LLM(대형 언어 모델)의 "블랙박스" 특성은 항상 인공지능 분야를 괴롭히는 중요한 문제였습니다. 모델 출력 결과의 해석 불가능성으로 인해 신뢰성과 신뢰성을 보장하기가 어렵습니다. 이 문제를 해결하기 위해 OpenAI는 LLM 출력의 해석 가능성과 검증 가능성을 향상시키는 것을 목표로 하는 PVG(Prover-Verifier Games)라는 새로운 기술을 출시했습니다. Downcodes의 편집자가 이 기술을 자세히 설명할 것입니다.

OpenAI는 최근 인공지능 모델 출력의 '블랙박스' 문제를 해결하는 것을 목표로 하는 PVG(Prover-Verifier Games)라는 신기술을 출시했습니다.

당신에게 초지능 비서가 있다고 상상해보세요. 그러나 그 비서의 사고 과정은 블랙박스와 같아서 그것이 어떻게 결론에 도달하는지 전혀 모릅니다. 다소 불안하게 들리나요? 그렇습니다. 이는 현재 많은 LLM(대형 언어 모델)이 직면한 문제입니다. 강력하기는 하지만 생성된 콘텐츠의 정확성을 확인하기는 어렵습니다.

서면 URL: https://cdn.openai.com/prover-verifier-games-improve-legibility-of-llm-outputs/legibility.pdf

이 문제를 해결하기 위해 OpenAI는 PVG 기술을 출시했습니다. 간단히 말하면 작은 모델(예: GPT-3)이 대형 모델(예: GPT-4)의 출력을 감독하도록 하는 것입니다. 마치 게임을 하는 것과 같습니다. 증명자는 콘텐츠 생성을 담당하고, 검증자는 콘텐츠가 올바른지 확인하는 역할을 합니다. 재미있을 것 같나요?

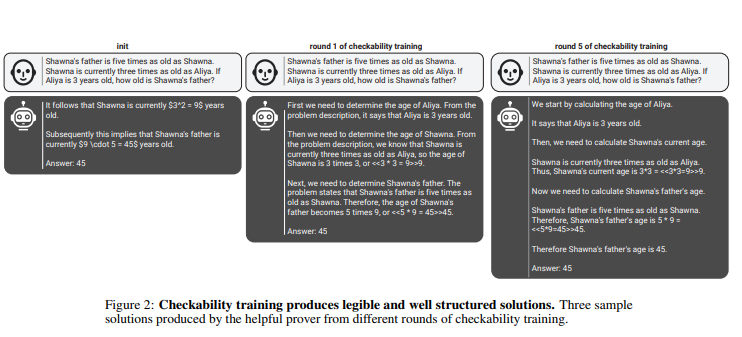

이 규칙에서 증명자와 검증자는 여러 차례의 반복 훈련을 통해 지속적으로 능력을 향상시킵니다. 검증자는 지도 학습을 사용하여 콘텐츠의 정확성을 예측하고, 증명자는 강화 학습을 사용하여 생성하는 콘텐츠를 최적화합니다. 더욱 흥미롭게도 증명자에는 유용한 증명자와 교활한 증명자의 두 가지 유형이 있습니다. 유용한 증명자는 정확하고 설득력 있는 콘텐츠를 생성하려고 노력하는 반면, 교활한 증명자는 부정확하지만 똑같이 설득력 있는 콘텐츠를 생성하려고 노력하여 검증자의 판단에 도전합니다.

penAI는 효과적인 검증 모델을 훈련하기 위해서는 인식 능력을 향상시키기 위해 대량의 실제적이고 정확한 라벨 데이터가 필요하다고 강조합니다. 그렇지 않으면 PVG 기술을 사용하더라도 검증된 콘텐츠가 여전히 불법 출력될 위험이 있습니다.

가장 밝은 부분:

PVG 기술은 대형 모델의 출력을 소형 모델로 검증해 AI '블랙박스' 문제를 해결한다.

? 훈련 프레임워크는 게임 이론을 기반으로 하며 증명자와 검증자 간의 상호 작용을 시뮬레이션하여 모델 출력의 정확성과 제어 가능성을 향상시킵니다.

? 충분한 판단력과 견고성을 보장하기 위해 검증 모델을 훈련하려면 많은 양의 실제 데이터가 필요합니다.

전체적으로 OpenAI의 PVG 기술은 인공지능 모델의 '블랙박스' 문제를 해결하기 위한 새로운 아이디어를 제공하지만, 그 효율성은 여전히 고품질 교육 데이터에 달려 있습니다. 이 기술의 향후 발전은 인공지능 모델의 개발을 더욱 신뢰할 수 있고 설명 가능하며 신뢰할 수 있는 방향으로 촉진할 것이기 때문에 기대해볼 만하다. Downcodes의 편집자는 유사한 혁신적인 기술이 더 많이 등장하기를 기대합니다.