I2V(이미지-비디오) 생성 기술은 더욱 사실적이고 제어된 비디오를 생성한다는 목표로 빠르게 발전하고 있습니다. Downcodes의 편집자는 오늘 명시적 모션 모델링을 통해 I2V 생성 분야에서 획기적인 발전을 이룬 Motion-I2V라는 새로운 프레임워크를 소개할 예정입니다. Xiaoyu Shi 및 Zhaoyang Huang과 같은 연구원이 개발한 이 프레임워크는 이미지-비디오 변환 프로세스를 두 단계로 분해하고 모션 필드 예측 및 모션 향상 타이밍 레이어를 교묘하게 결합하여 더 높은 품질, 더 일관되고 일관성을 달성한다는 점에서 혁신적입니다. 제어 가능한 비디오 생성.

인공지능 기술의 급속한 발전으로 I2V(Image-to-Video) 생성 기술이 뜨거운 연구 주제로 떠올랐다. 최근 Xiaoyu Shi 및 Zhaoyang Huang과 같은 연구원으로 구성된 팀은 명시적 모션 모델링을 통해 보다 일관되고 제어 가능한 이미지-비디오 생성을 달성하는 Motion-I2V라는 새로운 프레임워크를 도입했습니다. 이러한 기술적 혁신은 비디오 생성의 품질과 일관성을 향상시킬 뿐만 아니라 사용자에게 전례 없는 제어 경험을 제공합니다.

이미지-비디오 생성 분야에서는 생성된 비디오의 일관성과 제어성을 어떻게 유지하는가가 항상 기술적 문제였습니다. 기존 I2V 방법은 이미지와 비디오의 복잡한 매핑을 직접 학습하는 반면, Motion-I2V 프레임워크는 이 프로세스를 혁신적으로 두 단계로 분해하고 두 단계 모두에 명시적인 모션 모델링을 도입합니다.

첫 번째 단계에서 Motion-I2V는 참조 이미지 픽셀의 궤적을 도출하는 데 초점을 맞춘 확산 기반 모션 필드 예측기를 제안합니다. 이 단계의 핵심은 참조 이미지와 텍스트 큐를 사용하여 참조 프레임과 모든 향후 프레임 사이의 모션 필드 맵을 예측하는 것입니다. 두 번째 단계에서는 참조 이미지의 내용을 복합 프레임으로 전파하는 작업을 담당합니다. 새로운 모션 증강 시간 계층을 도입함으로써 1차원 시간 주의력이 향상되고 시간 수용 필드가 확장되며 복잡한 시공간 패턴을 직접 학습하는 복잡성이 완화됩니다.

기존 방법과 비교하여 Motion-I2V는 분명한 장점을 보여줍니다. "빠르게 움직이는 탱크", "빠르게 운전하는 파란색 BMW", "세 개의 투명한 얼음 조각" 또는 "기어가는 달팽이"와 같은 시나리오에서 Motion-I2V는 고품질 출력에서도 더욱 일관된 비디오를 생성합니다. 광범위한 동작 및 시야각 변화에도 유지됩니다.

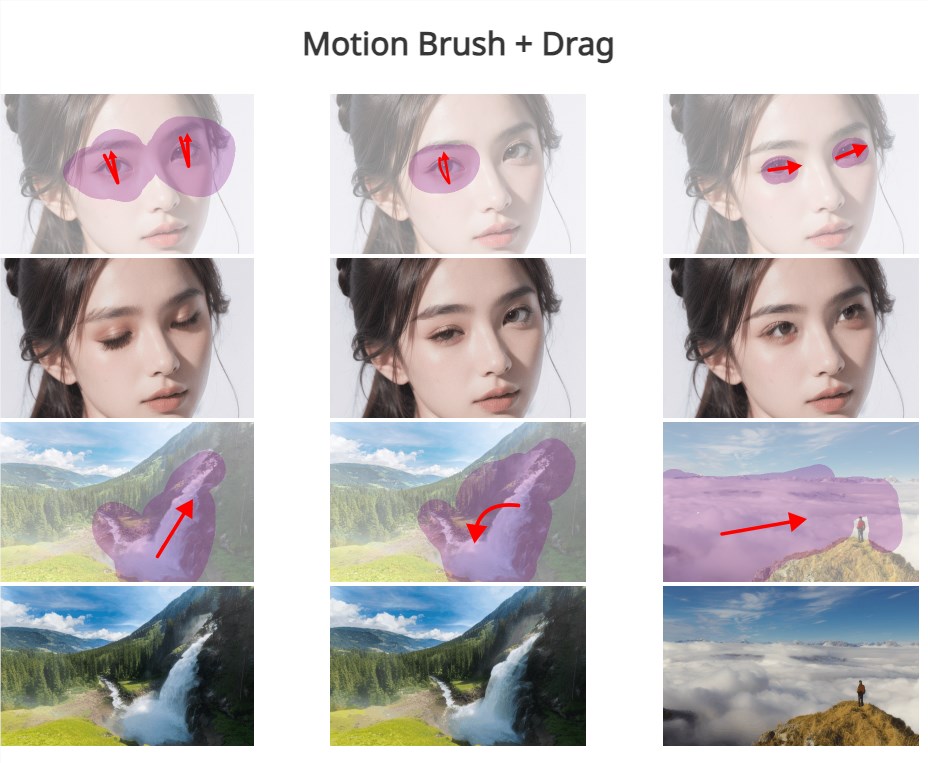

또한 Motion-I2V는 사용자가 희소 궤적 및 영역 주석을 통해 모션 궤적 및 모션 영역을 정밀하게 제어할 수 있도록 지원하여 텍스트 지침에만 의존하는 것보다 더 많은 제어 기능을 제공합니다. 이는 사용자의 상호작용 경험을 향상시킬 뿐만 아니라 비디오 생성의 맞춤화 및 개인화 가능성도 제공합니다.

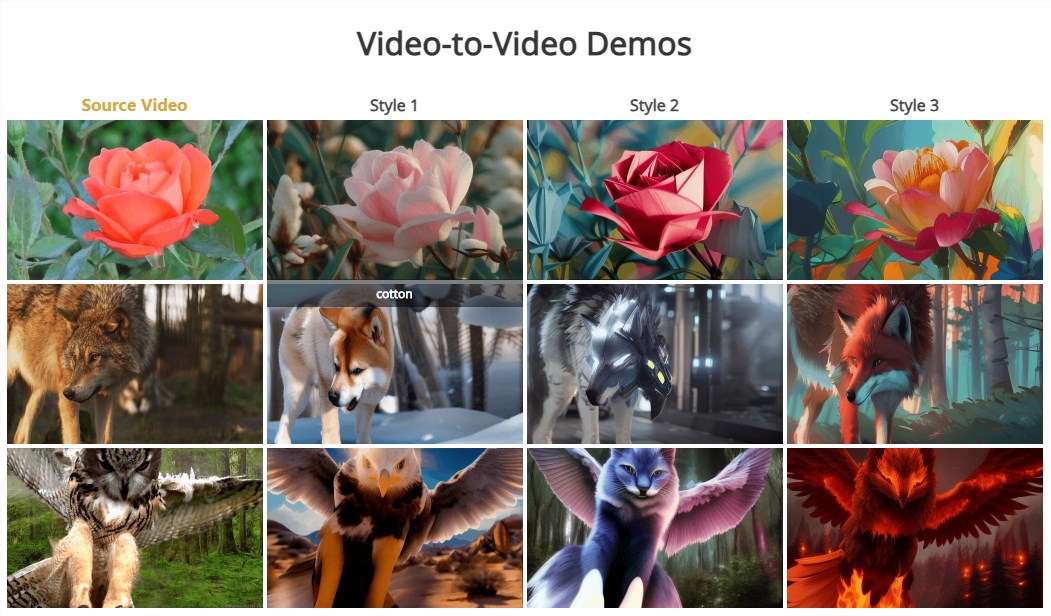

Motion-I2V의 두 번째 단계도 자연스럽게 제로 샘플 비디오-비디오 변환을 지원한다는 점은 언급할 가치가 있습니다. 이는 훈련 샘플 없이 다양한 스타일이나 콘텐츠의 비디오 변환이 달성될 수 있음을 의미합니다.

Motion-I2V 프레임워크의 출시는 이미지-비디오 생성 기술의 새로운 단계를 의미합니다. 품질과 일관성이 크게 향상되었을 뿐만 아니라 사용자 제어 및 개인화 측면에서도 큰 잠재력을 보여줍니다. 기술이 지속적으로 성숙하고 개선됨에 따라 Motion-I2V가 영화 및 TV 제작, 가상 현실, 게임 개발 및 기타 분야에서 중요한 역할을 하여 사람들에게 더욱 풍부하고 생생한 시각적 경험을 선사할 것이라고 믿을 이유가 있습니다.

문서 주소: https://xiaoyushi97.github.io/Motion-I2V/

깃허브 주소: https://github.com/GUN/Motion-I2V

Motion-I2V 프레임워크의 출현은 I2V 기술에 새로운 가능성을 가져왔고, 비디오 생성 품질, 일관성 및 사용자 제어의 향상은 기대할 가치가 있습니다. 앞으로는 기술이 더욱 발전하여 Motion-I2V가 더 많은 분야에 적용되어 우리에게 더욱 흥미로운 시각적 경험을 선사할 것이라고 믿습니다. 이 프레임워크를 기반으로 하는 더욱 혁신적인 애플리케이션을 기대해 보세요.