인공지능 훈련은 시간이 많이 걸리고 컴퓨팅 파워도 소모하는데, 이는 AI 분야에서 항상 병목 현상이 되어왔다. DeepMind 팀은 최근 획기적인 연구를 발표하고 이 문제를 효과적으로 해결하는 JEST라는 새로운 데이터 스크리닝 방법을 제안했습니다. Downcodes의 편집자는 JEST가 어떻게 AI 훈련의 효율성을 크게 향상시킬 수 있는지에 대한 심층적인 이해를 제공하고 그 뒤에 있는 기술 원리를 설명합니다.

인공지능 분야에서 컴퓨팅 성능과 시간은 언제나 기술 발전을 제한하는 핵심 요소였습니다. 그러나 DeepMind 팀의 최신 연구 결과는 이 문제에 대한 해결책을 제시합니다.

그들은 훈련에 가장 적합한 데이터 배치를 지능적으로 선별하여 AI 훈련 시간과 컴퓨팅 성능 요구 사항을 크게 줄이는 JEST라는 새로운 데이터 선별 방법을 제안했습니다. AI 훈련 시간을 13배, 컴퓨팅 파워 요구량을 90%까지 줄일 수 있다고 한다.

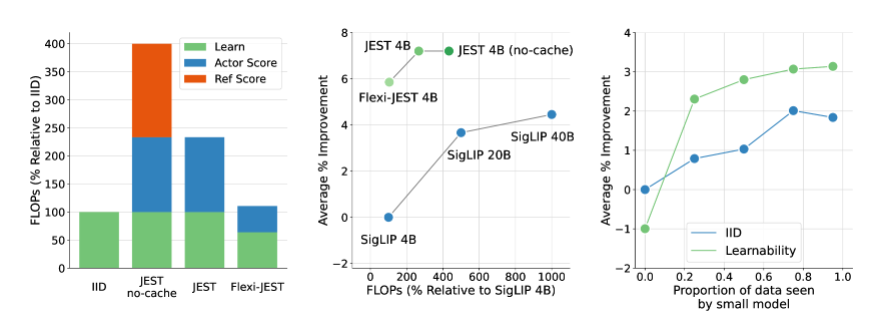

JEST 방법의 핵심은 개별 샘플이 아닌 최상의 데이터 배치를 공동으로 선택하는 데 있으며, 이는 다중 모드 학습을 가속화하는 데 특히 효과적인 것으로 입증된 전략입니다. 기존의 대규모 사전 훈련 데이터 스크리닝 방법과 비교하여 JEST는 반복 및 부동 소수점 연산 횟수를 크게 줄일 뿐만 아니라 FLOP 예산의 10%만 사용하면서 이전 최첨단 기술을 능가합니다.

DeepMind 팀의 연구에서는 세 가지 주요 시사점을 밝혔습니다. 좋은 데이터 배치를 선택하는 것이 데이터 포인트를 개별적으로 선택하는 것보다 더 효과적이며, 온라인 모델 근사치를 사용하여 데이터를 보다 효율적으로 필터링할 수 있으며, 작은 고품질 데이터 세트를 부트스트랩하여 더 큰 데이터 세트를 활용할 수 있습니다. . 선별되지 않은 데이터세트. 이러한 결과는 JEST 방법의 효율적인 성능을 위한 이론적 기초를 제공합니다.

JEST의 작동 원리는 RHO 손실에 대한 이전 연구를 활용하고 학습 모델의 손실과 사전 훈련된 참조 모델을 결합하여 데이터 포인트의 학습 가능성을 평가하는 것입니다. 사전 훈련된 모델에는 더 쉽지만 현재 학습 모델에는 더 어려운 데이터 포인트를 선택하여 훈련 효율성과 효과를 향상시킵니다.

또한 JEST는 점진적으로 배치를 구축하고 각 반복의 조건부 학습성 점수를 기반으로 새로운 샘플 하위 집합을 선택하기 위해 차단 Gibbs 샘플링을 기반으로 하는 반복 방법을 채택합니다. 이 접근 방식은 사전 훈련된 참조 모델만 사용하여 데이터 점수를 매기는 것을 포함하여 더 많은 데이터가 필터링됨에 따라 계속해서 개선됩니다.

DeepMind의 이번 연구는 AI 훈련 분야에 획기적인 진전을 가져올 뿐만 아니라, 미래 AI 기술 개발을 위한 새로운 아이디어와 방법을 제시합니다. JEST 방법의 추가 최적화 및 적용을 통해 인공 지능의 개발이 더 넓은 전망을 가져올 것이라고 믿을 만한 이유가 있습니다.

논문: https://arxiv.org/abs/2406.17711

가장 밝은 부분:

**훈련 효율성 혁명**: DeepMind의 JEST 방법은 AI 훈련 시간을 13배 줄이고 컴퓨팅 전력 요구 사항을 90% 줄입니다.

**데이터 배치 스크리닝**: JEST는 개별 샘플 대신 최상의 데이터 배치를 공동으로 선택하여 다중 모드 학습의 효율성을 크게 향상시킵니다.

?️ **혁신적인 훈련 방법**: JEST는 온라인 모델 근사화 및 고품질 데이터 세트 지침을 활용하여 대규모 사전 훈련의 데이터 분포 및 모델 일반화 기능을 최적화합니다.

JEST 방식의 등장은 AI 훈련에 새로운 희망을 가져왔고, JEST 방식의 효율적인 데이터 스크리닝 전략은 AI 기술의 다양한 분야 적용과 발전을 촉진할 것으로 기대된다. 앞으로는 더욱 실용적인 응용 분야에서 JEST의 성능을 확인하고 인공 지능 분야의 혁신을 더욱 촉진할 수 있기를 기대합니다. Downcodes의 편집자는 계속해서 관련 개발에 주의를 기울이고 독자들에게 더욱 흥미로운 보고서를 제공할 것입니다.