Downcodes의 편집자는 Transformer 모델의 비밀에 대한 심층적인 이해를 제공할 것입니다! 최근 "페인터로서의 트랜스포머 레이어"라는 제목의 논문에서는 트랜스포머 모델의 중간 레이어의 작동 메커니즘을 "페인터"의 관점에서 생생하게 설명했습니다. 기발한 은유와 실험을 통해 이 문서는 Transformer 계층 구조가 어떻게 작동하는지 밝히고 대규모 언어 모델의 내부 작동을 이해할 수 있는 새로운 아이디어를 제공합니다. 논문에서 저자는 트랜스포머의 각 레이어를 화가에 비유하고 함께 작업하여 거대한 언어 그림을 만들고 일련의 실험을 통해 이러한 관점을 검증했습니다.

인공 지능의 세계에는 특별한 화가 그룹, 즉 Transformer 모델의 계층 구조가 있습니다. 그들은 언어라는 캔버스에 다채로운 세계를 그리는 마법의 붓과 같습니다. 최근 Transformer Layers as Painters라는 논문은 Transformer 중간 계층의 작동 메커니즘을 이해하는 데 새로운 관점을 제공합니다.

현재 가장 널리 사용되는 대규모 언어 모델인 Transformer 모델에는 수십억 개의 매개변수가 있습니다. 그것의 각 층은 화가와 같으며, 함께 작업하여 거대한 언어 그림을 완성합니다. 하지만 이 화가들은 어떻게 함께 작업했습니까? 그들이 사용한 붓과 물감은 어떻게 달랐습니까? 이 논문은 이러한 질문에 답하려고 시도합니다.

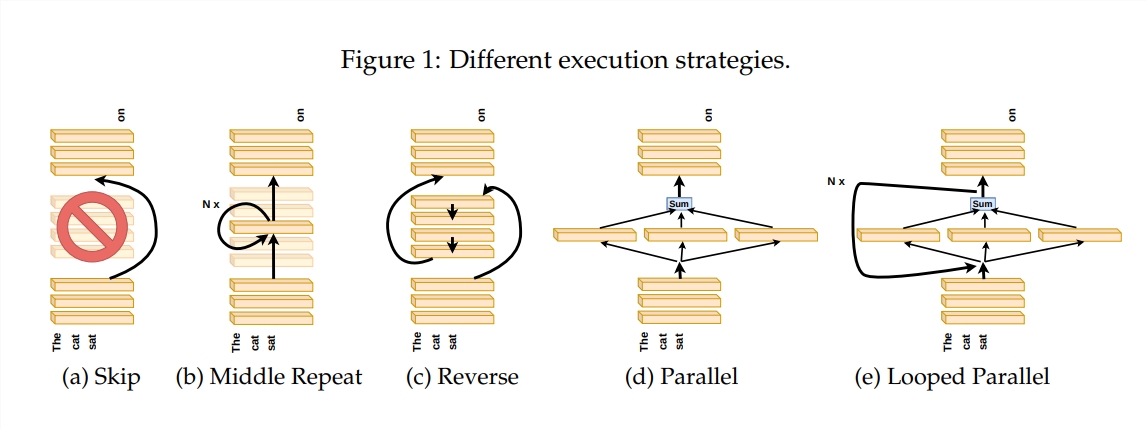

Transformer 레이어의 작동 방식을 살펴보기 위해 저자는 특정 레이어 건너뛰기, 레이어 순서 변경, 레이어 병렬 실행 등 일련의 실험을 설계했습니다. 이러한 실험은 화가가 적응할 수 있는지 확인하기 위해 다양한 그림 규칙을 설정하는 것과 같습니다.

"화가의 파이프라인" 비유에서 입력은 캔버스로 간주되며 중간 레이어를 통과하는 과정은 조립 라인에서 캔버스를 통과하는 것과 같습니다. 각 "페인터", 즉 Transformer의 각 레이어는 자신의 전문 지식에 따라 그림을 수정합니다. 이 비유는 Transformer 계층의 병렬성과 확장성을 이해하는 데 도움이 됩니다.

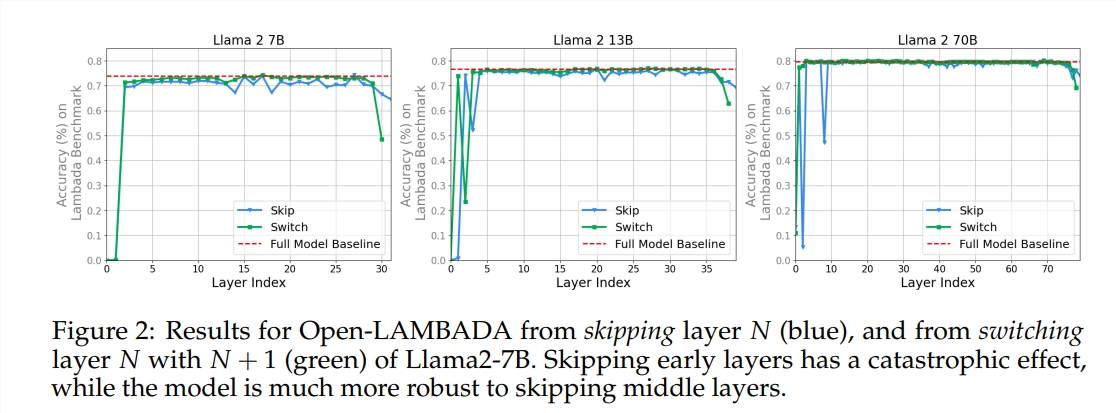

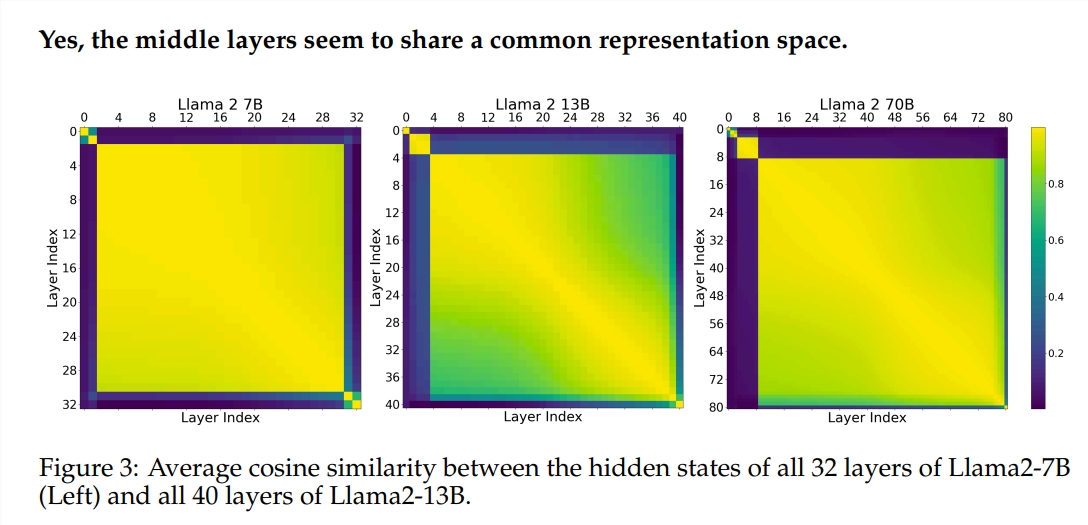

실험에서는 사전 훈련된 LLM(대형 언어 모델) 두 개, 즉 Llama2-7B와 BERT를 사용했습니다. 연구 결과에 따르면 중간 계층의 화가는 첫 번째 및 마지막 계층의 화가와는 달리 공간을 나타내는 공통 페인트 상자를 공유하는 것으로 나타났습니다. 특정 중간 레이어를 건너뛰는 화가는 그림 전체에 거의 영향을 미치지 않으므로 모든 화가가 필요한 것은 아닙니다.

중간층의 화가들은 같은 물감 상자를 사용하지만 각자의 기술을 이용해 캔버스에 서로 다른 무늬를 그린다. 단순히 특정 화가의 기법을 재사용하면 그림은 원래의 매력을 잃게 됩니다.

그리는 순서는 엄격한 논리가 필요한 수학 및 추론 작업에 특히 중요합니다. 의미론적 이해에 의존하는 작업의 경우 순서의 영향은 상대적으로 작습니다.

연구 결과에 따르면 Transformer의 중간 계층은 어느 정도 일관성을 가지지만 중복되지는 않습니다. 수학적 및 추론 작업의 경우 의미론적 작업보다 레이어 순서가 더 중요합니다.

또한 연구에서는 모든 레이어가 필요한 것은 아니며 모델 성능에 심각한 영향을 주지 않고 중간 레이어를 건너뛸 수 있다는 사실도 발견했습니다. 또한 중간 레이어는 동일한 표현 공간을 공유하지만 서로 다른 기능을 수행합니다. 레이어의 실행 순서를 변경하면 성능이 저하되어 순서가 모델 성능에 중요한 영향을 미친다는 것을 알 수 있습니다.

Transformer 모델을 탐색하는 과정에서 많은 연구자들이 가지치기, 매개변수 감소 등을 포함하여 이를 최적화하려고 노력하고 있습니다. 이러한 작품은 Transformer 모델을 이해하는 데 귀중한 경험과 영감을 제공합니다.

논문 주소: https://arxiv.org/pdf/2407.09298v1

전체적으로 이 논문은 Transformer 모델의 내부 메커니즘을 이해하는 데 새로운 관점을 제공하고 향후 모델 최적화를 위한 새로운 아이디어를 제공합니다. Downcodes의 편집자는 관심 있는 독자가 전체 기사를 읽고 Transformer 모델의 신비에 대한 심층적인 이해를 얻을 것을 권장합니다!