Downcodes의 편집자는 Checkmarx가 발표한 글로벌 연구 보고서를 해석하는 데 도움을 줄 것입니다. 이 보고서는 소프트웨어 개발 분야에서 AI 프로그래밍 도구의 광범위한 사용 현황과 이로 인해 발생하는 보안 위험을 보여줍니다. 보고서 데이터에 따르면 일부 기업은 AI 프로그래밍 도구의 사용을 명시적으로 금지했음에도 불구하고 채택률이 여전히 높은 것으로 나타났습니다. 이는 기업이 생성 AI 관리에 직면한 어려움을 강조합니다. 또한 이 보고서는 기업의 AI 도구 거버넌스, 보안 위험 평가, AI 도구에 대한 개발자의 신뢰에 대한 심층적인 논의를 제공하여 기업이 AI 도구를 효과적으로 활용하는 데 중요한 참고 자료를 제공합니다.

클라우드 보안 회사인 Checkmarx가 발표한 글로벌 연구에 따르면, 기업의 15%가 AI 프로그래밍 도구 사용을 명시적으로 금지하고 있지만 거의 모든 개발 팀(99%)이 여전히 이러한 도구를 사용하고 있습니다. 이러한 현상은 실제 개발 과정에서 생성 AI의 사용을 통제하기가 어렵다는 점을 반영합니다.

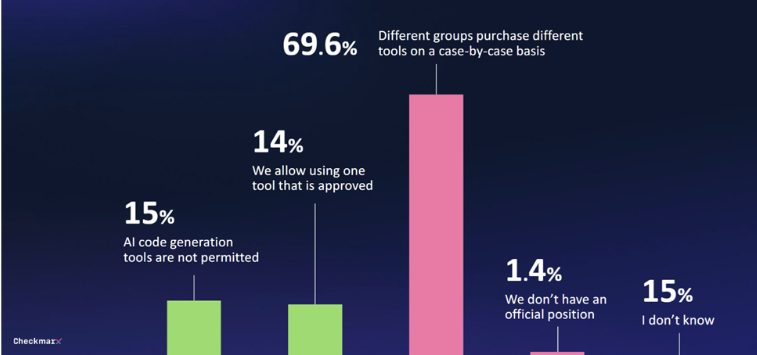

연구에 따르면 기업 중 29%만이 생성 AI 도구에 대한 어떤 형태로든 거버넌스 시스템을 구축한 것으로 나타났습니다. 70%의 기업은 중앙 전략이 없으며, 다양한 부서의 조달 결정이 일시적이고 통합된 관리가 부족한 경우가 많습니다.

점점 더 많은 개발자가 AI 프로그래밍 도구를 사용함에 따라 보안 문제가 점점 더 커지고 있습니다. 응답자의 80%는 개발자가 AI를 사용할 때 가져올 수 있는 잠재적인 위협을 걱정하고 있으며, 특히 60%는 AI로 인해 발생할 수 있는 '환각'을 걱정하고 있습니다.

이러한 우려에도 불구하고 많은 사람들은 AI의 잠재력에 여전히 관심을 갖고 있습니다. 응답자의 47%는 감독 없이 AI가 코드를 변경할 수 있도록 허용할 의향이 있는 반면, 소프트웨어 환경의 AI 보안 조치에 대해 완전히 불신하는 응답자는 6%에 불과했습니다.

Checkmarx의 최고 제품 책임자인 Kobi Tzruya는 다음과 같이 말했습니다. “전 세계 CISO의 응답에 따르면 이러한 AI 도구는 보안 코드를 안정적으로 생성할 수 없음에도 불구하고 개발자가 AI를 애플리케이션 개발에 사용하고 있는 것으로 나타났습니다. 이는 보안 팀이 수많은 문제를 처리하고 있음을 의미합니다. 새롭고 잠재적으로 악성 코드입니다."

마이크로소프트의 업무 동향 지수(Work Trend Index) 보고서에 따르면 많은 직원들이 자체 AI 도구를 제공하지 않고 사용하고 있으며 이에 대해 공개적으로 논의하지 않는 경우가 많아 비즈니스 프로세스에서 생성적 AI를 체계적으로 구현하는 데 방해가 되는 경우가 많습니다.

가장 밝은 부분:

1. ? **15%의 회사에서 AI 프로그래밍 도구를 금지하지만, 개발 팀의 99%는 여전히 AI 프로그래밍 도구를 사용합니다**

2. ? **29%의 기업만이 생성 AI 도구에 대한 거버넌스 시스템을 구축했습니다**

3. ? **응답자의 47%는 AI가 감독되지 않은 코드 변경을 수행하도록 의향이 있습니다**

전체적으로 이 보고서는 기업이 AI 프로그래밍 도구의 관리 및 보안 정책을 강화하고 AI가 제공하는 편의성과 잠재적 위험 사이의 균형을 맞춰야 할 필요성을 강조합니다. 기업은 통합 전략을 수립하고 AI로 인해 발생할 수 있는 보안 취약성에 주의를 기울여야 합니다. 이를 통해 AI 기술을 더 잘 활용하여 개발 효율성을 높일 수 있습니다. Downcodes의 편집자는 AI 보안 분야의 발전에 대해 자세히 알아보려면 Checkmarx의 후속 보고서에 주의를 기울일 것을 권장합니다.