최근 Anthropic의 AI 챗봇 Claude의 사용자 경험이 뜨거운 논의를 불러일으켰습니다. Reddit에는 Claude의 성능이 저하되었으며, 특히 기억 상실 및 코딩 능력 저하로 인해 나타나는 수많은 사용자 피드백이 나타났습니다. 이번 사건은 대규모 언어 모델의 성능 평가와 사용자 경험에 대한 폭넓은 논의를 촉발시켰고, AI 기업이 모델 안정성을 유지하는 데 직면한 과제를 다시 한번 부각시켰습니다.

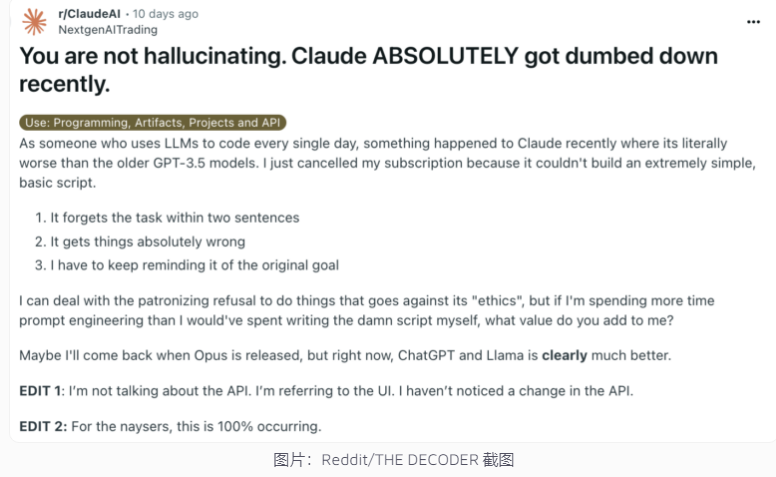

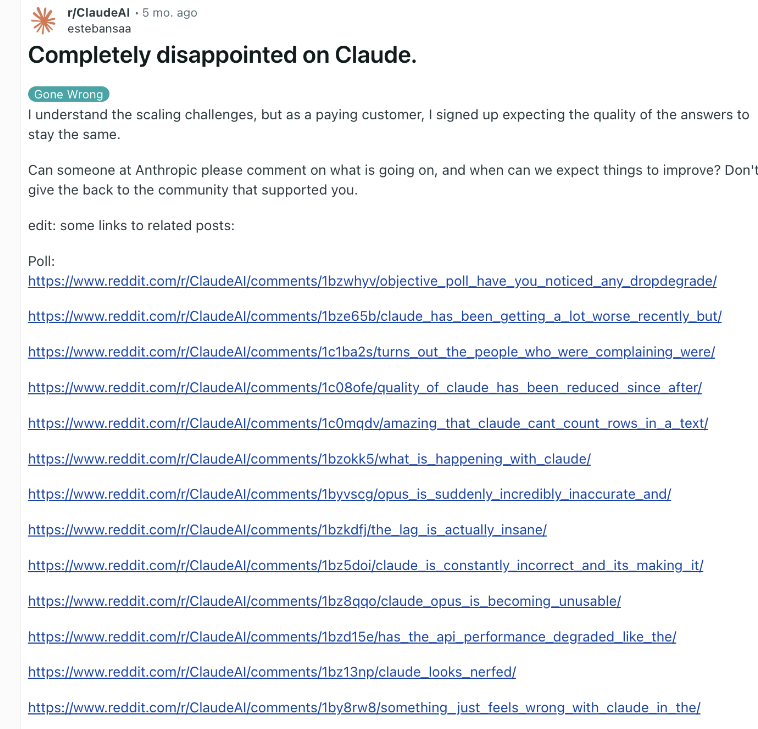

최근 앤트로픽(Anthropic)의 AI 챗봇 클로드(Claude)가 다시 한번 성능 논란에 휩싸였다. Claude가 훨씬 더 멍청해졌다고 주장하는 Reddit의 게시물은 최근 광범위한 관심을 끌었으며 많은 사용자가 기억 상실 및 코딩 능력 저하를 포함하여 Claude의 능력 저하를 경험했다고 보고했습니다.

이에 대해 Anthropic의 Alex Albert 임원은 회사의 조사에서 일반적인 문제를 발견하지 못했다고 응답했으며 Claude3.5Sonnet 모델이나 추론 파이프라인에 변경 사항이 없음을 확인했습니다. 투명성을 높이기 위해 Anthropic은 공식 웹사이트에 Claude 모델의 시스템 프롬프트를 게시했습니다.

사용자들이 AI 성능 저하를 보고하고 회사가 이를 부인한 것은 이번이 처음이 아닙니다. 2023년 말, OpenAI의 ChatGPT도 비슷한 의심에 직면했습니다. 업계 관계자에 따르면 이러한 현상의 원인으로는 시간이 지남에 따라 증가하는 사용자 기대치, AI 출력의 자연스러운 변화, 일시적인 컴퓨팅 리소스 제한 등이 포함될 수 있습니다.

그러나 이러한 요소는 기본 모델이 크게 변경되지 않더라도 사용자가 인식하는 성능 저하로 이어질 수 있습니다. OpenAI는 AI 행동 자체가 예측 불가능하며 대규모 생성 AI 성능을 유지하고 평가하는 것이 큰 과제라고 지적한 적이 있습니다.

Anthropic은 계속해서 사용자 피드백에 귀를 기울이고 Claude의 성능 안정성을 개선하기 위해 열심히 노력할 것이라고 말했습니다. 이번 사건은 AI 기업이 모델 일관성을 유지하는 데 직면한 과제와 AI 성과 평가 및 커뮤니케이션의 투명성을 높이는 것이 얼마나 중요한지를 강조합니다.

Claude 성능 논란은 대규모 언어 모델의 개발 및 배포의 복잡성뿐만 아니라 사용자 기대와 실제 응용 프로그램 간의 격차를 반영합니다. 앞으로 AI 기술이 사용자에게 안정적으로 서비스를 지속적으로 제공할 수 있도록 AI 기업은 모델 안정성을 더욱 향상하고 사용자와의 보다 효과적인 커뮤니케이션을 유지해야 합니다.