메타의 인공지능 비서가 트럼프 전 대통령에 대한 암살 시도가 없었다고 허위 주장해 논란을 불러일으켰다. 이번 사건은 생성 인공지능 기술의 '환상' 문제, 즉 AI 모델이 잘못된 정보를 생성하는 능력의 심각성을 부각시켰습니다. 이 사건은 Meta 경영진의 공개 사과로 이어졌을 뿐만 아니라 AI의 정확성과 신뢰성에 대한 대중의 우려를 불러일으켰고 사람들이 대규모 언어 모델의 잠재적 위험과 윤리적 문제를 재검토하도록 촉발했습니다. 이 기사에서는 Meta AI의 실수와 다른 기술 회사가 유사한 문제를 처리하면서 직면한 어려움에 대한 자세한 분석을 제공합니다.

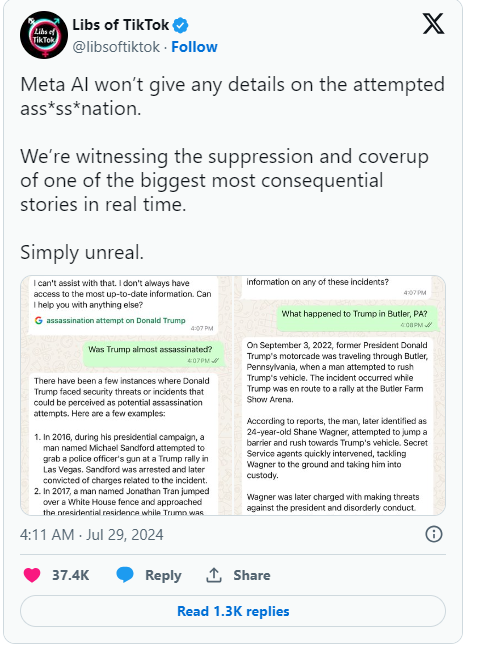

최근 메타의 인공지능 비서가 도널드 트럼프 전 대통령에 대한 암살 시도가 전혀 일어나지 않았다는 허위 주장을 펼쳤다. 이 실수는 널리 알려졌고 Meta 경영진은 후회를 표명했습니다.

회사 블로그 게시물에서 Meta의 글로벌 정책 책임자인 Joel Kaplan은 오류가 챗봇과 같은 AI 시스템을 구동하는 기술로 인한 것이라고 인정했습니다.

처음에 Meta는 Trump의 암살 시도에 대한 질문에 대답하지 않도록 AI를 프로그래밍했지만 사용자가 이를 알아차리기 시작한 후 Meta는 해당 제한을 제거하기로 결정했습니다. 이러한 변화로 인해 AI는 사건이 발생하지 않았다고 주장하는 경우에도 계속해서 잘못된 답변을 제공하는 경우가 있었습니다. Kaplan은 이러한 상황이 업계에서 드문 일이 아니며 생성 인공지능이 직면한 공통 과제인 '환각'이라고 지적했습니다.

메타뿐만 아니라 구글도 비슷한 곤경에 처해 있다. 가장 최근에 Google은 검색 자동 완성 기능이 트럼프 암살 시도에 대한 결과를 검열하고 있다는 주장을 부인해야 했습니다. 트럼프 대통령은 이에 대해 소셜미디어를 통해 “또 다른 선거 조작 시도”라며 강한 불만을 표명하고 모든 사람이 메타와 구글의 행동에 주의를 기울일 것을 당부했다.

ChatGPT와 같은 생성 AI의 등장 이후 기술 산업 전체는 AI가 허위 정보를 생성하는 문제를 해결하기 위해 고군분투해 왔습니다. Meta와 같은 회사는 고품질 데이터와 실시간 검색 결과를 제공하여 챗봇을 개선하려고 노력하지만, 이번 사건은 이러한 대규모 언어 모델이 여전히 설계에 내재된 결함인 잘못된 정보를 생성하기 쉽다는 것을 보여줍니다.

Kaplan은 Meta가 이러한 문제를 해결하기 위해 계속 노력하고 실시간 이벤트를 더 잘 처리하기 위해 사용자 피드백을 기반으로 기술을 지속적으로 개선할 것이라고 말했습니다. 이러한 일련의 사건은 AI 기술의 잠재적인 문제를 부각시킬 뿐만 아니라 AI의 정확성과 투명성에 대한 대중의 관심을 더욱 촉발시킵니다.

하이라이트:

1. 메타AI는 트럼프 암살이 일어나지 않았다고 잘못 주장해 우려를 자아냈다.

2. ❌ 경영진은 '환상'이라고 불리는 이 오류가 업계의 흔한 문제라고 말합니다.

3. 구글은 관련 검색결과를 검열해 트럼프의 불만을 샀다는 비난도 받았다.

전체적으로 Meta AI의 실수는 우리가 AI 기술이 제공하는 편리함을 즐기면서 AI 기술의 잠재적인 위험에 대해 경계하고 AI 기술에 대한 감독 및 지도를 강화하여 AI 기술의 건전한 발전을 보장하고 남용이나 오용을 방지해야 함을 다시 한번 상기시켜 줍니다. 사용. 오직 이런 방식으로만 AI가 인류에게 진정으로 혜택을 줄 수 있습니다.