Google이 최근 발표한 연구 보고서는 생성 인공 지능(GenAI)이 잘못된 콘텐츠로 인터넷을 오염시키고 있다고 경고합니다. 보고서는 주로 여론에 영향을 미치거나 사기, 이익을 추구할 목적으로 초상화를 조작하는 것부터 증거를 조작하는 것까지 GenAI를 악용하는 사례가 끝없이 많다고 지적했습니다. Google 자체도 터무니없는 제안을 제공하는 AI 제품으로 인해 허위 정보 제작자가 되었습니다. 이는 경고를 더욱 경악하게 만들고 사람들이 GenAI의 잠재적 위험에 대해 깊이 생각하게 만듭니다.

최근 Google 연구원들은 생성 인공 지능(GenAI)이 가짜 콘텐츠로 인터넷을 망치고 있다고 경고했습니다. 이는 경고일 뿐만 아니라 반성의 시간이기도 하다.

아이러니하게도 Google은 이 '진실과 거짓의 전쟁'에서 이중 역할을 수행합니다. 한편으로는 생성적 AI의 중요한 촉진자이기도 하고, 다른 한편으로는 허위 정보의 생산자이기도 합니다. Google의 AI 개요 기능에는 "피자에 접착제를 바르세요", "바위를 먹어라"와 같은 말도 안되는 제안이 있었고 이러한 잘못된 메시지는 결국 수동으로 삭제해야 했습니다.

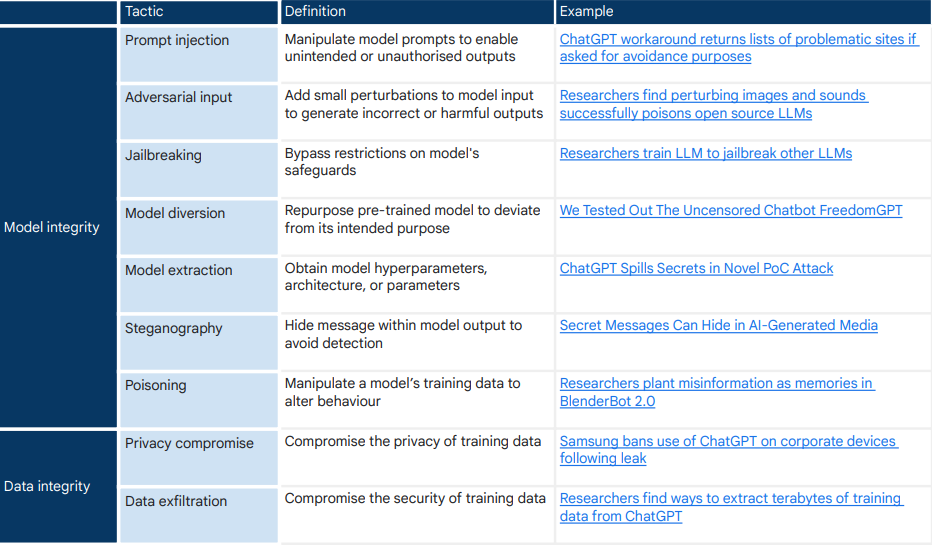

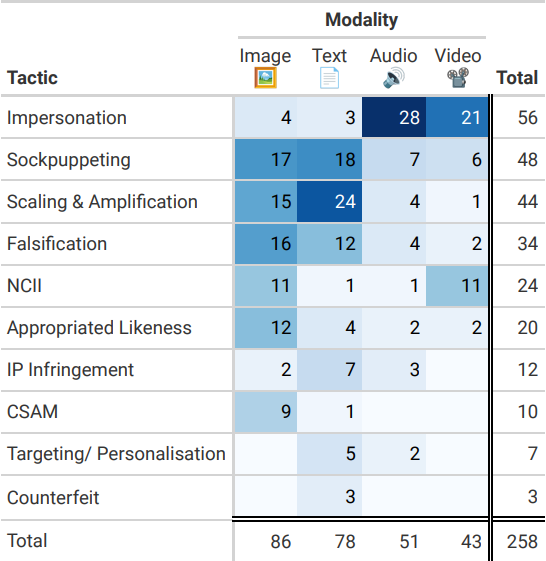

구글 연구팀은 생성 AI 남용에 대한 뉴스 보도 200개를 심층 조사한 결과, 인물 사진 조작 및 증거 조작이 가장 일반적인 남용 방법이라는 사실을 발견했습니다. 이러한 행동의 목적은 여론에 영향을 미치거나 사기를 치거나 이익을 얻는 것 이상입니다. 생성적 AI의 위험은 아직 '실존적 위협' 수준까지 올라가지는 않았지만 현재 일어나고 있는 일이며 앞으로는 더욱 악화될 수 있습니다.

연구원들은 대부분의 GenAI 남용 사례가 시스템의 정상적인 사용이며 "탈옥" 행위와 관련이 없다는 사실을 발견했습니다. 이러한 유형의 "일상적인 작업"이 90%를 차지합니다. GenAI의 광범위한 가용성, 접근성 및 초현실주의는 끝없는 형태의 낮은 수준의 남용을 가능하게 합니다. 허위정보 생성 비용이 너무 저렴해요!

Google의 연구 자료는 주로 언론 보도에서 비롯됩니다. 이는 연구 결론이 언론에 의해 편향된다는 것을 의미합니까? 언론은 선정적인 사건을 보도하는 경향이 있으며 이로 인해 데이터 세트가 특정 유형의 학대에 편향될 수 있습니다. 404Media는 우리가 아직 인지하지 못한, 보고되지 않은 생성 AI 남용 사례가 많다고 지적합니다.

AI 도구의 "울타리"는 몇 가지 팁을 통해 교묘하게 우회할 수 있습니다. 예를 들어 ElevenLabs의 AI 음성 복제 도구는 높은 정확도로 동료나 유명인의 목소리를 모방할 수 있습니다. Civitai 사용자는 유명인의 AI 생성 이미지를 만들 수 있으며 플랫폼에 NCII(동의 없는 친밀한 이미지)에 대한 정책이 있지만 사용자가 오픈 소스 도구를 사용하여 자신의 컴퓨터에서 NCII를 생성하는 것을 막을 수는 없습니다.

잘못된 정보가 퍼지면 인터넷상의 혼란은 진실과 거짓을 구별하는 사람들의 능력에 큰 시험을 가져올 것입니다. 우리는 “이것이 진짜인가?”라는 끊임없는 의심에 갇히게 될 것입니다. 이를 해결하지 않고 방치한다면, AI 생성 콘텐츠에 의한 공공 데이터의 오염은 정보 검색을 방해하고 사회정치적 현실에 대한 집단적 인식이나 과학적 합의를 왜곡할 수도 있습니다.

Google은 생성 AI로 인한 허위 콘텐츠 확산에 기여해 왔습니다. 수년 전에 발사된 총알이 마침내 오늘 그의 눈썹 사이에 맞았습니다. 구글의 연구는 어쩌면 자기구원의 시작이자 인터넷 사회 전체에 대한 경종일 수도 있다.

논문 주소: https://arxiv.org/pdf/2406.13843

이 Google 보고서는 의심할 여지 없이 GenAI의 향후 개발에 대한 경고로 들립니다. 기술 개발과 위험 통제의 균형을 맞추는 방법과 GenAI로 인한 허위 정보 확산에 효과적으로 대응하는 방법은 글로벌 기술 커뮤니티와 사회가 직면한 공통 과제입니다. 우리는 인터넷의 진정성과 순수성을 공동으로 유지하기 위한 더 많은 연구와 조치를 기대합니다.