Green Deep Learning의 최신 오픈 소스 RWKV-CLIP 모델은 Transformer와 RNN 아키텍처를 통합한 혁신적인 디자인으로 시각적 언어 표현 학습 분야에서 강력한 성능을 입증했습니다. 이 모델은 트윈 타워 아키텍처, 공간 믹싱 및 채널 믹싱 모듈, 다양한 설명 생성 프레임워크를 교묘하게 결합하여 시끄러운 데이터 문제를 효과적으로 해결하고 모델의 견고성과 다운스트림 작업 성능을 크게 향상시킵니다. 이는 이미지-텍스트 일치 및 이해 분야에서 획기적인 발전을 이루었으며, 시각적 언어 모델의 연구 및 적용을 위한 새로운 방향을 제시했습니다.

Gelingshentong은 Transformer와 RNN의 장점을 결합한 시각적 언어 표현 학습자인 RWKV-CLIP 모델을 오픈 소스로 제공했습니다. 이 모델은 이미지 및 텍스트 사전 학습 작업을 통해 웹사이트에서 얻은 이미지-텍스트 쌍을 사용하여 데이터 세트를 확장함으로써 시각적 및 언어 작업의 성능을 크게 향상시킵니다.

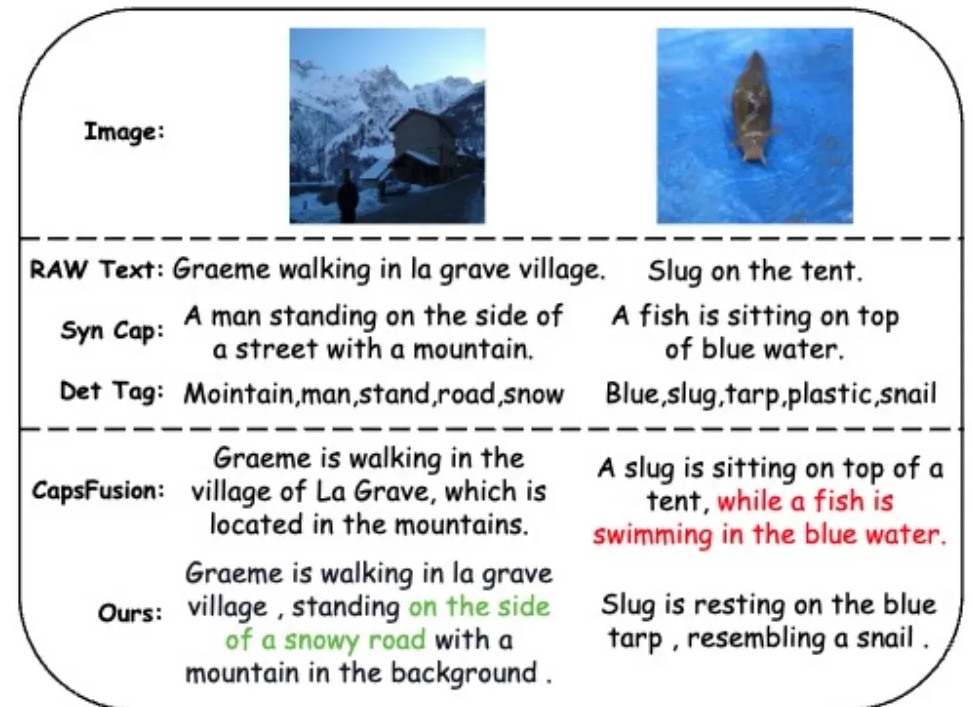

시끄러운 데이터 문제를 해결하고 데이터 품질을 개선하기 위해 연구팀은 LLM(대형 언어 모델)을 활용하여 웹 기반 텍스트, 합성된 자막 및 감지된 태그의 콘텐츠를 합성하고 개선하는 다양한 설명 생성 프레임워크를 도입했습니다.

RWKV-CLIP 모델은 Transformer의 효과적인 병렬 훈련과 RNN의 효율적인 추론을 통합하는 트윈 타워 아키텍처를 채택합니다. 모델은 입력 이미지와 텍스트의 심층 처리를 가능하게 하는 여러 공간 블렌딩 및 채널 블렌딩 모듈로 스택됩니다. 공간 혼합 단계에서 모델은 Attention 메커니즘을 사용하여 전역 선형 복잡성 계산을 수행하고 채널 수준에서 기능의 상호 작용을 강화합니다. 채널 블렌딩 단계에서는 특징 표현을 더욱 구체화합니다. 입력 향상 측면에서 RWKV-CLIP 모델은 원본 텍스트, 합성 자막 또는 생성된 설명을 텍스트 입력으로 무작위로 선택하여 모델의 견고성을 향상시킵니다.

실험 결과에 따르면 RWKV-CLIP은 선형 감지, 제로샷 분류, 제로샷 이미지 텍스트 검색을 포함한 여러 다운스트림 작업에서 최첨단 성능을 달성하는 것으로 나타났습니다. 기본 모델과 비교하여 RWKV-CLIP은 성능이 크게 향상되었습니다.

RWKV-CLIP 모델의 교차 모달 분석은 학습된 표현이 동일한 양식 내에서 더 명확한 식별성을 나타내고 이미지-텍스트 양식 공간에서 더 가까운 거리를 나타내므로 교차 양식이 더 나은 정렬 성능을 나타냄을 보여줍니다.

모델 주소: https://wisemodel.cn/models/deepglint/RWKV-CLIP

전체적으로 RWKV-CLIP 모델은 시각 언어 분야에서 큰 잠재력을 보여주며, 오픈 소스도 관련 연구에 귀중한 리소스를 제공합니다. 관심 있는 개발자는 제공된 링크를 방문하여 모델을 다운로드하고 추가 연구 및 적용을 수행할 수 있습니다.