난징대학교, 푸단대학교, 화웨이 노아의 방주 연구소 연구팀은 3D 디지털 휴먼 분야에서 획기적인 발전을 이뤄 기존 방식의 부족한 다시점 일관성과 감정 표현력 문제를 해결했습니다. 그들은 감정을 제어할 수 있는 3D 말하는 아바타를 합성하고 입술 동기화 및 렌더링 품질을 크게 향상시키는 새로운 방법을 개발했습니다. 연구 결과는 보정된 다시점 비디오, 감성 주석 및 프레임별 3D 기하학적 정보를 포함하고 비상업적 연구 용도로 공개된 새로 구축된 EmoTalk3D 데이터 세트를 기반으로 합니다. "말소리에서 기하학, 모양까지"의 매핑 프레임워크를 통해 이 방법은 미묘한 얼굴 표정을 정확하게 포착하고 자유로운 시야각에서 충실도 높은 렌더링을 달성합니다.

제품 입구 : https://nju-3dv.github.io/projects/EmoTalk3D/

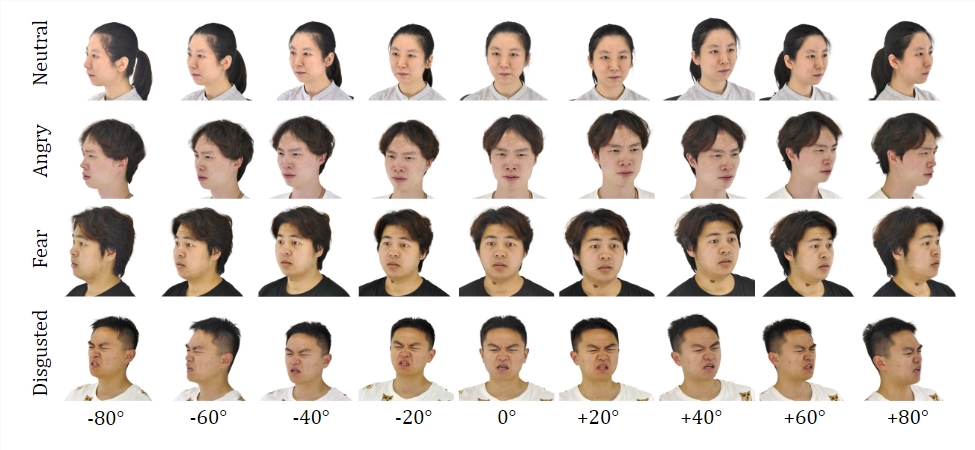

그들은 보정된 다중 뷰 비디오, 감정 주석 및 프레임별 3D 기하학을 통해 EmoTalk3D 데이터 세트를 수집했습니다. 그리고 감정을 제어할 수 있는 3D 말하는 아바타를 합성하는 새로운 방법이 제안되었으며, 입술 동기화 및 렌더링 품질이 크게 향상되었습니다.

데이터세트:

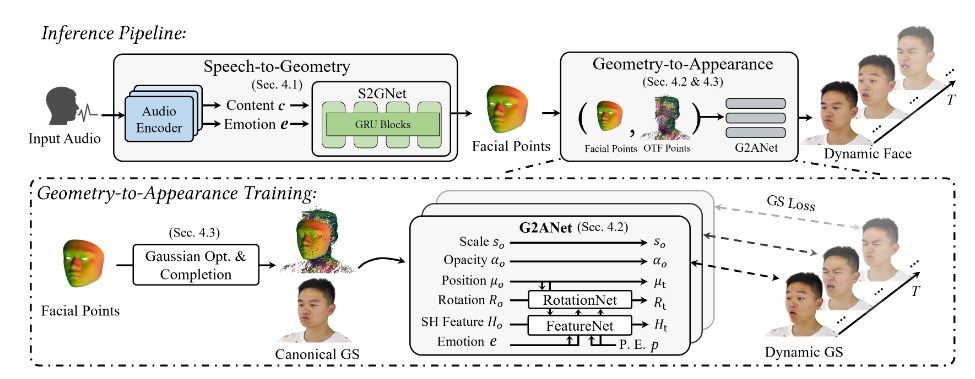

연구팀은 EmoTalk3D 데이터세트에 대한 교육을 통해 "음성부터 기하학, 모양까지" 매핑 프레임워크를 구축했습니다. 오디오 특징으로부터 사실적인 3차원 기하학적 시퀀스를 먼저 예측한 후, 예측된 기하학을 기반으로 4차원 가우시안으로 표현되는 3차원 말하는 머리의 모습을 합성합니다. 모양은 표준 및 동적 가우스로 추가로 분해되고 다중 뷰 비디오에서 학습되며 융합되어 프리뷰 토킹 헤드 애니메이션을 렌더링합니다.

이 모델은 생성된 말하는 아바타에서 제어 가능한 감정을 가능하게 하고 이를 다양한 시야각에서 렌더링합니다. 주름, 미묘한 표정 등 역동적인 얼굴 디테일을 포착하면서 향상된 렌더링 품질과 입술 모션 생성의 안정성을 입증했습니다. 생성된 결과의 예시에는 3D 디지털 휴먼의 행복한 표정, 화난 표정, 답답한 표정이 정확하게 표현되어 있습니다.

전체 프로세스에는 5개의 모듈이 포함됩니다.

첫 번째는 입력 음성에서 콘텐츠와 정서적 특징을 구문 분석하는 감성 콘텐츠 분해 인코더이고, 두 번째는 특징에서 동적 3D 포인트 클라우드를 예측하는 음성-기하학 네트워크입니다. 세 번째는 가우시안 최적화 및 완성 모듈입니다. 네 번째는 형상 대 모양입니다. 네트워크는 동적 3D 포인트 클라우드를 기반으로 얼굴 모양을 합성합니다. 다섯 번째는 동적 가우스를 자유 보기 애니메이션으로 렌더링하는 렌더링 모듈입니다.

또한 그들은 프레임별 3D 얼굴 모양을 갖춘 감정 주석이 달린 멀티뷰 말하는 머리 데이터세트인 EmoTalk3D 데이터세트를 구축했으며, 이 데이터세트는 비상업적 연구 목적으로 대중에게 공개될 예정입니다.

가장 밝은 부분:

감정을 통제할 수 있는 디지털 휴먼을 합성하는 새로운 방법을 제안합니다.

"음성부터 기하학, 모양까지" 매핑 프레임워크를 구축하세요.

EmoTalk3D 데이터 세트가 설정되어 열 준비가 되었습니다.

본 연구는 3D 디지털 휴먼 기술 개발에 새로운 방향을 제시하며, 제안된 방법과 데이터 세트는 향후 연구에 귀중한 자원을 제공하고 보다 현실적이고 감성적으로 표현되는 3D 디지털 휴먼 기술 개발을 촉진할 것입니다. EmoTalk3D 데이터세트의 공개로 학계의 협력과 교류도 활성화됩니다.