Sun Yat-sen University와 Byte Digital Human Team은 MMTryon이라는 가상 시착 프레임워크를 공동 개발했습니다. 이 프레임워크는 의류 이미지와 착용 방법에 대한 텍스트 지침을 입력하여 단 한 번의 클릭으로 고품질 모델 시착 효과를 생성할 수 있습니다. 실제 캐릭터와 만화 캐릭터를 지원하여 가상 체험 과정을 크게 단순화합니다. 이 기술은 기존 알고리즘의 한계를 뛰어넘어 옷을 세밀하게 분할할 필요 없이 복잡한 옷 입는 장면과 임의의 옷 스타일을 정밀하게 처리해 효율성과 편의성을 크게 향상시킨다.

최근 Sun Yat-sen University와 Byte Digital Human Team은 MMTryon이라는 가상 체험 프레임워크를 제안했습니다. 옷 사진 몇 장을 입력하고 착용 방법에 대한 몇 가지 텍스트 설명을 추가하기만 하면 한 번의 클릭으로 모델 시착 효과를 생성할 수 있으며 품질도 매우 높습니다.

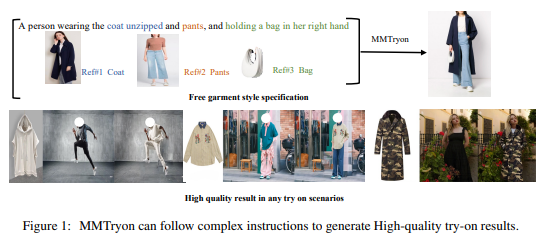

코트, 바지, 가방을 선택하고 클릭 한 번만 하면 자동으로 초상화에 올려진다고 상상해 보세요. 당신이 실제 인물이든, 만화 속 캐릭터이든 상관없이 클릭 한 번으로 이 작업을 수행할 수 있습니다.

게다가 MMTryon의 힘은 여기서 끝나지 않습니다. 단일 이미지 드레스업의 경우, 다양하고 복잡한 드레스업 장면과 모든 의류 스타일을 처리할 수 있는 의류 인코더를 설계하기 위해 많은 양의 데이터를 사용합니다. 옷차림의 조합은 옷을 세밀하게 분할하는 전통적인 알고리즘을 깨고 단일 텍스트 명령으로 생성되는 효과가 현실적이고 자연스럽습니다.

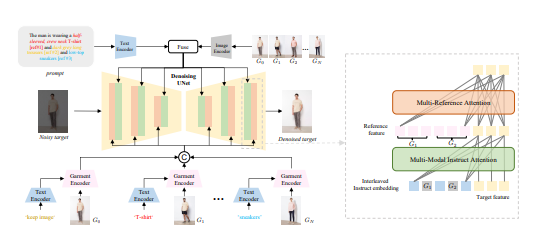

벤치마크 테스트에서 MMTryon은 새로운 SOTA를 직접 획득했으며 이 결과는 무시할 수 없습니다. 연구팀은 또한 드레싱 효과를 보다 정확하고 유연하게 만들기 위해 다중 모드 다중 참조 주의 메커니즘을 개발했습니다. 기존의 가상 시착 솔루션은 한 가지 아이템만 시착해 볼 수 있었거나 옷 스타일에 무기력했습니다. 하지만 이제 MMTryon이 모든 것을 해결해 드립니다.

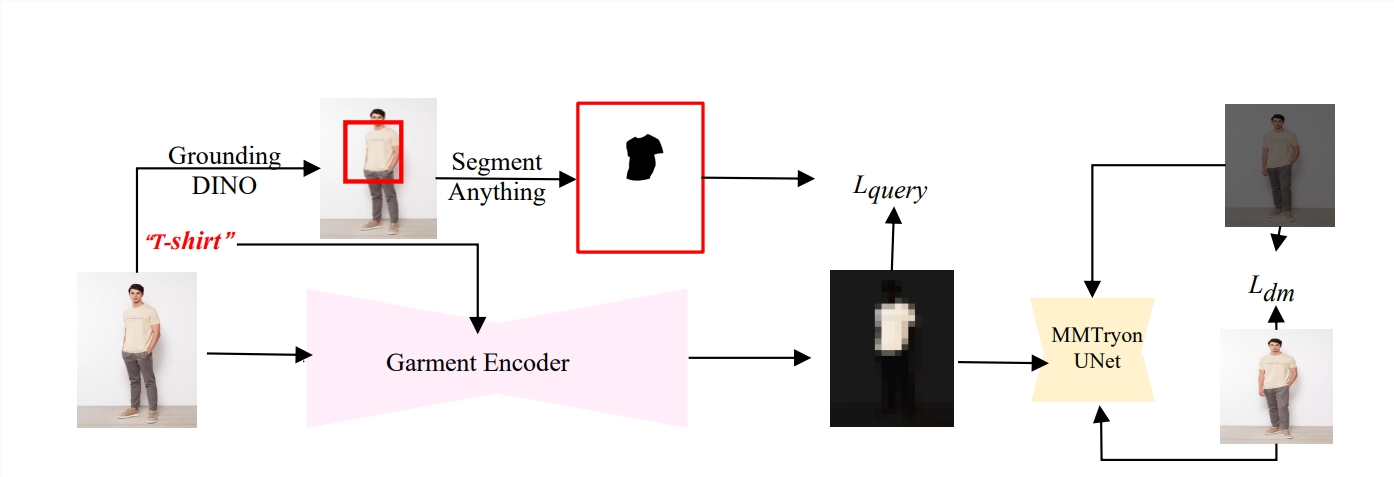

또한 MMTryon은 매우 똑똑합니다. 풍부한 표현 기능을 갖춘 의류 인코더와 확장 가능한 새로운 데이터 생성 프로세스를 결합하여 드레싱 프로세스에 분할이 필요하지 않으며 텍스트와 다중을 통해 직접 높은 수준의 성능을 달성할 수 있습니다. 고품질의 가상 드레스업.

오픈 소스 데이터 세트와 복잡한 시나리오에 대한 광범위한 실험을 통해 MMTryon이 질적으로나 양적으로 기존 SOTA 방법보다 우수한 것으로 입증되었습니다. 연구팀은 또한 텍스트를 쿼리로 사용하여 텍스트의 해당 영역의 기능을 활성화하여 의류 분할에 대한 의존성을 없애는 의류 인코더를 사전 학습했습니다.

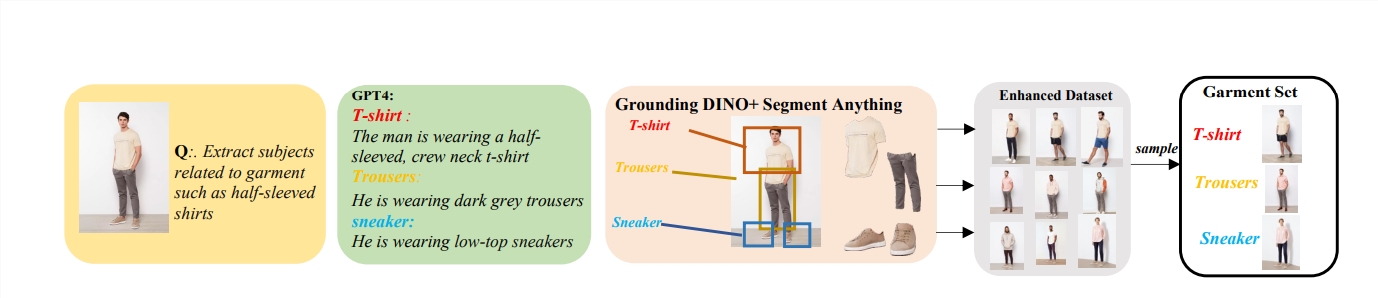

더욱 놀라운 점은 연구팀이 결합된 드레스 변경을 훈련하기 위해 대형 모델을 기반으로 한 데이터 증폭 모델을 제안하고 100만 개의 향상된 데이터 세트를 구축하여 MMTryon이 다양한 유형의 드레스 변경에 대한 실제 가상 시험을 할 수 있다는 것입니다. 효과.

MMTryon은 패션 업계의 검은 기술과도 같습니다. 한 번의 클릭으로 옷을 입어볼 수 있을 뿐만 아니라 옷을 선택하는 데 도움을 주는 패션 드레싱 도우미 역할도 합니다. 정량적 지표와 인간 평가 측면에서 MMTryon은 다른 기준 모델을 능가하며 탁월한 결과를 얻었습니다.

논문 주소: https://arxiv.org/abs/2405.00448

전체적으로 MMTryon은 효율적이고 정확하며 편리한 가상 체험 기능을 통해 패션 분야에서 큰 응용 가능성을 보여주었으며 의류 디자인과 쇼핑 경험에 혁명적인 변화를 가져왔습니다. 선도적인 기술과 뛰어난 성능으로 가상 체험 분야의 새로운 벤치마크가 되었습니다.