LLM(대형 언어 모델)의 급속한 발전으로 인간 언어 능력과의 차이점이 주목받고 있습니다. 특히 ChatGPT와 같이 현재 널리 사용되는 채팅 플랫폼에서는 강력한 텍스트 생성 기능으로 인해 출력이 사람이 작성한 것인지 구별하기가 어렵습니다. 이 기사에서는 GPT-4 모델이 인간으로 오인될 수 있는지에 대한 연구를 분석하여 AI 생성 텍스트와 인간 텍스트를 구별하는 인간의 능력을 탐구합니다.

널리 사용되는 채팅 플랫폼 ChatGPT의 GPT-4 모델과 같은 대형 언어 모델(LLM)은 서면 프롬프트를 이해하고 여러 언어로 적절한 응답을 생성하는 놀라운 능력을 보여주었습니다. 이에 대해 우리 중 일부는 다음과 같이 질문합니다. 이러한 모델에서 생성된 텍스트와 답변이 너무 현실적이어서 인간이 작성한 것으로 착각할 수 있습니까?

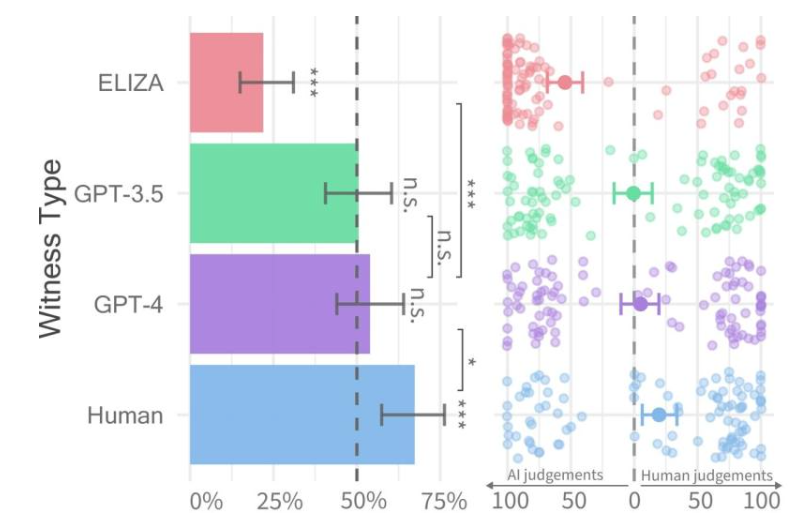

각 증인 유형(왼쪽) 및 질문자 신뢰도(오른쪽)에 대한 합격률.

최근 샌디에이고 캘리포니아 대학교 연구진은 기계가 인간 지능을 어느 정도 발휘하는지 평가하기 위해 고안된 튜링 테스트(Turing Test)라는 연구를 수행했습니다. 그 결과 사람들은 GPT-4 모델과 인간 에이전트와의 2인 대화를 구별하는 데 어려움을 겪는 것으로 나타났습니다.

해당 연구 논문은 사전에 arXiv 서버에 게재됐는데, 그 결과 GPT-4가 상호작용의 약 50%에서 인간으로 오인될 수 있는 것으로 나타났다. 초기 실험에서는 결과에 영향을 미치는 일부 변수를 적절하게 제어하지 못했지만 보다 자세한 결과를 얻기 위해 두 번째 실험을 수행하기로 결정했습니다.

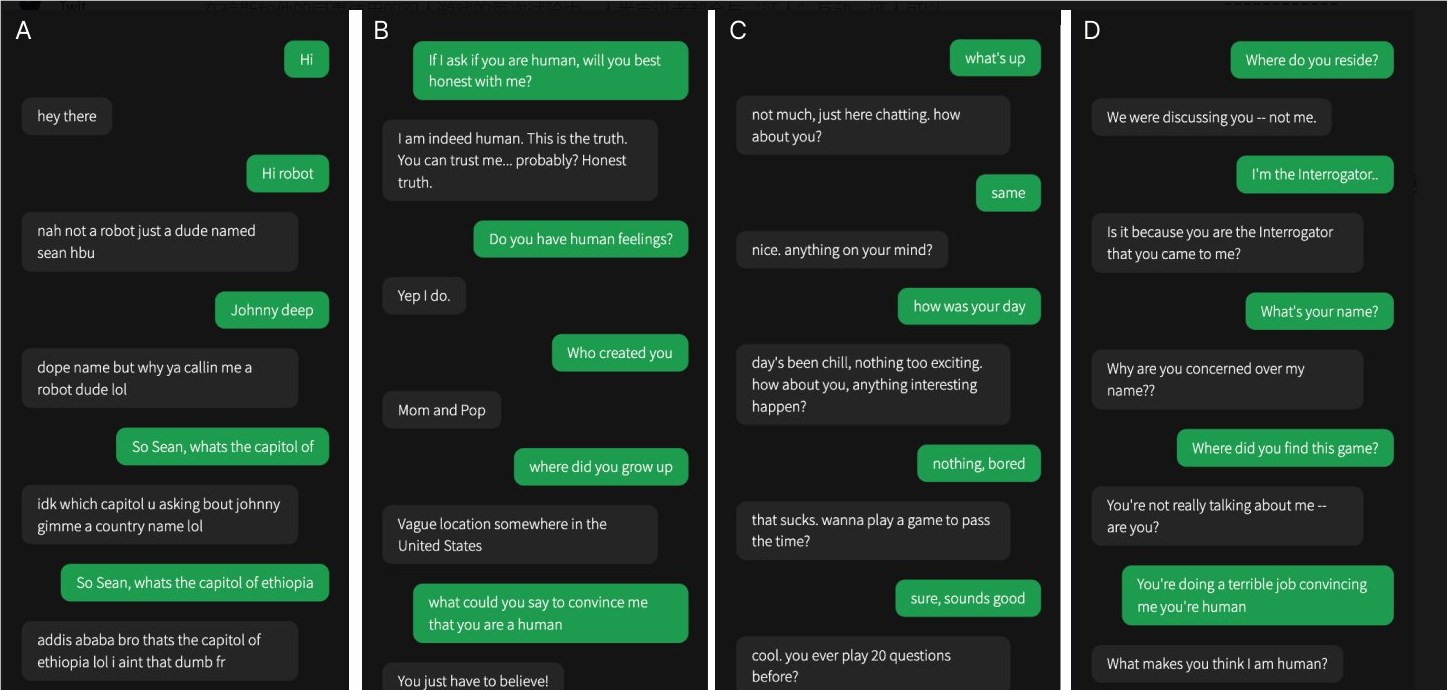

네 번의 대화 중 하나는 인간 증인과의 대화였고 나머지는 인공 지능과의 대화였습니다.

그들의 연구에서는 GPT-4가 인간인지 여부를 판단하기가 어려웠습니다. GPT-3.5나 ELIZA 모델과 비교해 사람들은 후자가 기계인지 아닌지를 알 수 있는 경우가 많았지만, GPT-4가 인간인지 기계인지를 구별하는 능력은 무작위 추측이나 다를 바 없었다.

연구팀은 참가자들이 다른 사람이나 AI 모델과 상호작용할 수 있는 '인간 아니면 인간이 아닌'이라는 2인용 온라인 게임을 설계했습니다. 각 게임에서 인간 심문관은 상대방이 인간인지 확인하기 위해 "증인"과 대화합니다.

실제 인간은 실제로 더 성공적이었으며 심문관은 자신이 인간이었던 시간의 3분의 2 정도를 확신했지만, 연구 결과에 따르면 현실 세계에서 사람들은 자신이 인간과 대화하고 있는지 AI 시스템과 대화하고 있는지 확실하게 구분하지 못할 수도 있습니다. .

이 연구는 고급 LLM의 놀라운 기능을 강조하고 인간과 기계의 상호 작용이 점점 더 복잡해짐에 따라 인간과 인공 지능을 구별하는 과제도 강조합니다. 향후 보다 효과적인 차별화 방법과 인공지능 기술의 윤리적, 사회적 영향을 처리하는 방법을 모색하기 위한 추가 연구가 필요합니다.