비영리 인공지능 연구 기관인 Ai2가 새로운 개방형 언어 모델인 OLMo2 시리즈를 출시했습니다. 이는 OLMo 시리즈의 2세대 제품으로, 완전 오픈 소스 코드 기능은 오픈 소스 AI 분야의 최신 발전을 나타냅니다. OLMo2는 오픈 소스 이니셔티브의 정의를 엄격하게 준수하며 모든 교육 데이터, 도구 및 코드는 공개적으로 사용할 수 있습니다. 이는 "개방형"이라고 주장하지만 완전한 오픈 소스는 아닌 다른 언어 모델과 뚜렷한 대조를 이룹니다. Ai2의 움직임은 오픈 소스 커뮤니티의 혁신과 발전을 촉진하고 글로벌 개발자에게 강력한 기술 지원과 리소스 공유 플랫폼을 제공하는 것을 목표로 합니다.

Meta의 Llama 시리즈와 같이 현재 시중에 나와 있는 다른 "개방형" 언어 모델과 달리 OLMo2는 오픈 소스 이니셔티브(Open Source Initiative)의 엄격한 정의를 충족합니다. 즉, 개발에 사용되는 교육 데이터, 도구 및 코드가 공개되어 누구나 액세스할 수 있습니다. 사용. 오픈 소스 이니셔티브(Open Source Initiative)에서 정의한 대로 OLMo2는 올해 10월에 확정된 "오픈 소스 AI" 표준에 대한 조직의 요구 사항을 충족합니다.

Ai2는 블로그에서 공유 리소스를 통해 오픈 소스 커뮤니티에서 혁신과 발견을 촉진하는 것을 목표로 OLMo2 개발 과정에서 모든 훈련 데이터, 코드, 훈련 계획, 평가 방법 및 중간 체크포인트가 완전히 공개되었다고 언급했습니다. "우리의 데이터, 솔루션 및 연구 결과를 공개적으로 공유함으로써 우리는 오픈 소스 커뮤니티에 새로운 방법과 혁신적인 기술을 발견할 수 있는 리소스를 제공할 수 있기를 바랍니다."

OLMo2 시리즈에는 두 가지 버전이 포함되어 있습니다. 하나는 70억 개의 매개변수가 있는 OLMo7B이고 다른 하나는 130억 개의 매개변수가 있는 OLMo13B입니다. 매개변수 수는 모델 성능에 직접적인 영향을 미치며 매개변수가 더 많은 버전은 일반적으로 더 복잡한 작업을 처리할 수 있습니다. OLMo2는 일반적인 텍스트 작업에서 좋은 성능을 발휘하여 질문에 답하기, 문서 요약, 코드 작성과 같은 작업을 완료할 수 있었습니다.

OLMo2를 교육하기 위해 Ai2는 5조 개의 토큰이 포함된 데이터 세트를 사용했습니다. 토큰은 언어 모델에서 가장 작은 단위입니다. 100만 개의 토큰은 대략 750,000개의 단어와 같습니다. 훈련 데이터에는 고품질 웹 사이트, 학술 논문, Q&A 토론 게시판, 합성 수학 워크북의 콘텐츠가 포함되어 있으며 모델의 효율성과 정확성을 보장하기 위해 신중하게 선택됩니다.

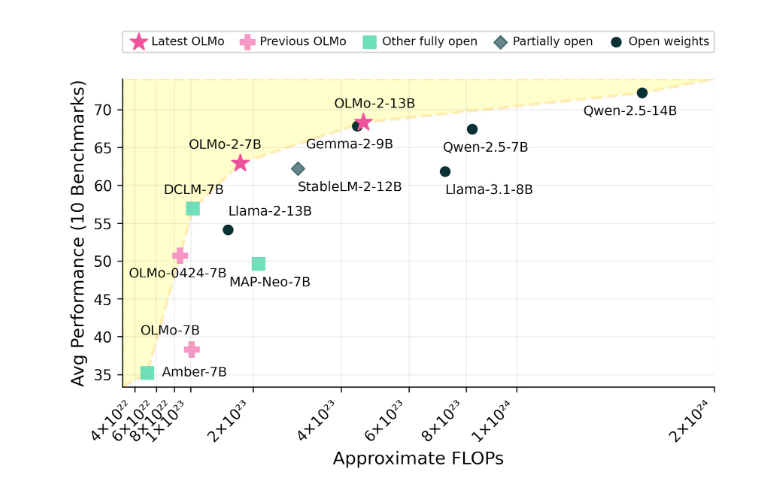

Ai2는 Meta의 Llama3.1 등 오픈소스 모델과 성능 면에서 경쟁했다고 주장하며 OLMo2의 성능에 자신감을 갖고 있다. Ai2는 OLMo27B의 성능이 Llama3.18B를 능가하며 현재 가장 강력한 완전 개방형 언어 모델 중 하나가 되었다고 지적했습니다. 모든 OLMo2 모델과 해당 구성 요소는 Ai2 공식 웹사이트를 통해 무료로 다운로드할 수 있으며 Apache2.0 라이센스를 따릅니다. 이는 이러한 모델을 연구용뿐만 아니라 상업용 응용 프로그램에도 사용할 수 있음을 의미합니다.

OLMo2의 오픈소스 기능과 뛰어난 성능은 인공지능 분야 발전에 새로운 가능성을 가져왔고, 오픈소스 커뮤니티에 새로운 활력을 불어넣고 있다. 앞으로의 발전과 활용을 기대해 볼 만하다.