DeepSeek은 2025년 1월 20일 강화 학습 훈련을 기반으로 한 첫 번째 추론 모델 DeepSeek-R1을 출시했습니다. 이 모델은 여러 벤치마크 테스트에서 OpenAI-o1-1217과 비슷하거나 그보다 더 나은 성능을 보여주었습니다. DeepSeek-R1은 직접 훈련하지 않고 다단계 훈련과 Cold Start 데이터를 통해 DeepSeek-V3-Base 모델을 기반으로 강화학습 훈련 모델(DeepSeek-R1-Zero)만을 사용하여 발생하는 문제를 극복합니다. 가독성 저하, 언어 혼합 등의 문제는 궁극적으로 상당한 성능 향상으로 이어졌습니다. 이 모델은 오픈 소스이며 경쟁력 있는 API 액세스 가격을 제공하여 사용자에게 보다 편리하고 경제적인 옵션을 제공합니다.

2025년 1월 20일 DeepSeek은 강화 학습(RL)을 통해 훈련된 최초의 추론 모델 DeepSeek-R1의 출시를 발표했습니다. 이는 여러 추론 벤치마크에서 OpenAI-o1-1217과 비슷한 성능을 달성했습니다. DeepSeek-R1은 DeepSeek-V3-Base 모델을 기반으로 하며 다단계 교육 및 콜드 스타트 데이터를 사용하여 추론 기능을 향상시킵니다.

DeepSeek 연구자들은 지도 미세 조정을 위한 준비 단계 없이 대규모 강화 학습을 통해 완전히 훈련된 모델인 DeepSeek-R1-Zero를 처음 개발했습니다. DeepSeek-R1-Zero는 추론 벤치마크에서 뛰어난 성능을 보여주었습니다. 예를 들어 AIME2024 시험에서 pass@1 점수가 15.6%에서 71.0%로 증가했습니다. 그러나 DeepSeek-R1-Zero에도 가독성이 좋지 않고 언어가 혼합되는 등 몇 가지 문제가 있습니다.

이러한 문제를 해결하고 추론 성능을 더욱 향상시키기 위해 DeepSeek 팀은 DeepSeek-R1을 개발했습니다. DeepSeek-R1은 강화 학습 이전에 다단계 훈련과 콜드 스타트 데이터를 도입합니다. 특히 연구원들은 DeepSeek-V3-Base 모델을 미세 조정하기 위해 먼저 수천 개의 콜드 스타트 데이터를 수집했습니다. 그런 다음 DeepSeek-R1-Zero를 훈련하면서 추론 지향 강화 학습을 수행했습니다. 강화학습 과정이 수렴에 가까워지면 강화학습 체크포인트의 거부 샘플링을 통해 새로운 지도 미세 조정 데이터를 생성하고 글쓰기, 사실 답변, 자기 인식 등 영역에서 DeepSeek-V3의 지도 데이터와 결합한 후 재교육했습니다. DeepSeek-V3-Base 모델. 마지막으로 모든 시나리오의 단서를 사용하여 미세 조정된 체크포인트에 대해 추가 강화 학습이 수행됩니다.

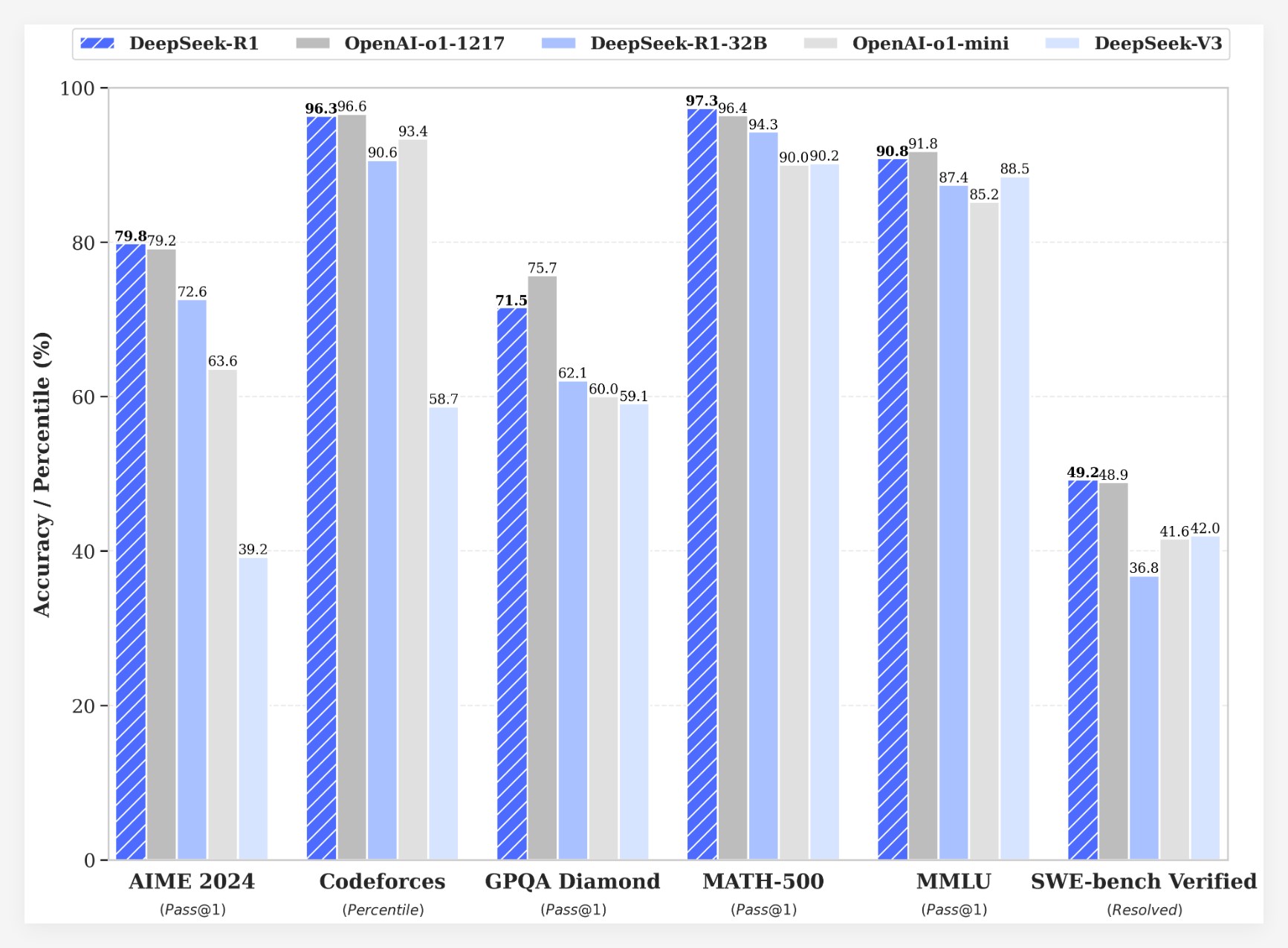

DeepSeek-R1은 여러 벤치마크에서 인상적인 결과를 달성했습니다.

•AIME2024 시험에서 DeepSeek-R1의 pass@1 점수는 OpenAI-o1-1217보다 약간 높은 79.8%를 기록했습니다.

•MATH-500 시험에서 DeepSeek-R1의 pass@1 점수는 OpenAI-o1-1217과 동일한 97.3%를 기록했습니다.

•코드 경쟁 작업에서 DeepSeek-R1은 Codeforces에서 2029 Elo 등급을 달성하여 인간 참가자의 96.3%를 능가했습니다.

•MMLU, MMLU-Pro 및 GPQA Diamond와 같은 지식 벤치마크에서 DeepSeek-R1은 각각 90.8%, 84.0% 및 71.5%를 기록하여 DeepSeek-V3보다 훨씬 뛰어납니다.

•DeepSeek-R1은 창의적인 글쓰기, 일반 Q&A, 편집, 요약 등과 같은 다른 작업에서도 잘 작동합니다.

또한 DeepSeek은 DeepSeek-R1의 추론 기능을 더 작은 모델로 추출하는 방법도 탐색합니다. DeepSeek-R1에서 직접 증류하는 것이 작은 모델에 강화 학습을 적용하는 것보다 더 나은 성능을 보이는 것으로 나타났습니다. 이는 대규모 기본 모델에서 발견된 추론 패턴이 추론 기능을 향상하는 데 중요하다는 것을 의미합니다. DeepSeek은 Qwen 및 Llama를 기반으로 하는 DeepSeek-R1-Zero, DeepSeek-R1 및 DeepSeek-R1에서 증류된 6개의 밀도 모델(1.5B, 7B, 8B, 14B, 32B, 70B)을 오픈 소스로 보유하고 있습니다. DeepSeek-R1의 출시는 대규모 언어 모델의 추론 기능을 향상시키는 강화 학습의 상당한 진전을 나타냅니다.

비용 우위비용 측면에서 DeepSeek-R1은 매우 경쟁력 있는 가격 전략을 제공합니다. API 액세스 가격은 입력 토큰 1백만개당 0.14달러(캐시 적중) 및 0.55달러(캐시 누락), 출력 토큰 1백만개당 2.19달러입니다. 이 가격 전략은 다른 유사한 제품보다 더 매력적이며 사용자들에 의해 "게임 체인저"로 묘사되었습니다. 공식 웹사이트와 API가 이제 온라인에 공개되었습니다! DeepThink를 경험하려면 https://chat.deepseek.com을 방문하세요!

DeepSeek-R1의 출시로 커뮤니티에서 열띤 토론이 촉발되었습니다. 많은 사용자는 모델의 오픈 소스 특성과 비용 이점을 높이 평가하며 개발자에게 더 많은 선택권과 자유를 제공한다고 믿습니다. 그러나 일부 사용자는 모델의 컨텍스트 창 크기에 대해 질문을 제기했으며 향후 버전이 더욱 최적화될 수 있기를 바랍니다.

DeepSeek 팀은 모델의 성능과 사용자 경험을 개선하기 위해 계속 노력할 것이며 AGI(Artificial General Intelligence)에 대한 사용자 기대에 부응하기 위해 고급 데이터 분석을 포함한 더 많은 기능을 향후 출시할 계획이라고 밝혔습니다.

DeepSeek-R1의 출시는 대규모 언어 모델의 추론 능력을 향상시키는 강화 학습의 큰 잠재력을 보여줄 뿐만 아니라 AI 분야의 발전에 새로운 방향과 가능성을 제시합니다. 오픈소스 기능과 경쟁력 있는 가격 전략은 AI 기술의 대중화와 적용을 더욱 촉진할 것입니다.