Zhejiang University와 Alibaba Damo Academy는 교육 비디오를 사용하여 고품질 다중 모드 교과서 데이터 세트를 구축하는 획기적인 연구를 공동으로 시작했습니다. 본 연구는 기존 대규모 언어 모델(VLM) 사전 학습 데이터의 낮은 지식 밀도와 약한 이미지-텍스트 상관 관계 문제를 해결하고, 더 나은 VLM 학습 자료를 제공하며, 교육 자원 활용을 혁신하는 것을 목표로 합니다. 연구팀은 대규모 교육 영상을 수집하고 처리했으며, 최종적으로 총 22,000시간이 넘는 다양한 분야를 포괄하는 고품질 데이터 세트를 구축하여 교육 분야에서 인공지능을 적용할 수 있는 새로운 가능성을 제시했습니다.

최근 절강대학교와 알리바바 다모 아카데미는 교육 영상을 통해 고품질의 다중 모드 교과서를 만들기 위한 눈길을 끄는 연구를 공동으로 발표했습니다. 이 혁신적인 연구 결과는 대규모 언어 모델(VLM) 훈련에 대한 새로운 아이디어를 제공할 뿐만 아니라 교육 자원 활용 방식을 바꿀 수도 있습니다.

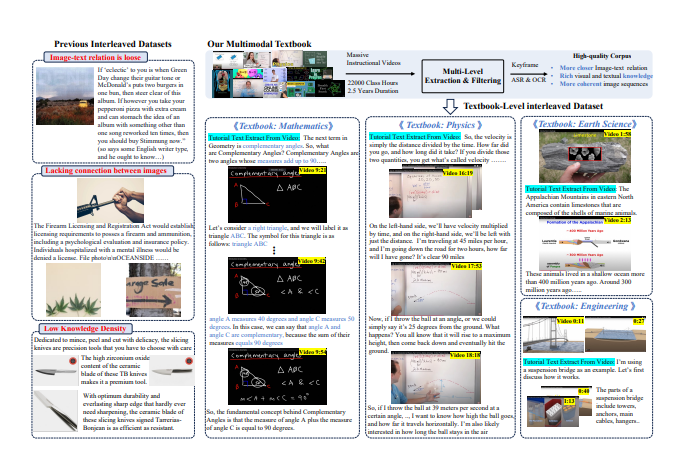

인공 지능 기술의 급속한 발전으로 인해 VLM의 사전 훈련 코퍼스는 주로 이미지-텍스트 데이터와 이미지-텍스트가 얽힌 코퍼스에 의존합니다. 그러나 현재 데이터의 대부분은 웹페이지에서 나오며, 텍스트와 이미지 간의 상관관계가 약하고, 지식 밀도가 상대적으로 낮아 복잡한 시각적 추론을 효과적으로 지원하지 못합니다.

이러한 과제를 해결하기 위해 연구팀은 인터넷에 있는 수많은 교육 동영상에서 고품질의 지식 코퍼스를 추출하기로 결정했습니다. 그들은 159,000개 이상의 교육용 비디오를 수집했으며 신중한 필터링과 처리를 거쳐 마침내 수학, 물리학, 화학 등 다양한 주제를 다루는 총 22,000시간 이상의 고품질 비디오 75,000개를 보유했습니다.

연구원들은 복잡한 "비디오-교과서" 처리 파이프라인을 설계했습니다. 먼저 자동음성인식(ASR) 기술을 이용해 영상 속 설명 내용을 텍스트로 전사한 뒤, 이미지 분석과 텍스트 매칭을 통해 지식 포인트와 연관성이 높은 클립을 선별한다. 마지막으로 이러한 처리된 키프레임, OCR 텍스트 및 복사된 텍스트는 인터리브되고 구성되어 풍부한 콘텐츠와 엄격한 구조를 갖춘 다중 모드 교과서를 형성합니다.

본 연구의 예비 결과는 이전의 웹 중심 데이터 세트와 비교하여 새로 생성된 교과서 데이터 세트가 지식 밀도와 이미지 상관 관계를 크게 향상시켜 VLM 학습을 위한 보다 견고한 기반을 제공한다는 것을 보여줍니다. 또한, 해당 연구는 학계의 폭넓은 관심을 끌었으며 관련 데이터 세트는 단 2주 만에 7,000건 이상의 다운로드를 기록하며 Hugging Face 플랫폼 인기 목록 상위권에 빠르게 올라갔습니다.

이러한 혁신적인 시도를 통해 연구자들은 VLM 개발을 촉진할 뿐만 아니라 교육 자원의 통합 및 적용에 있어 새로운 가능성을 열어주기를 희망합니다.

논문 주소: https://arxiv.org/pdf/2501.00958

이번 연구 결과는 인공지능 분야에 있어서 큰 의의가 있을 뿐만 아니라, 미래 교육 모델 개혁에 새로운 방향을 제시하는 것으로, 교육 분야에서 인공지능 기술이 폭넓게 활용될 수 있는 전망을 제시하고 있다. 이 데이터 세트의 오픈 소스는 전 세계 연구자들에게 귀중한 리소스를 제공하고 학계의 협력과 교류를 촉진합니다.