시각적 대형 모델(LVLM)은 이미지 이해 분야에서 상당한 진전을 이루었지만 '환상 현상'은 개발에 병목 현상이 되었습니다. 이 문제를 해결하기 위해 Taotian Group Future Life Laboratory 팀은 자체 보정된 시각적 앵커링 보상 메커니즘을 도입하여 모델의 시각적 영향을 효과적으로 향상시키는 "토큰 선호도 최적화"(TPO)라는 새로운 방법을 제안했습니다. 환각의 확률. TPO의 핵심은 토큰 수준 보상 신호 생성을 자동화하고, 지루한 수동 주석을 피하고, 시각적 정보에 대한 의존도를 반영하는 각 토큰에 보상을 할당하여 모델 성능을 향상시키는 것입니다.

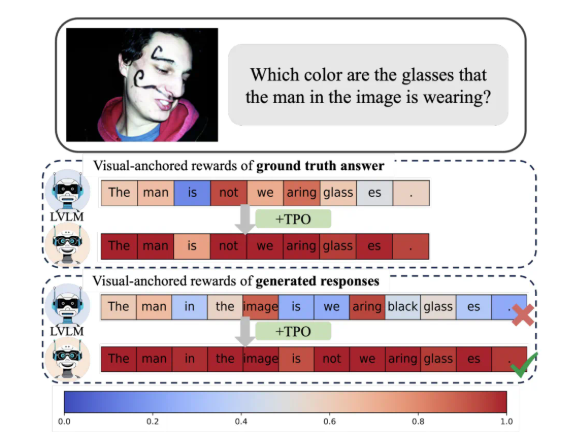

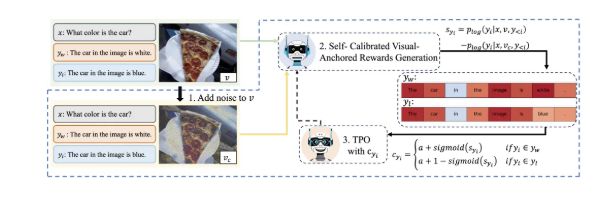

TPO의 가장 큰 혁신은 자동화된 토큰 수준 보상 신호를 구현한다는 것입니다. 이 방법은 기본 설정 데이터에서 시각적으로 고정된 토큰을 자동으로 식별하여 지루한 수동 세부 주석을 피하는 동시에 각 토큰에 훈련 프로세스 중 시각적 정보에 대한 의존성을 반영하는 보상을 할당할 수 있습니다. 자체 보정된 시각적 고정 보상 신호는 시각적 정보에 대한 모델의 의존성을 최적화하여 환각 발생을 효과적으로 완화하도록 설계되었습니다.

연구에 따르면 TPO를 사용하는 모델은 여러 평가 벤치마크, 특히 모델에 의해 생성된 답변이 언어 모델에 대한 사전 지식보다는 이미지 정보에 점점 더 의존하는 더 복잡한 작업에서 기존 방법보다 훨씬 뛰어난 성능을 보입니다. 이러한 진전은 모델에 대한 이해를 향상시킬 뿐만 아니라 추가 연구를 위한 중요한 이론적 기초를 제공합니다.

또한 연구팀은 TPO의 다양한 매개변수 설정에 대한 절제 실험을 수행하여 최적화된 노이즈 추가 단계와 보상 분배 전략이 모델 성능을 더욱 향상시킬 수 있음을 발견했습니다. 이 발견은 의심할 여지 없이 대규모 시각적 모델의 향후 연구 및 적용 방향을 제시합니다.

즉, Taotian의 이러한 혁신적인 성과는 다중 모드 정렬 기술에 대한 새로운 아이디어를 제공하고 생활 및 소비 분야에서 AI 기술의 심층적 적용을 촉진합니다.

TPO 방식의 적용을 통해 대형 시각모델의 '환상' 문제를 효과적으로 해결하고, 모델의 신뢰성과 정확성을 향상시키며, 향후 대형 시각모델 개발에 새로운 방향을 제시한다. 인공지능을 실생활에 적용하기 위한 새로운 방향을 제시한 응용 프로그램은 견고한 기반을 마련했으며 중요한 이론적 의의와 응용 가치를 갖고 있습니다. 이번 연구 결과는 멀티모달 기술 개발에 새로운 힘을 실어준다.