이 기사는 Clip 모델의 비주얼 인코더 성능을 향상시키고 길고 복잡한 텍스트 설명을 처리 할 때의 한계를 해결하는 것을 목표로하는 Tongji University와 협력하여 Microsoft가 개발 한 LLM2Clip 방법을 소개합니다. LLM2Clip은 대형 언어 모델 (LLM)을 통합하고 "제목 대비 미세 조정"기술을 소개하여 이미지와 텍스트를 일치시키는 모델의 기능을 크게 향상시킵니다. 여러 데이터 세트 에서이 방법의 실험 결과는 이미지-텍스트 및 텍스트-이미지 검색 작업, 특히 길고 짧은 텍스트 검색 작업에서 전통적인 클립과 EVA 모델을 능가하고 강력한 교차 고문 처리를 보여줍니다. 능력.

오늘날의 과학 기술 분야에서 클립 (대조 언어 이미지 사전 훈련)은 중요한 멀티 모달 기본 모델입니다. 대규모 이미지 텍스트 쌍에서 대비 학습 손실을 사용하여 시각적 및 텍스트 신호를 공유 기능 공간으로 결합합니다.

검색자는 클립이 제로 샷 분류, 감지, 세분화 및 이미지 텍스트 검색과 같은 다양한 작업을 지원할 수 있습니다. 한편, 기능 추출기로서 이미지 이해력, 비디오 이해력, 텍스트-이미지 또는 비디오 생성과 같은 거의 모든 교차 모달 표현 작업을 지배합니다. 클립의 강력한 점은 자세한 텍스트 설명이 포함 된 대규모 네트워크 데이터에 대한 교육 덕분에 이미지를 자연어에 연결하고 인간 지식을 포착하는 능력입니다.

그러나 클립은 길고 복잡한 텍스트 설명을 다루는 데 특정 제한 사항이 있습니다. 이 문제를 극복하기 위해 Microsoft와 Tongji University의 연구원들은 LLM (Langer Models)을 통합하여 시각적 표현 학습을 향상시키는 것을 목표로 LLM2Clip 방법을 제안했습니다. 이 메소드는 원래 클립 텍스트 인코더를 대담하게 대체하고 LLM의 풍부한 지식을 사용하여 클립의 비주얼 인코더 성능을 향상시킵니다. 이 연구는 LLM을 클립에 직접 통합하면 성능 저하가 발생 하므로이 과제를 해결해야합니다.

LLM2Clip 메소드는 "타이틀 대비 미세 조정"기술을 도입하여 이미지 제목을 분리하는 LLM의 능력을 크게 향상시켜 성능이 크게 향상됩니다.

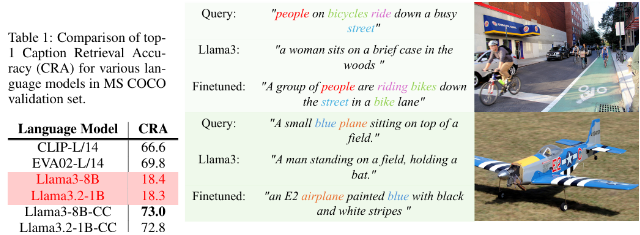

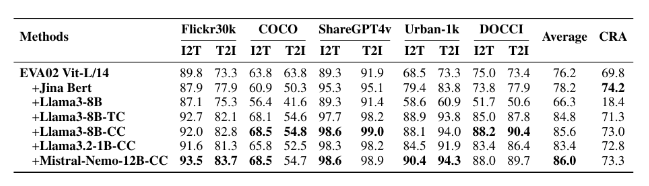

연구원들은 작은 CC-3M, 중간 CC-3M 및 CC-12M뿐만 아니라 큰 CC-3M, CC-12M, YFCC-15M 및 Recaption-1B를 포함한 미세 조정 실험에 다양한 크기의 데이터 세트를 사용했습니다. 결과는 LLM2Clip을 사용하여 훈련 된 모델이 이미지-텍스트 및 텍스트-이미지 검색 작업의 기존 클립 및 EVA 모델보다 더 잘 수행 함을 보여줍니다.

Llava 1.5와 같은 모델과 멀티 모드 교육을 결합하여 LLM2Clip은 거의 모든 벤치 마크에서, 특히 길고 짧은 텍스트 검색 작업을 처리 할 때 이전 EVA02 모델의 성능을 16.5%향상시킬 때 잘 수행되었습니다. 이 혁신적인 접근 방식은 클립을 단순히 영어 데이터를 단순히 처리하는 것에서 강력한 교차 언어 모델로 변환 할뿐만 아니라 미래의 클립 교육에 대한 기초를 제시합니다.

모델 : https://huggingface.co/collections/microsoft/llm2clip-672323a266173cfa40b32d4c

코드 : https://github.com/microsoft/llm2clip/

종이 : https://arxiv.org/abs/2411.04997

전철기:

LLM2Clip은 Tongji University와 협력하여 Microsoft 및 Tongji University가 제안한 혁신적인 접근 방식으로 Clip의 텍스트 인코더를 대체하여 Visual Encoder의 성능을 향상시키기위한 것을 목표로합니다.

이 방법은 기존의 최첨단 모델을 능가하는 "제목 대비 미세 조정"기술을 통해 이미지를 텍스트와 일치시키는 모델의 능력을 크게 향상시킵니다.

여러 데이터 세트에 대한 LLM2Clip의 실험에 따르면 길고 짧은 텍스트 검색 작업에서 기존 모델보다 성능이 우수하여 언어 교차 모델의 개발을 주도합니다.

요컨대, LLM2Clip 방법은 클립 모델의 개선을위한 새로운 아이디어를 제공하며, 교차 기능의 향상은 멀티 모달 모델의 향후 개발을위한 중요한 기준 값을 제공합니다. 관련 리소스 링크는 독자가 학습 및 연구에 편리합니다.