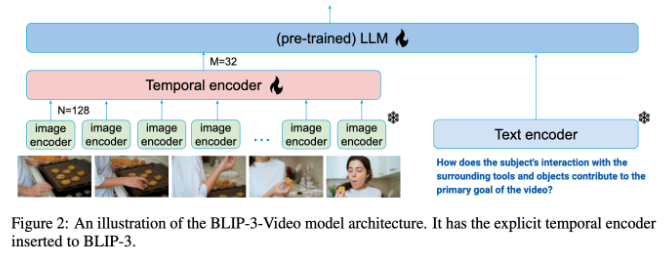

Salesforce AI Research 팀은 최신 멀티 모달 언어 모델 인 Blip-3-Video를 발표하여 성장하는 비디오 데이터를 효율적으로 처리하기위한 것입니다. 전통적인 비디오 이해 모델은 비효율적입니다. Blip-3-Video는 혁신적인 타이밍 인코더를 통해 비디오 정보를 16 ~ 32 개의 시각적 마커로 압축하여 컴퓨팅 효율성을 크게 향상시킵니다. 이 움직임은 긴 비디오를 다루는 문제를 해결하고 자율 주행 및 엔터테인먼트와 같은 산업에 더 강력한 비디오 이해 기능을 제공합니다.

최근 Salesforce AI 연구팀은 새로운 멀티 모달 언어 모델 인 Blip-3-Video를 출시했습니다. 비디오 컨텐츠가 급격히 증가함에 따라 비디오 데이터를 효율적으로 처리하는 방법이 긴급한 문제가되었습니다. 이 모델의 출현은 비디오 이해의 효율성과 효과를 향상 시키도록 설계되었으며 자율 주행에서 엔터테인먼트까지 산업에 적합합니다.

전통적인 비디오 이해 모델은 종종 프레임별로 비디오 프레임을 처리하여 많은 양의 시각적 정보를 생성합니다. 이 프로세스는 많은 컴퓨팅 리소스를 소비 할뿐만 아니라 긴 비디오를 처리하는 능력을 크게 제한합니다. 비디오 데이터의 양이 계속 증가함에 따라이 접근법은 점점 비효율적으로 증가하므로 컴퓨팅 부담을 줄이면 비디오의 중요한 정보를 캡처하는 솔루션을 찾는 것이 중요합니다.

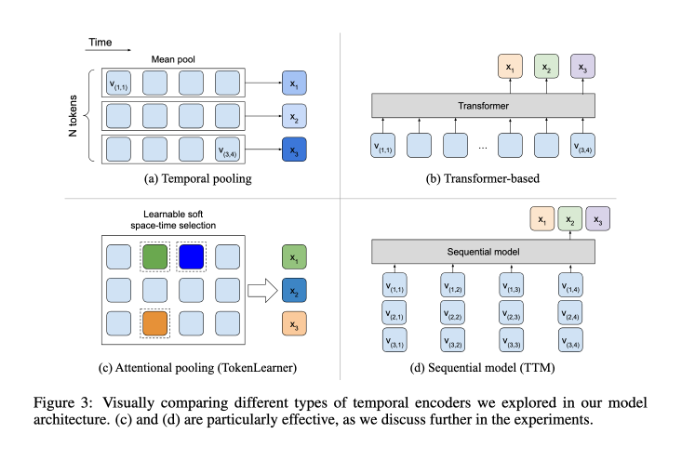

이와 관련하여 Blip-3-Video는 상당히 잘 수행되었습니다. "시간 시퀀스 인코더"를 도입 함으로써이 모델은 비디오에 필요한 시각 정보의 양을 16 ~ 32 개의 시각적 마커로 성공적으로 줄였습니다. 이 혁신적인 설계는 컴퓨팅 효율성을 크게 향상시켜 모델이 복잡한 비디오 작업을 저렴한 비용으로 완료 할 수 있도록합니다. 이 타이밍 인코더는 각 프레임에서 가장 중요한 정보를 추출하고 소형 시각적 마커 세트에 통합하는 학습 가능한 시공간 주의력 풀링 메커니즘을 사용합니다.

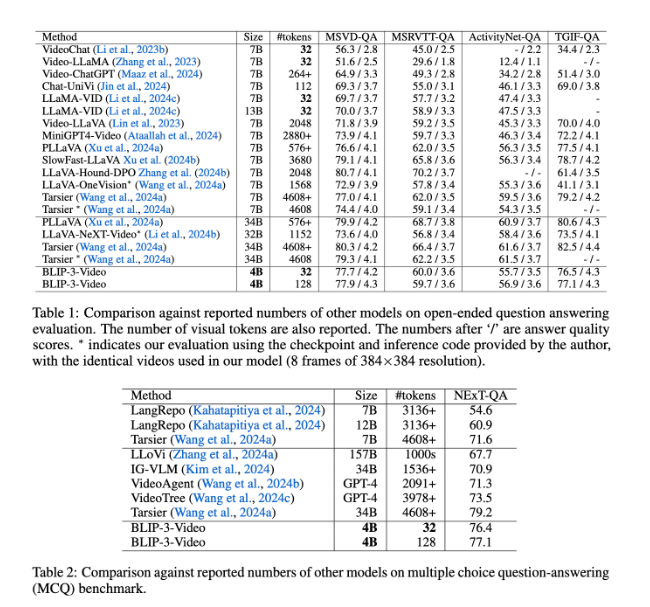

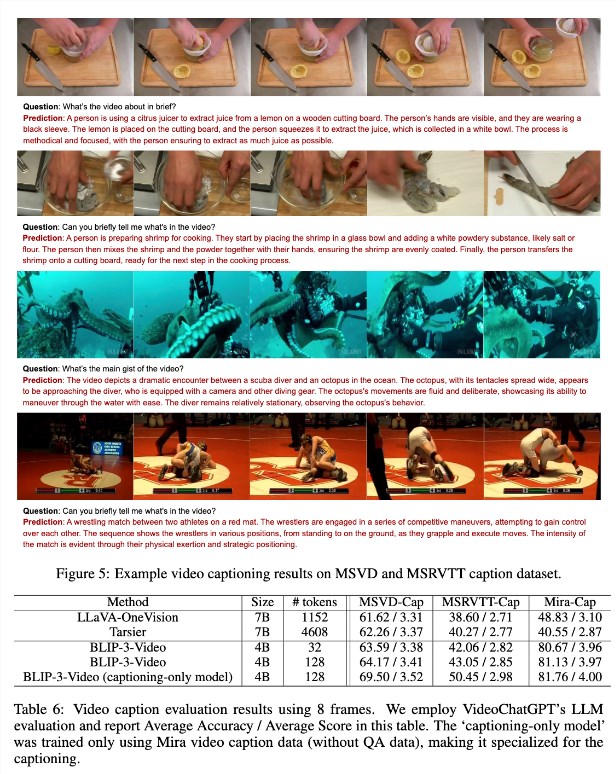

Blip-3-Video도 매우 잘 수행되었습니다. 다른 큰 모델과 비교 하여이 연구는이 모델이 비디오 Q & A 작업에서 비슷한 최고 모델의 정확도를 가지고 있음을 발견했습니다. 예를 들어, Tarsier-34B 모델은 8 프레임의 비디오 프레임을 처리하기 위해 4608 점 마크가 필요하지만 Blip-3-Video는 77.7% MSVD-QA 벤치 마크 점수를 달성하기 위해 32 점 만 필요합니다. 이는 Blip-3-Video가 고성능을 유지하면서 자원 소비를 크게 줄이는 것을 보여줍니다.

또한 객관식 질문 및 답변 작업에서 Blip-3-Video의 성능을 과소 평가해서는 안됩니다. 다음 -QA 데이터 세트 에서이 모델은 77.1%의 높은 점수를 얻었지만 TGIF-QA 데이터 세트에서는 77.1%의 정확도도 달성했습니다. 이 모든 데이터는 복잡한 비디오 문제를 처리 할 때 Blip-3-Video의 효율성을 나타냅니다.

Blip-3-Video는 혁신적인 타이밍 인코더를 통해 비디오 처리 분야에서 새로운 가능성을 열어줍니다. 이 모델의 출시는 비디오 이해의 효율성을 향상시킬뿐만 아니라 향후 비디오 응용 프로그램에 더 많은 가능성을 제공합니다.

프로젝트 입구 : https://www.salesforceairesearch.com/opensource/xgen-mm-vid/index.html

핵심 사항 :

-** 새로운 모델 릴리스 ** : Salesforce AI Research는 비디오 처리에 중점을 둔 멀티 모달 언어 모델 인 Blip-3-Video를 출시합니다.

- ** 효율적인 처리 ** : 타이밍 인코더를 사용하면 필요한 시각적 표시 수를 크게 줄이고 컴퓨팅 효율성을 크게 향상시킵니다.

- ** 우수한 성능 ** : 비디오 Q & A 작업의 탁월한 성능은 높은 정확도를 유지하면서 자원 소비를 줄입니다.

요컨대, Blip-3-Video는 효율적인 처리 기능과 우수한 성능으로 비디오 이해 분야에 상당한 진전을 가져 왔으며 응용 프로그램 전망은 광범위합니다. 이 모델의 오픈 소스는 또한 추가 연구 및 응용 프로그램을위한 좋은 토대를 제공합니다.