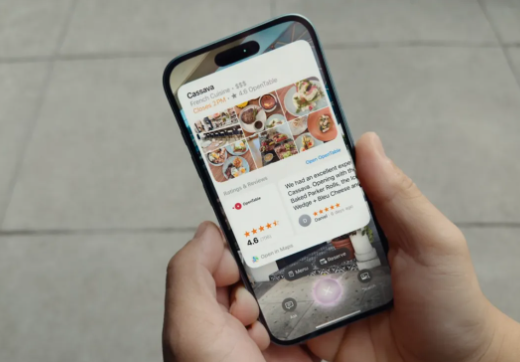

Apple은 iPhone 16 런칭에서 매우 기대되는 AI 구동 시각 정보 기능을 시작하여 iPhone의 카메라 기능을 새로운 수준으로 끌어 올렸습니다. iPhones는 Google 렌즈와 유사한 시각적 검색 기능을 제공합니다. 여기서 사용자는 식당 표지판을 식별하고 위치 및 리뷰를 찾는 등 사진을 찍음으로써 관련 정보를 얻을 수 있습니다. 이 혁신적인 기능은 정보 수집 프로세스를 크게 단순화하고 사용자에게보다 편리하고 더 똑똑한 모바일 경험을 제공합니다.

Apple은 방금 개최 된 iPhone 16 런칭 컨퍼런스에서 새로운 iPhone, AirPods 및 Apple Watch Series 10을 선보일뿐만 아니라 AI 구동 시각 정보 기능을 처음 출시했습니다. 이 새로운 기능은 Google 렌즈와 유사한 iPhone 카메라를 제공하여 더 똑똑한 사진 경험을 가능하게합니다.

Apple의 Visual Intelligence 기능을 통해 사용자는 싱글이나 레스토랑 표지판과 같은 사진을 찍어 주변의 객체를 캡처 한 다음 iPhone의 AI 기술을 사용하여보다 관련 정보를 검색하고 제공 할 수 있습니다. 사용자는 단순히 카메라를 켜고 인식하려는 항목의 사진을 찍어야하며 iPhone은 정보를 신속하게 처리하고 피드백합니다.

또한 Apple은 특히 데이터 개인 정보를 강조했습니다. 보안을 보장하기 위해 Apple의 프라이빗 클라우드 컴퓨팅에 사용자 촬영 데이터가 저장됩니다. 그러나 사용자가 원한다면 당사자의 서비스와 통합하도록 선택할 수도 있습니다. 예를 들어, 사용자는 캡처 된 콘텐츠를 Google에 직접 검색하도록 선택할 수 있습니다.

더 흥미로운 점은 Apple이 Chatgpt의 통합을 소개했다는 것입니다. 사용자는 Chatgpt가 카메라에서 캡처 한 이미지 데이터를 처리하여 자세한 정보와 제안을 추가로 얻을 수 있습니다. 이 모든 것은 사용자가 자신의 요구에 따라 해당 권한을 활성화할지 여부를 선택해야합니다.

iPhone 16과 iPhone 16Plus가 각각 799 달러와 899 달러의 가격으로 선주문을 수락하기 시작했지만 시각적 지능 기능은 즉시 사용할 수 없습니다. 애플은이 AI 기능이 다음 달 베타 버전으로 점차적으로 출시 될 것이며 앞으로 몇 개월 안에 더 많은 기능이 추가 될 것이라고 말했다.

핵심 사항 :

Apple의 Visual Intelligence 기능을 통해 iPhone 카메라는 Google 렌즈와 같은 시각적 검색을 수행 할 수 있습니다.

개인 정보 및 보안을 보장하기 위해 Apple의 프라이빗 클라우드 컴퓨팅에 사용자 데이터가 저장됩니다.

앞으로는 Chatgpt와 같은 타사 응용 프로그램과 통합되어 자세한 정보를 얻을 수도 있습니다.

대체로 Apple의 Visual Intelligence 기능은 iPhone 카메라로의 주요 업그레이드로 사용자가 주변 세계와 상호 작용하는 방식을 바꿀 것입니다. 기능은 여전히 테스트 단계에 있지만 잠재력은 무제한이며 미래의 개발과 더 많은 기능의 출시를 기대할 가치가 있습니다.