Princeton University와 Yale University의 연구원들은 대형 언어 모델 (LLM)의 "사고 (COT)"추론 능력에 대한 심층적 인 연구를 수행하고 관련 보고서를 발표했습니다. 이 연구는 테스트 작업으로 시프트 암호를 크래킹하고 분석을 위해 3 개의 LLMS GPT-4, Claude3 및 LLAMA3.1을 선택하여 COT 추론의 메커니즘을 나타 냈습니다. 연구에 따르면 LLM의 COT 추론은 단순한 상징적 논리적 추론이 아니라 여러 요인의 복잡한 상호 작용의 결과로 LLM의 추론 능력을 이해할 수있는 새로운 관점을 제공합니다.

프린스턴과 예일 대학의 연구원들은 최근 큰 언어 모델 (LLM)에서“연결 체인 (COT)의 추론 능력에 관한 보고서를 발표하여 COT 추론의 미스터리를 밝혀 냈습니다. 논리적 규칙에 근거한 상징적 추론이 아닙니다. 메모리, 확률 및 소음 추론을 결합합니다.

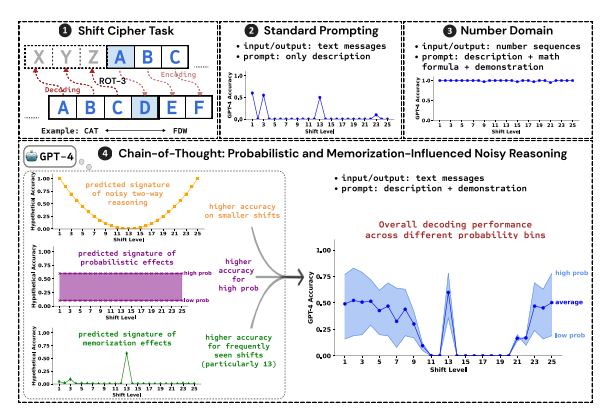

연구원들은 세 가지 LLM의 성능, GPT-4, Claude3 및 LLAMA3.1의 성능을 분석하기 위해 테스트 작업으로 시프트 비밀번호를 크래킹했습니다. 시프트 비밀번호는 간단한 인코딩 방법이며 각 문자는 고정 숫자로 알파벳으로 전진하는 문자로 대체됩니다. 예를 들어, 알파벳을 3 자리 숫자로 전진 시키면 "고양이"는 "FDW"가됩니다.

연구 결과에 따르면 COT 추론의 효과에 영향을 미치는 세 가지 주요 요인은 다음과 같습니다.

확률 : LLM은 추론 단계가 더 낮은 확률로 답변을 가리더라도 확률이 높은 출력을 생성하는 경향이 있습니다. 예를 들어, 추론 단계가 "staz"를 가리키지 만 "Stay"가 더 일반적인 단어 인 경우, LLM은 "자체를 수정"하고 "Stay"를 출력 할 수 있습니다.

메모리 : LLM은 사전 훈련 중에 많은 양의 텍스트 데이터를 기억하며, 이는 COT 추론의 정확도에 영향을 미칩니다. 예를 들어 ROT-13은 가장 일반적인 시프트 암호이며 LLM은 다른 유형의 시프트 암호보다 ROT-13에서 정확도가 상당히 높습니다.

소음 추론 : LLM의 추론 과정은 완전히 정확하지는 않지만 어느 정도의 소음이 있습니다. 시프트 암호의 변위가 증가함에 따라 디코딩에 필요한 중간 단계도 증가하고 노이즈 추론의 영향이 더 명백 해져서 LLM의 정확도가 감소합니다.

연구원들은 또한 LLM의 COT 추론이 자체 조건에 의존한다는 것을 발견했습니다. 즉, LLM은 후속 추론 단계의 문맥으로 텍스트를 명시 적으로 생성해야합니다. LLM에 텍스트를 출력하지 않고 "조용히 생각"하도록 지시 받으면 추론 능력이 크게 줄어 듭니다. 또한, 데모 단계의 효과는 시연 단계에 오류가 있더라도 LLM의 COT 추론 효과는 여전히 안정적으로 유지 될 수 있습니다.

이 연구는 LLM의 COT 추론이 완벽한 상징적 추론이 아니라 메모리, 확률 및 소음 추론과 같은 여러 요인을 결합한 것으로 나타났습니다. LLM은 COT 추론 과정에서 메모리 마스터의 특성을 보여줄뿐만 아니라 확률 마스터의 스타일도 보여줍니다. 이 연구는 LLM의 추론 능력을 더 깊이 이해하고보다 강력한 AI 시스템의 미래 개발을위한 귀중한 통찰력을 제공하는 데 도움이됩니다.

종이 주소 : https://arxiv.org/pdf/2407.01687

요약하면,이 연구는 큰 언어 모델의 추론 메커니즘을 이해하는 데 큰 의미가 있으며, 그 결과는 미래의 LLM의 추론 능력을 개선하고보다 강력한 AI 시스템을 개발하기위한 귀중한 참조를 제공합니다. 이 연구는 LLM 추론에 대한 확률, 기억 및 소음과 같은 요인의 영향을 강조하여 AI 분야의 연구원들에게 새로운 방향을 제공합니다.