고품질의 긴 비디오를 효율적으로 생성하는 것은 항상 컴퓨터 비전 분야에서 중요한 과제였습니다. Meta AI 연구원들은 기존 확산 변압기 모델 (DIT)의 느린 추론에 반응하여 Adacache라는 훈련이없는 가속 방법을 제안했습니다. Adacache는 비디오 컨텐츠 차이를 영리하게 활용하고, 각 비디오에 대한 캐싱 전략을 사용자 정의하며, 비디오 모션 컨텐츠를 기반으로 컴퓨팅 리소스를 동적으로 할당하기 위해 모션 정규화 체계를 도입하여 생성 품질을 보장하면서 추론 속도를 크게 향상시킵니다.

고품질의 시간 연속 비디오를 생성하려면 특히 더 긴 시간 동안 많은 컴퓨팅 리소스가 필요합니다. 최신 확산 변압기 모델 (DIT)이 비디오 생성에서 상당한 진전을 보였지만,이 과제는 더 큰 모델에 대한 의존과보다 복잡한주의 메커니즘으로 인해 느린 추론에 의해 악화됩니다. 이 문제를 해결하기 위해 Meta AI의 연구원들은 비디오 다이트를 가속화하기 위해 Adacache라는 교육이없는 방법을 제안했습니다.

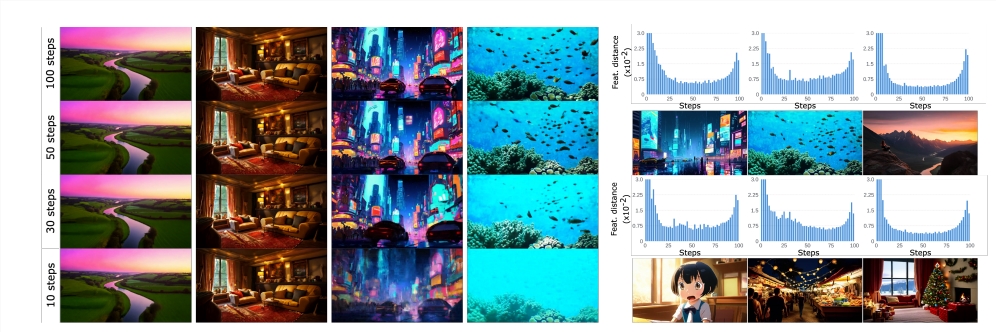

Adacache의 핵심 아이디어는 "모든 비디오가 동일하지는 않습니다"라는 사실을 기반으로합니다. 즉, 일부 비디오는 합리적인 품질을 달성하기 위해 다른 비디오보다 더 적은 피의 단계가 필요합니다. 이를 바탕 으로이 방법은 확산 프로세스 중 계산 결과를 캐시 할뿐만 아니라 각 비디오 생성에 대한 맞춤형 캐시 전략을 설계하여 품질과 대기 시간 간의 트레이드 오프를 최대화합니다.

연구원들은 Adacache의 비디오 정보를 사용하여 모션 컨텐츠에 기초한 컴퓨팅 리소스의 할당을 제어하는 모션 정규화 (Moreg) 체계를 도입했습니다. 고주파 텍스처와 다량의 모션 컨텐츠를 포함하는 비디오 시퀀스에는 합리적인 품질을 달성하기 위해 더 많은 확산 단계가 필요하기 때문에 Moreg는 컴퓨팅 리소스를 더 잘 할당 할 수 있습니다.

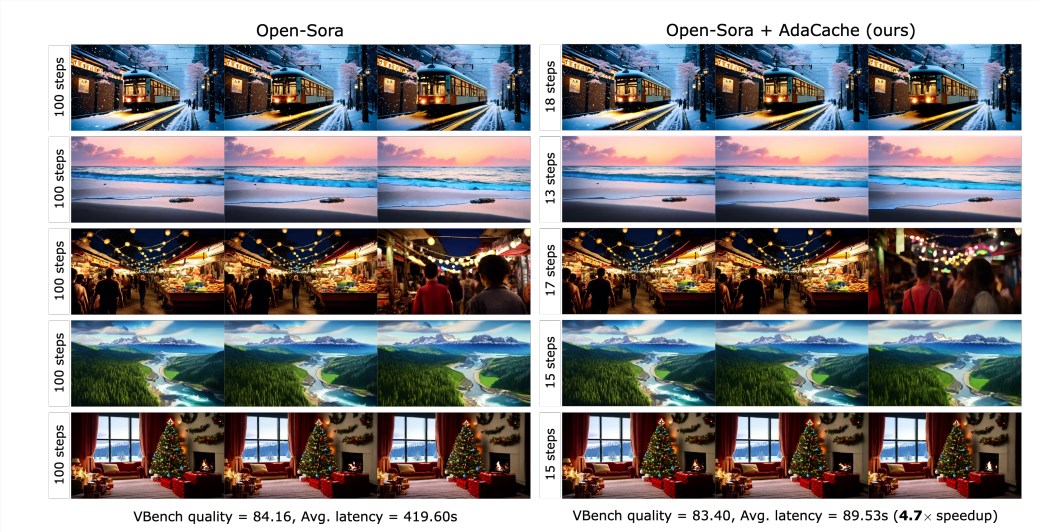

실험 결과에 따르면 Adacache는 생성 품질을 희생하지 않고 추론 속도 (예 : Open -SORA720P -2S 비디오 생성에서 최대 4.7 배 더 빠르게)를 크게 향상시킬 수 있습니다. 또한 Adacache는 일반화 기능이 우수하며 Open-Sora, Open-Sora-Plan 및 Latte와 같은 다양한 비디오 DIT 모델에 적용 할 수 있습니다. Adacache는 ∆-dit, t-gate 및 PAB와 같은 다른 훈련이없는 가속 방법에 비해 속도와 품질 모두에서 상당한 이점을 가지고 있습니다.

사용자 연구에 따르면 사용자는 다른 방법에 비해 Adacache-Gened 비디오를 선호하며 품질이 벤치 마크 모델과 비슷하다고 생각합니다. 이 연구는 Adacache의 효과를 확인하고 효율적인 비디오 생성 분야에 중요한 기여를합니다. Meta Ai는 Adacache가 널리 사용될 수 있으며 고 충실도 긴 비디오 생성의 대중화를 촉진 할 수 있다고 생각합니다.

종이 : https://arxiv.org/abs/2411.02397

프로젝트 홈페이지 :

https://adacache-dit.github.io/

Github :

https://github.com/adacache-dit/adacache

요컨대, 효율적인 비디오 생성 가속화 방법으로 Adacache는 고 충실도 긴 비디오 생성에 새로운 가능성을 제공하며, 상당한 성능 개선 및 우수한 사용자 경험으로 인해 향후 애플리케이션에서 광범위한 전망이 있습니다. Meta AI 의이 연구는 효율적인 비디오 생성 분야에서 중요한 돌파구를 가져 왔습니다.