최근 Vita-Mllm 팀은 VITA-1.0, 특히 다중 모드 상호 작용의 정확성을 기반으로 완전히 업그레이드되었습니다. Vita-1.5는 영어와 중국어의 두 언어를 지원할뿐만 아니라 여러 성능 지표에서 질적 도약을 달성하여 사용자에게 더 부드럽고 효율적인 대화식 경험을 제공합니다.

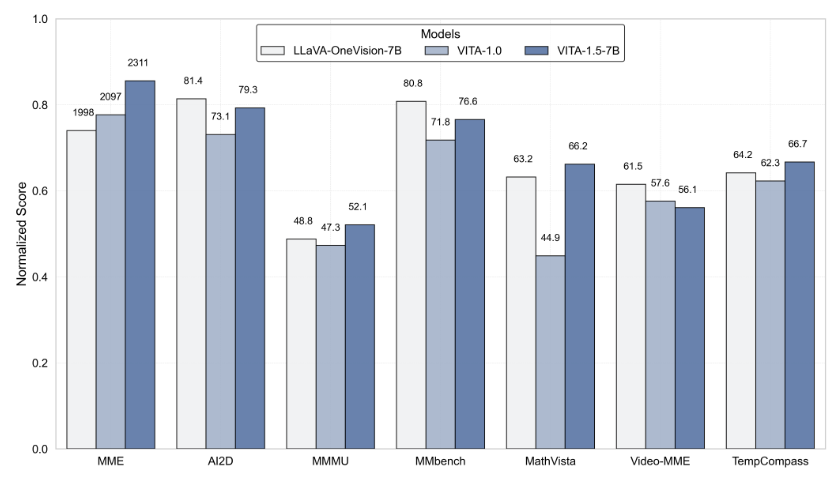

Vita-1.5는 상호 작용 지연에서 큰 획기적인 획기적인 획기적인 획기적인 결과를 얻었으며, 원래 4 초 지연을 1.5 초로 크게 단축시켰다. 이러한 개선을 통해 사용자는 음성 상호 작용 중에 거의 지연되지 않아 사용자 경험을 크게 향상시킵니다. 또한 VITA-1.5는 MME, MMBENCH 및 MATHVISTA와 같은 여러 벤치 마크 테스트를 통해 다중 모드 성능에서 크게 향상되었으며, 평균 성능은 59.8에서 70.8로 증가했습니다.

음성 처리 측면에서 Vita-1.5도 깊이 최적화되었습니다. 자동 음성 인식 (ASR) 시스템의 오류율은 18.4에서 7.5로 떨어졌으며 음성 명령의 이해와 응답 정확도가 크게 향상되었습니다. 동시에 Vita-1.5는 새로운 엔드 투 엔드 텍스트 음성 (TTS) 모듈을 소개합니다.이 텍스트-음성 (TTS) 모듈은 입력으로 대형 언어 모델 (LLM)의 임베딩을 직접받을 수 있으며, 음성 합성의 자연과 일관성을 크게 향상시킬 수 있습니다. .

멀티 모달 기능의 균형을 보장하기 위해 VITA-1.5는 점진적인 교육 전략을 채택하여 새로 추가 된 음성 처리 모듈이 시각적 언어 성능에 미치는 영향을 최소화하고 이미지 이해력 성능은 71.3에서 70.8로 약간 감소했습니다. 이러한 기술 혁신을 통해 VITA-1.5는 실시간 시각적 및 음성 상호 작용 사이의 경계를 더욱 촉진하여 미래의 지능형 상호 작용 애플리케이션을위한 견고한 토대를 마련합니다.

개발자의 경우 Vita-1.5는 사용하기에 매우 편리합니다. 개발자는 간단한 명령 라인 작업을 신속하게 시작할 수 있으며 팀은 기본 및 실시간 대화 형 데모를 제공하여 사용자가 시스템을 더 잘 이해하고 사용하도록 도와줍니다. 실시간 대화 형 경험을 더욱 향상시키기 위해서는 사용자가 VAD (Voice Activity Detection) 모듈과 같은 필요한 모듈을 준비해야합니다. 또한 Vita-1.5 코드는 완전히 오픈 소스가되어 개발자가 참여하고 기여 하고이 기술의 발전을 공동으로 홍보 할 수 있습니다.

Vita-1.5의 출시는 대화식 멀티 모달 대형 언어 모델에서 또 다른 중요한 이정표를 표시하여 기술 혁신 및 사용자 경험에서 Vita-Mllm 팀의 끊임없는 추구를 보여줍니다. 이 버전의 출시는 사용자에게보다 지능적인 대화식 경험을 제공 할뿐만 아니라 미래의 멀티 모달 기술 개발 방향을 지적합니다.

프로젝트 입구 : https://github.com/vita-mllm/vita?tab=readme-ov-file

핵심 사항 :

VITA-1.5는 상호 작용 대기 시간이 4 초에서 1.5 초로 단축되어 사용자 경험을 크게 향상시킵니다.

다중 벤치 마크의 평균 성능은 59.8에서 70.8로 증가하면서 멀티 모달 성능이 향상되었습니다.

음성 처리 기능이 향상되고 ASR 오류율이 18.4에서 7.5로 떨어졌으며 음성 인식이 더 정확합니다.