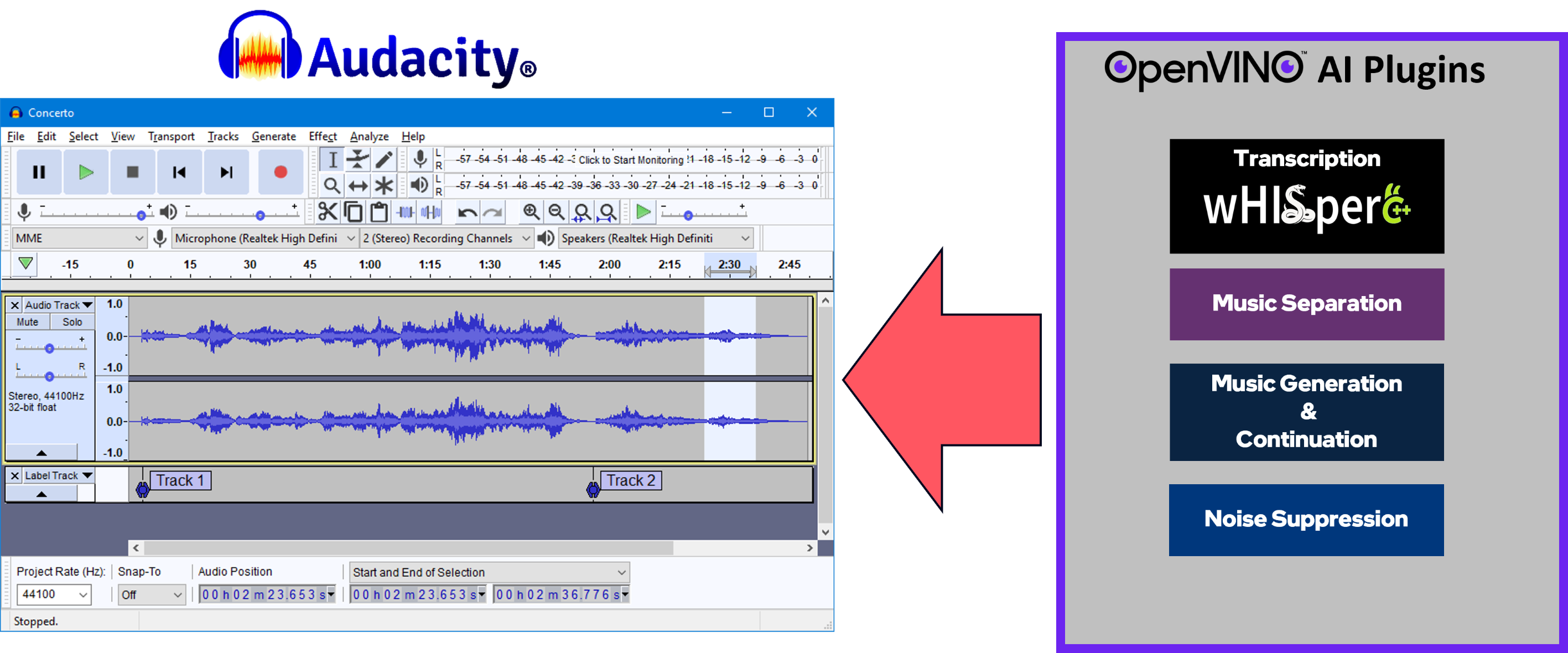

Um conjunto de efeitos, geradores e analisadores habilitados para IA para Audacity®. Esses recursos de IA são executados 100% localmente no seu PC? - não é necessária conexão com a internet! OpenVINO™ é usado para executar modelos de IA em aceleradores suportados encontrados no sistema do usuário, como CPU, GPU e NPU.

Separação de Música – Separe uma faixa mono ou estéreo em hastes individuais – Bateria, Baixo, Vocais e Outros Instrumentos.

Supressão de ruído – Remove o ruído de fundo de uma amostra de áudio.

Geração e continuação de música - Usa MusicGen LLM para gerar trechos de música ou para gerar uma continuação de um trecho de música existente.

Transcrição de sussurro – Usa Whisper.cpp para gerar uma faixa de rótulo contendo a transcrição ou tradução para uma determinada seleção de áudio falado ou vocal.

Clique aqui para encontrar pacotes de instalação e instruções para a versão mais recente do Windows.

Instruções de compilação do Windows

Instruções de construção do Linux

Convidamos você a enviar um problema aqui para

Questões

Relatórios de bugs

Solicitações de recursos

Feedback de qualquer tipo – como podemos melhorar este projeto?

Suas contribuições são bem-vindas e valorizadas, não importa quão grandes ou pequenas. Sinta-se à vontade para enviar uma solicitação pull!

Equipe de desenvolvimento do Audacity® e Muse Group - Obrigado pelo seu apoio!

Audacity® GitHub – https://github.com/audacity/audacity

O analisador de transcrição e tradução Whisper usa Whisper.cpp (com backend OpenVINO™): https://github.com/ggerganov/whisper.cpp

Geração e continuação de música usam o modelo MusicGen, da Meta.

Atualmente temos suporte para MusicGen-Small e MusicGen-Small-Stereo

Os pipelines txt-to-music foram portados de python para C++, referenciando a lógica do projeto de transformadores Hugging Face: https://github.com/huggingface/transformers

O efeito Music Separation usa o modelo Demucs v4 da Meta (https://github.com/facebookresearch/demucs), que foi portado para funcionar com OpenVINO™

Supressão de ruído:

Transferiu os modelos e pipeline daqui: https://github.com/Rikorose/DeepFilterNet

Também usamos o fork/branch do @grazder (https://github.com/grazder/DeepFilterNet/tree/torchDF-changes) para entender melhor a implementação do Rust e, portanto, também baseamos algumas de nossas implementações C++ em torch_df_offline.py encontrado aqui.

Citações:

@inproceedings{schroeter2022deepfilternet2,title = {{DeepFilterNet2}: Rumo ao aprimoramento de fala em tempo real em dispositivos incorporados para áudio de banda completa},author = {Schröter, Hendrik e Escalante-B., Alberto N. e Rosenkranz, Tobias e Maier, Andreas},booktitle={17º Workshop Internacional sobre Melhoria de Sinal Acústico (IWAENC 2022)}, ano = {2022},

} @inproceedings{schroeter2023deepfilternet3,title = {{DeepFilterNet}: Aprimoramento de fala em tempo real perceptualmente motivado},author = {Schröter, Hendrik e Rosenkranz, Tobias e Escalante-B., Alberto N. e Maier, Andreas},booktitle={ INTERSPEECH}, ano = {2023},

}noise-suppression-denseunet-ll: do Open Model Zoo do OpenVINO™: https://github.com/openvinotoolkit/open_model_zoo

DeepFilterNet2 e DeepFilterNet3:

OpenVINO™ Notebooks – Aprendemos muito com este incrível conjunto de notebooks python e ainda o usamos para aprender as práticas mais recentes/melhores para implementar pipelines de IA usando OpenVINO™!