Obtenha ajuda - Perguntas frequentes Discussões Site de documentação do Discord

Roteiro de modelos de início rápido? Demonstração? Explorador? Exemplos

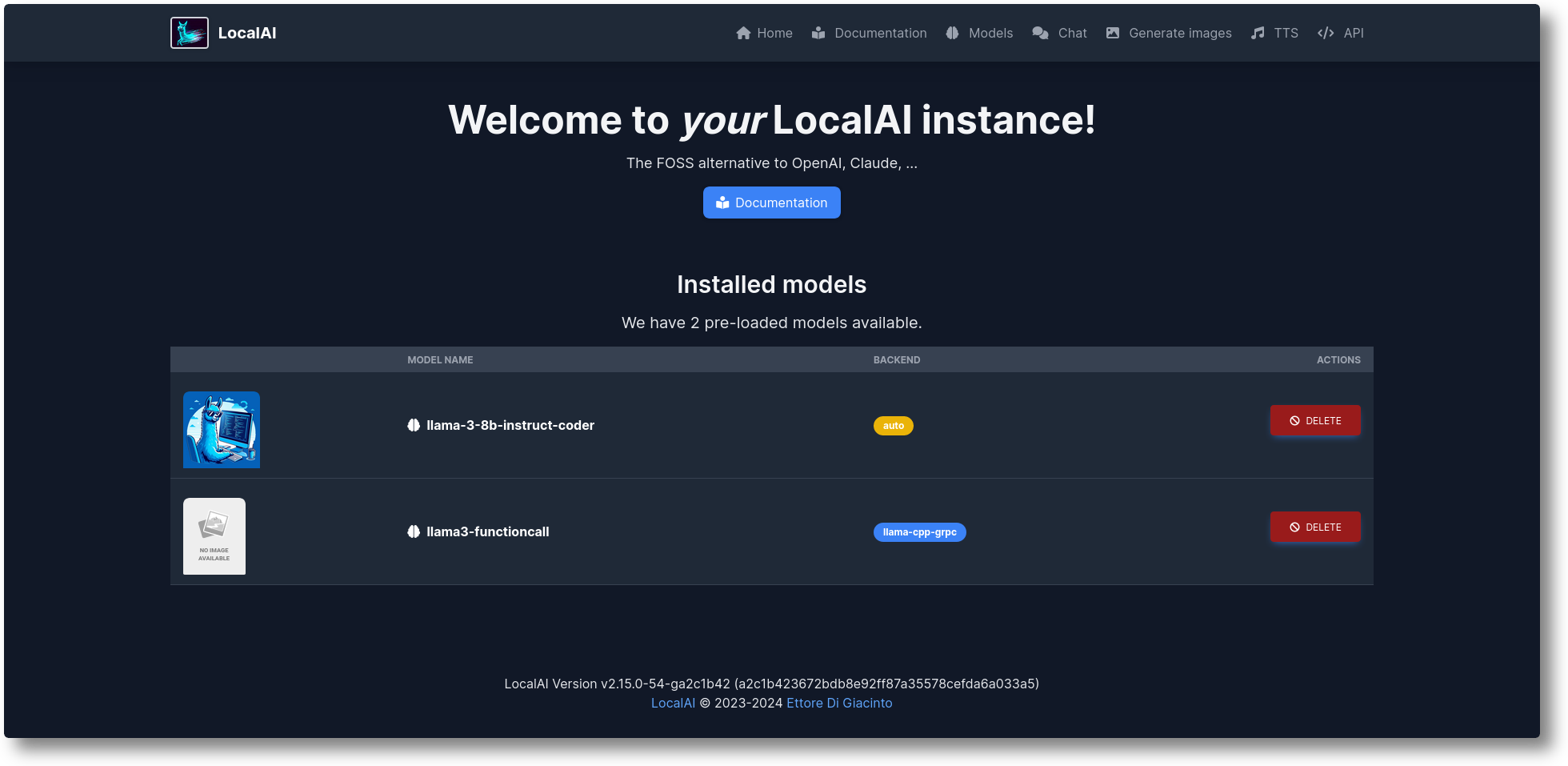

LocalAI é a alternativa gratuita e de código aberto OpenAI. LocalAI atua como uma API REST de substituição que é compatível com as especificações da API OpenAI (Elevenlabs, Anthropic...) para inferência de IA local. Ele permite que você execute LLMs, gere imagens, áudio (e não apenas) localmente ou no local com hardware de consumo, suportando várias famílias de modelos. Não requer GPU. É criado e mantido por Ettore Di Giacinto.

Execute o script do instalador:

curl https://localai.io/install.sh | eh

Ou execute com o docker:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# Imagens alternativas:# - se você tiver uma GPU Nvidia:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - sem modelos pré-configurados# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - sem modelos pré-configurados para GPUs Nvidia# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-gpu-nvidia -cuda-12

Para carregar modelos:

# Na galeria de modelos (veja os modelos disponíveis com `local-ai models list`, na WebUI na guia de modelos ou visitando https://models.localai.io)local-ai execute llama-3.2-1b-instruct: q4_k_m# Inicie LocalAI com o modelo phi-2 diretamente de huggingfacelocal-ai execute huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# Instale e execute um modelo de o registro Ollama OCIlocal-ai execute ollama://gemma:2b# Execute um modelo a partir de um arquivo de configuraçãolocal-ai execute https://gist.githubusercontent.com/.../phi-2.yaml# Instale e execute um modelo de um registro OCI padrão (por exemplo, Docker Hub)local-ai execute oci://localai/phi-2:latest

Começando

Outubro de 2024: exemplos movidos para exemplos LocalAI

Agosto de 2024: ? FLUX-1, Explorador P2P

Julho de 2024: ? Painel P2P, modo federado LocalAI e AI Swarms: #2723

Junho de 2024: ? Você pode navegar agora na galeria de modelos sem LocalAI! Confira https://models.localai.io

Junho de 2024: Suporte para modelos de registros OCI: #2628

Maio de 2024: P2P descentralizado llama.cpp: #2343 (peer2peer llama.cpp!) Documentos https://localai.io/features/distribute/

Maio de 2024: Openvoice: #2334

Maio de 2024: ? Chamadas de função sem gramática e modo misto: #2328

Maio de 2024: Inferência distribuída: #2324

Maio de 2024: Chat, TTS e geração de imagens na WebUI: #2222

Abril de 2024: API Reclassificador: #2121

Itens do roteiro: lista de problemas

Multimodal com vLLM e compreensão de vídeo: #3729

API em tempo real #3714

Pools comunitários distribuídos e globais P2P: #3113

Melhorias na WebUI: #2156

Back-ends v2: #1126

Melhorando a UX v2: #1373

API assistente: #1273

Ponto final de moderação: #999

Vulcano: #1647

API antrópica: #1808

Se você quiser ajudar e contribuir, questões à sua disposição: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

Geração de texto com GPTs ( llama.cpp , gpt4all.cpp , ... e mais)

Texto para áudio

Áudio para texto (transcrição de áudio com whisper.cpp )

Geração de imagem com difusão estável

API de ferramentas semelhantes ao OpenAI

Geração de embeddings para bancos de dados vetoriais

Gramáticas restritas

Baixe modelos diretamente do Huggingface

API de visão

API de reclassificação

Inferência P2P

WebUI integrada!

Confira a seção Primeiros passos em nossa documentação.

Crie e implante contêineres personalizados:

https://github.com/sozercan/aikit

UIs da Web:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (um projeto de bate-papo interativo que aproveita LLMs LocalAI para rápida compreensão e navegação do repositório de código GitHub) https://github.com/reid41/QA-Pilot

Galerias de modelos

https://github.com/go-skynet/model-gallery

Outro:

Gráfico do Helm https://github.com/go-skynet/helm-charts

Extensão VSCode https://github.com/badgooooor/localai-vscode-plugin

Utilitário de terminal https://github.com/djcopley/ShellOracle

Assistente inteligente local https://github.com/mudler/LocalAGI

Assistente doméstico https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

Bot Discord https://github.com/mudler/LocalAGI/tree/main/examples/discord

Bot do Slack https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (Interaja com LLM usando modelos LocalAI por meio de scripts shell puros em seu sistema Linux ou MacOS) https://github.com/reid41/shell-pilot

Bot de telegrama https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

Ações do Github: https://github.com/marketplace/actions/start-localai

Exemplos: https://github.com/mudler/LocalAI/tree/master/examples/

Guia de ajuste fino do LLM

Como construir localmente

Como instalar no Kubernetes

Projetos integrando LocalAI

Seção de instruções (com curadoria de nossa comunidade)

Execute o código do Visual Studio com LocalAI (SUSE)

Execute LocalAI no Jetson Nano Devkit

Execute LocalAI no AWS EKS com Pulumi

Execute LocalAI na AWS

Crie um slackbot para equipes e projetos OSS que respondam à documentação

LocalAI encontra k8sgpt

Resposta a perguntas em documentos localmente com LangChain, LocalAI, Chroma e GPT4All

Tutorial para usar k8sgpt com LocalAI

Se você utilizar este repositório, dados em um projeto downstream, considere citá-lo com:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},Você acha o LocalAI útil?

Apoie o projeto tornando-se um apoiador ou patrocinador. Seu logotipo aparecerá aqui com um link para seu site.

Um enorme obrigado aos nossos generosos patrocinadores que apoiam este projeto cobrindo as despesas do CI e à nossa lista de patrocinadores:

LocalAI é um projeto comunitário criado por Ettore Di Giacinto.

MIT - Autor Ettore Di Giacinto [email protected]

LocalAI não poderia ter sido construído sem a ajuda de um excelente software já disponível na comunidade. Obrigado!

lhama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go para as ideias iniciais

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

Este é um projeto comunitário, um agradecimento especial aos nossos colaboradores! ?