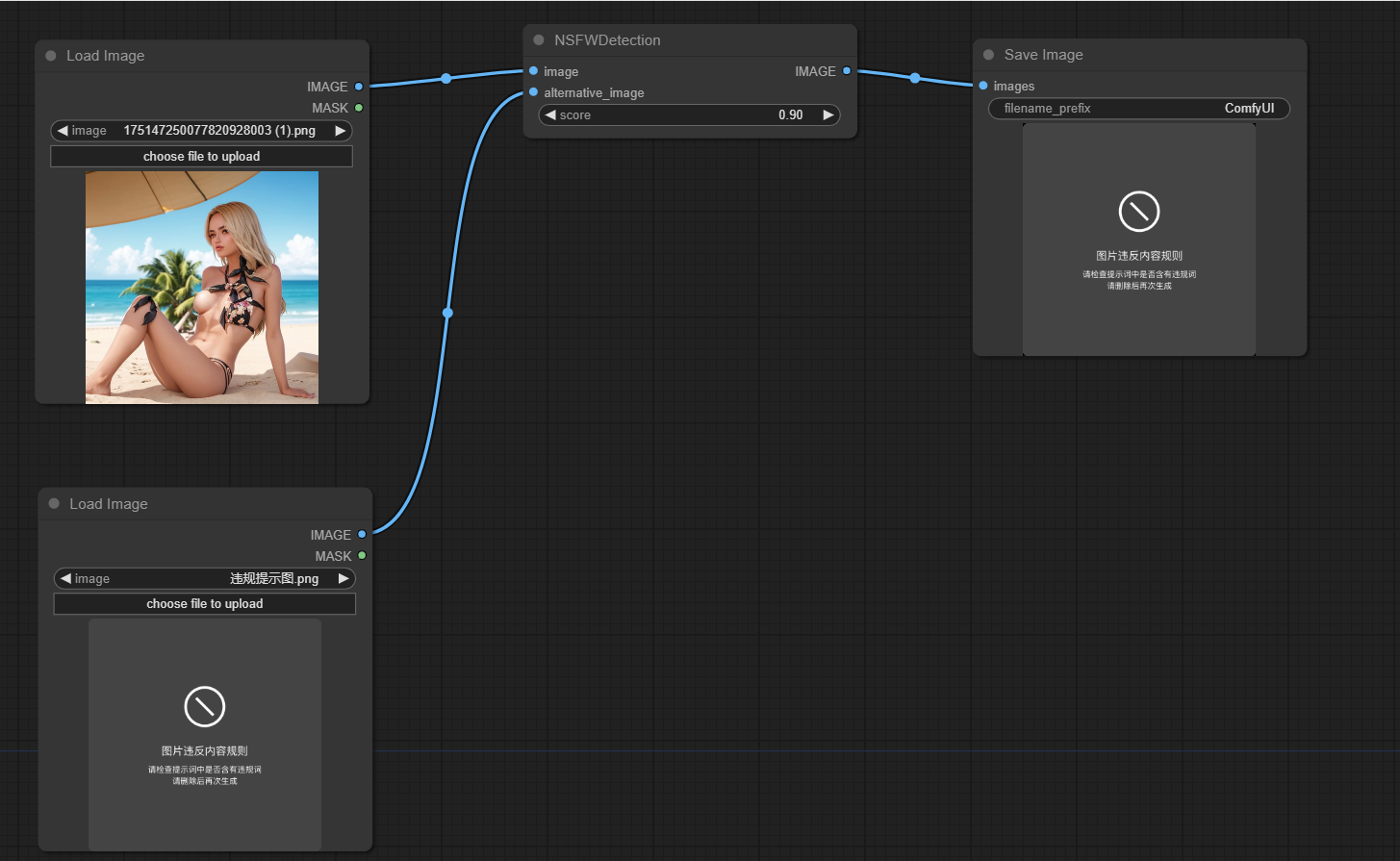

Este projeto foi projetado para detectar se as imagens geradas pela Comfyui não são seguras para o trabalho (NSFW). Ele usa um modelo de aprendizado de máquina para classificar as imagens como seguro ou não seguro para o trabalho. Se uma imagem for classificada como NSFW, uma imagem alternativa será retornada.

Clone este repos

Execute o PIP Install -R requisitos.txt

A principal funcionalidade do projeto é encapsulada na classe NSFWDetection no arquivo node.py Esta classe possui um método run que leva três parâmetros:

image : a imagem a ser classificada.score : A pontuação limite para classificar uma imagem como NSFW.alternative_image : a imagem a ser retornada se a imagem de entrada for classificada como NSFW.

https://github.com/trumanwong/comfyui-nfw-detection/blob/main/workflow.json

Contribuições são bem -vindas. Envie uma solicitação de tração se tiver alguma melhoria ou correção de bugs.

Este projeto está licenciado nos termos da licença do MIT.