Gere jogos e programas usando agentes OpenAi. Construído sobre o Microsoft Autogen.

️ Trabalho em andamento

O código atual funciona, mas:

- Existem, e haverá mudanças de quebra:

- Sempre verifique se o seu arquivo escondido

.env.jsonccorresponde à última estruturaenv.sample.jsonc.- Sempre atualize suas dependências via

poetry install.- Muita coisa precisa ser otimizada para reduzir drasticamente o uso de tokens: armazenamento em cache, etapas a passo, divisão de conversas, melhores avisos.

- O código precisa de alguma limpeza.

- A Microsoft Autogen ainda está no estágio inicial e contém alguns bugs.

- Muitas coisas codificadas podem ser personalizáveis por meio de arquivos de configuração.

- Vou me concentrar apenas em algumas linguagens de programação no início.

Existem alguns projetos incríveis fazendo coisas semelhantes, mas espero encontrar uma maneira de resolver a geração de programas ambiciosos.

Você precisa de uma chave de API do OpenAI ou uma chave de API do Azure Openai.

Não confie no GPT-3.5 , seja turbo ou padrão, para mais do que apenas programas de "amostra". Se você está buscando aplicativos mais complexos, GPT-4 é uma obrigação, de preferência até GPT-4-32k .

O uso da API do OpenAI pode esgotar rapidamente seu limite de token. Para projetos mais extensos, a API do Azure Openai é recomendada.

Esteja atento aos custos se tiver objetivos ambiciosos! Sempre monitore o uso de tokens e o que seus agentes estão fazendo. Embora a IA possa ser uma ferramenta poderosa, ainda não é necessariamente mais barata do que contratar desenvolvedores reais -?

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc Edite seu env.json para adicionar suas chaves da API e personalizar sua instalação.

Apenas:

make run Os OADs gerarão automaticamente o código -fonte do programa no diretório ./project .

Você pode limpar isso via:

make cleanIMPORTANTE: As funções não funcionarão.

Pelo que testei, o Autogen parece funcionar com qualquer LLM de código aberto suportado pela interface da web de geração de texto.

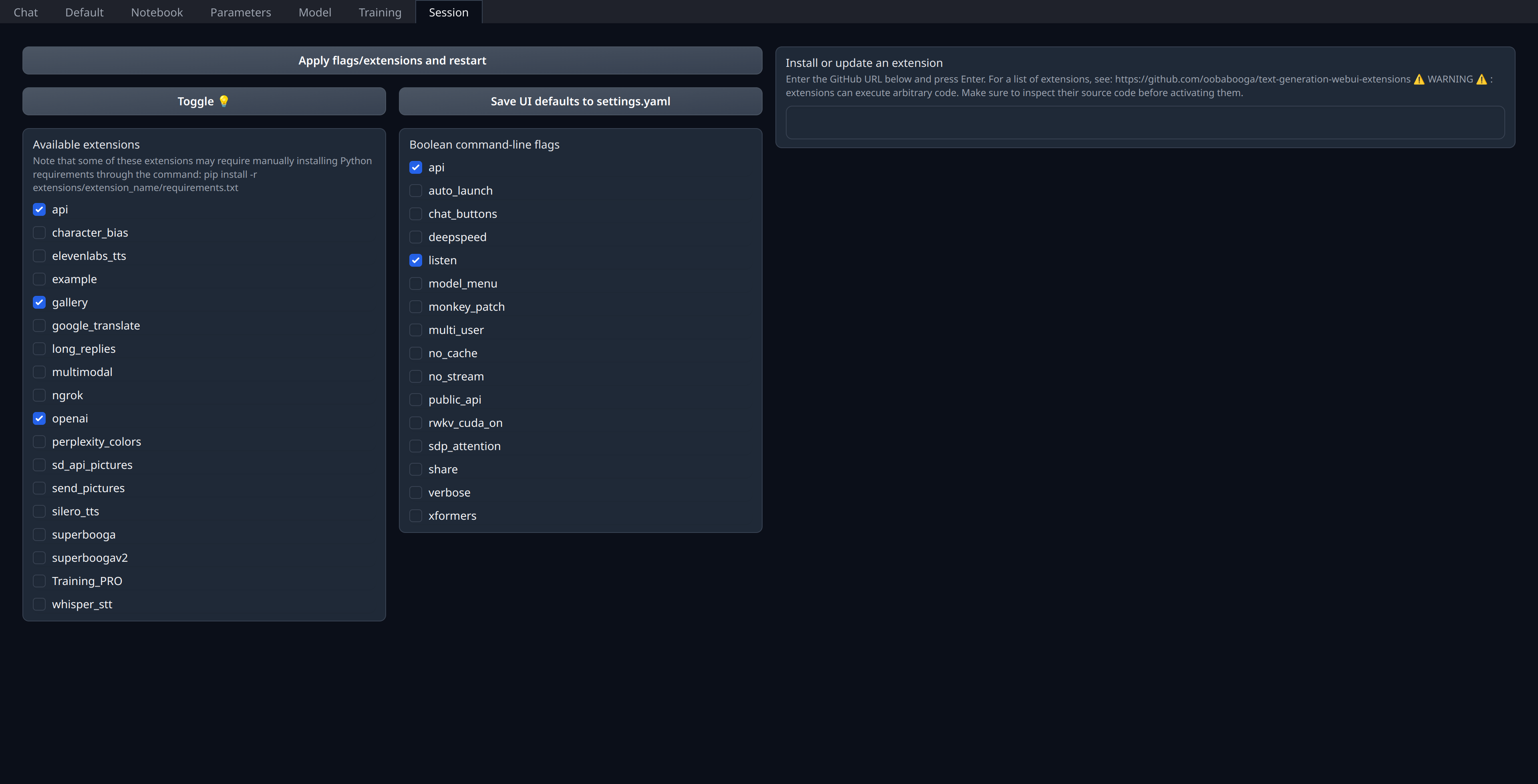

Você só precisa ativar a extensão openai na "sessão" da interface do usuário da web:

Certifique-se de ter sua porta 5001 aberta ou Binded se for um servidor remoto, pois é aqui que a API do tipo OpenAI será exposta.

I personally deploy my current models on RunPod (not affiliated) and use thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest image even though I think it seems a bit outdated regarding llama.cpp & co.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,