Присоединяйтесь к нашей группе пользователей WeChat или NPU.

[ Английский | 中文]

Точная настройка большой языковой модели может быть простой, как...

Выберите свой путь:

Colab : https://colab.research.google.com/drive/1eRTPn37ltBbYsISy9Aw2NuI2Aq5CQrD9?usp=sharing

PAI-DSW : Пример Llama3 | Пример Qwen2-VL

Локальный компьютер : см. использование.

Документация (НЗП) : https://llamafactory.readthedocs.io/zh-cn/latest/

Недавняя деятельность:

18.10.2024–30.11.2024 : Создайте личного бота-гида с помощью PAI+LLaMA Factory. [веб-сайт]

Примечание

За исключением приведенных выше ссылок, все остальные веб-сайты являются неавторизованными сторонними веб-сайтами. Пожалуйста, используйте их осторожно.

Функции

Контрольный показатель

Журнал изменений

Поддерживаемые модели

Поддерживаемые подходы к обучению

Предоставленные наборы данных

Требование

Начиная

Проекты с использованием LLaMA Factory

Лицензия

Цитирование

Благодарность

Различные модели : LLaMA, LLaVA, Mistral, Mixtral-MoE, Qwen, Qwen2-VL, Yi, Gemma, Baichuan, ChatGLM, Phi и т. д.

Интегрированные методы : (непрерывное) предварительное обучение, (мультимодальное) контролируемая точная настройка, моделирование вознаграждения, PPO, DPO, KTO, ORPO и т. д.

Масштабируемые ресурсы : 16-битная полная настройка, настройка с фиксацией, LoRA и 2/3/4/5/6/8-битная QLoRA через AQLM/AWQ/GPTQ/LLM.int8/HQQ/EETQ.

Расширенные алгоритмы : GaLore, BAdam, Adam-mini, DoRA, LongLoRA, LLaMA Pro, Mixture-of-Depths, LoRA+, LoftQ, PiSSA и настройка агента.

Практические приемы : FlashAttention-2, Unsloth, Liger Kernel, масштабирование RoPE, NEFTune и rsLoRA.

Мониторы экспериментов : LlamaBoard, TensorBoard, Wandb, MLflow и т. д.

Более быстрый вывод : API в стиле OpenAI, пользовательский интерфейс Gradio и CLI с рабочим элементом vLLM.

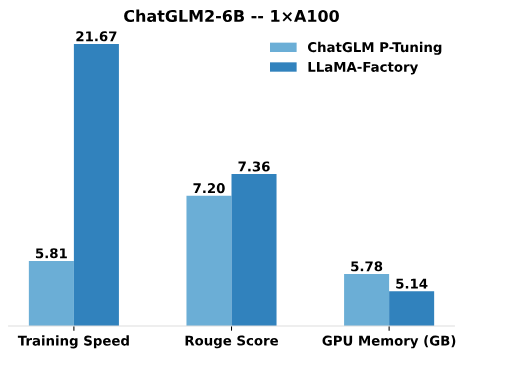

По сравнению с P-Tuning от ChatGLM, настройка LoRA от LLaMA Factory обеспечивает до 3,7 раз более высокую скорость обучения и лучшую оценку Rouge в задаче создания рекламного текста. Используя технику 4-битного квантования, QLoRA от LLaMA Factory еще больше повышает эффективность памяти графического процессора.

Скорость обучения : количество обучающих выборок, обрабатываемых в секунду во время обучения. (bs=4, Cutoff_len=1024)

Оценка Rouge : оценка Rouge-2 в наборе разработки задачи создания рекламного текста. (bs=4, Cutoff_len=1024)

Память графического процессора : пиковое использование памяти графического процессора при 4-битном квантовании. (bs=1, Cutoff_len=1024)

Мы принимаем pre_seq_len=128 для P-Tuning ChatGLM и lora_rank=32 для настройки LoRA LLaMA Factory.

[24.10.09] Мы поддержали загрузку предварительно обученных моделей и наборов данных из Modelers Hub . См. этот учебник для использования.

[24.09.19] Поддерживаем тонкую настройку моделей Qwen2.5 .

[24.08.30] Поддерживаем тонкую настройку моделей Qwen2-VL . Спасибо пиару @simonJJJ.

[24.08.27] Мы поддерживаем Liger Kernel . Попробуйте enable_liger_kernel: true для эффективного обучения.

[24.08.09] Поддерживаем оптимизатор Adam-mini . Посмотрите примеры использования. Спасибо пиару @relic-yuexi.

[24/07/04] Мы поддерживаем обучение без загрязнения. Используйте neat_packing: true , чтобы активировать его. Спасибо @chuan298 за пиар.

[24.06.16] Мы поддерживаем алгоритм PiSSA . Посмотрите примеры использования.

[24.06.07] Мы поддержали тонкую настройку моделей Qwen2 и GLM-4 .

[24.05.26] Мы поддержали алгоритм SimPO для обучения предпочтениям. Посмотрите примеры использования.

[24.05.20] Поддержали доработку моделей серии PaliGemma . Обратите внимание, что модели PaliGemma являются предварительно обученными моделями, вам необходимо настроить их с помощью шаблона paligemma для завершения чата.

[24.05.18] Мы поддержали алгоритм KTO для обучения предпочтениям. Посмотрите примеры использования.

[24.05.14] Мы поддержали обучение и вывод на устройствах Ascend NPU. Подробности смотрите в разделе установки.

[24.04.26] Поддержана тонкая настройка мультимодальных LLM LLaVA-1.5 . Посмотрите примеры использования.

[24.04.22] Мы предоставили ноутбук Colab для доводки модели Llama-3 на бесплатном графическом процессоре T4. Две модели на основе Llama-3, настроенные с помощью LLaMA Factory, доступны на Hugging Face. Подробности можно найти в Llama3-8B-Chinese-Chat и Llama3-Chinese.

[24.04.21] Мы поддержали Mixture-of-Depths в соответствии с реализацией AstraMindAI. Посмотрите примеры использования.

[24.04.16] Мы поддержали оптимизатор BAdam . Посмотрите примеры использования.

[24.04.16] Мы поддержали обучение длинных последовательностей unsloth (Llama-2-7B-56k в пределах 24 ГБ). Он достигает 117% скорости и 50% памяти по сравнению с FlashAttention-2. Дополнительные тесты можно найти на этой странице.

[24.03.31] Мы поддержали ОРПО . Посмотрите примеры использования.

[24.03.21] Наша статья «LlamaFactory: унифицированная эффективная точная настройка более 100 языковых моделей» доступна на arXiv!

[24.03.20] Мы поддержали FSDP+QLoRA , который оптимизирует модель 70B на 2 графических процессорах по 24 ГБ. Посмотрите примеры использования.

[24.03.13] Мы поддержали LoRA+ . Посмотрите примеры использования.

[24.03.07] Мы поддержали оптимизатор GaLore . Посмотрите примеры использования.

[24.03.07] Мы интегрировали vLLM для более быстрого и одновременного вывода. Попробуйте infer_backend: vllm , чтобы получить скорость вывода 270% .

[24.02.28] Мы поддержали LoRA с разложением по весу ( DoRA ). Попробуйте use_dora: true , чтобы активировать обучение DoRA.

[24.02.15] Мы поддержали расширение блока, предложенное LLaMA Pro. Посмотрите примеры использования.

[24.02.05] В LLaMA-Factory поддерживаются модели серии Qwen1.5 (бета-версия Qwen2). Подробности можно найти в этом сообщении в блоге.

[24.01.18] Мы поддержали настройку агента для большинства моделей, оснастив модель возможностями использования инструментов путем тонкой настройки с помощью dataset: glaive_toolcall_en .

[23.12.23] Мы поддержали реализацию unsloth для улучшения настройки LoRA для моделей LLaMA, Mistral и Yi. Попробуйте использовать аргумент use_unsloth: true , чтобы активировать патч unsloth. В нашем тесте он достигает скорости 170% . Подробности можно узнать на этой странице.

[23.12.12] Мы поддержали тонкую настройку последней модели MoE Mixtral 8x7B в нашем фреймворке. См. требования к оборудованию здесь.

[23.12.01] Мы поддержали загрузку предварительно обученных моделей и наборов данных из ModelScope Hub . См. этот учебник для использования.

[23.10.21] Мы поддержали трюк NEFTune для тонкой настройки. Попробуйте аргумент neftune_noise_alpha: 5 для активации NEFTune.

[23.09.27] Мы поддержали shift_attn: true чтобы включить короткое внимание.

[23.09.23] Мы интегрировали тесты MMLU, C-Eval и CMMLU в этот репозиторий. Посмотрите примеры использования.

[23.09.10] Мы поддержали FlashAttention-2 . Используйте аргумент flash_attn: fa2 чтобы включить FlashAttention-2, если вы используете графические процессоры RTX4090, A100 или H100.

[23.08.12] Мы поддержали масштабирование RoPE для увеличения длины контекста моделей LLaMA. Попробуйте rope_scaling: linear аргумент при обучении и rope_scaling: dynamic аргумент при выводе, чтобы экстраполировать вложения позиции.

[23.08.11] Мы поддержали обучение DPO для моделей, настроенных с помощью инструкций. Посмотрите примеры использования.

[23.07.31] Мы поддержали потоковую передачу набора данных . Попробуйте streaming: true и max_steps: 10000 аргументов, чтобы загрузить набор данных в потоковом режиме.

[23.07.29] На Hugging Face мы выпустили две настроенные по инструкции модели 13B. Подробности см. в репозиториях обнимающих лиц (LLaMA-2 / Baichuan).

[23.07.18] Мы разработали универсальный веб-интерфейс для обучения, оценки и вывода. Попробуйте train_web.py для точной настройки моделей в вашем веб-браузере. Благодарим @KanadeSiina и @codemayq за их усилия в разработке.

[23.07.09] Мы выпустили FastEdit⚡ ?, простой в использовании пакет для эффективного редактирования фактических знаний больших языковых моделей. Пожалуйста, следуйте FastEdit, если вам интересно.

[23.06.29] Мы предоставили воспроизводимый пример обучения модели чата с использованием наборов данных, следующих инструкциям, подробности см. в Baichuan-7B-sft.

[23.06.22] Мы привели демо-API в соответствие с форматом OpenAI, благодаря чему вы можете вставлять доработанную модель в произвольные приложения на базе ChatGPT .

[23.06.03] Мы поддержали квантовое обучение и логический вывод (также известный как QLoRA ). Посмотрите примеры использования.

| Модель | Размер модели | Шаблон |

|---|---|---|

| Байчуань 2 | 7Б/13Б | Байчуань2 |

| БЛУМ/БЛУМZ | 560М/1,1Б/1,7Б/3Б/7,1Б/176Б | - |

| ЧатGLM3 | 6Б | чатглм3 |

| Команда Р | 35Б/104Б | согласовываться |

| DeepSeek (Кодекс/МО) | 7Б/16Б/67Б/236Б | глубокий поиск |

| Сокол | 7Б/11Б/40Б/180Б | сокол |

| Джемма/Гемма 2/CodeGemma | 2Б/7Б/9Б/27Б | Джемма |

| ГЛМ-4 | 9Б | глм4 |

| СтажерLM2/СтажерLM2.5 | 7Б/20Б | стажер2 |

| Лама | 7Б/13Б/33Б/65Б | - |

| Лама 2 | 7Б/13Б/70Б | лама2 |

| Лама 3-3,2 | 1Б/3Б/8Б/70Б | лама3 |

| ЛЛаВА-1,5 | 7Б/13Б | лава |

| ЛЛаВА-NeXT | 7Б/8Б/13Б/34Б/72Б/110Б | llava_next |

| LLaVA-NeXT-Видео | 7Б/34Б | llava_next_video |

| Мини-цена за тысячу показов | 1Б/2Б/4Б | цена/мин/цена/мин3 |

| Мистраль/Мистраль | 7Б/8х7Б/8х22Б | мистраль |

| ОЛМо | 1Б/7Б | - |

| ПалиДжемма | 3Б | палигемма |

| Фи-1,5/Фи-2 | 1,3Б/2,7Б | - |

| Фи-3 | 4Б/7Б/14Б | фи |

| Пикстрал | 12Б | пиксельный |

| Квен (1-2,5) (Кодекс/Математика/МО) | 0,5Б/1,5Б/3Б/7Б/14Б/32Б/72Б/110Б | qwen |

| Квен2-ВЛ | 2Б/7Б/72Б | qwen2_vl |

| СтарКодер 2 | 3Б/7Б/15Б | - |

| XVERSE | 7Б/13Б/65Б | xverse |

| Йи/Йи-1,5 (Код) | 1,5Б/6Б/9Б/34Б | йи |

| Йи-ВЛ | 6Б/34Б | yi_vl |

| 2 юаня | 2Б/51Б/102Б | юань |

Примечание

Для «базовых» моделей аргумент template может быть выбран из default , alpaca , vicuna и т. д. Но обязательно используйте соответствующий шаблон для моделей «instruct/chat».

Не забудьте использовать один и тот же шаблон при обучении и выводе.

Полный список поддерживаемых нами моделей см. на сайте Constants.py.

Вы также можете добавить собственный шаблон чата в template.py.

| Подход | Полный тюнинг | Заморозка настройки | ЛоРА | QLoRA |

|---|---|---|---|---|

| Предварительное обучение | ✅ | ✅ | ✅ | ✅ |

| Контролируемая точная настройка | ✅ | ✅ | ✅ | ✅ |

| Моделирование вознаграждений | ✅ | ✅ | ✅ | ✅ |

| Обучение ППО | ✅ | ✅ | ✅ | ✅ |

| Обучение специалистов по защите данных | ✅ | ✅ | ✅ | ✅ |

| Обучение КТО | ✅ | ✅ | ✅ | ✅ |

| Обучение ОРПО | ✅ | ✅ | ✅ | ✅ |

| СимПО Обучение | ✅ | ✅ | ✅ | ✅ |

Кончик

Подробности реализации PPO можно найти в этом блоге.

Вики-демо (ru)

RefinedWeb (ru)

RedPajama V2 (ru)

Википедия (англ.)

Википедия (ж)

Пайл (en)

СкайПайл (ж)

FineWeb (ru)

FineWeb-Edu (en)

Стек (en)

СтарКодер (en)

Айдентика (эн&ж)

Стэнфордская Альпака (en)

Стэнфорд Альпака (ж)

Альпака GPT4 (англ.)

Вызов функций Glaive V2 (ru&zh)

ЛИМА (англ.)

Набор данных Гуанако (многоязычный)

БЕЛЬ 2М (ж)

БЕЛЬ 1М (ж)

БЕЛЬ 0.5М (ж)

БЕЛЬ Диалог 0.4М (ж)

BELLE Школа Математики 0.25М(ж)

Многооборотный чат BELLE 0.8M (ж)

УльтраЧат (ru)

OpenPlatypus (en)

CodeAlpaca 20k (ru)

Альпака CoT (многоязычный)

OpenOrca (en)

SlimOrca (en)

MathInstruct (ru)

Светлячок 1.1М (ж)

Вики-контроль качества (ru)

Веб-контроль качества (ж)

ВебНовел (ж)

Нектар (ru)

deepctrl (en&zh)

Генерация рекламы (ж)

ShareGPT Hyperfiltered (ru)

ПоделитьсяGPT4 (англ.)

УльтраЧат 200k (ru)

AgentInstruct (ru)

LMSYS Чат 1M (ru)

Evol Instruct V2 (ru)

Космопедия (ru)

СТЭМ (ж)

Руожиба (ж)

Нео-сфт(ж)

WebInstructSub (ru)

Magpie-Pro-300K-Filtered (ru)

Сорока-ультра-v0.1 (ru)

LLaVA смешанный (эн&ж)

Pokemon-gpt4o-captions (en&zh)

Открытый помощник (де)

Долли 15к (де)

Альпака GPT4 (де)

OpenSchnabeltier (де)

Эвол Инструкт (де)

Дельфин (де)

Буксум (де)

Айроборос (де)

Ультрачат (де)

ДПО смешанный (эн&ж)

Ультрафидбек (ru)

RLHF-V (en)

VLFeedback (ru)

Пары DPO Orca (en)

HH-RLHF (en)

Нектар (ru)

Орка ДПО (де)

КТО смешанный (en)

Некоторые наборы данных требуют подтверждения перед их использованием, поэтому мы рекомендуем войти в систему под своей учетной записью Hugging Face, используя эти команды.

pip install --upgrade humgingface_hub вход в Huggingface-Cli

| Обязательный | Минимум | Рекомендовать |

|---|---|---|

| питон | 3,8 | 3.11 |

| факел | 1.13.1 | 2.4.0 |

| трансформаторы | 4.41.2 | 4.43.4 |

| наборы данных | 2.16.0 | 2.20.0 |

| ускоряться | 0.30.1 | 0.32.0 |

| пефт | 0.11.1 | 0.12.0 |

| трл | 0.8.6 | 0.9.6 |

| Необязательный | Минимум | Рекомендовать |

|---|---|---|

| КУДА | 11,6 | 12.2 |

| глубокая скорость | 0.10.0 | 0.14.0 |

| биты и байты | 0.39.0 | 0.43.1 |

| вллм | 0.4.3 | 0.5.0 |

| вспышка | 2.3.0 | 2.6.3 |

* оцененный

| Метод | Биты | 7Б | 13Б | 30Б | 70Б | 110Б | 8х7Б | 8х22Б |

|---|---|---|---|---|---|---|---|---|

| Полный | AMP | 120 ГБ | 240 ГБ | 600 ГБ | 1200 ГБ | 2000 ГБ | 900 ГБ | 2400 ГБ |

| Полный | 16 | 60 ГБ | 120 ГБ | 300 ГБ | 600 ГБ | 900 ГБ | 400 ГБ | 1200 ГБ |

| Заморозить | 16 | 20 ГБ | 40 ГБ | 80 ГБ | 200 ГБ | 360 ГБ | 160 ГБ | 400 ГБ |

| ЛоРА/Галор/БАдам | 16 | 16 ГБ | 32 ГБ | 64 ГБ | 160 ГБ | 240 ГБ | 120 ГБ | 320 ГБ |

| QLoRA | 8 | 10 ГБ | 20 ГБ | 40 ГБ | 80 ГБ | 140 ГБ | 60 ГБ | 160 ГБ |

| QLoRA | 4 | 6 ГБ | 12 ГБ | 24 ГБ | 48 ГБ | 72 ГБ | 30 ГБ | 96 ГБ |

| QLoRA | 2 | 4ГБ | 8 ГБ | 16 ГБ | 24 ГБ | 48 ГБ | 18 ГБ | 48 ГБ |

Важный

Установка обязательна.

git clone --глубина 1 https://github.com/hiyouga/LLaMA-Factory.gitcd LLaMA-Factory pip install -e ".[факел,метрики]"

Доступны дополнительные зависимости: torch, torch-npu, metrics, deepspeed, liger-kernel, bitsandbytes, hqq, eetq, gptq, awq, aqlm, vllm, galore, badam, adam-mini, qwen, modelscope, openmind,quality

Кончик

Используйте pip install --no-deps -e . для разрешения конфликтов пакетов.

Если вы хотите включить квантованную LoRA (QLoRA) на платформе Windows, вам необходимо установить предварительно созданную версию библиотеки bitsandbytes , которая поддерживает CUDA 11.1–12.2. Выберите соответствующую версию выпуска в зависимости от вашей версии CUDA.

установка pip https://github.com/jllllll/bitsandbytes-windows-webui/releases/download/wheels/bitsandbytes-0.41.2.post2-py3-none-win_amd64.whl

Чтобы включить FlashAttention-2 на платформе Windows, вам необходимо установить предварительно скомпилированную библиотеку flash-attn , которая поддерживает CUDA 12.1–12.2. Загрузите соответствующую версию с флэш-внимания в соответствии с вашими требованиями.

Чтобы установить LLaMA Factory на устройствах Ascend NPU, укажите дополнительные зависимости: pip install -e ".[torch-npu,metrics]" . Дополнительно необходимо установить Ascend CANN Toolkit и Kernels . Пожалуйста, следуйте инструкциям по установке или используйте следующие команды:

# замените URL-адрес в соответствии с вашей версией CANN и устройством # установите CANN Toolkitwget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-toolkit_8 .0.RC1.alpha001_linux-"$(uname -я)".бежать bash Ascend-cann-toolkit_8.0.RC1.alpha001_linux-"$(uname -i)".run --install# install CANN Kernelswget https://ascend-repo.obs.cn-east-2.myhuaweicloud.com/Milan-ASL/Milan-ASL%20V100R001C17SPC701/Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run bash Ascend-cann-kernels-910b_8.0.RC1.alpha001_linux.run --install# set envvariablessource /usr/local/Ascend/ascend-toolkit/set_env.sh

| Требование | Минимум | Рекомендовать |

|---|---|---|

| КАНН | 8.0.RC1 | 8.0.RC1 |

| факел | 2.1.0 | 2.1.0 |

| факел-нпу | 2.1.0 | 2.1.0.post3 |

| глубокая скорость | 0.13.2 | 0.13.2 |

Не забудьте использовать ASCEND_RT_VISIBLE_DEVICES вместо CUDA_VISIBLE_DEVICES , чтобы указать используемое устройство.

Если вы не можете определить модель на устройствах NPU, попробуйте установить do_sample: false в конфигурациях.

Загрузите готовые образы Docker: 32 ГБ | 64 ГБ

Пожалуйста, обратитесь к data/README.md для проверки подробностей о формате файлов набора данных. Вы можете использовать наборы данных в хабе HuggingFace/ModelScope/Models или загрузить набор данных на локальный диск.

Примечание

Обновите data/dataset_info.json чтобы использовать ваш собственный набор данных.

Используйте следующие 3 команды для запуска точной настройки LoRA, вывода и слияния модели Llama3-8B-Instruct соответственно.

Примеры поездов llamafactory-cli/train_lora/llama3_lora_sft.yaml Примеры чата llamafactory-cli/inference/llama3_lora_sft.yaml Примеры экспорта llamafactory-cli/merge_lora/llama3_lora_sft.yaml

См. примеры/README.md для расширенного использования (включая распределенное обучение).

Кончик

Используйте llamafactory-cli help чтобы отобразить справочную информацию.

llamafactory-cli веб-интерфейс

Для пользователей CUDA:

компакт-диск докер/docker-cuda/ докер составить -d Docker Compose Exec llamafactory Bash

Для пользователей Ascend NPU:

компакт-диск докер/docker-npu/ докер составить -d Docker Compose Exec llamafactory Bash

Для пользователей AMD ROCm:

компакт-диск докер/docker-rocm/ докер составить -d Docker Compose Exec llamafactory Bash

Для пользователей CUDA:

docker build -f ./docker/docker-cuda/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory: последний запуск .docker -dit --gpus=all

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./данные:/приложение/данные

-v ./выход:/приложение/выход

-п 7860:7860

-p 8000:8000

--shm-размер 16G

--name llamafactory

ламафабрика: последний

docker exec -it llamafactory bashДля пользователей Ascend NPU:

# Выберите образ докера в вашей средеdocker build -f ./docker/docker-npu/Dockerfile

--build-arg INSTALL_DEEPSPEED=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory:latest .# Изменить `device` при запуске resourcesdocker -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./данные:/приложение/данные

-v ./выход:/приложение/выход

-v /usr/local/dcmi:/usr/local/dcmi

-v /usr/local/bin/npu-smi:/usr/local/bin/npu-smi

-v /usr/local/Ascend/driver:/usr/local/Ascend/driver

-v /etc/ascend_install.info:/etc/ascend_install.info

-п 7860:7860

-p 8000:8000

--устройство /dev/davinci0

--device /dev/davinci_manager

--устройство /dev/devmm_svm

--device /dev/hisi_hdc

--shm-размер 16G

--name llamafactory

ламафабрика: последний

docker exec -it llamafactory bashДля пользователей AMD ROCm:

docker build -f ./docker/docker-rocm/Dockerfile

--build-arg INSTALL_BNB=false

--build-arg INSTALL_VLLM=false

--build-arg INSTALL_DEEPSPEED=false

--build-arg INSTALL_FLASHATTN=false

--build-arg PIP_INDEX=https://pypi.org/simple

-t llamafactory: последний запуск .docker -dit

-v ./hf_cache:/root/.cache/huggingface

-v ./ms_cache:/root/.cache/modelscope

-v ./om_cache:/root/.cache/openmind

-v ./данные:/приложение/данные

-v ./выход:/приложение/выход

-v ./saves:/app/saves

-п 7860:7860

-p 8000:8000

--устройство /dev/kfd

--устройство /dev/dri

--shm-размер 16G

--name llamafactory

ламафабрика: последний

docker exec -it llamafactory bash hf_cache : использовать кеш Hugging Face на хост-компьютере. Переназначается, если кэш уже существует в другом каталоге.

ms_cache : аналогично кешу Hugging Face, но для пользователей ModelScope.

om_cache : аналогично кешу Hugging Face, но для пользователей-моделистов.

data : поместите наборы данных в этот каталог хост-компьютера, чтобы их можно было выбирать в графическом интерфейсе платы LLaMA.

output : установите каталог экспорта в это место, чтобы к объединенному результату можно было получить доступ непосредственно на хост-компьютере.

API_PORT=8000 примеров API llamafactory-cli/inference/llama3_vllm.yaml

Кончик

Посетите эту страницу для просмотра документа API.

Примеры: Понимание изображений | Вызов функции

Если у вас возникли проблемы с загрузкой моделей и наборов данных из Hugging Face, вы можете использовать ModelScope.

экспорт USE_MODELSCOPE_HUB=1 # `set USE_MODELSCOPE_HUB=1` для Windows

Обучите модель, указав идентификатор модели ModelScope Hub в качестве model_name_or_path . Полный список идентификаторов моделей можно найти на сайте ModelScope Hub, например, LLM-Research/Meta-Llama-3-8B-Instruct .

Вы также можете использовать Modelers Hub для загрузки моделей и наборов данных.

экспорт USE_OPENMIND_HUB=1 # `set USE_OPENMIND_HUB=1` для Windows

Обучите модель, указав идентификатор модели Центра моделирования в качестве model_name_or_path . Полный список идентификаторов моделей можно найти на сайте Modelers Hub, например, TeleAI/TeleChat-7B-pt .

Чтобы использовать веса и смещения для регистрации результатов экспериментов, вам необходимо добавить следующие аргументы в файлы yaml.

report_to: wandbrun_name: test_run # необязательно

Установите WANDB_API_KEY в качестве своего ключа при запуске учебных задач, чтобы войти в свою учетную запись W&B.

Если у вас есть проект, который необходимо включить, свяжитесь с ним по электронной почте или создайте запрос на включение.

Ван и др. ESRL: эффективное обучение с подкреплением на основе выборки для генерации последовательностей. 2023. [архив]

Ю и др. Открытые, закрытые или малоязыковые модели классификации текста? 2023. [архив]

Ван и др. UbiPhysio: поддержка ежедневного функционирования, фитнеса и реабилитации с помощью понимания действий и обратной связи на естественном языке. 2023. [архив]

Луцери и др. Использование больших языковых моделей для обнаружения кампаний влияния в социальных сетях. 2023. [архив]

Чжан и др. Облегчение галлюцинаций больших языковых моделей посредством индуцированных галлюцинаций. 2023. [архив]

Ван и др. Лучше знайте свои потребности: к структурированному пониманию требований маркетологов с помощью аналогового рассуждения, дополненного LLM. КДД 2024. [архив]

Ван и др. CANDLE: Итеративная концептуализация и создание экземпляров. Дистилляция больших языковых моделей для здравого смысла. ACL 2024. [архив]

Чой и др. FACT-GPT: дополнение проверки фактов посредством сопоставления претензий с LLM. 2024. [архив]

Чжан и др. AutoMathText: автономный выбор данных с помощью языковых моделей для математических текстов. 2024. [архив]

Люу и др. KnowTuning: точная настройка больших языковых моделей с учетом знаний. 2024. [архив]

Ян и др. LaCo: сокращение большой языковой модели посредством свертывания слоев. 2024. [архив]

Бхардвадж и др. Языковые модели — Гомер Симпсон! Перестройка безопасности точно настроенных языковых моделей посредством арифметики задач. 2024. [архив]

Ян и др. Улучшение генерации эмпатических ответов путем дополнения LLM мелкомасштабными эмпатическими моделями. 2024. [архив]

Йи и др. Генерация соответствует проверке: ускорение вывода больших языковых моделей с помощью интеллектуального параллельного декодирования с автокоррекцией. Результаты ACL 2024. [архив]

Цао и др. Разделяемое внимание по голове для больших языковых моделей. 2024. [архив]

Чжан и др. Расширение многоязычных возможностей больших языковых моделей посредством самодистилляции языков, богатых ресурсами. 2024. [архив]

Ким и др. Эффективное и действенное расширение словарного запаса в направлении многоязычных моделей большого языка. 2024. [архив]

Ю и др. KIEval: основанная на знаниях интерактивная система оценки для больших языковых моделей. ACL 2024. [архив]

Хуанг и др. Синтез данных на основе ключевых точек с его развитием математических рассуждений. 2024. [архив]

Дуан и др. Отрицание негативов: выравнивание без положительных человеческих образцов посредством оптимизации распределения различий. 2024. [архив]

Се и Швертфегер. Расширение возможностей робототехники с помощью больших языковых моделей: понимание карт osmAG с помощью LLM. 2024. [архив]

Ву и др. Большие языковые модели представляют собой параллельное многоязычное обучение. 2024. [архив]

Чжан и др. EDT: улучшение генерации больших языковых моделей с помощью динамической выборки температуры на основе энтропии. 2024. [архив]

Веллер и др. FollowIR: оценка и обучение моделей поиска информации следованию инструкциям. 2024. [архив]

Хунбин На. CBT-LLM: Модель большого китайского языка для ответов на вопросы о психическом здоровье на основе когнитивно-поведенческой терапии. КОЛИНГ 2024. [архив]

Зан и др. CodeS: естественный язык для репозитория кода с помощью многослойного эскиза. 2024. [архив]

Лю и др. Обширный самоконтраст позволяет выравнивать языковую модель без обратной связи. 2024. [архив]

Луо и др. BAdam: эффективный метод обучения полным параметрам памяти для больших языковых моделей. 2024. [архив]

Ду и др. Chinese Tiny LLM: предварительное обучение модели большого языка, ориентированной на китайский язык. 2024. [архив]

Ма и др. Эффективная квазиортогональная точная настройка параметров посредством вращения Гивенса. ICML 2024. [архив]

Лю и др. Динамическая генерация личностей с помощью больших языковых моделей. 2024. [архив]

Шан и др. Как далеко мы продвинулись в понимании упрощенного двоичного кода с использованием больших языковых моделей? 2024. [архив]

Хуанг и др. LLMTune: ускорение настройки базы данных с помощью больших языковых моделей. 2024. [архив]

Дэн и др. Text-Tuple-Table: к интеграции информации при генерации текста в таблицу посредством глобального извлечения кортежа. 2024. [архив]

Аджикгоз и др. Гиппократ: платформа с открытым исходным кодом для продвижения больших языковых моделей в здравоохранении. 2024. [архив]

Чжан и др. Малоязыковым моделям нужны сильные средства проверки для самостоятельной корректировки рассуждений. Результаты ACL 2024. [архив]

Чжоу и др. FREB-TQA: эталон детальной оценки устойчивости для ответов на табличные вопросы. NAACL 2024. [архив]

Сюй и др. Большие языковые модели для кибербезопасности: систематический обзор литературы. 2024. [архив]

Дамму и др. «Они некультурны»: раскрытие скрытого вреда и социальных угроз в беседах, проводимых LLM. 2024. [архив]

Йи и др. Структура перестройки безопасности посредством объединения моделей, ориентированных на подпространство, для больших языковых моделей. 2024. [архив]

Лу и др. SPO: Многомерное последовательное согласование предпочтений с неявным моделированием вознаграждения. 2024. [архив]

Чжан и др. Получение большего за счет меньшего: большие языковые модели способствуют спонтанному многоязычному обучению. 2024. [архив]

Чжан и др. TS-Align: платформа для совместной работы учителя и ученика для масштабируемой итеративной точной настройки больших языковых моделей. 2024. [архив]

Цзыхун Чен. Сегментация предложений и пунктуация предложений на основе XunziALLM. 2024. [бумага]

Гао и др. Лучшее из обоих миров: к честной и полезной модели большого языка. 2024. [архив]

Ван и Сун. МАРС: Сравнительный анализ способностей языковых моделей к метафизическому мышлению с помощью набора данных многозадачной оценки. 2024. [архив]

Ху и др. Вычислительные пределы адаптации низкого ранга (LoRA) для моделей на основе трансформаторов. 2024. [архив]

Ге и др. Редактирование знаний, зависящее от времени, посредством эффективной точной настройки. ACL 2024. [архив]

Тан и др. Экспертная оценка как многоходовой и длительный контекстный диалог с ролевым взаимодействием. 2024. [архив]

Сонг и др. Turbo Sparse: достижение производительности LLM SOTA с минимальными активируемыми параметрами. 2024. [архив]

Гу и др. RWKV-CLIP: Надежное средство обучения визуальному и языковому представлению. 2024. [архив]

Чен и др. Развитие моделей большого языка, дополненных инструментами: интеграция результатов ошибок в деревьях вывода. 2024. [архив]

Чжу и др. Являются ли большие языковые модели хорошими статистиками? 2024. [архив]

Ли и др. Познай неизвестное: чувствительный к неопределенности метод настройки инструкций LLM. 2024. [архив]

Дин и др. IntentionQA: тест для оценки способности языковых моделей в электронной коммерции понимать намерение покупки. 2024. [архив]

Он и др. COMMUNITY-CROSS-INSTRUCT: неконтролируемая генерация инструкций для согласования больших языковых моделей с онлайн-сообществами. 2024. [архив]

Лин и др. FVEL: интерактивная среда формальной проверки с большими языковыми моделями посредством доказательства теорем. 2024. [архив]

Трейтлейн и др. Соединяя точки: LLM могут выводить и вербализировать скрытую структуру на основе разрозненных обучающих данных. 2024. [архив]

Фэн и др. SS-Bench: эталон для создания и оценки социальных историй. 2024. [архив]

Фэн и др. Самостоятельная декомпиляция контекста с детальным улучшением выравнивания. 2024. [архив]

Лю и др. Большие языковые модели для измерения артериального давления без манжеты с помощью носимых биосигналов. 2024. [архив]

Айер и др. Изучение перевода с очень низкими ресурсами с магистрами права: задание Эдинбургского университета на конкурс AmericasNLP 2024 по переводу. AmericasNLP 2024. [бумага]

Ли и др. Калибровка LLM с оптимизацией предпочтений на деревьях мыслей для создания обоснования при подсчете баллов по научным вопросам. 2024. [архив]

Ян и др. Большая языковая модель финансовых знаний. 2024. [архив]

Лин и др. DogeRM: оснащение моделей вознаграждения знаниями предметной области посредством слияния моделей. 2024. [архив]

Бако и др. Оценка возможностей семантического профилирования LLM для высказываний на естественном языке при визуализации данных. 2024. [архив]

Хуанг и др. RoLoRA: точная настройка повернутых LLM без выбросов для эффективного квантования активации веса. 2024. [архив]

Цзян и др. LLM-сотрудничество в области автоматической научной журналистики для широкой аудитории. 2024. [архив]

Иноуе и др. Применена автоматическая настройка гиперпараметров LoRA. 2024. [бумага]

Ци и др. Исследование системы генерации информации о точках зрения тибетского туризма на основе LLM. 2024. [архив]

Сюй и др. Коррекция курса: настройка безопасности с использованием синтетических предпочтений. 2024. [архив]

Сан и др. LAMBDA: агент данных на основе большой модели. 2024. [архив]

Чжу и др. CollectiveSFT: Масштабирование больших языковых моделей для оценки китайской медицины с помощью коллективных инструкций в здравоохранении. 2024. [архив]

Ю и др. Исправление негативной предвзятости в больших языковых моделях посредством выравнивания показателей отрицательного внимания. 2024. [архив]

Се и др. Сила персонализированных наборов данных: развитие написания сочинений на китайском языке для начальной школы посредством целевой точной настройки модели. IALP 2024. [бумага]

Лю и др. Instruct-Code-Llama: улучшение возможностей языковой модели при генерации кода на уровне соревнований с помощью обратной связи онлайн-судьи. ICIC 2024. [бумага]

Ван и др. Кибернетические стражи: раскрытие влияния выбора данных о безопасности на безопасность модели при контролируемой точной настройке. ICIC 2024. [бумага]

Ся и др. Понимание производительности и оценка стоимости тонкой настройки LLM. 2024. [архив]

Цзэн и др. Воспринимайте, размышляйте и планируйте: разработка агента LLM для целенаправленной навигации по городу без инструкций. 2024. [архив]

Ся и др. Использование предварительно обученной языковой модели для точного прогнозирования ESG. ФинНЛП 2024. [бумага]

Лян и др. I-SHEP: Саморегулирование LLM с нуля через итеративную парадигму самосовершенствования. 2024. [архив]

StarWhisper : большая языковая модель для астрономии, основанная на ChatGLM2-6B и Qwen-14B.

DISC-LawLLM : Большая языковая модель, специализирующаяся на китайской правовой сфере, основанная на Baichuan-13B, способна извлекать и рассуждать на основе юридических знаний.

Sunsimiao : большая языковая модель, специализирующаяся на китайской медицине, основанная на Baichuan-7B и ChatGLM-6B.

CareGPT : серия крупных языковых моделей для китайской медицины на основе LLaMA2-7B и Baichuan-13B.

MachineMindset : серия больших языковых моделей MBTI Personality, способных дать любому LLM 16 различных типов личности на основе различных наборов данных и методов обучения.

Luminia-13B-v3 : большая языковая модель, специализирующаяся на создании метаданных для стабильного распространения. [демо]

Chinese-LLaVA-Med : мультимодальная модель большого языка, специализирующаяся на китайской медицине, на основе LLaVA-1.5-7B.

AutoRE : система извлечения отношений на уровне документа, основанная на больших языковых моделях.

NVIDIA RTX AI Toolkit : SDK для тонкой настройки LLM на ПК с Windows для NVIDIA RTX.

LazyLLM : простой и ленивый способ создания многоагентных приложений LLM, поддерживающий точную настройку модели с помощью LLaMA Factory.

RAG-Поиск : полный конвейер для точной настройки, вывода и дистилляции модели поиска RAG. [блог]

Этот репозиторий лицензируется по лицензии Apache-2.0.

Пожалуйста, следуйте лицензиям на модели, чтобы использовать соответствующие модели веса: Baichuan 2 / BLOOM / ChatGLM3 / Command R / DeepSeek / Falcon / Gemma / GLM-4 / InternLM2 / Llama / Llama 2 (LLaVA-1.5) / Llama 3 / MiniCPM / Mistral /Mixtral/Pixtral / ОЛМо / Фи-1.5/Фи-2 / Фи-3 / Qwen / StarCoder 2 / XVERSE / Йи / Йи-1.5 / Юань 2

Если данная работа окажется полезной, пожалуйста, укажите:

@inproceedings{zheng2024llamafactory, title={LlamaFactory: унифицированная эффективная точная настройка более чем 100 языковых моделей}, автор={Яовэй Чжэн и Ричонг Чжан и Цзюньхао Чжан и Яньхан Е и Чжэян Луо и Чжанчи Фэн и Юнцян Ма}, booktitle={ Материалы 62-го ежегодного собрания Ассоциации Компьютерная лингвистика (Том 3: Демонстрации системы)}, адрес={Бангкок, Таиланд}, издатель={Ассоциация компьютерной лингвистики}, год={2024}, url={http://arxiv.org/abs/2403.13372}}В этом репозитории используются PEFT, TRL, QLoRA и FastChat. Спасибо за их замечательные работы.