· Бумага · Контрольный показатель · Домашняя страница · Документ ·

✅ [25.07.2024] Visual PEFT Benchmark начинает выпуск набора данных, кода и т. д.

✅ [20.06.2024] Создана домашняя страница Visual PEFT Benchmark.

✅ [01.06.2024] Создано репозиторий Visual PEFT Benchmark.

Введение

Начиная

Структура кода

Быстрый старт

Результаты и контрольные точки

Сообщество и контакты

Цитирование

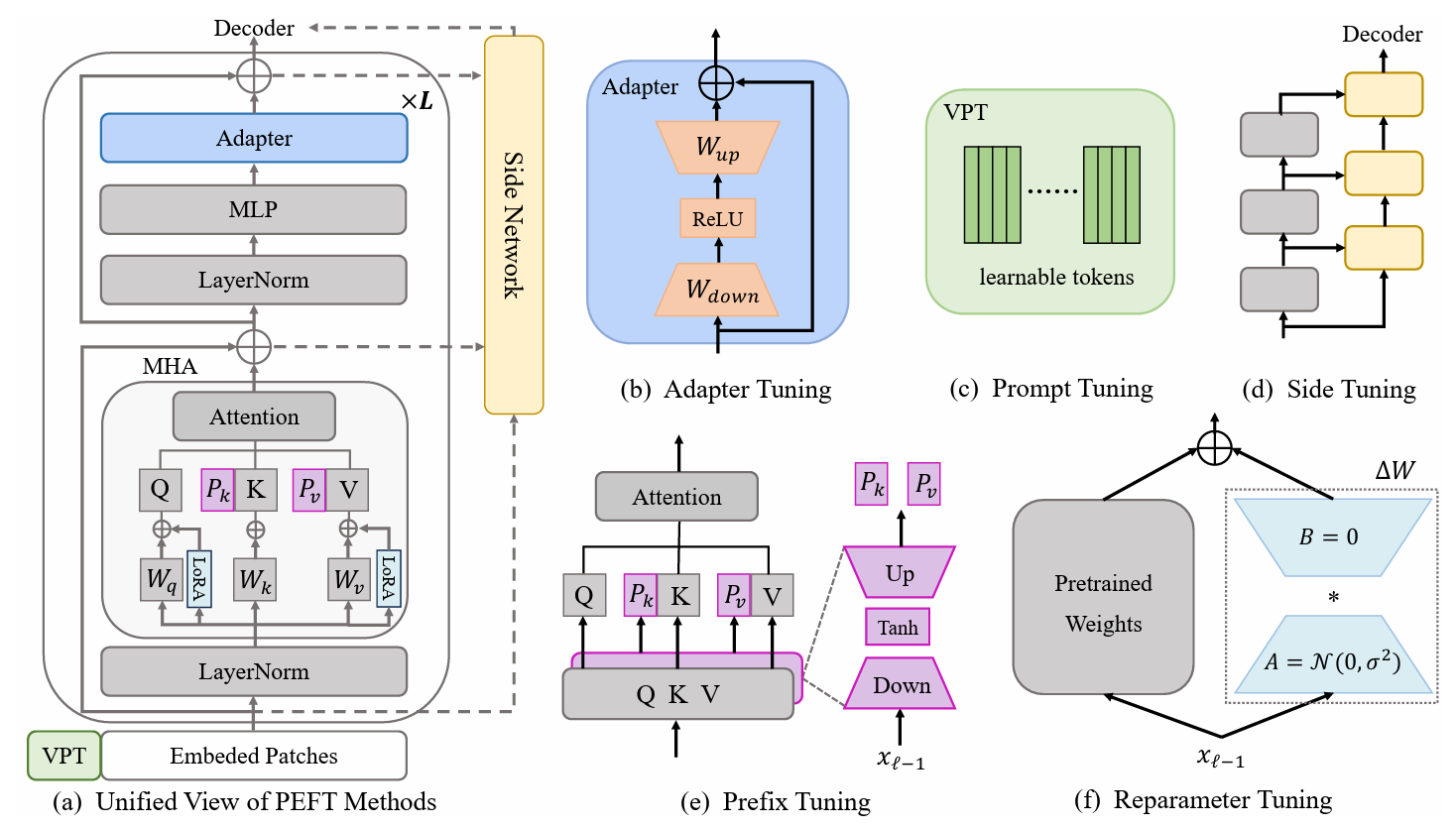

Методы обучения с эффективным переносом параметров (PETL) показывают многообещающие возможности адаптации предварительно обученной модели к различным последующим задачам при обучении лишь нескольких параметров. В области компьютерного зрения (CV) было предложено множество алгоритмов PETL, но их прямое использование или сравнение остается неудобным. Чтобы решить эту проблему, мы создаем единый визуальный тест PETL (V-PETL Bench) для области CV, выбирая 30 разнообразных, сложных и полных наборов данных из задач распознавания изображений, распознавания видеодействий и плотного прогнозирования . На основе этих наборов данных мы систематически оцениваем 25 доминирующих алгоритмов PETL и открываем исходный код модульной и расширяемой базы кода для объективной оценки этих алгоритмов.

Задачи мелкозернистой визуальной классификации (FGVC)

FGVC включает в себя 5 наборов данных мелкозернистой визуальной классификации. Наборы данных можно скачать по официальным ссылкам. Мы разделяем данные обучения, если общедоступный набор проверки недоступен. Разделенный набор данных можно найти здесь: Ссылка для скачивания.

КУБ200 2011 г.

НАПтицы

Оксфордские цветы

Стэнфордские собаки

Стэнфордские автомобили

Тест адаптации визуальных задач (VTAB)

VTAB включает 19 различных наборов данных визуальной классификации. Мы обработали весь набор данных, и данные можно скачать здесь: Ссылка для скачивания. Конкретные процедуры обработки и советы см. в разделе VTAB_SETUP.

Кинетика-400

Загрузите набор данных по ссылке для скачивания или ссылке для скачивания.

Предварительно обработайте набор данных, изменив размер короткого края видео до 320 пикселей . Вы можете обратиться к тесту данных MMAction2.

Создайте аннотации, необходимые для загрузчика данных («train.csv , val.csv и test.csv . Формат файла *.csv выглядит следующим образом:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

Что-то-что-то V2 (SSv2)

Загрузите набор данных по ссылке для скачивания.

Предварительно обработайте набор данных, изменив расширение видео с webm на .mp4 с исходной высотой 240 пикселей . Вы можете обратиться к тесту данных MMAction2.

Создайте аннотации, необходимые для загрузчика данных («train.csv , val.csv и test.csv . Формат файла *.csv выглядит следующим образом:

video_1.mp4 label_1 video_2.mp4 label_2 video_3.mp4 label_3 ... video_N.mp4 label_N

МС-КОКО

MS-COCO доступен по этой ссылке для скачивания.

АДЭ20К

Набор для обучения и проверки ADE20K можно загрузить по этой ссылке для скачивания. Мы также можем загрузить тестовый набор по ссылке для скачивания.

ПАСКАЛЬ ЛОС

Pascal VOC 2012 можно загрузить по ссылке для скачивания. Кроме того, в самых последних работах над набором данных Pascal VOC обычно используются дополнительные данные дополнения, которые можно найти по ссылке для скачивания.

Загрузите и поместите предварительно обученную модель ViT-B/16 в /path/to/pretrained_models .

mkdir pretrained_models wget https://storage.googleapis.com/vit_models/imagenet21k/ViT-B_16.npz

или вы можете скачать предварительно обученную модель Swin-B. Обратите внимание, что вам также необходимо переименовать загруженный файл Swin-B ckpt из swin_base_patch4_window7_224_22k.pth в Swin-B_16.pth .

mkdir pretrained_models wget https://github.com/SwinTransformer/storage/releases/download/v1.0.0/swin_base_patch4_window7_224_22k.pth mv swin_base_patch4_window7_224_22k.pth Swin_B_16.pth

Другой способ — загрузить предварительно обученные модели по ссылке ниже и поместить их в /path/to/pretrained_models .

| Предварительно обученная магистраль | Предварительно обученная цель | Предварительно обученный набор данных | Контрольно-пропускной пункт |

|---|---|---|---|

| ВИТ-Б/16 | Контролируемый | ImageNet-21K | Ссылка для скачивания |

| ВиТ-Л/16 | Контролируемый | ImageNet-21K | Ссылка для скачивания |

| ВиТ-Г/16 | Контролируемый | ImageNet-21K | Ссылка для скачивания |

| Свин-Б | Контролируемый | ImageNet-22K | Ссылка для скачивания |

| Свин-Л | Контролируемый | ImageNet-22K | Ссылка для скачивания |

| ВИТ-Б (ВидеоМАЭ) | Самоконтролируемый | Кинетика-400 | Ссылка для скачивания |

| Видео Свин-Б | Контролируемый | Кинетика-400 | Ссылка для скачивания |

ImageClassification/configs : обрабатывает параметры конфигурации для экспериментов.

ImageClassification/config/vtab/cifar100.yaml : основные настройки конфигурации для экспериментов и пояснения для каждого набора данных.

.....

ImageClassification/dataloader : загрузка и настройка входных наборов данных.

ImageClassification/dataloader/transforms : преобразования изображений.

ImageClassification/dataloader/loader : создает загрузчик данных для данного набора данных.

ImageClassification/models : обрабатывает магистральные арки и направляет различные протоколы точной настройки.

ImageClassification/models/vision_transformer_adapter.py : папка содержит те же магистрали в папке vit_backbones , указанной для адаптера.

ImageClassification/models/vision_transformer_sct.py : папка содержит те же магистрали, что и папка vit_backbones , указанная для SCT.

.....

ImageClassification/train : папка содержит папку с training file ,

ImageClassification/train/train_model_adapter.py : вызовите этот метод для обучения и оценки модели с указанным типом передачи, указанным для адаптера.

ImageClassification/train/train_model_sct.py : вызовите этот метод для обучения и оценки модели с указанным типом передачи, указанным для SCT.

.....

ImageClassification/scripts : папка содержит папку scripts file ,

ImageClassification/scripts/run_vit_adapter.sh : вы можете запустить метод адаптера для всех наборов данных одновременно.

ImageClassification/scripts/run_vit_sct.sh : вы можете запустить метод адаптера для всех наборов данных одновременно.

.....

ImageClassification/Visualize : инструменты визуализации.

ImageClassification/Visualize/AttentionMap.py : Визуализация карты внимания.

ImageClassification/Visualize/TSNE.py : визуализация T-SNE.

ImageClassification/utils : создание журнала, установка начального числа и т. д.

❗️Примечание❗️: Если вы хотите создать свой собственный алгоритм PETL, обратите внимание на «Классификация изображений/модели».

Это пример локальной настройки V-PETL Bench.

Чтобы создать локальную копию, выполните следующие простые шаги.

git clone https://github.com/synbol/Parameter-Efficient-Transfer-Learning-Benchmark.git

V-PETL Bench построен на pytorch, с torchvision, torchaudio, timm и т. д.

Чтобы установить необходимые пакеты, вы можете создать среду conda.

conda create --name v-petl-bench python=3.8

Активируйте среду conda.

Конда активирует v-petl-bench

Используйте pip для установки необходимых пакетов.

cd Параметр-Эффективный-Перенос-Обучения-Бенчмарк pip install -r требования.txt

Мы предоставляем специальную демонстрационную программу обучения и оценки на примере LoRA на VTAB Cifar100.

импортировать систему

sys.path.append("Параметр-эффективный-перенос-обучение-тест")

импортный фонарь

из утилит импорта ImageClassification

из ImageClassification.dataloader импортировать vtab

из ImageClassification.train import train# получить методы lora из timm.scheduler.cosine_lr import CosineLRScheduler

из ImageClassification.models импортируйте Vision_transformer_lora

import timm# путь для сохранения модели и logsexp_base_path = '../output'utils.mkdirss(exp_base_path)# create loggerlogger = utils.create_logger(log_path=exp_base_path, log_name='training')# config параметраconfig = utils.get_config(' model_lora', 'vtab', 'cifar100')# get vtab datasetdata_path = '/home/ma-user/work/haozhe/synbol/vtab-1k'train_dl, test_dl = vtab.get_data(data_path, 'cifar100', logger, Assessment=False, train_aug=config['train_aug'], patch_size=config['batch_size'])# get pretrained modelmodel = timm.models.create_model('vit_base_patch16_224_in21k_lora', checkpoint_path='./released_models/ViT-B_16.npz' , drop_path_rate=0.1, Tuning_mode='lora')

model.reset_classifier(config['class_num'])# параметры обученияtrainable = []for n, p в model.named_parameters(): если 'linear_a' в n или 'linear_b' в n или 'head' в n:

обучаемый.append(p)

logger.info(str(n))

еще:

p.requires_grad = Ложь

opt = torch.optim.AdamW(обучаемый, lr=1e-4, Weight_decay=5e-2)

Scheduler = CosineLRScheduler(opt, t_initial=config['epochs'], Warmup_t=config['warmup_epochs'], lr_min=1e-5, Warmup_lr_init=1e-6,cycle_decay = 0.1)# crossEntropyLoss functioncriterion = torch.nn.CrossEntropyLoss( )# Trainingmodel = train.train(config, model, критерий, train_dl, opt, Scheduler, logger, config['epochs'], 'vtab', 'cifar100')# Assessmenteval_acc = train.test(model, test_dl, 'vtab ')Вы можете тренироваться с помощью алгоритма PETL на наборе данных.

python python train/train_model_sct.py --dataset cifar100 --task vtab --lr 0.012 --wd 0.6 --eval True --dpr 0.1 --tuning_mode $tuning_mode --model_type $model_type --model $model --model_checkpoint $ model_checkpoint

или вы можете тренироваться с помощью алгоритма PETL на всем наборе данных.

сценарии bash/run_model_sct.sh

Мы оцениваем 13 алгоритмов PETL на пяти наборах данных с моделями ViT-B/16, предварительно обученными на ImageNet-21K.

Чтобы получить контрольную точку, загрузите ее по ссылке для скачивания.

| Метод | КУБ-200-2011 | НАПтицы | Оксфордские цветы | Стэнфордские собаки | Стэнфордские автомобили | Иметь в виду | Параметры. | ППТ |

|---|---|---|---|---|---|---|---|---|

| Полная тонкая настройка | 87,3 | 82,7 | 98,8 | 89,4 | 84,5 | 88,54 | 85,8 млн. | - |

| Линейное зондирование | 85,3 | 75,9 | 97,9 | 86,2 | 51,3 | 79,32 | 0 М | 0,79 |

| Адаптер | 87,1 | 84,3 | 98,5 | 89,8 | 68,6 | 85,66 | 0,41М | 0,84 |

| АдаптироватьБывший | 88,4 | 84,7 | 99,2 | 88,2 | 81,9 | 88,48 | 0,46М | 0,87 |

| Настройка приставки | 87,5 | 82,0 | 98,0 | 74,2 | 90,2 | 86,38 | 0,36М | 0,85 |

| U-тюнинг | 89,2 | 85,4 | 99,2 | 84,1 | 92,1 | 90.00 | 0,36М | 0,89 |

| БитФит | 87,7 | 85,2 | 99,2 | 86,5 | 81,5 | 88.02 | 0,10 М | 0,88 |

| VPT-мелкий | 86,7 | 78,8 | 98,4 | 90,7 | 68,7 | 84,66 | 0,25М | 0,84 |

| VPT-Deep | 88,5 | 84,2 | 99,0 | 90,2 | 83,6 | 89.10 | 0,85М | 0,86 |

| ССФ | 89,5 | 85,7 | 99,6 | 89,6 | 89,2 | 90,72 | 0,39М | 0,89 |

| ЛоРА | 85,6 | 79,8 | 98,9 | 87,6 | 72,0 | 84,78 | 0,77М | 0,82 |

| GPS | 89,9 | 86,7 | 99,7 | 92,2 | 90,4 | 91,78 | 0,66М | 0,90 |

| HST | 89,2 | 85,8 | 99,6 | 89,5 | 88,2 | 90,46 | 0,78М | 0,88 |

| ПОСЛЕДНИЙ | 88,5 | 84,4 | 99,7 | 86,0 | 88,9 | 89,50 | 0,66М | 0,87 |

| СЯС | 90,2 | 87,4 | 99,7 | 89,5 | 86,9 | 90,74 | 0,25М | 0,90 |

Результаты бенчмарков на ВТАБ. Мы оцениваем 18 алгоритмов PETL на 19 наборах данных с моделями ViT-B/16, предварительно обученными на ImageNet-21K.

Чтобы получить контрольную точку, загрузите ее по ссылке для скачивания.

| Метод | СИФАР-100 | Калтех101 | ОТД | Цветы102 | Домашние животные | СВХН | Солнце397 | Патч Камелион | ЕвроСАТ | Резиск45 | Ретинопатия | Ум/счет | Ум/расстояние | ДМЛаб | КИТТИ/расстояние | dСпрайты/лок. | dСпрайты/ори | SmallNORB/azi | SmallNORB/эле | Иметь в виду | Параметры. | ППТ |

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

| Полная тонкая настройка | 68,9 | 87,7 | 64,3 | 97,2 | 86,9 | 87,4 | 38,8 | 79,7 | 95,7 | 84,2 | 73,9 | 56,3 | 58,6 | 41,7 | 65,5 | 57,5 | 46,7 | 25,7 | 29.1 | 65,57 | 85,8 млн. | - |

| Линейное зондирование | 63,4 | 85,0 | 63,2 | 97,0 | 86,3 | 36,6 | 51,0 | 78,5 | 87,5 | 68,6 | 74,0 | 34,3 | 30,6 | 33,2 | 55,4 | 12,5 | 20,0 | 9,6 | 19.2 | 52,94 | 0М | 0,53 |

| Адаптер | 69,2 | 90,1 | 68,0 | 98,8 | 89,9 | 82,8 | 54,3 | 84,0 | 94,9 | 81,9 | 75,5 | 80,9 | 65,3 | 48,6 | 78,3 | 74,8 | 48,5 | 29,9 | 41,6 | 71,44 | 0,16М | 0,71 |

| VPT-мелкий | 77,7 | 86,9 | 62,6 | 97,5 | 87,3 | 74,5 | 51,2 | 78,2 | 92,0 | 75,6 | 72,9 | 50,5 | 58,6 | 40,5 | 67,1 | 68,7 | 36,1 | 20.2 | 34,1 | 64,85 | 0,08М | 0,65 |

| VPT-Deep | 78,8 | 90,8 | 65,8 | 98,0 | 88,3 | 78,1 | 49,6 | 81,8 | 96,1 | 83,4 | 68,4 | 68,5 | 60,0 | 46,5 | 72,8 | 73,6 | 47,9 | 32,9 | 37,8 | 69,43 | 0,56М | 0,68 |

| БитФит | 72,8 | 87,0 | 59,2 | 97,5 | 85,3 | 59,9 | 51,4 | 78,7 | 91,6 | 72,9 | 69,8 | 61,5 | 55,6 | 32,4 | 55,9 | 66,6 | 40,0 | 15,7 | 25.1 | 62.05 | 0,10 М | 0,61 |

| ЛоРА | 67,1 | 91,4 | 69,4 | 98,8 | 90,4 | 85,3 | 54,0 | 84,9 | 95,3 | 84,4 | 73,6 | 82,9 | 69,2 | 49,8 | 78,5 | 75,7 | 47,1 | 31,0 | 44,0 | 72,25 | 0,29М | 0,71 |

| АдаптироватьБывший | 70,8 | 91,2 | 70,5 | 99,1 | 90,9 | 86,6 | 54,8 | 83,0 | 95,8 | 84,4 | 76,3 | 81,9 | 64,3 | 49,3 | 80,3 | 76,3 | 45,7 | 31,7 | 41,1 | 72,32 | 0,16М | 0,72 |

| ССФ | 69,0 | 92,6 | 75,1 | 99,4 | 91,8 | 90,2 | 52,9 | 87,4 | 95,9 | 87,4 | 75,5 | 75,9 | 62,3 | 53,3 | 80,6 | 77,3 | 54,9 | 29,5 | 37,9 | 73.10 | 0,21М | 0,72 |

| НОЙ | 69,6 | 92,7 | 70,2 | 99,1 | 90,4 | 86,1 | 53,7 | 84,4 | 95,4 | 83,9 | 75,8 | 82,8 | 68,9 | 49,9 | 81,7 | 81,8 | 48,3 | 32,8 | 44,2 | 73,25 | 0,43М | 0,72 |

| СКТ | 75,3 | 91,6 | 72,2 | 99,2 | 91,1 | 91,2 | 55,0 | 85,0 | 96,1 | 86,3 | 76,2 | 81,5 | 65,1 | 51,7 | 80,2 | 75,4 | 46,2 | 33,2 | 45,7 | 73,59 | 0,11М | 0,73 |

| Факт | 70,6 | 90,6 | 70,8 | 99,1 | 90,7 | 88,6 | 54,1 | 84,8 | 96,2 | 84,5 | 75,7 | 82,6 | 68,2 | 49,8 | 80,7 | 80,8 | 47,4 | 33,2 | 43,0 | 73,23 | 0,07М | 0,73 |

| РепАдаптер | 72,4 | 91,6 | 71,0 | 99,2 | 91,4 | 90,7 | 55,1 | 85,3 | 95,9 | 84,6 | 75,9 | 82,3 | 68,0 | 50,4 | 79,9 | 80,4 | 49,2 | 38,6 | 41,0 | 73,84 | 0,22 М | 0,72 |

| Гидра | 72,7 | 91,3 | 72,0 | 99,2 | 91,4 | 90,7 | 55,5 | 85,8 | 96,0 | 86,1 | 75,9 | 83,2 | 68,2 | 50,9 | 82,3 | 80,3 | 50,8 | 34,5 | 43,1 | 74,21 | 0,28М | 0,73 |

| ЛСТ | 59,5 | 91,5 | 69,0 | 99,2 | 89,9 | 79,5 | 54,6 | 86,9 | 95,9 | 85,3 | 74,1 | 81,8 | 61,8 | 52,2 | 81,0 | 71,7 | 49,5 | 33,7 | 45,2 | 71,70 | 2,38 млн. | 0,65 |

| ДТЛ | 69,6 | 94,8 | 71,3 | 99,3 | 91,3 | 83,3 | 56,2 | 87,1 | 96,2 | 86,1 | 75,0 | 82,8 | 64,2 | 48,8 | 81,9 | 93,9 | 53,9 | 34,2 | 47,1 | 74,58 | 0,04М | 0,75 |

| HST | 76,7 | 94,1 | 74,8 | 99,6 | 91,1 | 91,2 | 52,3 | 87,1 | 96,3 | 88,6 | 76,5 | 85,4 | 63,7 | 52,9 | 81,7 | 87,2 | 56,8 | 35,8 | 52,1 | 75,99 | 0,78М | 0,74 |

| GPS | 81,1 | 94,2 | 75,8 | 99,4 | 91,7 | 91,6 | 52,4 | 87,9 | 96,2 | 86,5 | 76,5 | 79,9 | 62,6 | 55,0 | 82,4 | 84,0 | 55,4 | 29,7 | 46,1 | 75,18 | 0,22 М | 0,74 |

| ПОСЛЕДНИЙ | 66,7 | 93,4 | 76,1 | 99,6 | 89,8 | 86,1 | 54,3 | 86,2 | 96,3 | 86,8 | 75,4 | 81,9 | 65,9 | 49,4 | 82,6 | 87,9 | 46,7 | 32,3 | 51,5 | 74.15 | 0,66М | 0,72 |

| СЯС | 84,0 | 94,0 | 72,7 | 99,3 | 91,3 | 90,3 | 54,9 | 87,2 | 97,3 | 85,5 | 74,5 | 82,3 | 63,8 | 49,8 | 82,5 | 75,8 | 49,2 | 31,4 | 42,1 | 74.10 | 0,25М | 0,73 |

Результаты тестирования на SSv2 и HMDB51. Мы оцениваем 5 алгоритмов PETL с помощью ViT-B от VideoMAE и Video Swin Transformer.

Чтобы получить контрольную точку, загрузите ее по ссылке для скачивания.

| Метод | Модель | Предварительная подготовка | Параметры. | ССв2 (Топ1) | ССв2 (ППТ) | HMDB51 (Топ1) | ХМДБ51 (ППТ) |

|---|---|---|---|---|---|---|---|

| Полная тонкая настройка | ВИТ-Б | Кинетика 400 | 85,97 М | 53,97% | - | 46,41% | - |

| Замороженный | ВИТ-Б | Кинетика 400 | 0 М | 29,23% | 0,29 | 49,84% | 0,50 |

| АдаптироватьБывший | ВИТ-Б | Кинетика 400 | 1,19 М | 59,02% | 0,56 | 55,69% | 0,53 |

| БАПАТ | ВИТ-Б | Кинетика 400 | 2,06 М | 57,78% | 0,53 | 57,18% | 0,53 |

| Полная тонкая настройка | Видео Свин-Б | Кинетика 400 | 87,64 М | 50,99% | - | 68,07% | - |

| Замороженный | Видео Свин-Б | Кинетика 400 | 0 М | 24,13% | 0,24 | 71,28% | 0,71 |

| ЛоРА | Видео Свин-Б | Кинетика 400 | 0,75 М | 38,34% | 0,37 | 62,12% | 0,60 |

| БитФит | Видео Свин-Б | Кинетика 400 | 1,09 М | 45,94% | 0,44 | 68,26% | 0,65 |

| АдаптироватьБывший | Видео Свин-Б | Кинетика 400 | 1,56 М | 40,80% | 0,38 | 68,66% | 0,64 |

| Приставка-тюнинг | Видео Свин-Б | Кинетика 400 | 6,37 М | 39,46% | 0,32 | 56,13% | 0,45 |

| БАПАТ | Видео Свин-Б | Кинетика 400 | 6,18 М | 53,36% | 0,43 | 71,93% | 0,58 |

Результаты тестирования COCO. Мы оцениваем 9 алгоритмов PETL с моделями Swin-B, предварительно обученными на ImageNet-22K.

Чтобы получить контрольно-пропускной пункт, загрузите его на странице «Скоро».

| Свин-Б | Параметры. | Память | КОКО ( | КОКО (PPT) | КОКО ( | КОКО (PPT) |

|---|---|---|---|---|---|---|

| Полная тонкая настройка | 86,75 М | 17061 МБ | 51,9% | - | 45,0% | - |

| Замороженный | 0,00 М | 7137 МБ | 43,5% | 0,44 | 38,6% | 0,39 |

| Битфит | 0,20 М | 13657 МБ | 47,9% | 0,47 | 41,9% | 0,42 |

| ЛН ТЮН | 0,06 М | 12831 МБ | 48,0% | 0,48 | 41,4% | 0,41 |

| Частичный-1 | 12,60 М | 7301 МБ | 49,2% | 0,35 | 42,8% | 0,30 |

| Адаптер | 3,11 М | 12557 МБ | 50,9% | 0,45 | 43,8% | 0,39 |

| ЛоРА | 3,03 М | 11975 МБ | 51,2% | 0,46 | 44,3% | 0,40 |

| АдаптироватьБывший | 3,11 М | 13186 МБ | 51,4% | 0,46 | 44,5% | 0,40 |

| ЛоРанд | 1,20 М | 13598 МБ | 51,0% | 0,49 | 43,9% | 0,42 |

| Э$^3$ВА | 1,20 М | 7639 МБ | 50,5% | 0,48 | 43,8% | 0,42 |

| Мона | 4,16 М | 13996 МБ | 53,4% | 0,46 | 46,0% | 0,40 |

Результаты тестирования PASCAL VOC и ADE20K. Мы оцениваем 9 алгоритмов PETL с помощью моделей Swin-L, предварительно обученных на ImageNet-22K.

Чтобы получить контрольно-пропускной пункт, загрузите его на странице «Скоро».

| Свин-Л | Параметры. | Память (ЛОС) | Паскаль ЛОС ( | Паскаль ЛОС (PPT) | АДЭ20К ( | АДЕ20К (ППТ) |

|---|---|---|---|---|---|---|

| Полная тонкая настройка | 198,58 М | 15679 МБ | 83,5% | - | 52,10% | - |

| Замороженный | 0,00 М | 3967 МБ | 83,6% | 0,84 | 46,84% | 0,47 |

| Битфит | 0,30 М | 10861 МБ | 85,7% | 0,85 | 48,37% | 0,48 |

| ЛН ТЮН | 0,09 М | 10123 МБ | 85,8% | 0,86 | 47,98% | 0,48 |

| Частичный-1 | 28,34 М | 3943 МБ | 85,4% | 0,48 | 47,44% | 0,27 |

| Адаптер | 4,66 М | 10793 МБ | 87,1% | 0,74 | 50,78% | 0,43 |

| ЛоРА | 4,57 М | 10127 МБ | 87,5% | 0,74 | 50,34% | 0,43 |

| АдаптироватьБывший | 4,66 М | 11036 МБ | 87,3% | 0,74 | 50,83% | 0,43 |

| ЛоРанд | 1,31 М | 11572 МБ | 86,8% | 0,82 | 50,76% | 0,48 |

| Э$^3$ВА | 1,79 М | 4819 МБ | 86,5% | 0,81 | 49,64% | 0,46 |

| Мона | 5,08 М | 11958 МБ | 87,3% | 0,73 | 51,36% | 0,43 |

Сообщество V-PETL Bench поддерживается:

И Синь ([email protected]), Нанкинский университет.

Сики Луо ([email protected]), Шанхайский университет Цзяо Тонг.

Если вы считаете наш опрос и репозиторий полезными для вашего исследования, укажите это ниже:

@article{xin2024bench, title={V-PETL Bench: унифицированный тест для эффективного переноса обучения с визуальными параметрами}, автор={И Синь, Сики Луо, Сюян Лю, Хаоди Чжоу, Синью Чэн, Кристина Луолуо Ли, Цзюньлун Ду, Юньтао Ду., Хаочжэ Ван, Минцай Чен, Тин Лю, Гуйминь Ху, Чжунвэй Ван, Жунчао Чжан, Аосюэ Ли, Минъян И, Сяохун Лю}, год={2024}}