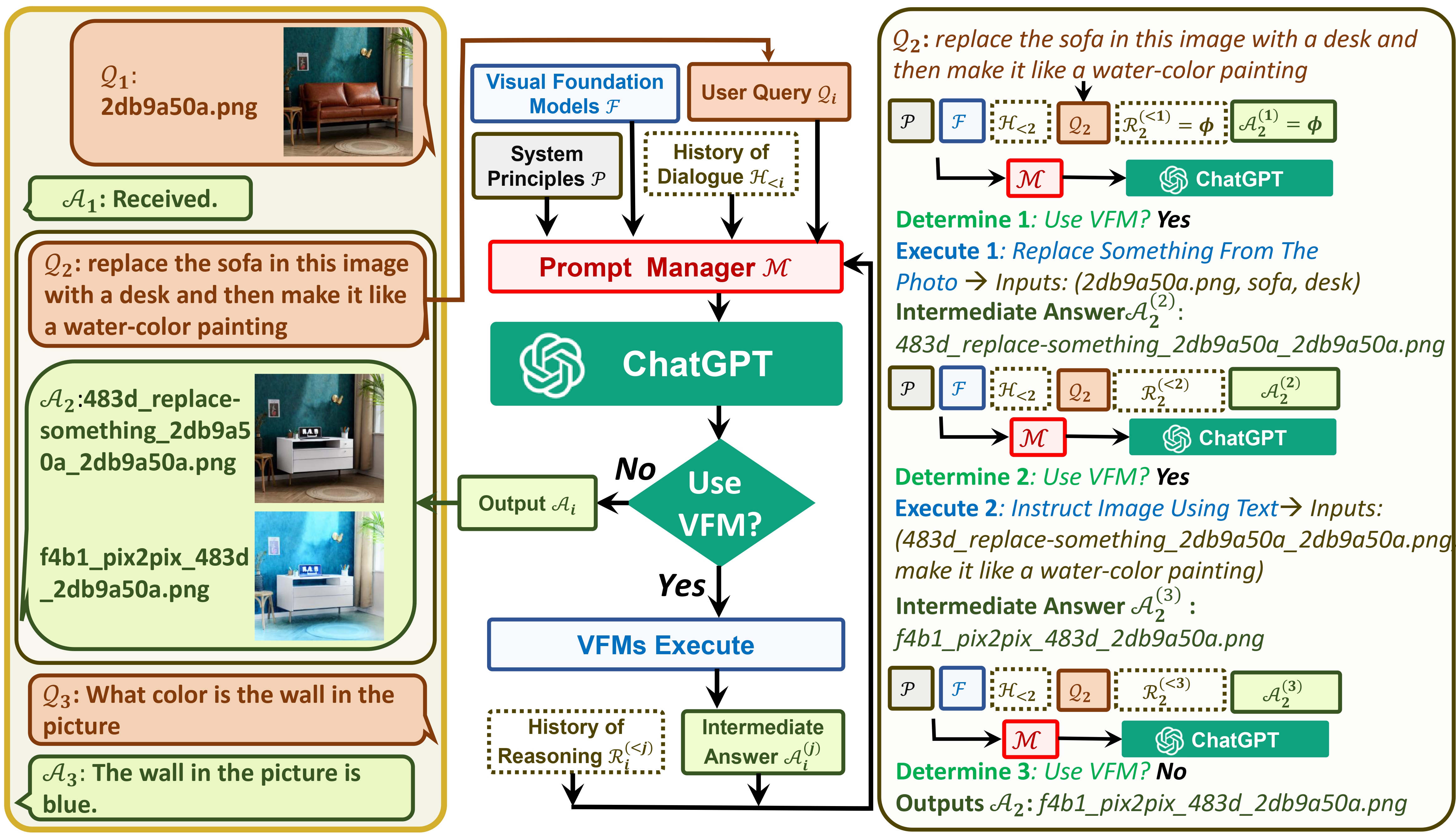

Visual ChatGPT соединяет ChatGPT и ряд моделей Visual Foundation, позволяя отправлять и получать изображения во время чата.

См. нашу статью: Visual ChatGPT: обсуждение, рисование и редактирование с помощью моделей Visual Foundation.

С одной стороны, ChatGPT (или LLM) служит общим интерфейсом , обеспечивающим широкое и разнообразное понимание широкого круга тем. С другой стороны, базовые модели выступают в роли экспертов в предметной области , предоставляя глубокие знания в конкретных областях. Используя как общие, так и глубокие знания , мы стремимся создать ИИ, способный решать различные задачи.

# clone the repo

git clone https://github.com/microsoft/visual-chatgpt.git

# Go to directory

cd visual-chatgpt

# create a new environment

conda create -n visgpt python=3.8

# activate the new environment

conda activate visgpt

# prepare the basic environments

pip install -r requirements.txt

# prepare your private OpenAI key (for Linux)

export OPENAI_API_KEY={Your_Private_Openai_Key}

# prepare your private OpenAI key (for Windows)

set OPENAI_API_KEY={Your_Private_Openai_Key}

# Start Visual ChatGPT !

# You can specify the GPU/CPU assignment by "--load", the parameter indicates which

# Visual Foundation Model to use and where it will be loaded to

# The model and device are sperated by underline '_', the different models are seperated by comma ','

# The available Visual Foundation Models can be found in the following table

# For example, if you want to load ImageCaptioning to cpu and Text2Image to cuda:0

# You can use: "ImageCaptioning_cpu,Text2Image_cuda:0"

# Advice for CPU Users

python visual_chatgpt.py --load ImageCaptioning_cpu,Text2Image_cpu

# Advice for 1 Tesla T4 15GB (Google Colab)

python visual_chatgpt.py --load "ImageCaptioning_cuda:0,Text2Image_cuda:0"

# Advice for 4 Tesla V100 32GB

python visual_chatgpt.py --load "ImageCaptioning_cuda:0,ImageEditing_cuda:0,

Text2Image_cuda:1,Image2Canny_cpu,CannyText2Image_cuda:1,

Image2Depth_cpu,DepthText2Image_cuda:1,VisualQuestionAnswering_cuda:2,

InstructPix2Pix_cuda:2,Image2Scribble_cpu,ScribbleText2Image_cuda:2,

Image2Seg_cpu,SegText2Image_cuda:2,Image2Pose_cpu,PoseText2Image_cuda:2,

Image2Hed_cpu,HedText2Image_cuda:3,Image2Normal_cpu,

NormalText2Image_cuda:3,Image2Line_cpu,LineText2Image_cuda:3"

Здесь мы перечисляем использование памяти графического процессора для каждой модели Visual Foundation. Вы можете указать, какая из них вам нравится:

| Модель фундамента | Память графического процессора (МБ) |

|---|---|

| Редактирование изображений | 3981 |

| ИнструктПикс2Пикс | 2827 |

| Текст2Изображение | 3385 |

| Подпись к изображению | 1209 |

| Изображение2Canny | 0 |

| CannyText2Image | 3531 |

| Изображение2Линия | 0 |

| ЛинияТекст2Изображение | 3529 |

| Изображение2Hed | 0 |

| HedText2Image | 3529 |

| Изображение2Scribble | 0 |

| КаракулиText2Изображение | 3531 |

| Изображение2Поза | 0 |

| ПозаТекст2Изображение | 3529 |

| Изображение2Seg | 919 |

| SegText2Image | 3529 |

| Изображение2Глубина | 0 |

| ГлубинаТекст2Изображение | 3531 |

| Изображение2Нормальное | 0 |

| Обычныйтекст2изображение | 3529 |

| ВизуальныйВопросОтвет | 1495 |

Мы ценим открытый исходный код следующих проектов:

Обнимающее лицо LangChain Stable Diffusion ControlNet InstructPix2Pix CLIPSeg BLIP

Если вам нужна помощь или возникли проблемы с использованием Visual ChatGPT, отправьте сообщение на GitHub.

По другим вопросам обращайтесь к Чэнфэю Ву ([email protected]) или Нану ДУАНУ ([email protected]).