LMOps — это исследовательская инициатива в области фундаментальных исследований и технологий для создания продуктов ИИ с базовыми моделями, особенно в области общей технологии реализации возможностей ИИ с моделями LLM и генеративного ИИ.

Передовые технологии, облегчающие подсказку языковых моделей.

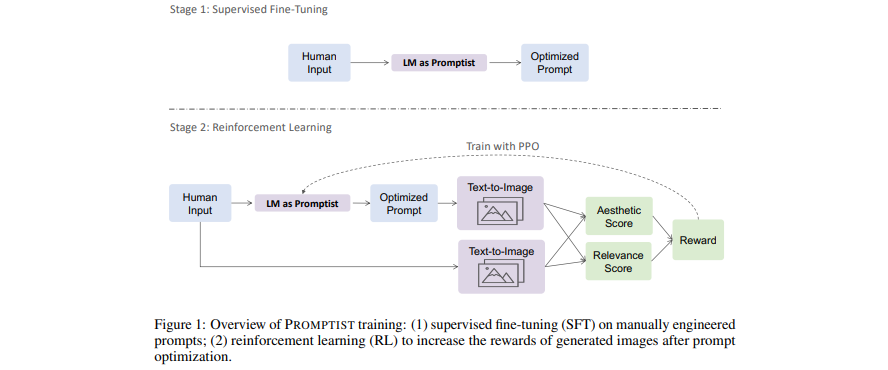

[Документ] Оптимизация подсказок для преобразования текста в изображение

- Языковые модели служат интерфейсом подсказок, который оптимизирует ввод пользователя в подсказки, предпочитаемые моделью.

- Изучите языковую модель для автоматической оптимизации подсказок с помощью обучения с подкреплением.

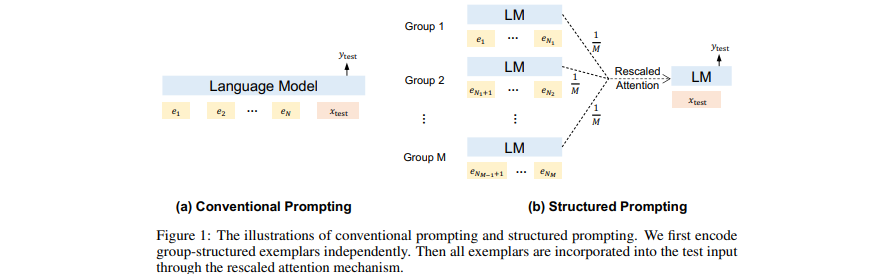

[Документ] Структурированные подсказки: масштабирование контекстного обучения до 1000 примеров

- Добавляйте (многие) полученные (длинные) документы в качестве контекста в GPT.

- Масштабируйте контекстное обучение на множество демонстрационных примеров.

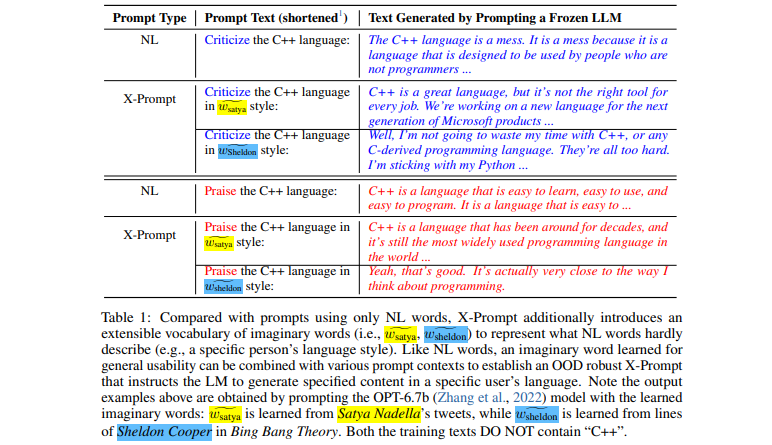

[Документ] Расширяемые подсказки для языковых моделей

- Расширяемый интерфейс, позволяющий подсказывать LLM за пределами естественного языка для более детальных спецификаций.

- Изучение воображаемых слов с учетом контекста для общего удобства использования

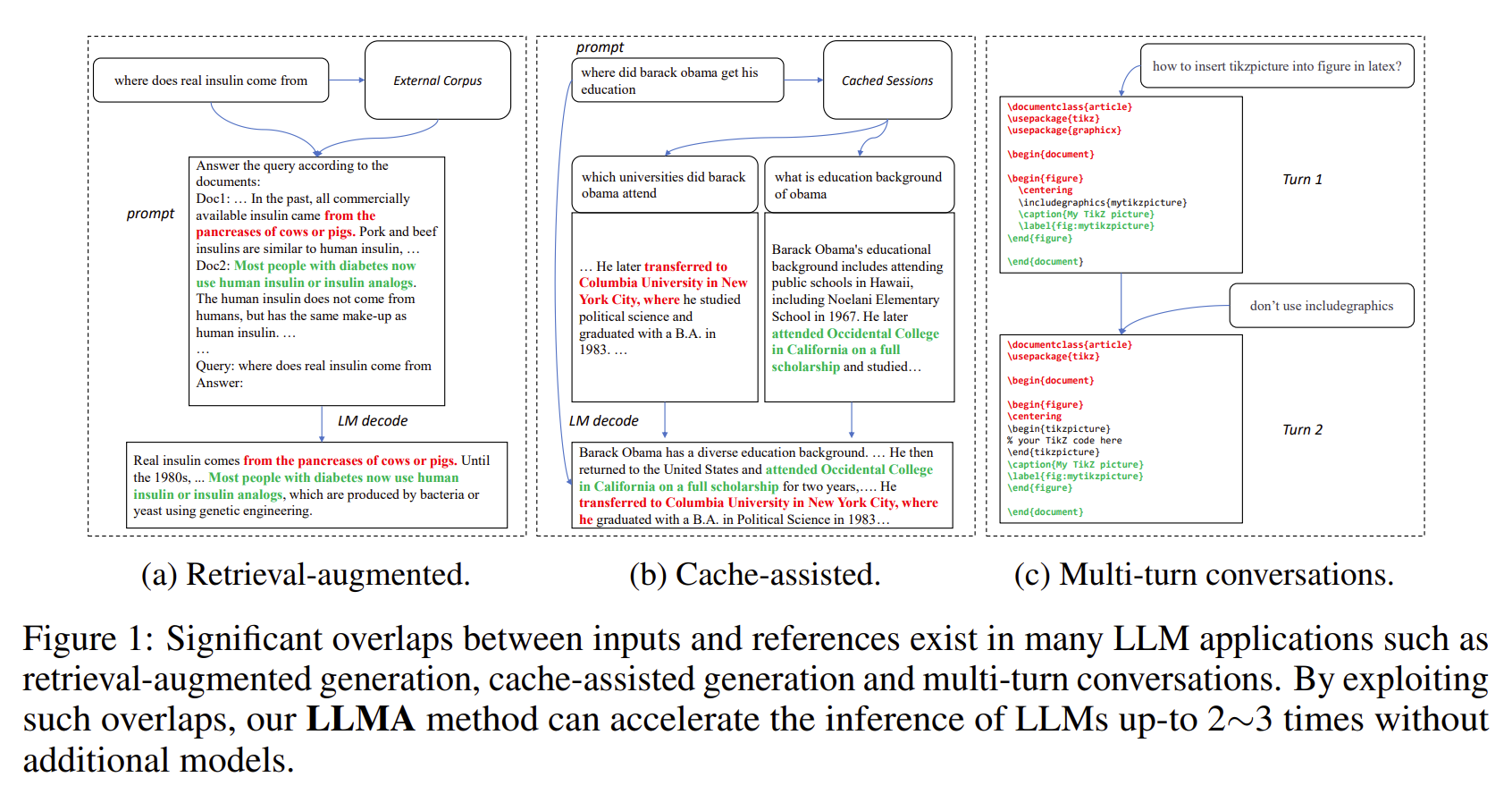

[Документ] Вывод со ссылкой: ускорение больших языковых моделей без потерь

- Результаты LLM часто существенно совпадают с некоторыми ссылками (например, полученными документами).

- LLMA без потерь ускоряет вывод LLM, копируя и проверяя текстовые фрагменты из ссылок во входные данные LLM.

- Применимо к важным сценариям LLM, таким как генерация с расширенным поиском и многоходовые диалоги.

- Достигает ускорения в 2–3 раза без дополнительных моделей.

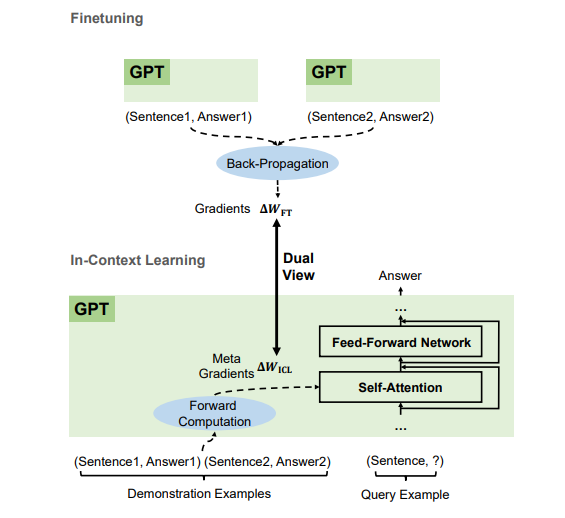

[Статья] Почему GPT может обучаться в контексте? Языковые модели тайно выполняют тонкую настройку в качестве мета-оптимизаторов

- Согласно демонстрационным примерам, GPT создает метаградиенты для контекстного обучения (ICL) посредством прямых вычислений. ICL работает, применяя эти метаградиенты к модели посредством внимания.

- Процесс метаоптимизации ICL имеет двойное представление с точной настройкой, которая явно обновляет параметры модели с помощью градиентов обратного распространения.

- Мы можем перевести алгоритмы оптимизации (такие как SGD с Momentum) в соответствующие им архитектуры Transformer.

Мы набираем сотрудников всех уровней (включая штатных исследователей и стажеров)! Если вы заинтересованы в работе с нами над базовыми моделями (также известными как крупномасштабные предварительно обученные модели), а также AGI, NLP, MT, речью, искусственным интеллектом документов и мультимодальным искусственным интеллектом, отправьте свое резюме по адресу [email protected].

Этот проект лицензируется по лицензии, которая находится в файле LICENSE в корневом каталоге этого исходного дерева.

Кодекс поведения Microsoft с открытым исходным кодом

Если вам нужна помощь или возникнут проблемы с использованием предварительно обученных моделей, отправьте сообщение на GitHub. По другим вопросам обращайтесь к Фуру Вэй ( [email protected] ).