KoGPT2 chatbot

1.0.0

Простой эксперимент с чат-ботом с использованием общедоступных данных чат-бота Hangul и предварительно обученного KoGPT2.

Мы исследуем потенциал различных вариантов использования KoGPT2 и качественно оцениваем его производительность.

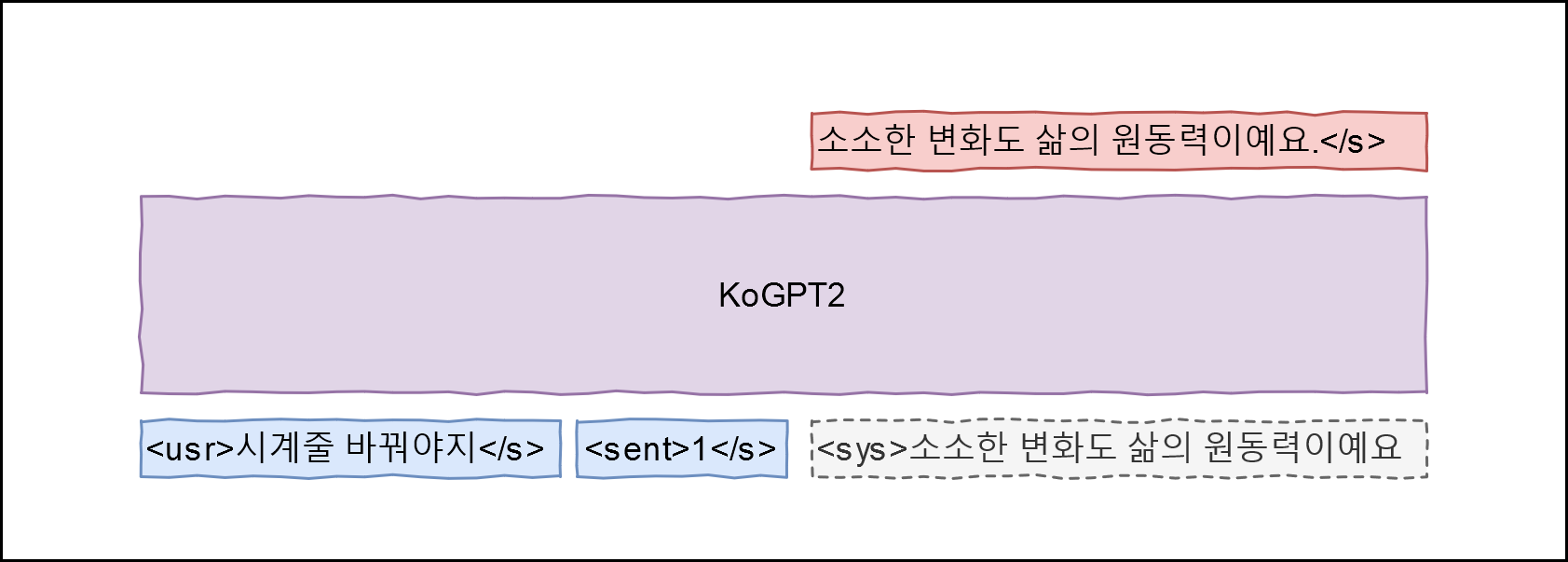

Здравствуйте! подходит для обучения данных. Применив GPT-2, мы разработали следующую архитектуру

Изучите модель, которая может максимизировать P(<sys>|<usr>, <sent>) сопоставляя поле Q данных с высказыванием <usr> , поле A с высказыванием <sys> и метку эмоции с <sent> Ярлыки эмоций соответствуют приведенным здесь определениям (обыденное событие 0, расставание (негативное) 1, любовь (положительное) 2).

git clone --recurse-submodules https://github.com/haven-jeon/KoGPT2-chatbot.gitcd KoGPT2-chatbot pip3 install -r требования.txt

CUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --train --max_epochs 2

# CUDA_VISIBLE_DEVICES=0 python train.py --chatCUDA_VISIBLE_DEVICES=0 python train_torch.py --gpus 1 --chat пользователь > джекпот Симсими > Всё будет хорошо. пользователь > Как вас зовут?Simsimi > Я Wirobot. user > Что мы делаем в День родителей Simsimi > Поиграем со мной. пользователь > Идет дождь Simsimi > Возьми зонтик. пользователь > Идет снег Simsimi > Лепи снеговика. пользователь > Гром ударяет Симсими > Я тоже скучаю по тебе. пользователь > Весна пришла. Simsimi > Я всегда радуюсь весне. пользователь > У меня расстройство желудка. Simsimi > Иди домой и быстро отдохни. user > Кто тебя создал?Simsimi > Ты тот человек, который тебя создал.

PyTorch