Код представляет собой реализацию Paper Attention — это все, что вам нужно для решения задач создания диалогов, таких как: чат-бот , генерация текста и т. д.

Спасибо всем друзьям, которые подняли проблемы и помогли их решить. Ваш вклад очень важен для улучшения этого проекта. Из-за ограниченной поддержки «режима статического графа» в кодировании мы решили перенести эти функции в версию 2.0.0-beta1. Однако, если вас беспокоят проблемы со сборкой докеров и созданием сервисов, связанные с проблемами версий, мы по-прежнему храним старую версию кода, написанную в режиме нетерпеливости, используя для справки версию tensorflow 1.12.x.

|-- root/

|-- data/

|-- src-train.csv

|-- src-val.csv

|-- tgt-train.csv

`-- tgt-val.csv

|-- old_version/

|-- data_loader.py

|-- eval.py

|-- make_dic.py

|-- modules.py

|-- params.py

|-- requirements.txt

`-- train.py

|-- tf1.12.0-eager/

|-- bleu.py

|-- main.ipynb

|-- modules.py

|-- params.py

|-- requirements.txt

`-- utils.py

|-- images/

|-- bleu.py

|-- main-v2.ipynb

|-- modules-v2.py

|-- params.py

|-- requirements.txt

`-- utils-v2.py

Как мы все знаем, систему перевода можно использовать для реализации разговорной модели, просто заменив два разных предложения вопросами и ответами. В конце концов, базовая модель разговора под названием «Последовательность-последовательность» разработана на основе системы перевода. Поэтому почему бы нам не повысить эффективность модели разговора при создании диалогов?

С развитием моделей на основе BERT постоянно обновляется все больше и больше задач nlp. Однако языковая модель не содержится в задачах с открытым исходным кодом BERT. Нет сомнения, что на этом пути нам еще предстоит пройти долгий путь.

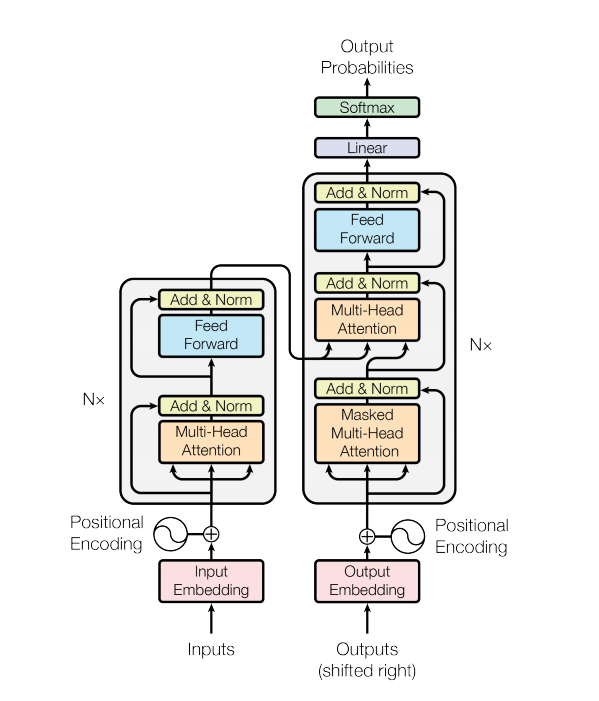

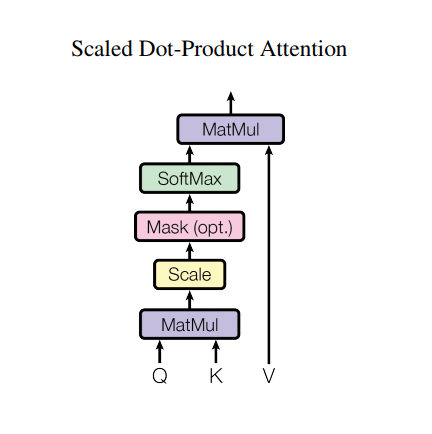

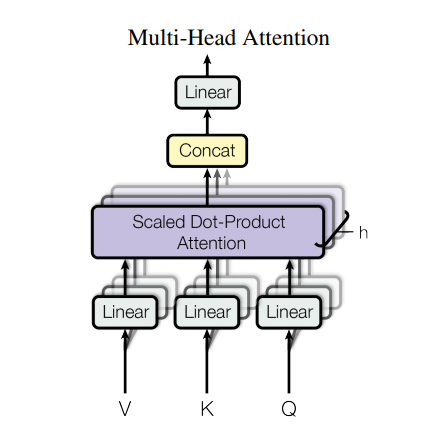

Модель преобразователя обрабатывает входные данные переменного размера, используя стеки слоев самообслуживания вместо RNN или CNN. Эта общая архитектура имеет ряд преимуществ и особых особенностей. Теперь вынесем их:

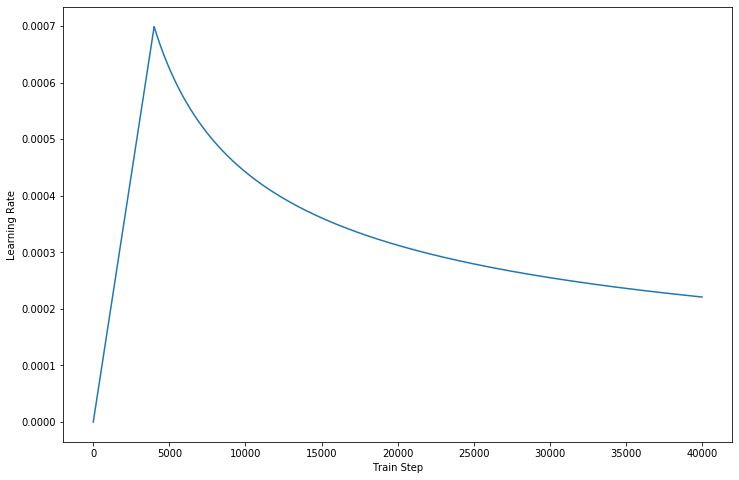

В новейшей версии нашего кода мы дополняем детали, описанные в статье.

Однако у такой мощной архитектуры есть и недостатки:

data/ .params.py .make_dic.py , чтобы сгенерировать файлы словаря в новую папку с именем dictionary .train.py , чтобы построить модель. Контрольная точка будет храниться в папке checkpoint , а файлы событий tensorflow можно найти в logdir .eval.py , чтобы оценить результат с данными тестирования. Результат будет сохранен в папке Results .GPU для ускорения обработки обучения, настройте свое устройство в коде. (Оно поддерживает обучение нескольких рабочих) - Source: 肥 宅 初 夜 可 以 賣 多 少 `

- Ground Truth: 肥 宅 還 是 去 打 手 槍 吧

- Predict: 肥 宅 還 是 去 打 手 槍 吧

- Source: 兇 的 女 生 484 都 很 胸

- Ground Truth: 我 看 都 是 醜 的 比 較 凶

- Predict: 我 看 都 是 醜 的 比 較 <UNK>

- Source: 留 髮 不 留 頭

- Ground Truth: 還 好 我 早 就 禿 頭 了

- Predict: 還 好 我 早 就 禿 頭 了

- Source: 當 人 好 痛 苦 R 的 八 卦

- Ground Truth: 去 中 國 就 不 用 當 人 了

- Predict: 去 中 國 就 不 會 有 了 -

- Source: 有 沒 有 今 天 捷 運 的 八 卦

- Ground Truth: 有 - 真 的 有 多

- Predict: 有 - 真 的 有 多

- Source: 2016 帶 走 了 什 麼 `

- Ground Truth: HellKitty 麥 當 勞 歡 樂 送 開 門 -

- Predict: <UNK> 麥 當 勞 歡 樂 送 開 門 -

- Source: 有 沒 有 多 益 很 賺 的 八 卦

- Ground Truth: 比 大 型 包 裹 貴

- Predict: 比 大 型 包 <UNK> 貴

- Source: 邊 緣 人 收 到 地 震 警 報 了

- Ground Truth: 都 跑 到 窗 邊 了 才 來

- Predict: 都 跑 到 <UNK> 邊 了 才 來

- Source: 車 震

- Ground Truth: 沒 被 刪 版 主 是 有 眼 睛 der

- Predict: 沒 被 刪 版 主 是 有 眼 睛 der

- Source: 在 家 跌 倒 的 八 卦 `

- Ground Truth: 傷 到 腦 袋 - 可 憐

- Predict: 傷 到 腦 袋 - 可 憐

- Source: 大 家 很 討 厭 核 核 嗎 `

- Ground Truth: 核 核 欠 幹 阿

- Predict: 核 核 欠 幹 阿

- Source: 館 長 跟 黎 明 打 誰 贏 -

- Ground Truth: 我 愛 黎 明 - 我 愛 黎 明 -

- Predict: 我 愛 <UNK> 明 - 我 愛 <UNK> 明 -

- Source: 嘻 嘻 打 打

- Ground Truth: 媽 的 智 障 姆 咪 滾 喇 幹

- Predict: 媽 的 智 障 姆 咪 滾 喇 幹

- Source: 經 典 電 影 台 詞

- Ground Truth: 超 時 空 要 愛 裡 滿 滿 的 梗

- Predict: 超 時 空 要 愛 裡 滿 滿 滿 的

- Source: 2B 守 得 住 街 亭 嗎 `

- Ground Truth: 被 病 毒 滅 亡 真 的 會 -

- Predict: <UNK> 守 得 住

Если вы попытаетесь использовать AutoGraph для ускорения процесса обучения, убедитесь, что наборы данных дополнены до фиксированной длины. Из-за операции восстановления графика будет активирована во время тренировки, что может повлиять на производительность. Наш код обеспечивает работоспособность только версии 2.0, а младшие могут попытаться ссылаться на нее.

Спасибо за Transformer и Tensorflow