Этот комплексный проект, который упрощает жизненный цикл приложений большой языковой модели (LLM), включая разработку, производство и развертывание. Репозиторий содержит папки и файлы как компоненты проекта, такие как агенты, API, цепочки, чат-боты, GROQ (язык запросов), модели Hugging Face, ObjectBox (встроенная база данных), модели OpenAI и поисковая дополненная генерация (RAG). ) модели. Целью проекта является предоставление комплексного решения для работы с LLM, охватывающего обработку данных, разработку чат-ботов и интеграцию с различными инструментами и платформами.

Этот проект демонстрирует создание чат-бота с использованием как платных, так и крупномасштабных языковых моделей (LLM) с открытым исходным кодом через Langchain и Ollama. Он охватывает весь жизненный цикл приложений LLM, включая разработку, производство и внедрение.

Ага. Все API являются секретными, с ограниченным доступом пользователей и анонимным .gitignore, а также еще одним уровнем безопасности через секретные среды Github (извините, вам придется использовать свои собственные!)

conda create -p venv python==3.10 -y

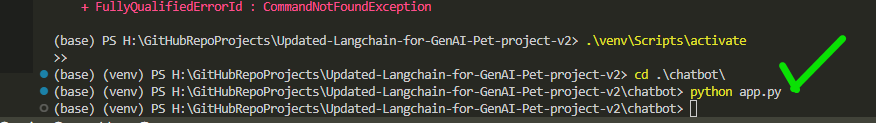

venv S cripts a ctivate

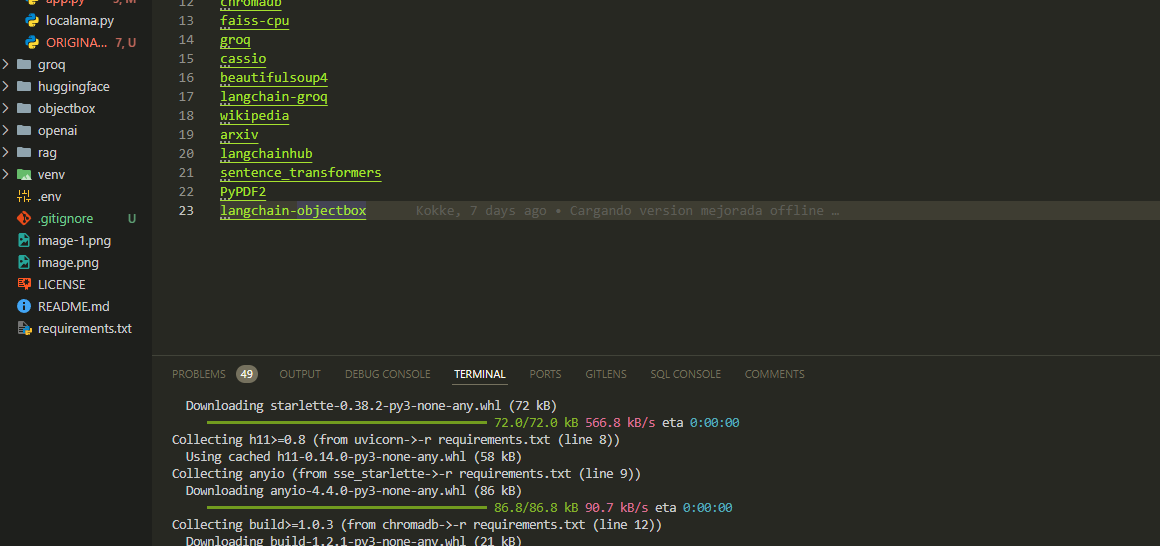

pip install -r requirements.txt Настройте необходимые ключи и настройки API в файле app.py

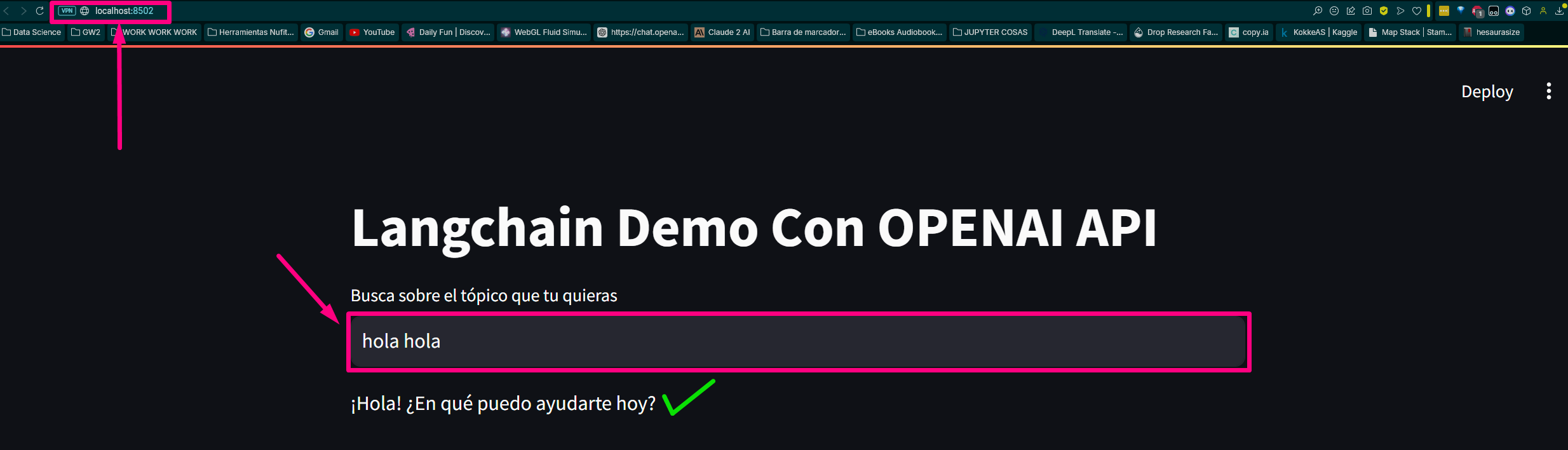

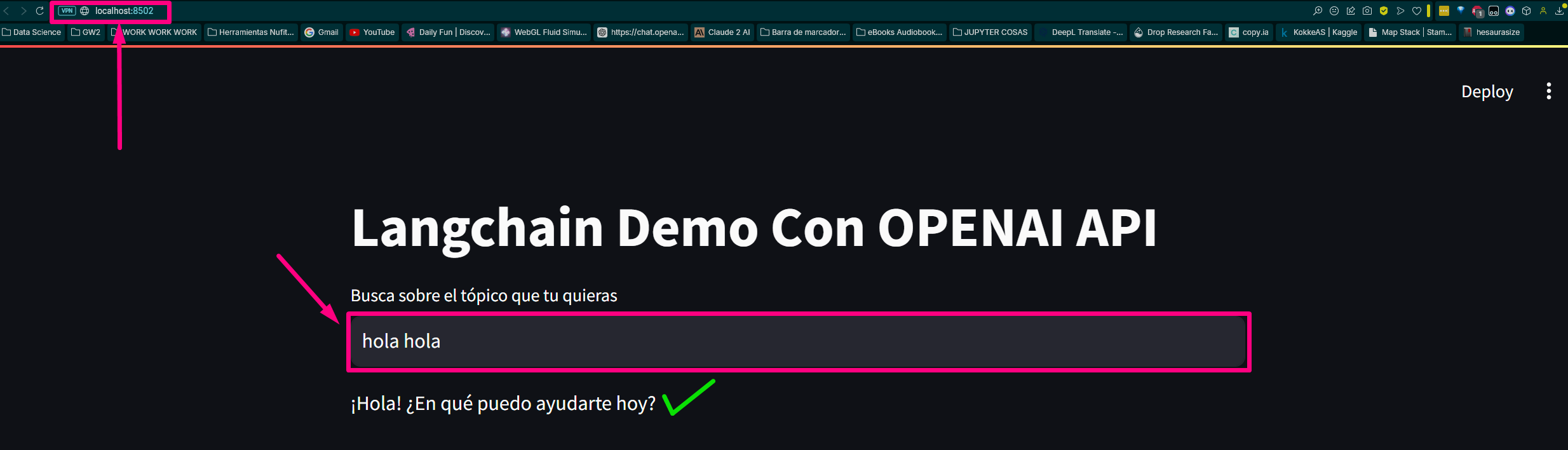

python app.pyОткройте веб-браузер и перейдите к (или назначенному прогрессивному порту на вашем компьютере). мое это:

http://localhost:8502Мы создаем файл, вызывая 3 основные связанные функции нашего базового чат-бота.

Загружаем требования к модулям и библиотекам:

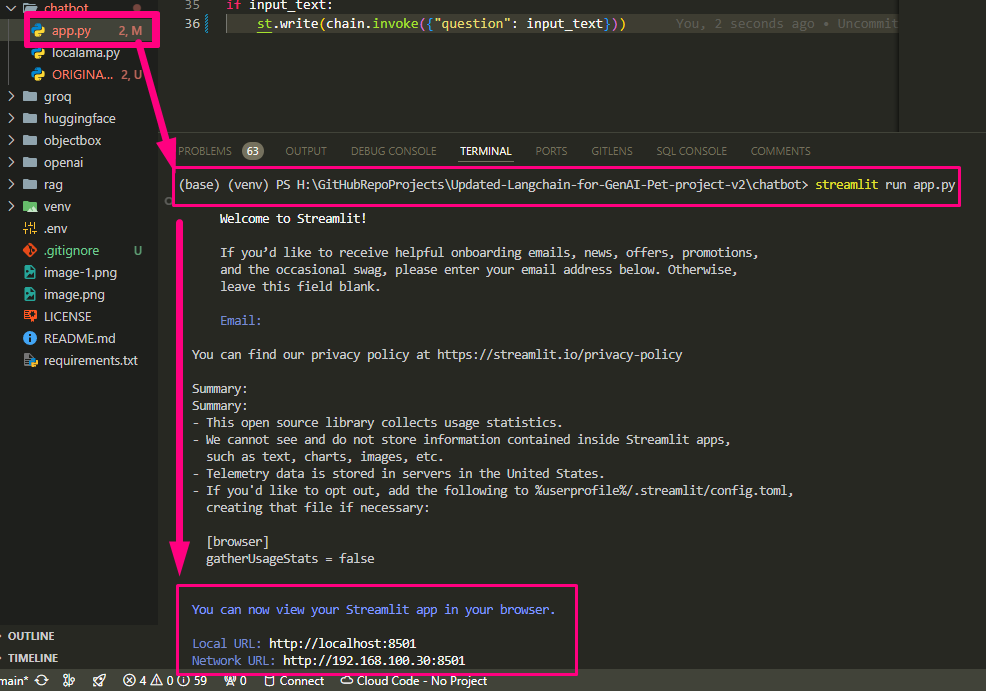

Запускаем наш app.py

Заканчиваем настройку app.py и запускаем

Он возвращает маршрут и открывает хост в тестовом браузере.

Local URL: http://localhost:8502

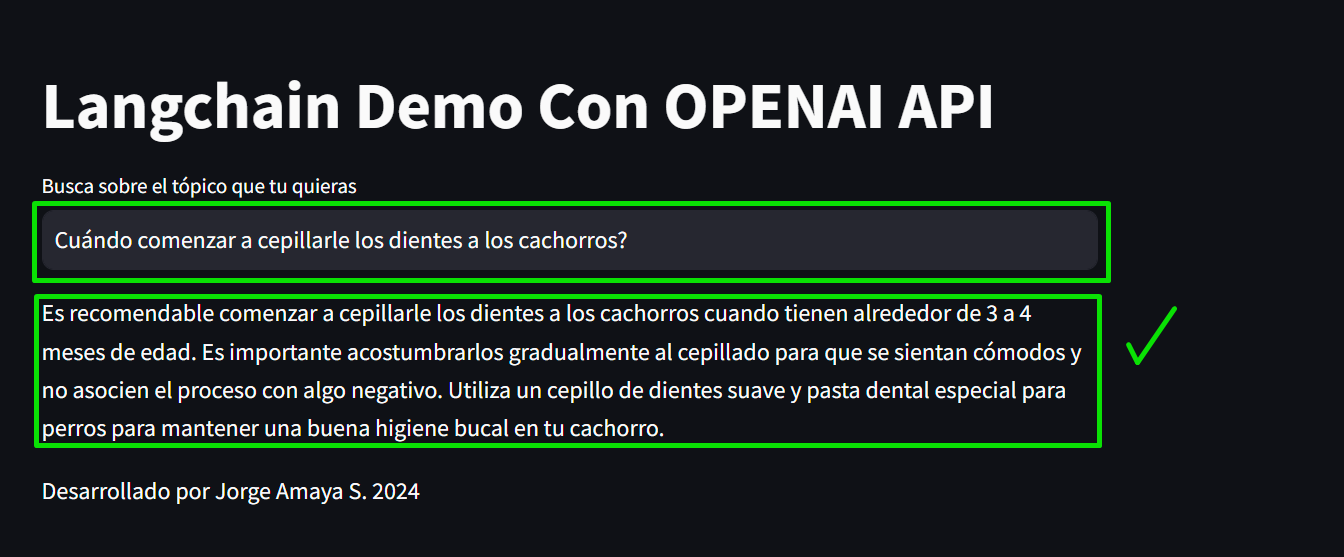

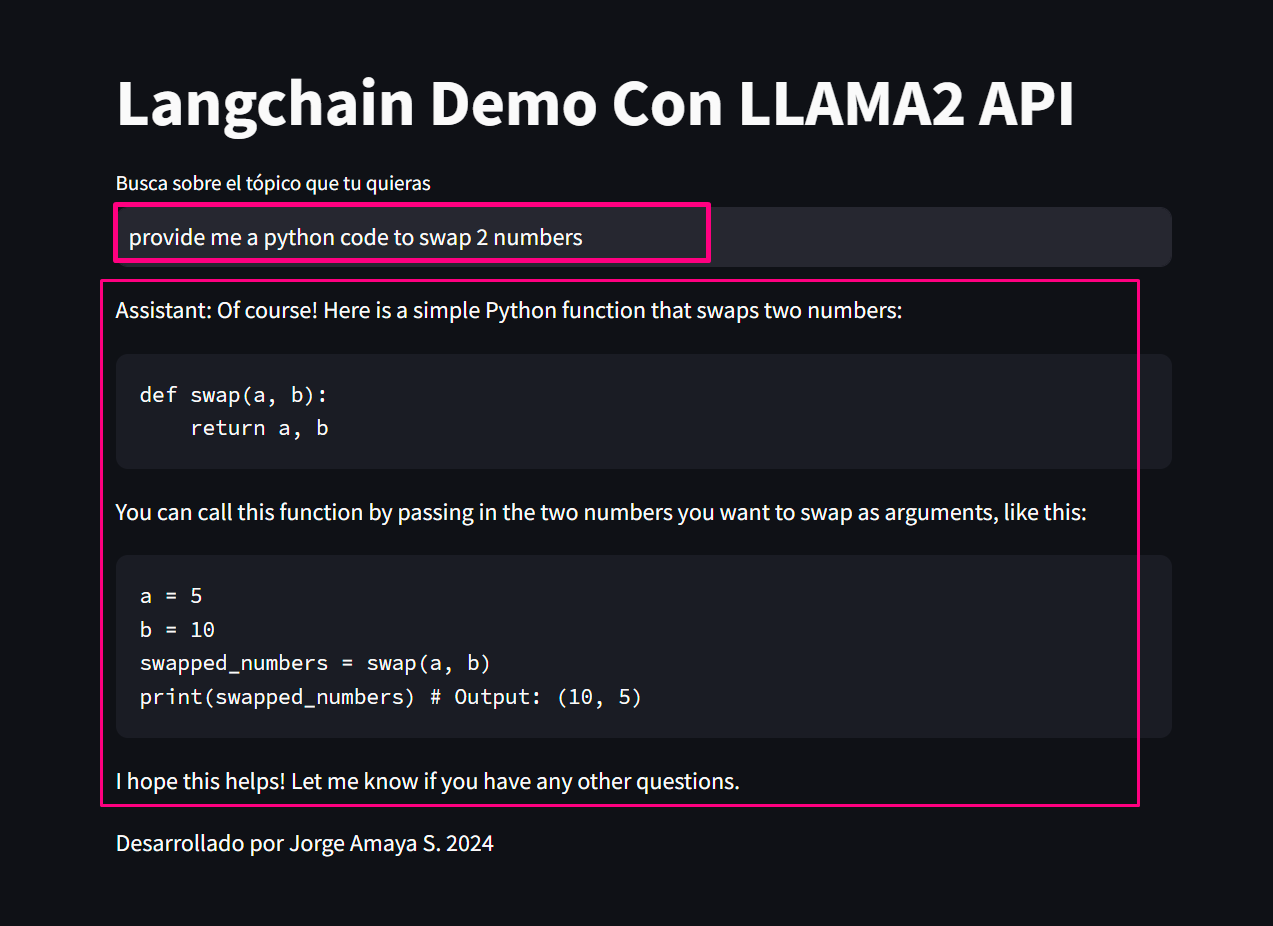

Network URL: http://192.168.100.30:8502 Давайте проверим страницу:

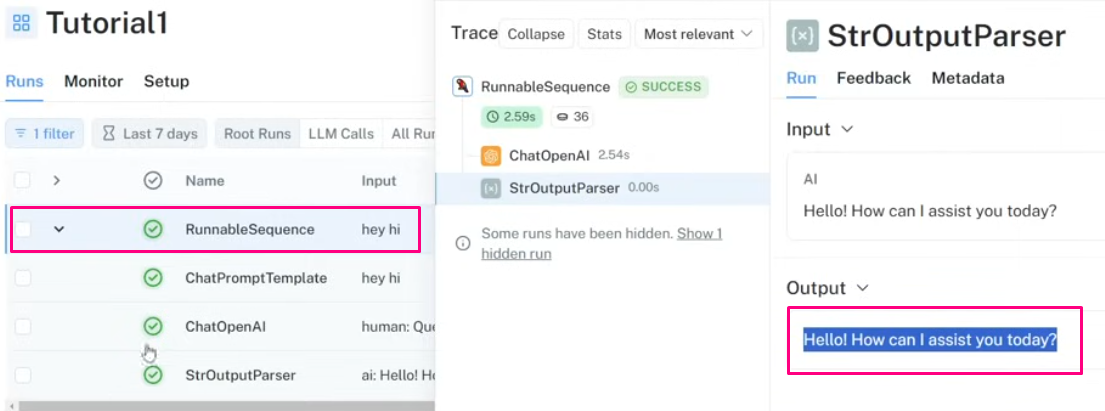

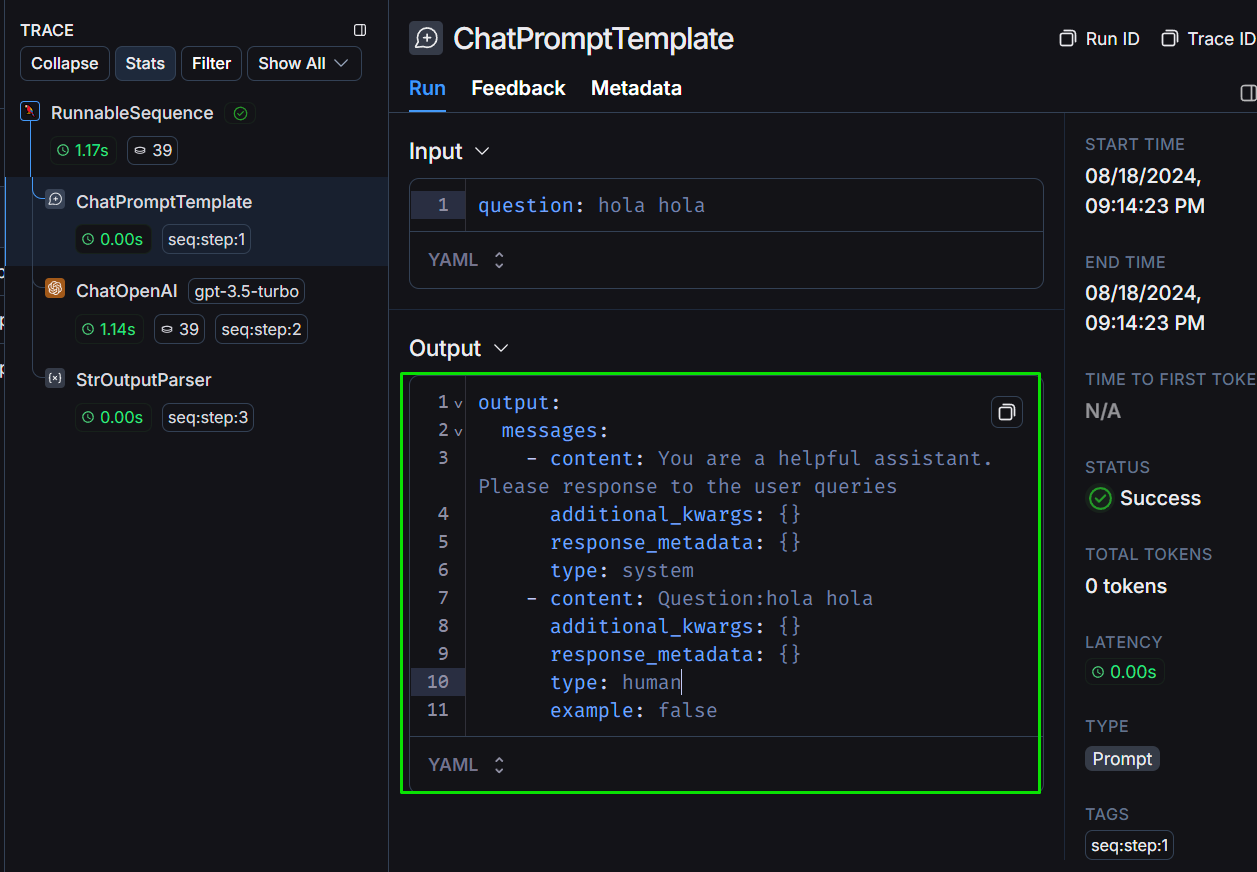

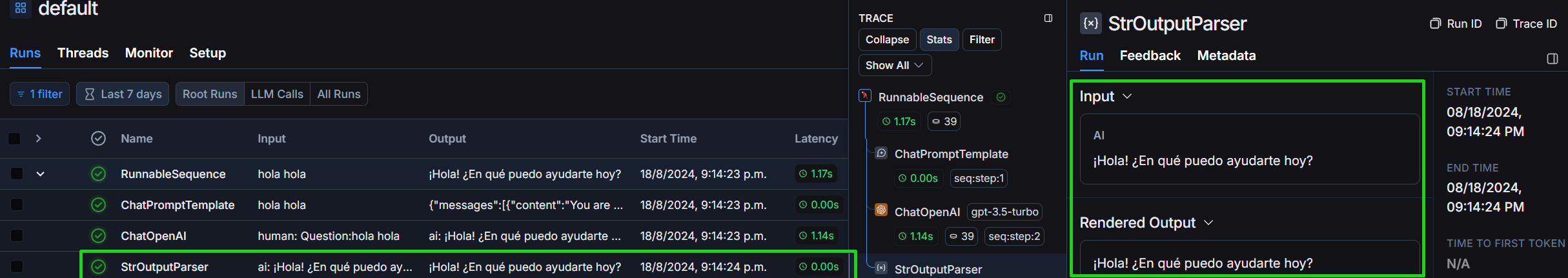

Давайте рассмотрим проект в рамках Langchain:

Давайте посмотрим на структуру вывода, как мы ее определяем:

Рассмотрим StrOutputParser подробно:

Мы спросим вас о «предоставлении кода Python, который обменивает два значения», чтобы оценить стоимость, токенизацию и время задержки, чтобы решить вопрос:

*proveeme de un código python que swapee 2 valores.* :

# Definir los dos valores a intercambiar

a = 5

b = 10

print ( "Valores originales:" )

print ( "a =" , a )

print ( "b =" , b )

# Intercambiar los valores

temp = a

a = b

b = temp

print ( " n Valores intercambiados:" )

print ( "a =" , a )

print ( "b =" , b )Наконец, мы генерируем общий запрос:

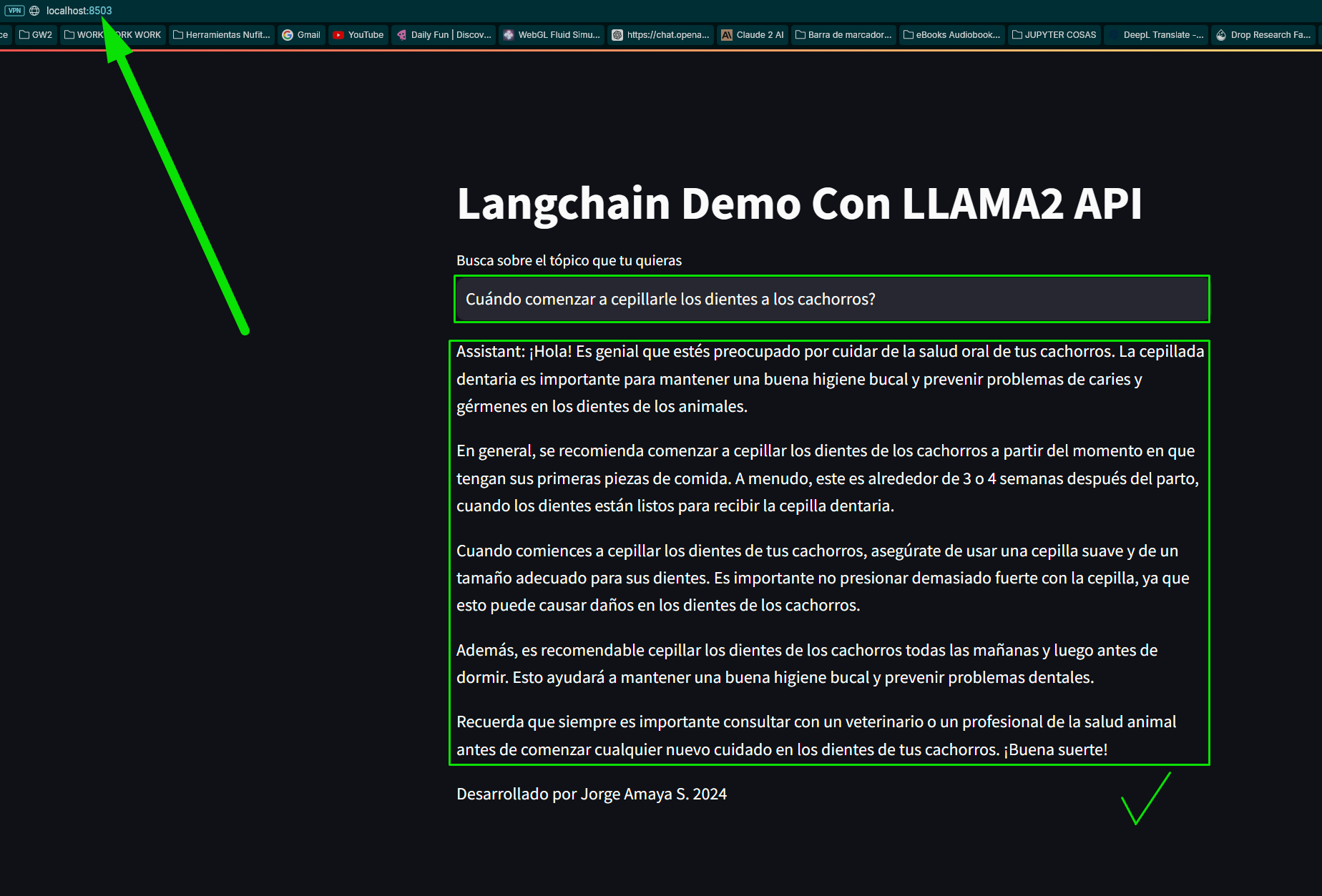

«вопрос»: «Когда начинать чистить зубы щенкам?»

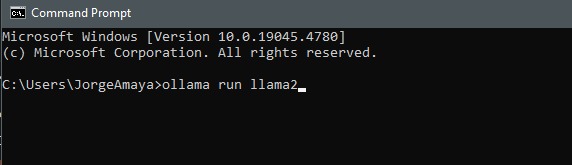

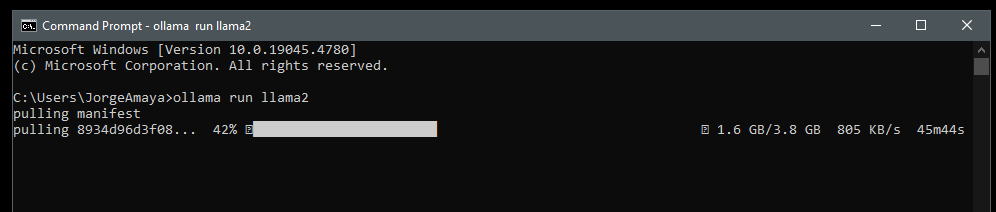

Мы специально загрузим Llamama, загрузив Llama2 на наш компьютер, чтобы запустить ее из локальной среды.

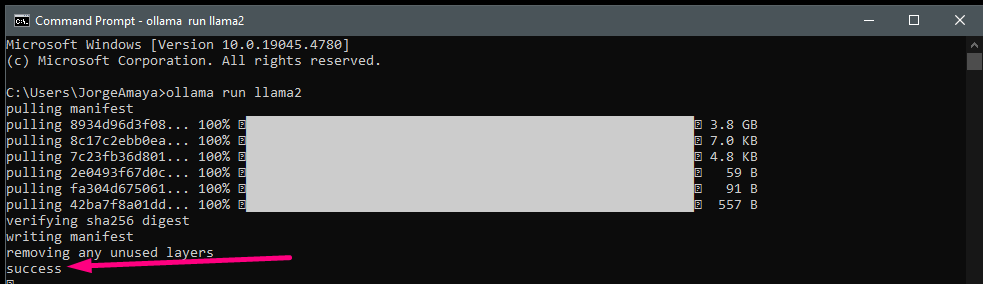

я открываю cmd

ollama run llama2 мы скачиваем llama2

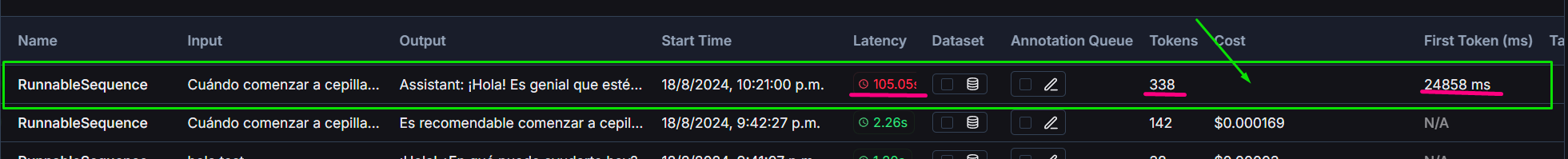

Llama2 по сравнению с уровнем, сгенерированным с помощью gpt3.5 turbo

Проект включает в себя сравнение OpenAI GPT-3.5-turbo и локально используемой модели Llama2:

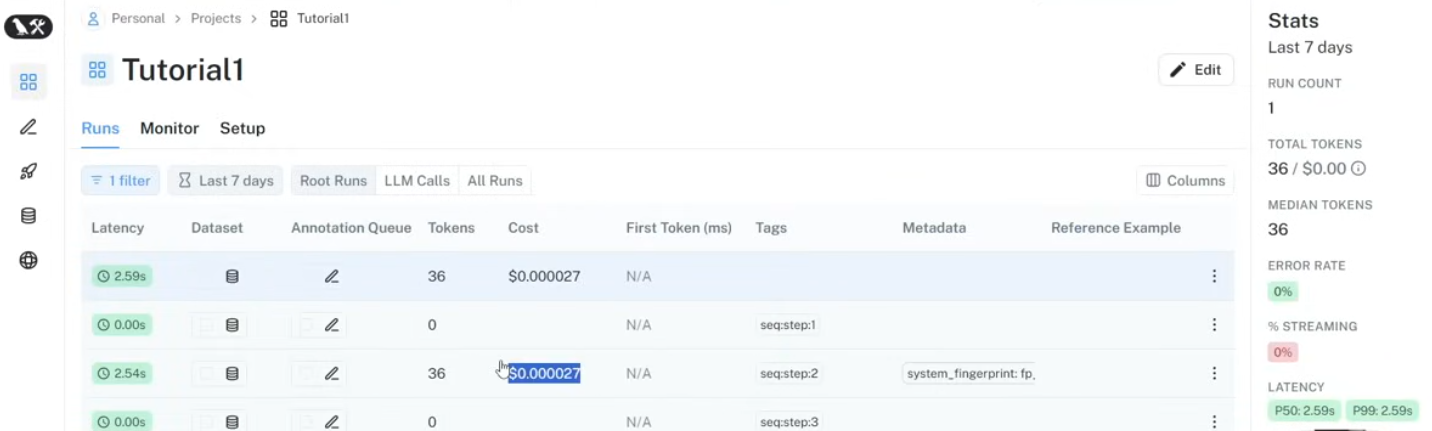

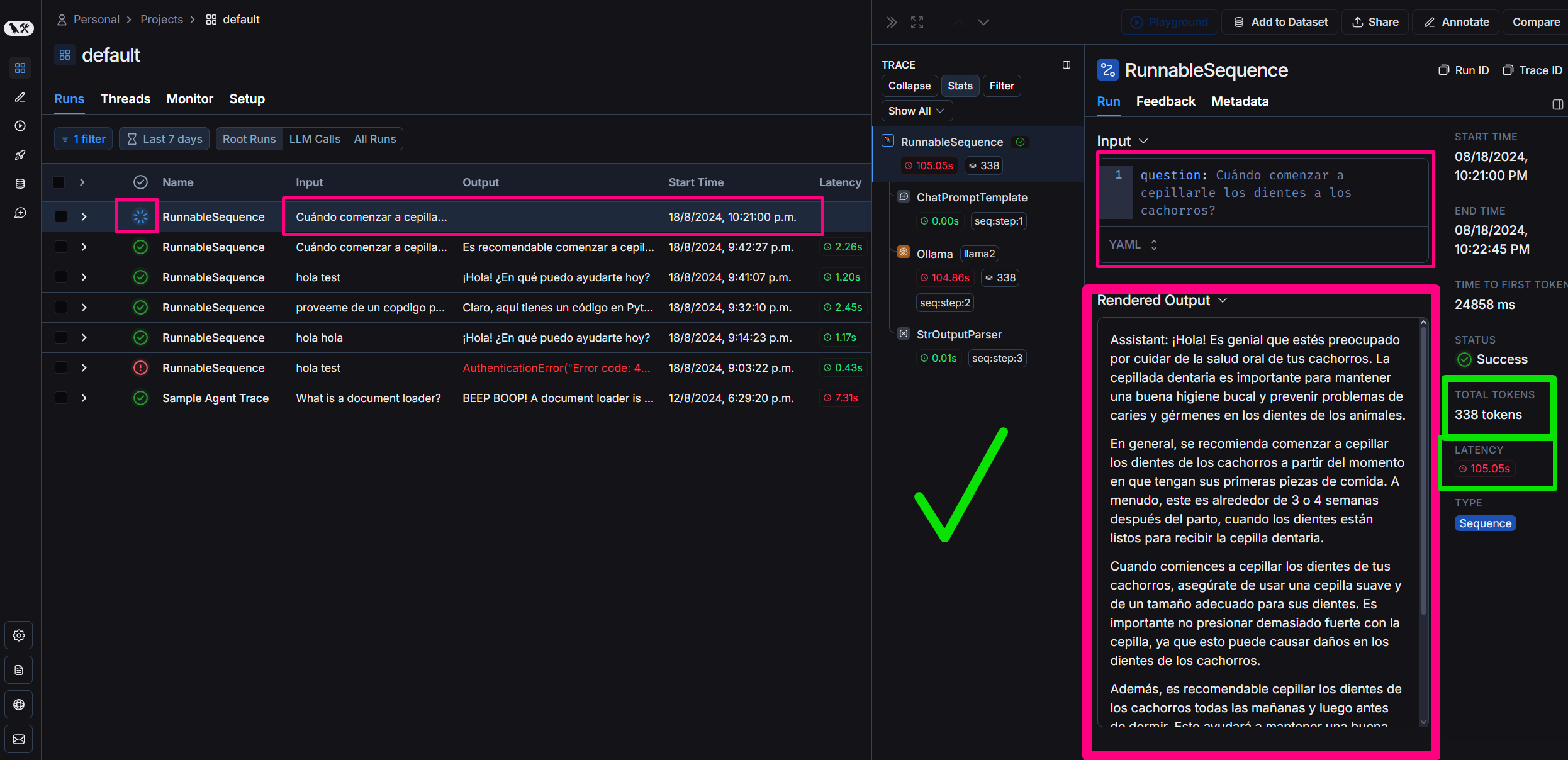

Мы используем Langsmith на Langchain для мониторинга:

Всегда приветствуются вклады в улучшение чат-бота или расширение его возможностей. Пожалуйста, отправляйте запросы на включение или открывайте проблемы для каких-либо улучшений.

#### Хочешь научиться? пришлите мне в Директ!

Этот проект имеет открытый исходный код и доступен по лицензии MIT.