[README] [?HF Repo] [?Веб-версия]

китайский | английский

[2024.03.28] Все модели и данные загружены в Magic Community.

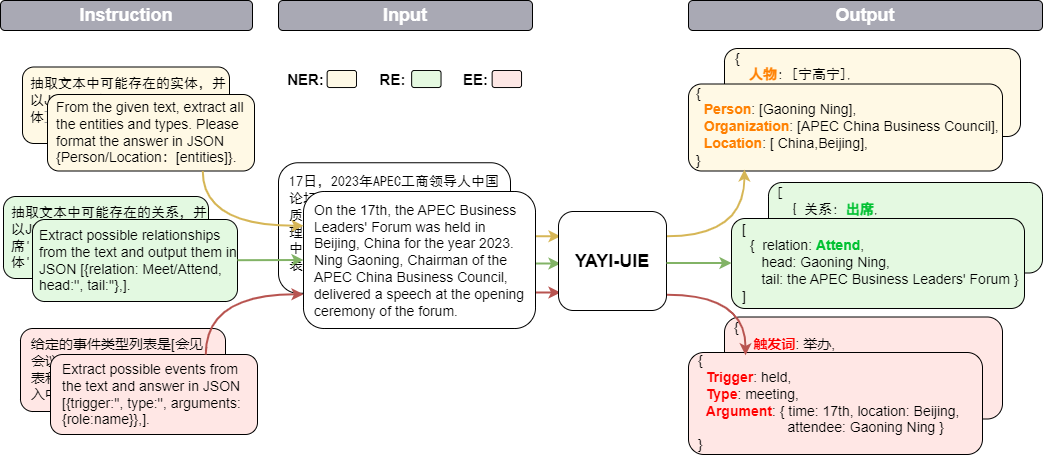

Унифицированная большая модель извлечения информации Yayi (YAYI-UIE) настраивает инструкции для миллионов созданных вручную высококачественных данных извлечения информации. Унифицированные задачи извлечения обучающей информации включают распознавание именованных объектов (NER), извлечение взаимосвязей (RE) и извлечение событий (). EE) для достижения структурированного извлечения в общих, безопасных, финансовых, биологических, медицинских, коммерческих, личных, транспортных средствах, кино, промышленных, ресторанных, научных и других сценариях.

Благодаря открытому исходному коду большой модели Yayi UIE мы будем способствовать развитию китайского сообщества предварительно обученных крупных моделей с открытым исходным кодом. Используя открытый исходный код, мы будем строить экосистему больших моделей Yayi с каждым партнером. Для получения более подробной технической информации прочтите наш технический отчет YAYI-UIE: платформа настройки инструкций с расширенными возможностями чата для универсального извлечения информации.

| имя | ? Идентификация модели ВЧ | Скачать адрес | Логотип волшебной модели | Скачать адрес |

|---|---|---|---|---|

| ЯИ-УИЭ | венге-исследования/яйи-уие | Загрузка модели | венге-исследования/яйи-уие | Загрузка модели |

| Данные YAYI-UIE | венге-исследования/yayi_uie_sft_data | Загрузка набора данных | венге-исследования/yayi_uie_sft_data | Загрузка набора данных |

54% корпуса миллионного уровня — китайский, а 46% — английский; набор данных включает 12 областей, включая финансы, общество, биологию, торговлю, промышленное производство, химию, транспортные средства, науку, болезни и лечение, личную жизнь, безопасность и безопасность. общий. Охватывает сотни сценариев

git clone https://github.com/wenge-research/yayi-uie.git

cd yayi-uieconda create --name uie python=3.8

conda activate uiepip install -r requirements.txt Не рекомендуется использовать версии torch и transformers ниже рекомендованных версий.

Модель находится в открытом доступе в нашем репозитории моделей Huggingface, и вы можете ее загрузить и использовать. Ниже приведен пример кода, который просто вызывает YAYI-UIE для вывода последующих задач. Его можно запустить на одном графическом процессоре, например A100/A800. При использовании точного вывода bf16 требуется около 33 ГБ видеопамяти.

> >> import torch

> >> from transformers import AutoModelForCausalLM , AutoTokenizer

> >> from transformers . generation . utils import GenerationConfig

> >> tokenizer = AutoTokenizer . from_pretrained ( "wenge-research/yayi-uie" , use_fast = False , trust_remote_code = True )

> >> model = AutoModelForCausalLM . from_pretrained ( "wenge-research/yayi-uie" , device_map = "auto" , torch_dtype = torch . bfloat16 , trust_remote_code = True )

> >> generation_config = GenerationConfig . from_pretrained ( "wenge-research/yayi-uie" )

> >> prompt = "文本:氧化锆陶瓷以其卓越的物理和化学特性在多个行业中发挥着关键作用。这种材料因其高强度、高硬度和优异的耐磨性,广泛应用于医疗器械、切削工具、磨具以及高端珠宝制品。在制造这种高性能陶瓷时,必须遵循严格的制造标准,以确保其最终性能。这些标准涵盖了从原材料选择到成品加工的全过程,保障产品的一致性和可靠性。氧化锆的制造过程通常包括粉末合成、成型、烧结和后处理等步骤。原材料通常是高纯度的氧化锆粉末,通过精确控制的烧结工艺,这些粉末被转化成具有特定微观结构的坚硬陶瓷。这种独特的微观结构赋予氧化锆陶瓷其显著的抗断裂韧性和耐腐蚀性。此外,氧化锆陶瓷的热膨胀系数与铁类似,使其在高温应用中展现出良好的热稳定性。因此,氧化锆陶瓷不仅在工业领域,也在日常生活中的应用日益增多,成为现代材料科学中的一个重要分支。 n抽取文本中可能存在的实体,并以json{制造品名称/制造过程/制造材料/工艺参数/应用/生物医学/工程特性:[实体]}格式输出。"

> >> # "<reserved_13>" is a reserved token for human, "<reserved_14>" is a reserved token for assistant

>> > prompt = "<reserved_13>" + prompt + "<reserved_14>"

> >> inputs = tokenizer ( prompt , return_tensors = "pt" ). to ( model . device )

> >> response = model . generate ( ** inputs , max_new_tokens = 512 , temperature = 0 )

> >> print ( tokenizer . decode ( response [ 0 ], skip_special_tokens = True ))Примечание:

文本:xx

【实体抽取】抽取文本中可能存在的实体,并以json{人物/机构/地点:[实体]}格式输出。

文本:xx

【关系抽取】已知关系列表是[注资,拥有,纠纷,自己,增持,重组,买资,签约,持股,交易]。根据关系列表抽取关系三元组,按照json[{'relation':'', 'head':'', 'tail':''}, ]的格式输出。

文本:xx

抽取文本中可能存在的关系,并以json[{'关系':'会见/出席', '头实体':'', '尾实体':''}, ]格式输出。

文本:xx

已知论元角色列表是[时间,地点,会见主体,会见对象],请根据论元角色列表从给定的输入中抽取可能的论元,以json{角色:论元}格式输出。

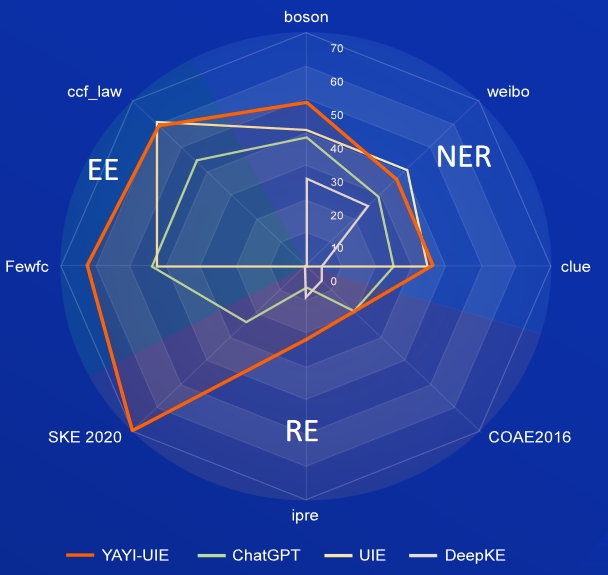

Искусственный интеллект, литература, музыка, политика и наука — это наборы данных на английском языке, а бозон, подсказка и Weibo — это наборы данных на китайском языке.

| Модель | ИИ | Литература | Музыка | Политика | Наука | английский средний | бозон | зацепка | Вейбо | Китайский средний показатель |

|---|---|---|---|---|---|---|---|---|---|---|

| давинчи | 2,97 | 9,87 | 13.83 | 18.42 | 10.04 | 11.03 | - | - | - | 31.09 |

| ЧатGPT 3.5 | 54,4 | 54.07 | 61,24 | 59.12 | 63 | 58,37 | 38,53 | 25.44 | 29,3 | |

| ИЮП | 31.14 | 38,97 | 33,91 | 46,28 | 41,56 | 38,37 | 40,64 | 34,91 | 40,79 | 38,78 |

| УСМ | 28.18 | 56 | 44,93 | 36,1 | 44.09 | 41,86 | - | - | - | - |

| ИнструктироватьUIE | 49 | 47,21 | 53,16 | 48.15 | 49,3 | 49,36 | - | - | - | - |

| ЗнатьLM | 13,76 | 20.18 | 14,78 | 33,86 | 9.19 | 18.35 | 25.96 | 4.44 | 25,2 | 18.53 |

| ЯИ-УИЭ | 52,4 | 45,99 | 51,2 | 51,82 | 50,53 | 50,39 | 49,25 | 36,46 | 36,78 | 40,83 |

FewRe, Wiki-ZSL — наборы данных на английском языке, SKE 2020, COAE2016, IPRE — наборы данных на китайском языке.

| Модель | ФьюРел | Вики-ЗСЛ | английский средний | СКЭ 2020 | COAE2016 | ИПРЕ | Китайский средний показатель |

|---|---|---|---|---|---|---|---|

| ЧатGPT 3.5 | 9,96 | 13.14 | 11,55 24,47 | 19.31 | 6,73 | 16.84 | |

| ZETT(T5-маленький) | 30.53 | 31,74 | 31.14 | - | - | - | - |

| ZETT(Т5-база) | 33,71 | 31.17 | 32.44 | - | - | - | - |

| ИнструктироватьUIE | 39,55 | 35,2 | 37,38 | - | - | - | - |

| ЗнатьLM | 17.46 | 15.33 | 16.40 | 0,4 | 6,56 | 9,75 | 5,57 |

| ЯИ-УИЭ | 36.09 | 41.07 | 38,58 | 70,8 | 19.97 | 22.97 | 37,91 |

сырьевые новости — набор данных на английском языке, FewFC, ccf_law — набор данных на китайском языке

EET (идентификация типа события)

| Модель | сырьевые новости | ФьюФК | ccf_law | Китайский средний показатель |

|---|---|---|---|---|

| ЧатGPT 3.5 | 1.41 | 16.15 | 0 | 8.08 |

| ИЮП | - | 50,23 | 2.16 | 26.20 |

| ИнструктироватьUIE | 23.26 | - | - | - |

| ЯИ-УИЭ | 12.45 | 81,28 | 12.87 | 47.08 |

EEA (извлечение аргументов событий)

| Модель | сырьевые новости | ФьюФК | ccf_law | Китайский средний показатель |

|---|---|---|---|---|

| ЧатGPT 3.5 | 8,6 | 44,4 | 44,57 | 44,49 |

| ИЮП | - | 43.02 | 60,85 | 51,94 |

| ИнструктироватьUIE | 21.78 | - | - | - |

| ЯИ-УИЭ | 19.74 | 63.06 | 59,42 | 61,24 |

Модель SFT, обученная на основе текущих данных и базовых моделей, по-прежнему имеет следующие проблемы с точки зрения эффективности:

Учитывая вышеуказанные ограничения модели, мы требуем, чтобы разработчики использовали наш открытый исходный код, данные, модели и последующие производные, созданные в рамках этого проекта, только в исследовательских целях, а не в коммерческих целях или других целях, которые могут нанести вред обществу. Пожалуйста, будьте осторожны при идентификации и использовании контента, созданного Yayi Big Model, и не распространяйте созданный вредоносный контент в Интернете. В случае возникновения каких-либо неблагоприятных последствий ответственность будет нести коммуникатор. Этот проект можно использовать только в исследовательских целях, и разработчик проекта не несет ответственности за любой вред или убытки, причиненные использованием этого проекта (включая, помимо прочего, данные, модели, коды и т. д.). Пожалуйста, обратитесь к отказу от ответственности для получения подробной информации.

Код и данные в этом проекте имеют открытый исходный код в соответствии с протоколом Apache-2.0. Когда сообщество использует модель YAYI UIE или ее производные, следуйте соглашению сообщества Baichuan2 и коммерческому соглашению.

Если вы используете нашу модель в своей работе, вы можете цитировать нашу статью:

@article{YAYI-UIE,

author = {Xinglin Xiao, Yijie Wang, Nan Xu, Yuqi Wang, Hanxuan Yang, Minzheng Wang, Yin Luo, Lei Wang, Wenji Mao, Dajun Zeng}},

title = {YAYI-UIE: A Chat-Enhanced Instruction Tuning Framework for Universal Information Extraction},

journal = {arXiv preprint arXiv:2312.15548},

url = {https://arxiv.org/abs/2312.15548},

year = {2023}

}