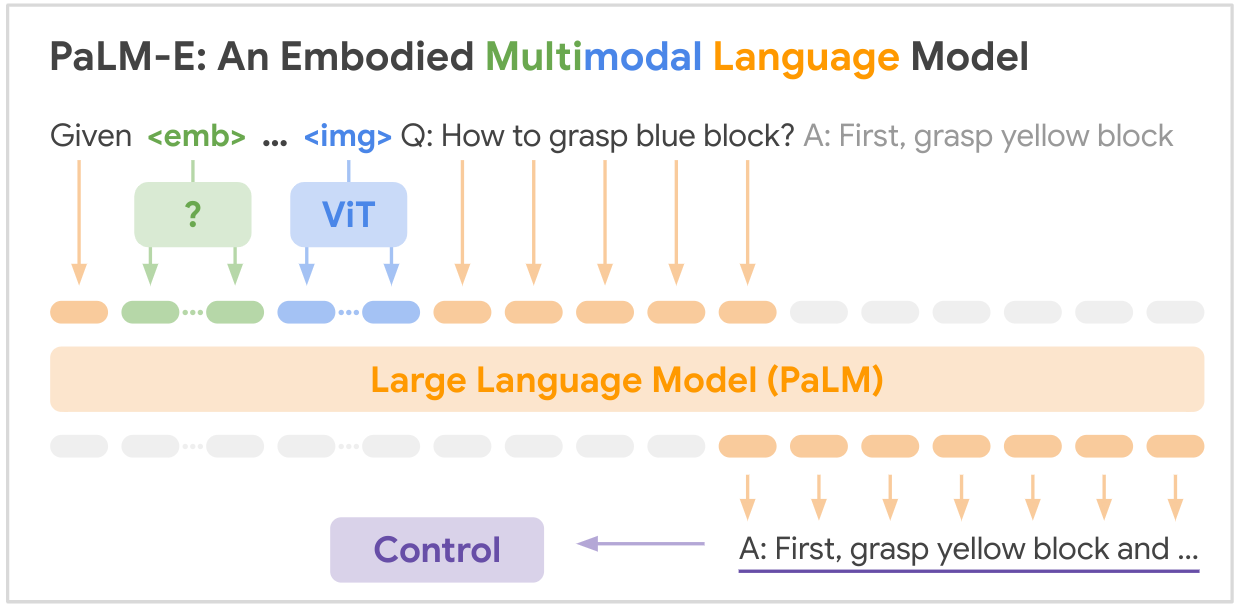

Это реализация с открытым исходным кодом базовой мультимодальной модели SOTA «PALM-E: An Embodied Multimodal Language Model» от Google. PALM-E — это единая большая воплощенная мультимодальная модель, которая может решать множество воплощенных задач рассуждения, от различные способы наблюдения, в нескольких вариантах реализации и, кроме того, демонстрируют положительный перенос: модель выигрывает от разнообразного совместного обучения в областях языка, зрения и визуального языка в масштабе Интернета.

ССЫЛКА НА БУМАГУ: PaLM-E: воплощенная мультимодальная языковая модель

pip install palme import torch

from palme . model import PalmE

#usage

img = torch . randn ( 1 , 3 , 256 , 256 )

caption = torch . randint ( 0 , 20000 , ( 1 , 1024 ))

model = PalmE ()

output = model ( img , caption )

print ( output . shape ) # (1, 1024, 20000)

Вот сводная таблица ключевых наборов данных, упомянутых в документе:

| Набор данных | Задачи | Размер | Связь |

|---|---|---|---|

| ТАМП | Планирование роботизированных манипуляций, VQA | 96 000 сцен | Пользовательский набор данных |

| Языковая таблица | Планирование роботизированных манипуляций | Пользовательский набор данных | Связь |

| Мобильная манипуляция | Роботизированная навигация и планирование манипуляций, VQA | 2912 последовательностей | На основе набора данных SayCan |

| ВебЛИ | Извлечение изображения и текста | 66 миллионов пар изображений и подписей | Связь |

| VQAv2 | Визуальный ответ на вопрос | 1,1 млн вопросов по изображениям COCO | Связь |

| ОК-VQA | Визуальный ответ на вопрос, требующий внешних знаний | 14 031 вопрос по изображениям COCO | Связь |

| КОКО | Подпись к изображению | 330 тыс. изображений с подписями | Связь |

| Википедия | Текстовый корпус | Н/Д | Связь |

Ключевые наборы данных по робототехнике были собраны специально для этой работы, в то время как более крупные наборы данных на языке видения (WebLI, VQAv2, OK-VQA, COCO) являются стандартными эталонами в этой области. Наборы данных варьируются от десятков тысяч примеров для областей робототехники до десятков миллионов данных на языке видения в масштабе Интернета.

Ваш блеск необходим! Присоединяйтесь к нам, и вместе сделаем PALM-E еще более впечатляющим:

? Исправления, ? улучшения, документы или идеи – все приветствуются! Давайте рука об руку формировать будущее искусственного интеллекта.

@article{driess2023palme,

title={PALM-E: An Embodied Multimodal Language Model},

author={Driess, Danny and Xia, Fei and Sajjadi, Mehdi S. M. and Lynch, Corey and Chowdhery, Aakanksha and Ichter, Brian and Wahid, Ayzaan and Tompson, Jonathan and Vuong, Quan and Yu, Tianhe and Huang, Wenlong and Chebotar, Yevgen and Sermanet, Pierre and Duckworth, Daniel and Levine, Sergey and Vanhoucke, Vincent and Hausman, Karol and Toussaint, Marc and Greff, Klaus and Zeng, Andy and Mordatch, Igor and Florence, Pete},

journal={arXiv preprint arXiv:2303.03378},

year={2023},

url={https://doi.org/10.48550/arXiv.2303.03378}

}