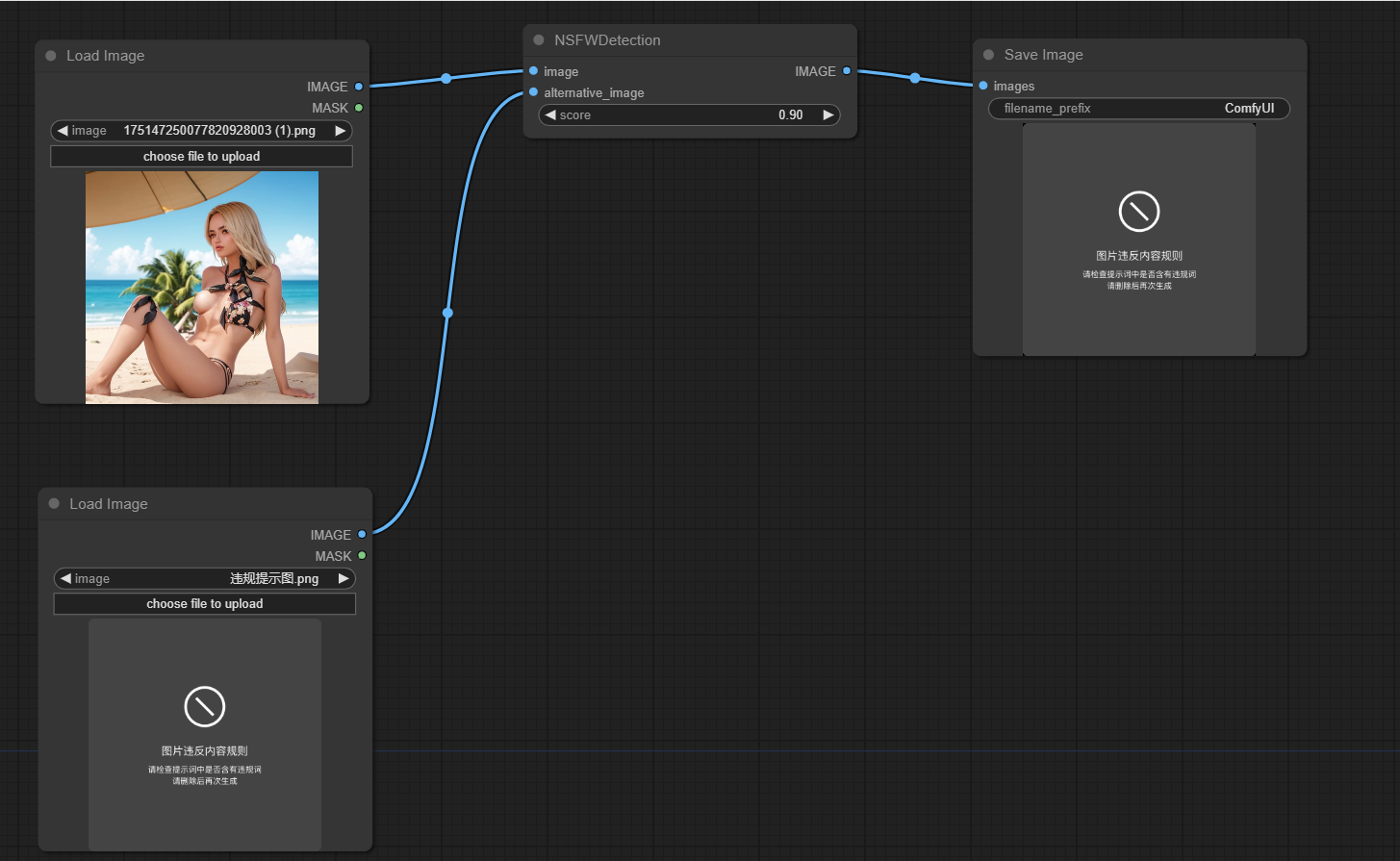

Этот проект предназначен для определения того, не являются ли изображения, сгенерированные Comfyui, небезопасно для работы (NSFW). Он использует модель машинного обучения для классификации изображений как безопасных или не безопасных для работы. Если изображение классифицируется как NSFW, возвращается альтернативное изображение.

Клонировать это репо в каталог custom_nodes

Запустить PIP Install -R TEDS.TXT

Основная функциональность проекта инкапсулируется в классе NSFWDetection в файле node.py У этого класса есть метод run , который принимает три параметра:

image : изображение, которое нужно классифицировать.score : пороговый счет для классификации изображения как NSFW.alternative_image : изображение, которое нужно возвращать, если входное изображение классифицируется как NSFW.

https://github.com/trumanwong/comfyui-nsfw-detection/blob/main/workflow.json

Взносы приветствуются. Пожалуйста, отправьте запрос на привлечение, если у вас есть какие -либо улучшения или исправления ошибок.

Этот проект лицензирован в соответствии с условиями лицензии MIT.