llm-gateway -это шлюз для сторонних поставщиков LLM, таких как OpenAI, COUER, и т. Д. Он отслеживает данные, отправляемые и полученные от этих поставщиков в базе данных PostGRES, и запускает эвристику PII до отправки.

В соответствии с политикой данных об использовании данных потребительских продуктов OpenAI они «могут использовать контент, такой как подсказки, ответы, загруженные изображения и сгенерированные изображения для улучшения наших услуг» для улучшения таких продуктов, как CHATGPT и DALL-E.

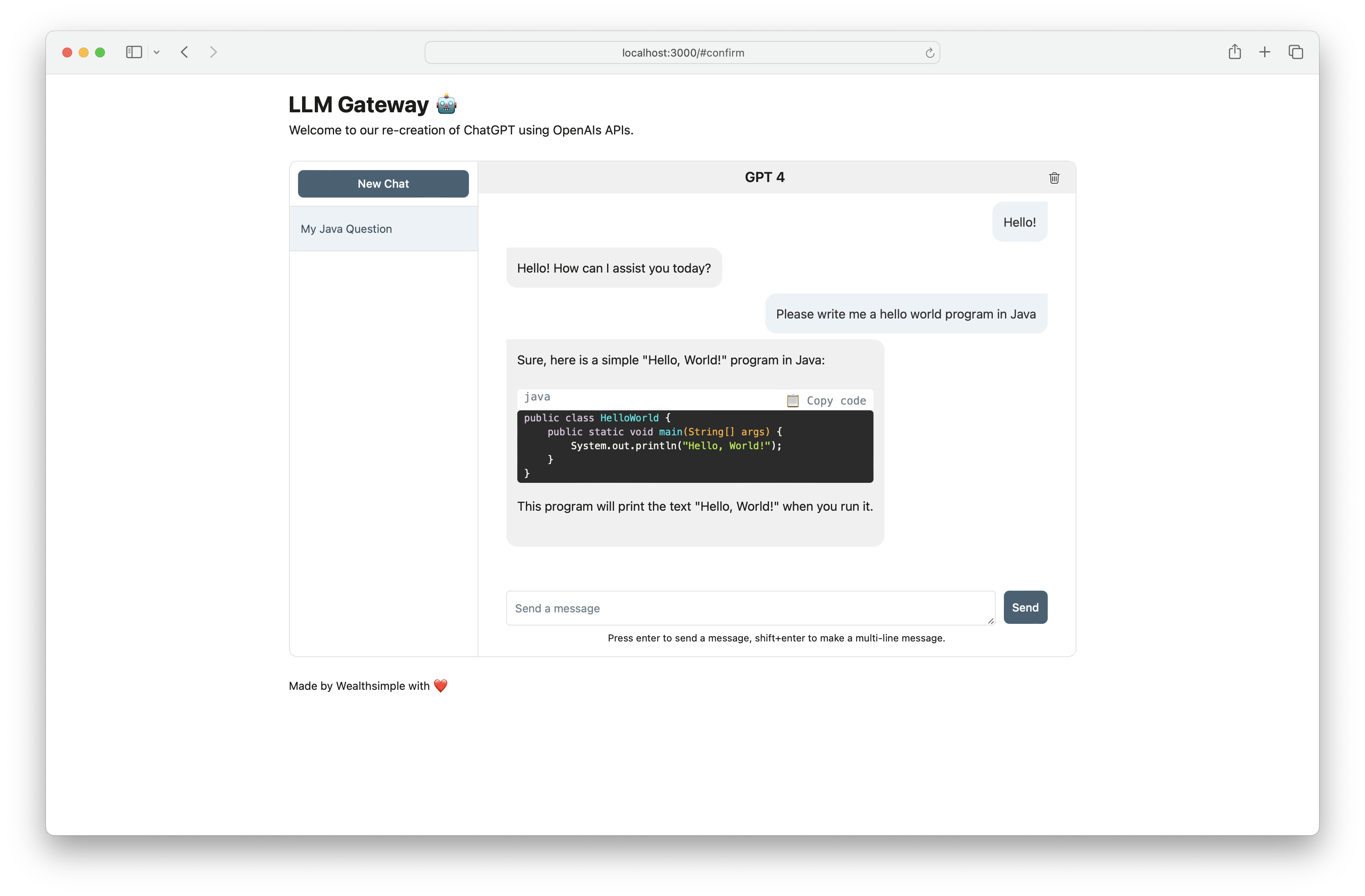

Используйте llm-gateway для безопасного взаимодействия с OpenAI. Ворота также воссоздает фронт Chatgpt, используя конечную точку Openai /ChatCompletion чтобы сохранить все общение в API.

| Поставщик | Модель |

|---|---|

| Openai | GPT 3.5 Turbo |

| Openai | GPT 3.5 Turbo 16K |

| Openai | GPT 4 |

| AI21 Лаборатории | Jurassic-2 Ultra |

| AI21 Лаборатории | Jurassic-2 Mid |

| Амазонка | Titan Text Lite |

| Амазонка | Titan Text Express |

| Амазонка | Текст Титана встраивания |

| Антроп | Клод 2.1 |

| Антроп | Клод 2.0 |

| Антроп | Клод 1.3 |

| Антроп | Клод Мгновенный |

| Кожух | Командование |

| Кожух | Командный свет |

| Кожух | Встроенный - английский |

| Кожух | Встроенный - многоязычный |

| Мета | Лама-2-13B-чат |

| Мета | Лама-2-70B-чат |

Ключ API поставщика должен быть сохранен в качестве переменной среды (см. Настройку дальнейшего вниз). Если вы общаетесь с OpenAI, установите OPENAI_API_KEY .

Для пошаговых инструкций настройки с Cohere, OpenAI и AWS Bedrock нажмите здесь.

[Openai] Пример скручивания в /completion конечной точки:

curl -X 'POST'

'http://<host>/api/openai/completion'

-H 'accept: application/json'

-H 'Content-Type: application/json'

-d '{

"temperature": 0,

"prompt": "Tell me what is the meaning of life",

"max_tokens": 50,

"model": "text-davinci-003"

}'

[Openai] При использовании конечной точки /chat_completion сформируйтесь как разговор между пользователем и помощником.

curl -X 'POST'

'http://<host>/api/openai/chat_completion'

-H 'accept: application/json'

-H 'Content-Type: application/json'

-d '{

"messages": [

{"role": "assistant", "content": "You are an intelligent assistant."},

{"role": "user", "content": "create a healthy recipe"}

],

"model": "gpt-3.5-turbo",

"temperature": 0

}'

from llm_gateway . providers . openai import OpenAIWrapper

wrapper = OpenAIWrapper ()

wrapper . send_openai_request (

"Completion" ,

"create" ,

max_tokens = 100 ,

prompt = "What is the meaning of life?" ,

temperature = 0 ,

model = "text-davinci-003" ,

)В этом проекте используется поэзия, Pyenv для зависимости и управления окружающей средой. Ознакомьтесь с официальной установкой документации по поэзии и Pyenv, чтобы начать работу. Для фронтальной части этот проект использует NPM и пряжу для управления зависимостями. Самая современная версия узла, необходимая для этого проекта, объявлена в.

Если использовать Docker, шаги 1-3 являются необязательными. Мы рекомендуем установить крючки перед наборами, чтобы ускорить цикл разработки.

pyenv install 3.11.3 brew install gitleaks

poetry install

poetry run pre-commit install

cp .envrc.example .envrc и обновление с секретами APIБежать в Docker:

# spin up docker-compose

make up

# open frontend in browser

make browse

# open FastAPI Swagger API

make browse-api

# delete docker-compose setup

make down