Создайте игры и программы с использованием агентов OpenAI. Построен на вершине Microsoft Autogen.

️ Работа в процессе

Текущий код работает, но:

- Есть и будут нарушать изменения:

- Всегда проверяйте, что ваш скрытый файл

.env.jsoncсоответствует последней структуреenv.sample.jsonc.- Всегда обновляйте свои зависимости с помощью

poetry install.- Многие вещи должны быть оптимизированы, чтобы резко уменьшить использование токенов: кэширование, пошаговый процесс, разделение разговоров, лучшие подсказки.

- Код нуждается в некоторой очистке.

- Microsoft Autogen все еще находится на ранней стадии и содержит несколько ошибок.

- Многие твердые вещи могут быть настраиваемыми через файлы конфигурации.

- Сначала я сосредоточусь только на нескольких языках программирования.

Есть несколько удивительных проектов, которые делают подобные вещи, но я надеюсь найти способ решить амбициозное генерацию программ.

Вам либо нужен ключ API OpenAI, либо Azure OpenAI API -ключ.

Не полагайтесь на GPT-3.5 , будь то turbo или стандарт, для не только программ «выборки». Если вы стремитесь к более сложным приложениям, GPT-4 является обязательным, предпочтительно даже GPT-4-32k .

Использование API OpenAI может быстро исчерпать ваш токен. Для более обширных проектов рекомендуется Azure OpenAI API.

Будьте внимательны к затратам, если у вас есть амбициозные цели! Всегда следите за использованием токенов и то, что делают ваши агенты. Хотя ИИ может быть мощным инструментом, он не обязательно дешевле, чем наем реальных разработчиков - еще?

conda create -n autogen python=3.10

conda activate autogen

pip install poetry

poetry install

cp env.sample.jsonc env.jsonc Отредактируйте свой env.json , чтобы добавить свои клавиши API и настроить установку.

Только:

make run OADS автоматически генерирует исходный код программы в каталоге ./project .

Вы можете очистить его через:

make cleanВажно: функции не будут работать.

Из того, что я проверил, Autogen, кажется, работает с любым LLM с открытым исходным кодом, поддерживаемым веб -интерфейсом Text Generation Web.

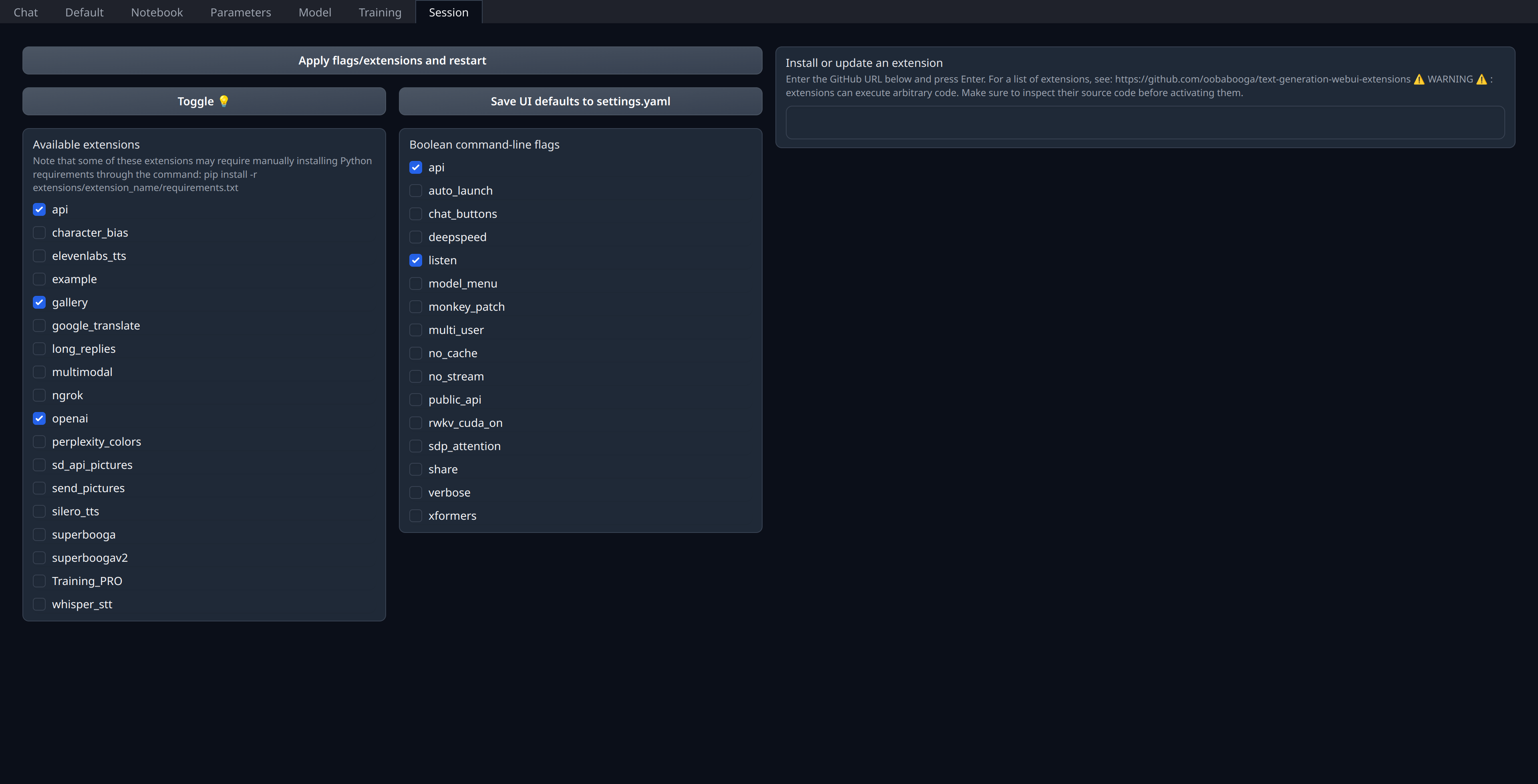

Вам просто нужно включить расширение openai на вкладке «Session» в веб -интерфейсе:

Убедитесь, что ваш порт 5001 открыт или Bend, если это удаленный сервер, так как именно здесь будет выявлен API, подобный Openai.

Я лично использую свои текущие модели на Runpod (не аффилирован) и использую thebloke/cuda11.8.0-ubuntu22.04-oneclick:latest изображение, хотя я думаю, что это кажется немного устаревшим в отношении Llama.cpp & Co.

"models" : [

// Custom deployment of (for example) `Open-Orca/Mistral-7B-OpenOrca`

// using "Text generation web UI" with `OpenAI` extension enabled:

// https://github.com/oobabooga/text-generation-webui/tree/main/extensions/openai#an-openedai-api-openai-like

// This can be any inference endpoint compatible following OpenAI API specs,

// regardless of the model you use behind it.

{

"model" : "Open-Orca/LlongOrca-13B-16k" ,

"api_base" : "http://localhost:5001" , // Or your remote server URL

"api_key" : "sk-111111111111111111111111111111111111111111111111" ,

"api_type" : "open_ai"

}

] ,