รับความช่วยเหลือ - เว็บไซต์คำถามที่พบบ่อย การสนทนา เอกสารความไม่ลงรอยกัน

แผนงานโมเดล Quickstart ? สาธิต ? นักสำรวจ ? ตัวอย่าง

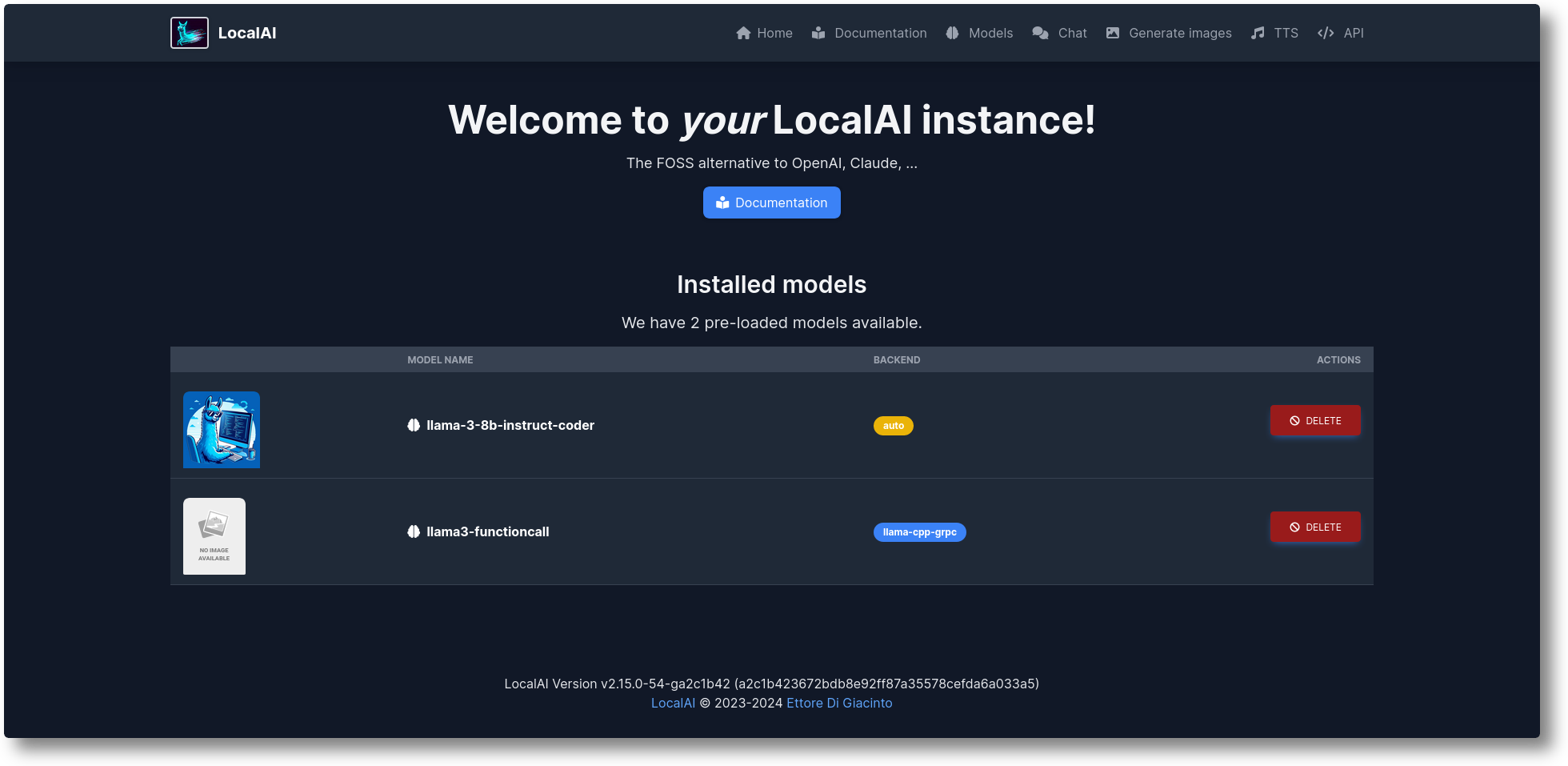

LocalAI เป็นทางเลือก OpenAI แบบโอเพ่นซอร์สฟรี LocalAI ทำหน้าที่เป็น REST API ทดแทนแบบดรอปอินที่เข้ากันได้กับข้อกำหนด API ของ OpenAI (Elevenlabs, Anthropic... ) สำหรับการอนุมาน AI ในพื้นที่ ช่วยให้คุณสามารถเรียกใช้ LLM สร้างภาพ เสียง (และไม่เพียงแต่) ภายในหรือภายในองค์กรด้วยฮาร์ดแวร์ระดับผู้บริโภค ซึ่งรองรับตระกูลโมเดลหลายตระกูล ไม่ต้องใช้ GPU สร้างและดูแลโดย Ettore Di Giacinto

รันสคริปต์การติดตั้ง:

ขด https://localai.io/install.sh | ซ

หรือรันด้วยนักเทียบท่า:

docker run -ti --name local-ai -p 8080:8080 localai/localai:latest-aio-cpu# รูปภาพทางเลือก:# - หากคุณมี Nvidia GPU:# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest-aio-gpu-nvidia-cuda-12# - ไม่มีโมเดลที่กำหนดค่าไว้ล่วงหน้า# docker run -ti --name local-ai -p 8080:8080 localai/localai:latest# - ไม่มีโมเดลที่กำหนดค่าไว้ล่วงหน้าสำหรับ Nvidia GPUs# docker run -ti --name local-ai -p 8080:8080 --gpus all localai/localai:latest- gpu-nvidia-cuda-12

วิธีโหลดโมเดล:

# จากแกลเลอรีโมเดล (ดูโมเดลที่มีพร้อม `รายการโมเดล local-ai` ใน WebUI จากแท็บโมเดล หรือไปที่ https://models.localai.io)local-ai รัน llama-3.2-1b-instruct: q4_k_m# เริ่ม LocalAI ด้วยโมเดล phi-2 โดยตรงจาก Huggingfacelocal-ai run Huggingface://TheBloke/phi-2-GGUF/phi-2.Q8_0.gguf# ติดตั้งและ รันโมเดลจาก Ollama OCI registerlocal-ai run ollama://gemma:2b# รันโมเดลจากการกำหนดค่า filelocal-ai run https://gist.githubusercontent.com/.../phi-2.yaml# ติดตั้ง และรันโมเดลจากรีจิสทรี OCI มาตรฐาน (เช่น Docker Hub)local-ai run oci://localai/phi-2:latest

เริ่มต้นใช้งาน

ต.ค. 2024: ตัวอย่างย้ายไปที่ LocalAI-examples

ส.ค. 2567: ? FLUX-1, P2P Explorer

กรกฎาคม 2567: ? แดชบอร์ด P2P, โหมด LocalAI Federated และ AI Swarms: #2723

มิถุนายน 2567: ? คุณสามารถเรียกดูแกลเลอรีโมเดลได้โดยไม่ต้องใช้ LocalAI! ตรวจสอบ https://models.localai.io

มิถุนายน 2024: รองรับรุ่นจากการลงทะเบียน OCI: #2628

พฤษภาคม 2024: P2P แบบกระจายอำนาจ llama.cpp: #2343 (peer2peer llama.cpp!) เอกสาร https://localai.io/features/distribute/

พฤษภาคม 2024: Openvoice: #2334

พฤษภาคม 2567: ? การเรียกใช้ฟังก์ชันโดยไม่มีไวยากรณ์และโหมดผสม: #2328

พฤษภาคม 2024: การอนุมานแบบกระจาย: #2324

พฤษภาคม 2024: การสร้าง Chat, TTS และรูปภาพใน WebUI: #2222

เมษายน 2024: Reranker API: #2121

รายการแผนงาน: รายการปัญหา

มัลติโมดัลที่มีความเข้าใจ vLLM และวิดีโอ: #3729

API เรียลไทม์ #3714

พูลชุมชน P2P Global แบบกระจาย: #3113

การปรับปรุง WebUI: #2156

แบ็กเอนด์ v2: #1126

การปรับปรุง UX v2: #1373

ผู้ช่วย API: #1273

จุดสิ้นสุดการกลั่นกรอง: #999

วัลแคน: #1647

API มานุษยวิทยา: #1808

หากคุณต้องการช่วยเหลือและมีส่วนร่วม ให้รีบคว้า: https://github.com/mudler/LocalAI/issues?q=is%3Aissue+is%3Aopen+label%3A%22up+for+grabs%22

การสร้างข้อความด้วย GPT ( llama.cpp , gpt4all.cpp , ... และอื่น ๆ )

ข้อความเป็นเสียง

เสียงเป็นข้อความ (การถอดเสียงด้วย whisper.cpp )

การสร้างภาพที่มีการแพร่กระจายที่เสถียร

API เครื่องมือที่เหมือนกันของ OpenAI

การสร้างการฝังสำหรับฐานข้อมูลเวกเตอร์

ไวยากรณ์ที่มีข้อจำกัด

ดาวน์โหลดโมเดลได้โดยตรงจาก Huggingface

วิชั่น API

API การจัดอันดับใหม่

การอนุมานแบบ P2P

WebUI แบบบูรณาการ!

ตรวจสอบส่วนการเริ่มต้นใช้งานในเอกสารของเรา

สร้างและปรับใช้คอนเทนเนอร์แบบกำหนดเอง:

https://github.com/sozercan/aikit

WebUI:

https://github.com/Jirubizu/localai-admin

https://github.com/go-skynet/LocalAI-frontend

QA-Pilot (โครงการแชทแบบโต้ตอบที่ใช้ประโยชน์จาก LocalAI LLM เพื่อความเข้าใจอย่างรวดเร็วและการนำทางของที่เก็บโค้ด GitHub) https://github.com/reid41/QA-Pilot

แกลเลอรี่โมเดล

https://github.com/go-skynet/model-gallery

อื่น:

แผนภูมิ Helm https://github.com/go-skynet/helm-charts

ส่วนขยาย VSCode https://github.com/badgooooor/localai-vscode-plugin

ยูทิลิตี้เทอร์มินัล https://github.com/djcopley/ShellOracle

ผู้ช่วยอัจฉริยะท้องถิ่น https://github.com/mudler/LocalAGI

ผู้ช่วยประจำบ้าน https://github.com/sammcj/homeassistant-localai / https://github.com/drndos/hass-openai-custom-conversation / https://github.com/valentinfrlch/ha-gpt4vision

บอท Discord https://github.com/mudler/LocalAGI/tree/main/examples/discord

บอทหย่อน https://github.com/mudler/LocalAGI/tree/main/examples/slack

Shell-Pilot (โต้ตอบกับ LLM โดยใช้โมเดล LocalAI ผ่านเชลล์สคริปต์ล้วนๆ บนระบบ Linux หรือ MacOS ของคุณ) https://github.com/reid41/shell-pilot

บอทโทรเลข https://github.com/mudler/LocalAI/tree/master/examples/telegram-bot

การดำเนินการ Github: https://github.com/marketplace/actions/start-localai

ตัวอย่าง: https://github.com/mudler/LocalAI/tree/master/examples/

คู่มือการปรับแต่ง LLM

วิธีการสร้างในท้องถิ่น

วิธีการติดตั้งใน Kubernetes

โครงการที่รวม LocalAI

ส่วนวิธีการ (ดูแลจัดการโดยชุมชนของเรา)

เรียกใช้โค้ด Visual Studio ด้วย LocalAI (SUSE)

เรียกใช้ LocalAI บน Jetson Nano Devkit

เรียกใช้ LocalAI บน AWS EKS ด้วย Pulumi

เรียกใช้ LocalAI บน AWS

สร้าง slackbot สำหรับทีมและโปรเจ็กต์ OSS ที่ตอบเอกสารประกอบ

LocalAI พบกับ k8sgpt

การตอบคำถามในเอกสารในเครื่องด้วย LangChain, LocalAI, Chroma และ GPT4All

บทช่วยสอนการใช้ k8sgpt กับ LocalAI

หากคุณใช้พื้นที่เก็บข้อมูลนี้ ข้อมูลในโครงการดาวน์สตรีม โปรดพิจารณาอ้างอิงด้วย:

@misc{localai,

author = {Ettore Di Giacinto},

title = {LocalAI: The free, Open source OpenAI alternative},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/go-skynet/LocalAI}},คุณพบว่า LocalAI มีประโยชน์หรือไม่

สนับสนุนโครงการโดยการเป็นผู้สนับสนุนหรือผู้สนับสนุน โลโก้ของคุณจะแสดงที่นี่พร้อมลิงก์ไปยังเว็บไซต์ของคุณ

ขอขอบคุณผู้สนับสนุนใจดีของเราที่สนับสนุนโครงการนี้ซึ่งครอบคลุมค่าใช้จ่าย CI และรายชื่อผู้สนับสนุนของเรา:

LocalAI เป็นโครงการที่ขับเคลื่อนโดยชุมชนที่สร้างโดย Ettore Di Giacinto

MIT - ผู้แต่ง Ettore Di Giacinto [email protected]

LocalAI ไม่สามารถถูกสร้างขึ้นได้หากไม่ได้รับความช่วยเหลือจากซอฟต์แวร์ที่ยอดเยี่ยมที่มีอยู่แล้วจากชุมชน ขอบคุณ!

llama.cpp

https://github.com/tatsu-lab/stanford_alpaca

https://github.com/cornelk/llama-go สำหรับแนวคิดเบื้องต้น

https://github.com/antimatter15/alpaca.cpp

https://github.com/EdVince/Stable-Diffusion-NCNN

https://github.com/ggerganov/whisper.cpp

https://github.com/saharNooby/rwkv.cpp

https://github.com/rhasspy/piper

นี่เป็นโครงการเพื่อชุมชน ขอขอบคุณเป็นพิเศษสำหรับผู้มีส่วนร่วมของเรา! -