ฮยอนจิน นัม* 1 , แดเนียล ซองโฮ จุง* 1 , กยองซิก มูน 2 , คยอง มู ลี 1

![]()

![]()

1 มหาวิทยาลัยแห่งชาติโซล , 2 Codec Avatars Lab, Meta

(*ผลงานที่เท่าเทียมกัน)

CONTHO ร่วมกันสร้าง มนุษย์และวัตถุ 3 มิติ ขึ้นใหม่โดยใช้ประโยชน์จากการสัมผัสระหว่างมนุษย์กับวัตถุเป็นสัญญาณสำคัญในการสร้างใหม่ที่แม่นยำ ด้วยเหตุนี้ เราจึงผสมผสาน "การสร้างวัตถุมนุษย์และวัตถุสามมิติขึ้นใหม่" และ "การประมาณค่าการสัมผัสระหว่างมนุษย์กับวัตถุ" ซึ่งเป็นงานที่แตกต่างกันสองงานที่ได้รับการศึกษาแยกกันในสองเส้นทาง ด้วยกรอบงานที่เป็นหนึ่งเดียว

เราขอแนะนำให้คุณใช้สภาพแวดล้อมเสมือนของ Anaconda ติดตั้ง PyTorch >=1.10.1 และ Python >= 3.7.0 CONTHO รุ่นล่าสุดของเราได้รับการทดสอบบน Python 3.9.13, PyTorch 1.10.1, CUDA 10.2

ตั้งค่าสภาพแวดล้อม

# Initialize conda environment conda create -n contho python=3.9 conda activate contho # Install PyTorch conda install pytorch==1.10.1 torchvision==0.11.2 torchaudio==0.10.1 cudatoolkit=10.2 -c pytorch # Install all remaining packages pip install -r requirements.txt

เตรียม base_data จาก Google Drive หรือ Onedrive และวางไว้เป็น ${ROOT}/data/base_data

ดาวน์โหลดจุดตรวจสอบที่ได้รับการฝึกอบรมล่วงหน้าจาก Google Drive หรือ OneDrive

สุดท้ายนี้ขอวิ่ง

python main/demo.py --gpu 0 --checkpoint {CKPT_PATH} คุณต้องปฏิบัติตามโครงสร้างไดเร็กทอรีของ data ดังต่อไปนี้

${ROOT}

|-- data

| |-- base_data

| | |-- annotations

| | |-- backbone_models

| | |-- human_models

| | |-- object_models

| |-- BEHAVE

| | |-- dataset.py

| | |-- sequences

| | | |-- Date01_Sub01_backpack_back

| | | |-- Date01_Sub01_backpack_hand

| | | |-- ...

| | | |-- Date07_Sub08_yogamat

| |-- InterCap

| | |-- dataset.py

| | |-- sequences

| | | |-- 01

| | | |-- 02

| | | |-- ...

| | | |-- 10 ดาวน์โหลดลำดับ Data01~Data07 จากชุดข้อมูล BEHAVE ไปที่ ${ROOT}/data/BEHAVE/sequences

(ตัวเลือกที่ 1) ดาวน์โหลดชุดข้อมูล BEHAVE โดยตรงจากหน้าดาวน์โหลด

(ตัวเลือกที่ 2) เรียกใช้สคริปต์ด้านล่าง

scripts/download_behave.sh

ดาวน์โหลด RGBD_Images.zip และ Res.zip จากชุดข้อมูล InterCap ไปที่ ${ROOT}/data/InterCap/sequences

(ตัวเลือกที่ 1) ดาวน์โหลดชุดข้อมูล InterCap โดยตรงจากหน้าดาวน์โหลด

(ตัวเลือกที่ 2) เรียกใช้สคริปต์ด้านล่าง

scripts/download_intercap.sh

ดาวน์โหลด base_data จาก Google Drive หรือ Onedrive

(ไม่บังคับ) ดาวน์โหลดจุดตรวจสอบที่เผยแพร่สำหรับชุดข้อมูล BEHAVE (Google Drive | OneDrive) และ InterCap (Google Drive | OneDrive)

หากต้องการฝึก CONTHO บนชุดข้อมูล BEHAVE หรือ InterCap โปรดเรียกใช้

python main/train.py --gpu 0 --dataset {DATASET}หากต้องการประเมิน CONTHO บนชุดข้อมูล BEHAVE หรือ InterCap โปรดเรียกใช้

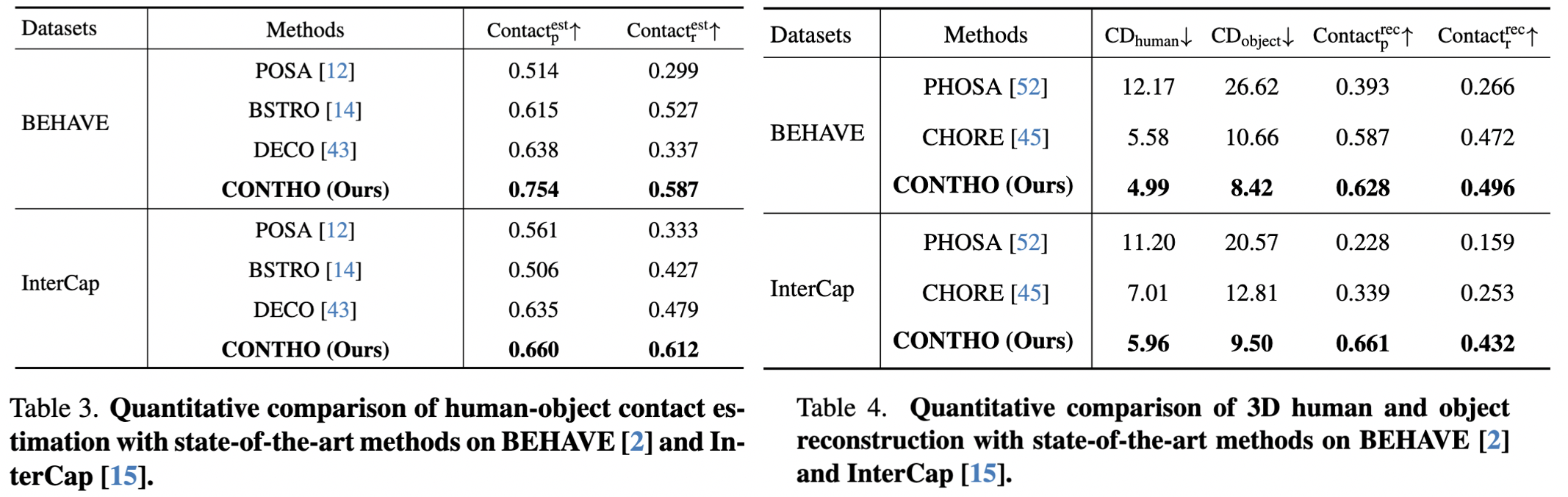

python main/test.py --gpu 0 --dataset {DATASET} --checkpoint {CKPT_PATH} ที่นี่ เรารายงานประสิทธิภาพของ CONTHO

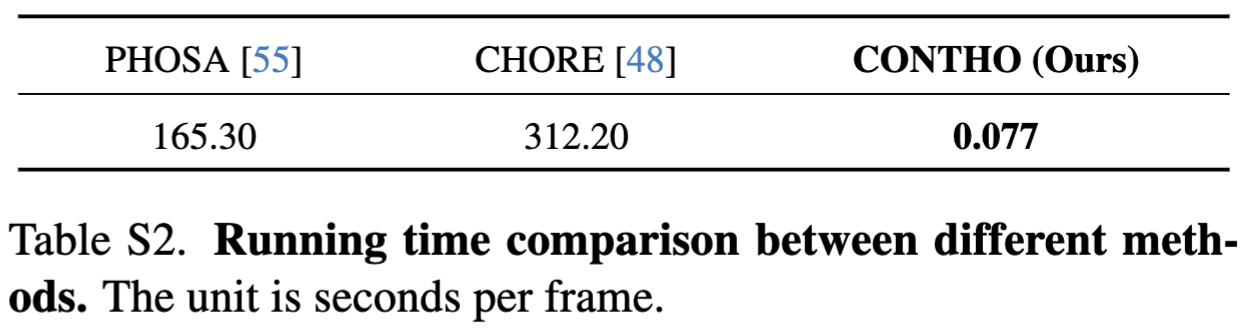

CONTHO เป็นเฟรมเวิร์กการสร้างมนุษย์และวัตถุ 3 มิติ ที่รวดเร็ว และ แม่นยำ !

RuntimeError: ไม่รองรับการลบ ตัวดำเนินการ - ที่มีบูลเทนเซอร์ หากคุณกำลังพยายามกลับด้านมาสก์ ให้ใช้โอเปอเรเตอร์ ~ หรือ logical_not() แทน: โปรดตรวจสอบข้อมูลอ้างอิง

bash: scripts/download_behave.sh: การอนุญาตถูกปฏิเสธ: โปรดตรวจสอบข้อมูลอ้างอิง

เราขอขอบคุณ:

Hand4Whole สำหรับการสร้างตาข่ายมนุษย์ 3 มิติขึ้นมาใหม่

CHORE สำหรับการฝึกอบรมและการทดสอบเกี่ยวกับ BEHAVE

InterCap สำหรับดาวน์โหลดสคริปต์ของชุดข้อมูล

DECO สำหรับการตั้งค่าการทดลองในป่า

@inproceedings{nam2024contho,

title = {Joint Reconstruction of 3D Human and Object via Contact-Based Refinement Transformer},

author = {Nam, Hyeongjin and Jung, Daniel Sungho and Moon, Gyeongsik and Lee, Kyoung Mu},

booktitle = {Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition},

year = {2024}

}