ผู้เขียน:

ซาช่า เคียร์ช, วาเลเรีย โอลิวนินา, ยาน ออนเดรจ, ราฟาเอล ปาเจส, แซร์คิโอ มาร์ติน และคลารา เปเรซ-โมลินา

[ Paper ] [ BibTex ]

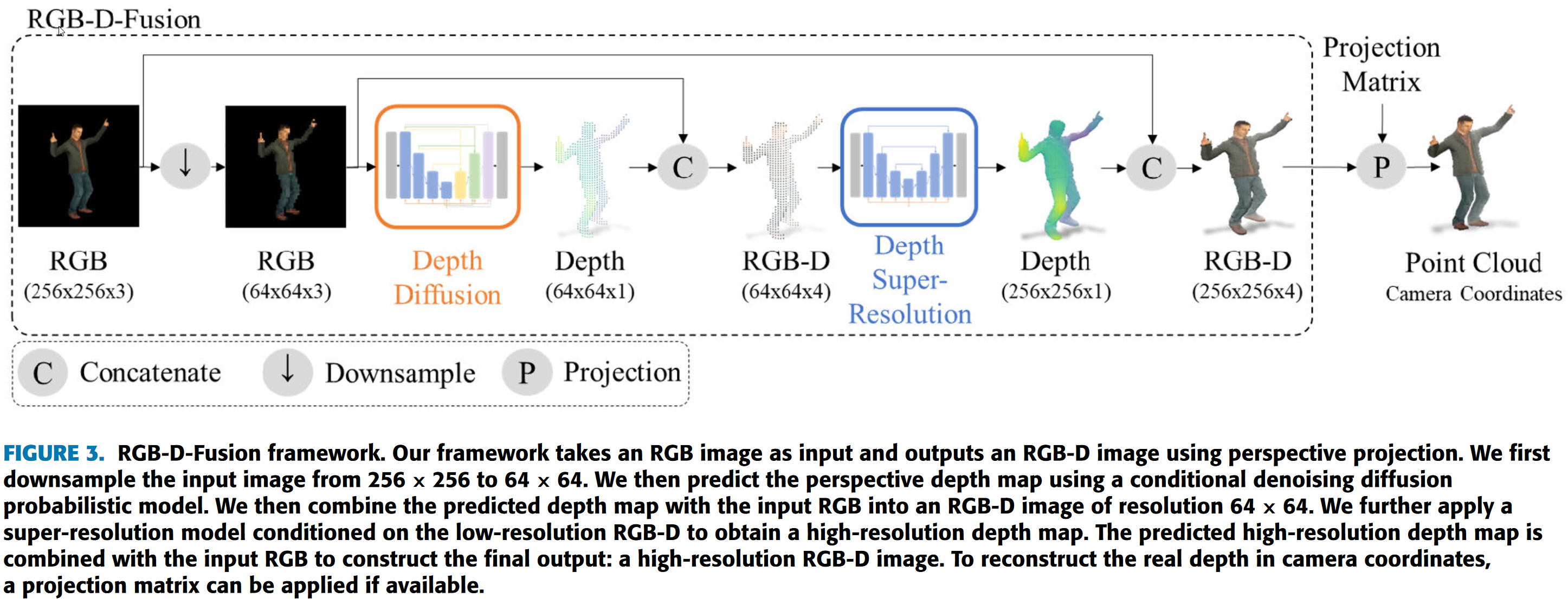

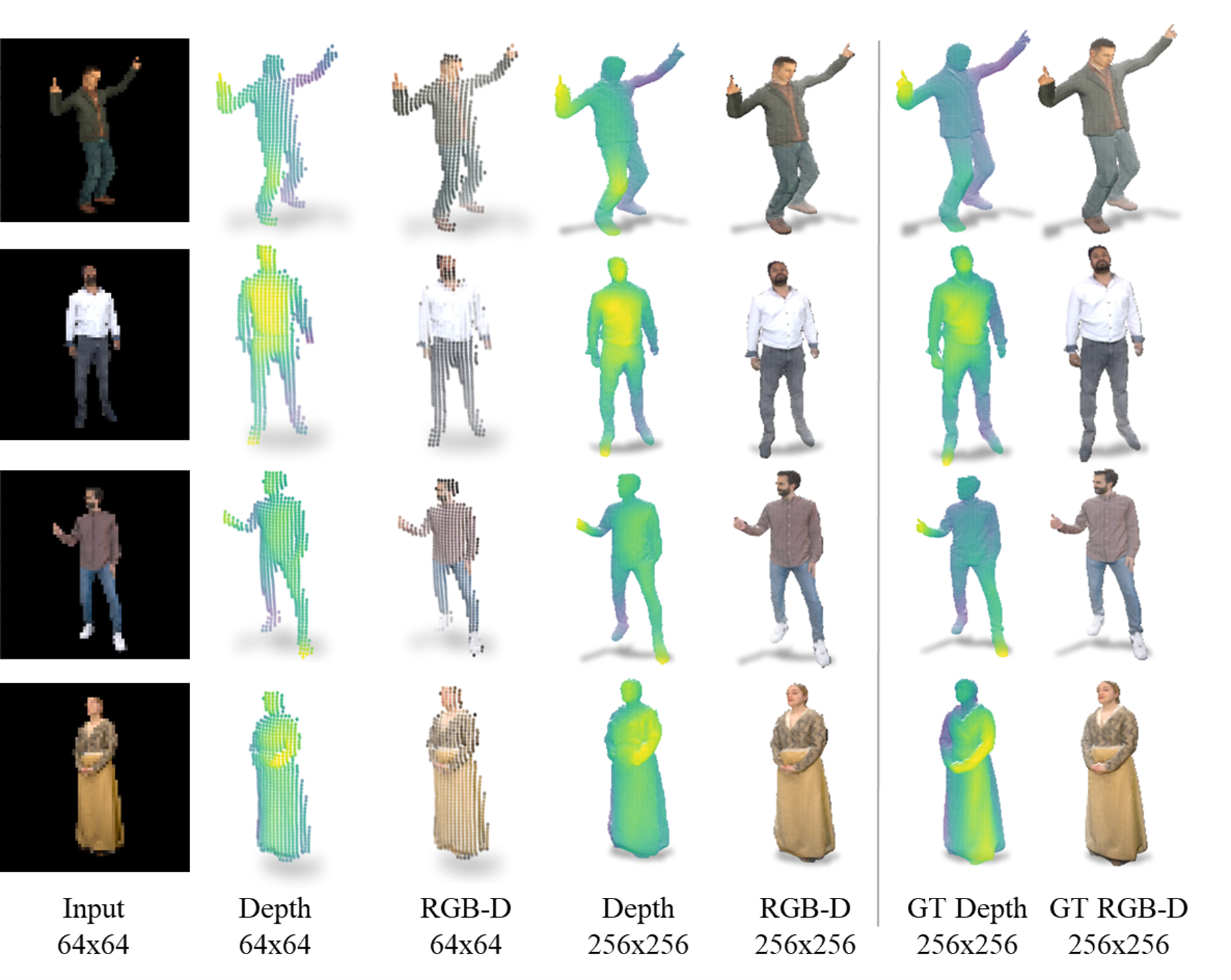

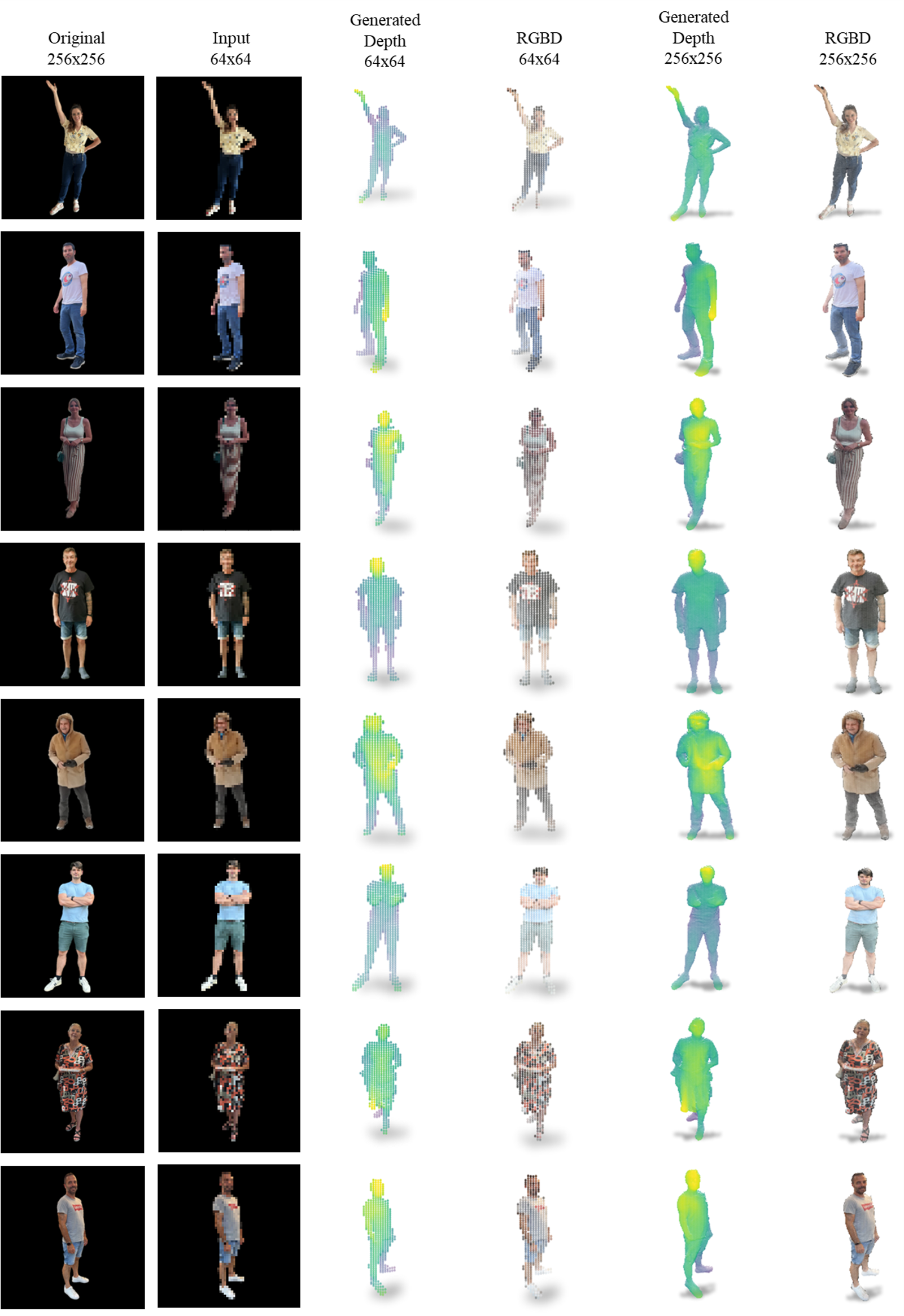

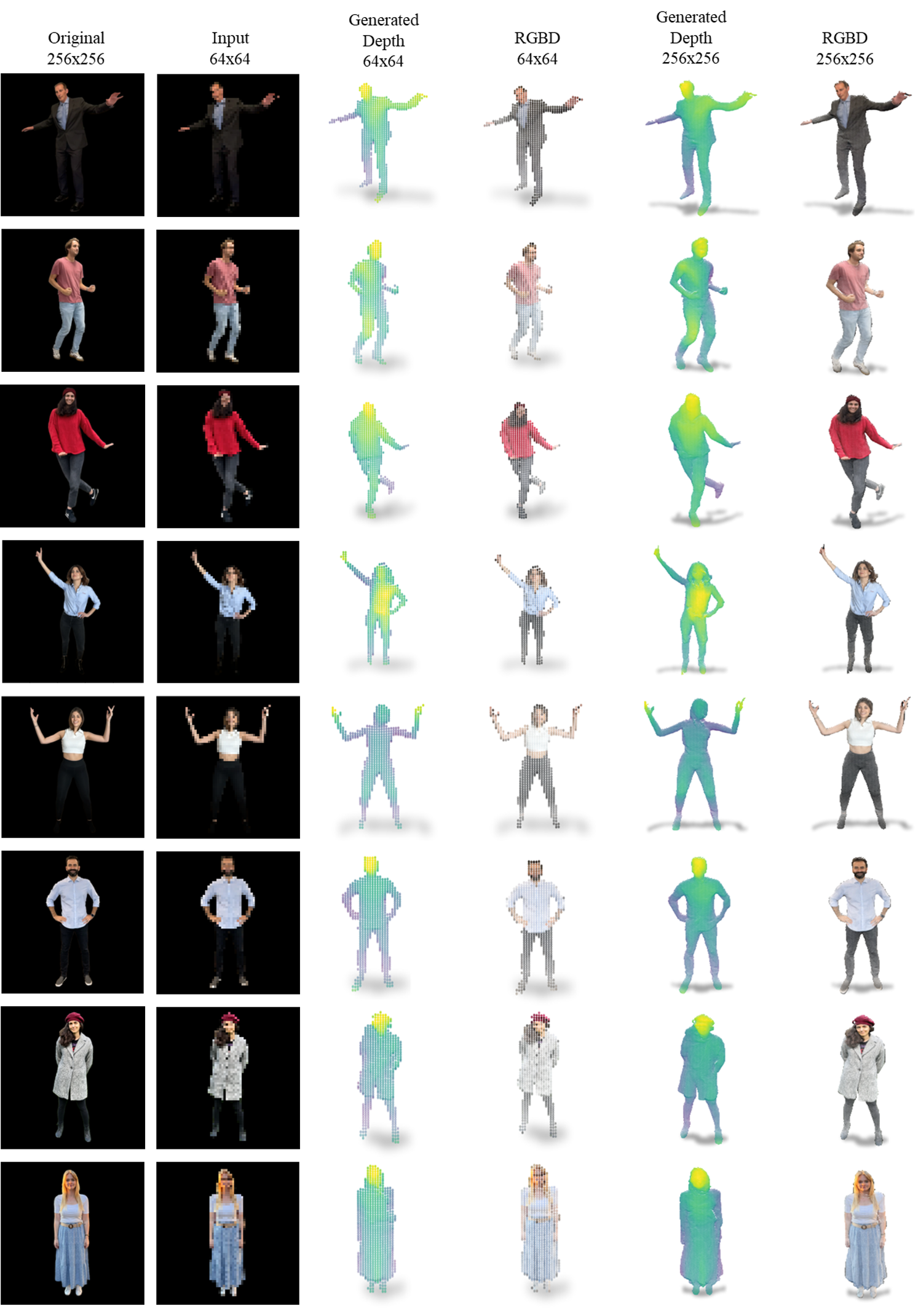

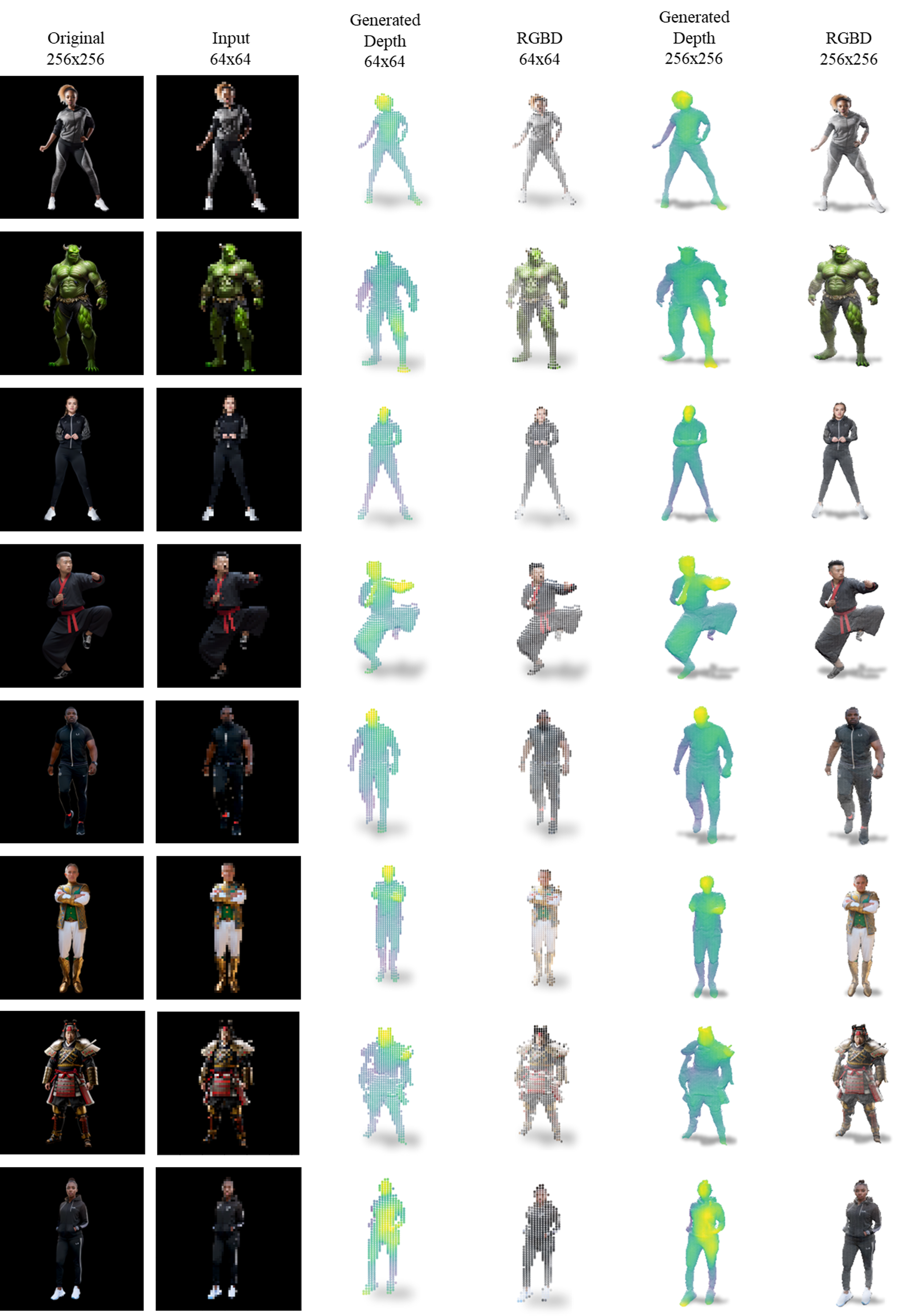

การใช้งาน TensorFlow สำหรับ RGB-D-Fusion สำหรับรายละเอียด โปรดดูรายงาน RGB-D-Fusion: การแพร่กระจายความลึกที่มีเงื่อนไขของภาพของวัตถุรูปทรงคล้ายมนุษย์

2023/10/14 : รหัสใช้ได้แล้ว!2023/09/04 : บทความของเราได้รับการตีพิมพ์ใน IEEE Access แล้ว!2023/07/29 : เราเผยแพร่การพิมพ์ล่วงหน้าของเราบน arxiv

|  |  |

เราขอแนะนำให้ใช้สภาพแวดล้อมนักเทียบท่า เราจัดเตรียมไฟล์นักเทียบท่าจาก TensorFlow และไฟล์นักเทียบท่าจาก NVIDIA อันหลังมีขนาดใหญ่กว่า แต่รวมถึงการเพิ่มประสิทธิภาพของ NVIDIA ตรวจสอบให้แน่ใจว่าติดตั้งนักเทียบท่ารวมถึงส่วนขยาย GPU ของ nvidia

docker build -t < IMAGE_NAME > / < VERSION > -f < PATH_TO_DOCKERFILE >docker container create --gpus all -u 1000:1000 --name rgb-d-fusion -p 8888:8888 -v < PATH_TO_tf_DIR > :/tf -v < PATH_TO_YOUR_GIT_DIR > :/tf/GitHub -it < IMAGE_NAME > / < VERSION >docker start rgb-d-fusionลำดับชั้นของไดเร็กทอรีควรมีลักษณะดังนี้

|- tf

|- manual_datasets

|- <DATASET 1>

|- test

|- DEPTH_RENDER_EXR

|- MASK

|- PARAM

|- RENDER

|- train # same hierachy as in test

|- <DATASET 2> # same hierachy as inv_humas_rendered

|- GitHub

|- ConditionalDepthDiffusion # This Repo

|- output_runs # Auto generated directory to store results

|- DepthDiffusion

|- checkpoints # stores saved model checkpoints

|- illustrations # illustrations that are beeing generated during or after training

|- diffusion_output # used for inference to store data sampled from the model

|- SuperResolution # same hierachy as in DepthDiffusion

ลำดับชั้นอาจถูกสร้างขึ้นในที่เดียวหรือในไดเร็กทอรีอื่น เมื่อเริ่มต้นคอนเทนเนอร์นักเทียบท่า สามารถติดตั้งไดเร็กทอรีที่แตกต่างกันได้

สคริปต์อยู่ภายใต้สคริปต์ ปัจจุบันมีโมเดลสองประเภท:

แต่ละโมเดลมีสคริปต์การฝึกอบรม การประเมิน และการอนุมานโดยเฉพาะที่เขียนด้วยภาษา Python คุณสามารถตรวจสอบการทำงานและพารามิเตอร์ได้ผ่านทาง python <SCRIPT> -h

หากคุณพบว่างานของเรามีประโยชน์สำหรับการวิจัยของคุณ โปรดพิจารณาอ้างอิงรายการ BibTeX ต่อไปนี้

@article { kirch_rgb-d-fusion_2023 ,

title = { RGB-D-Fusion: Image Conditioned Depth Diffusion of Humanoid Subjects } ,

author = { Kirch, Sascha and Olyunina, Valeria and Ondřej, Jan and Pagés, Rafael and Martín, Sergio and Pérez-Molina, Clara } ,

journal = { IEEE Access } ,

year = { 2023 } ,

volume = { 11 } ,

issn = { 2169-3536 } ,

doi = { 10.1109/ACCESS.2023.3312017 } ,

pages = { 99111--99129 } ,

url = { https://ieeexplore.ieee.org/document/10239167 } ,

}