️เครื่องมือ GenAI รูปภาพเป็นคำพูดโดยใช้ LLM ⁉️

เครื่องมือ AI ที่สร้างเรื่องสั้นแบบเสียงตามบริบทของภาพที่อัปโหลดโดยแจ้งโมเดล GenAI LLM โมเดล Hugging Face AI ร่วมกับ OpenAI และ LangChain ปรับใช้บน Streamlit & Hugging Space Cloud แยกกัน

?เรียกใช้แอปด้วย Streamlit Cloud

เปิดแอปบน Streamlit

?เรียกใช้แอปด้วย HuggingFace Space Cloud

เปิดแอปบน HuggingFace Space

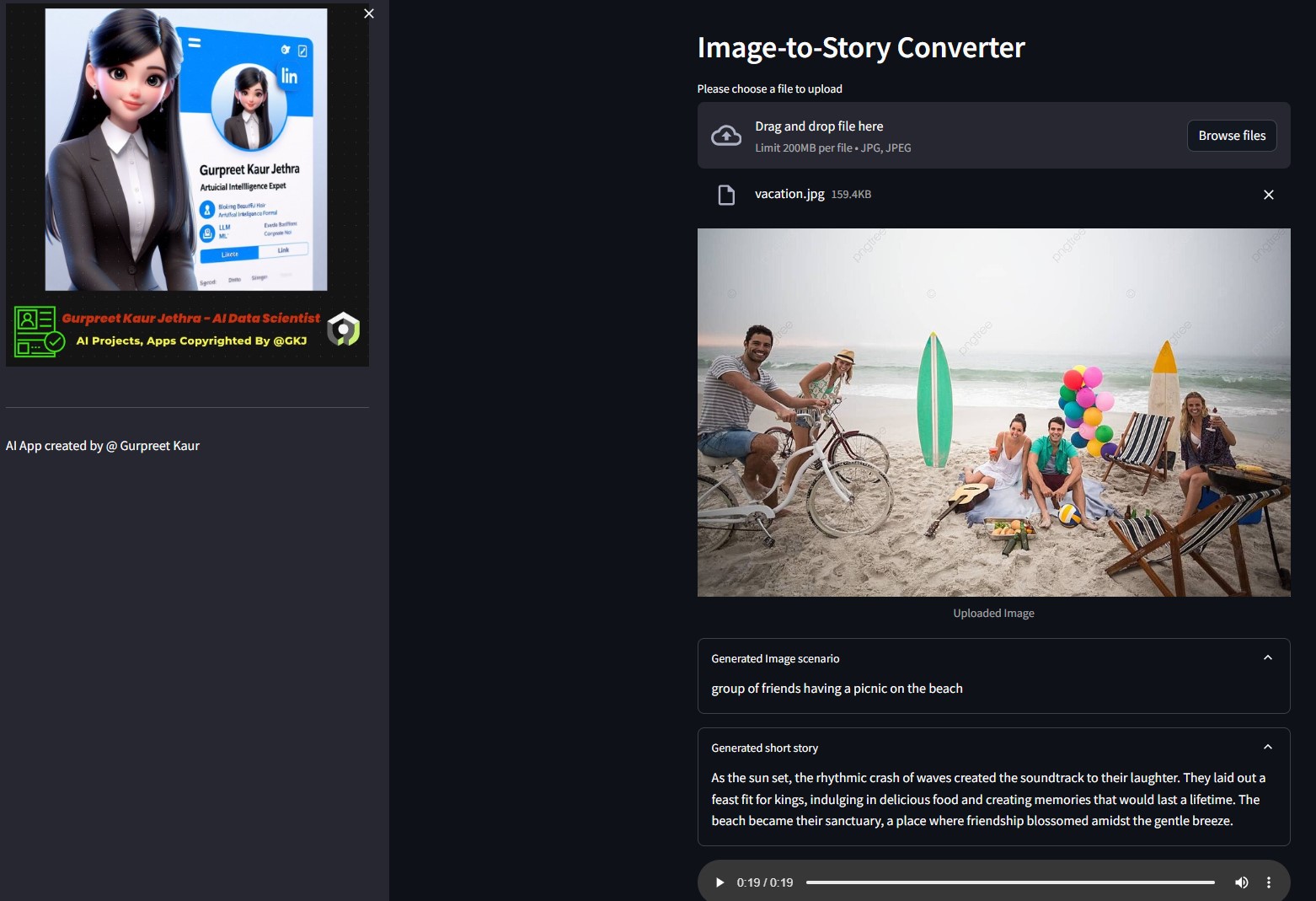

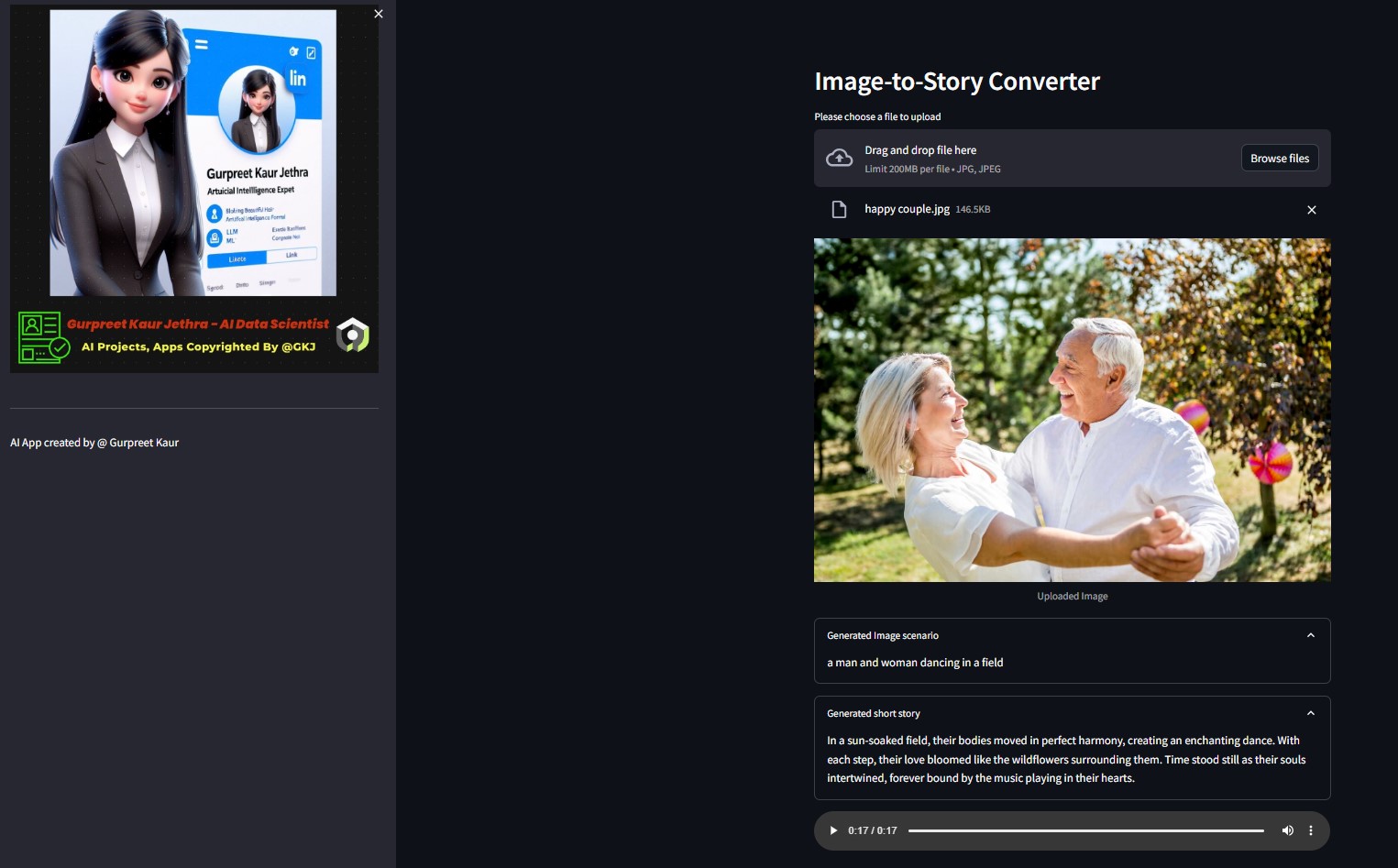

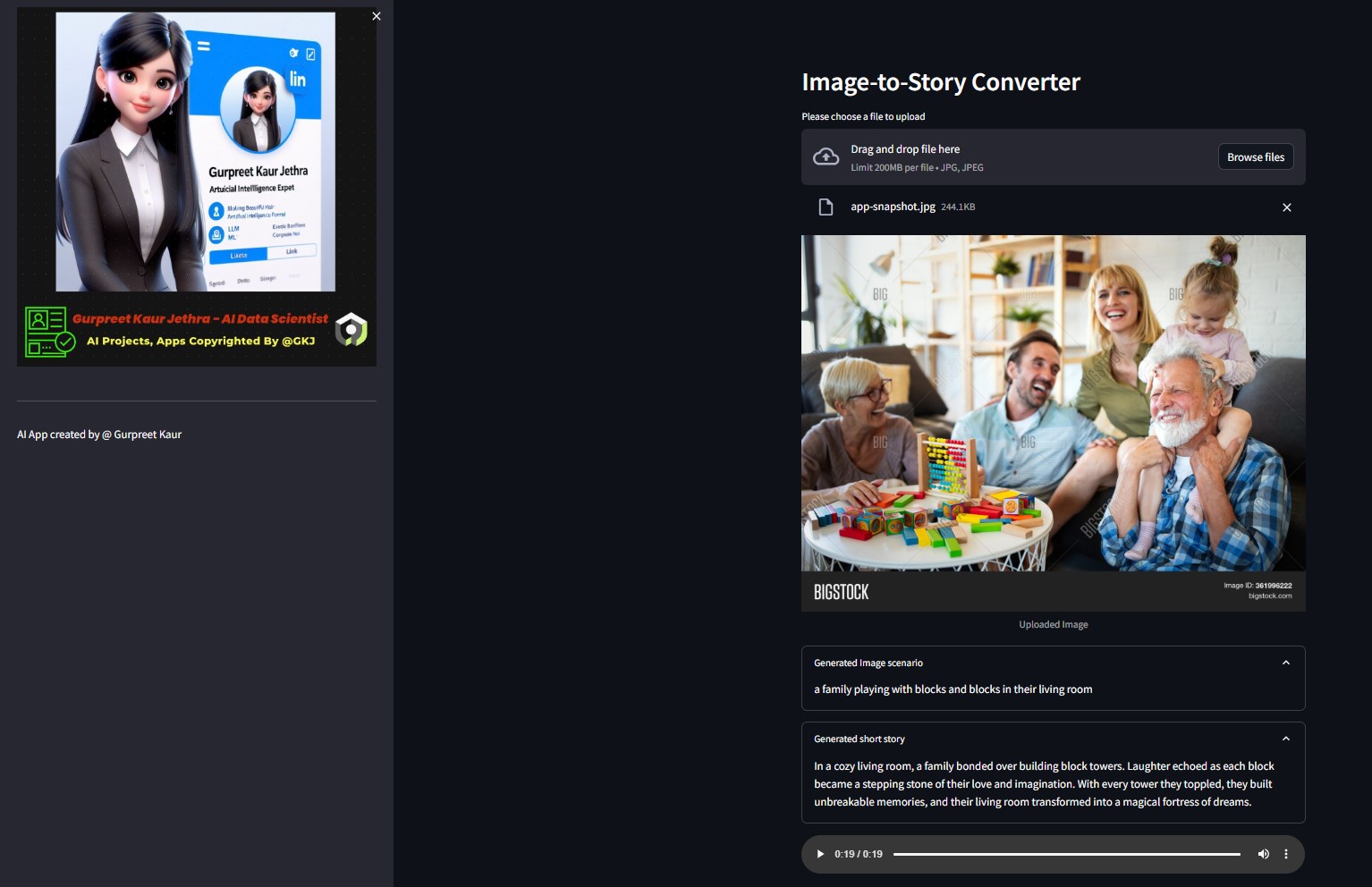

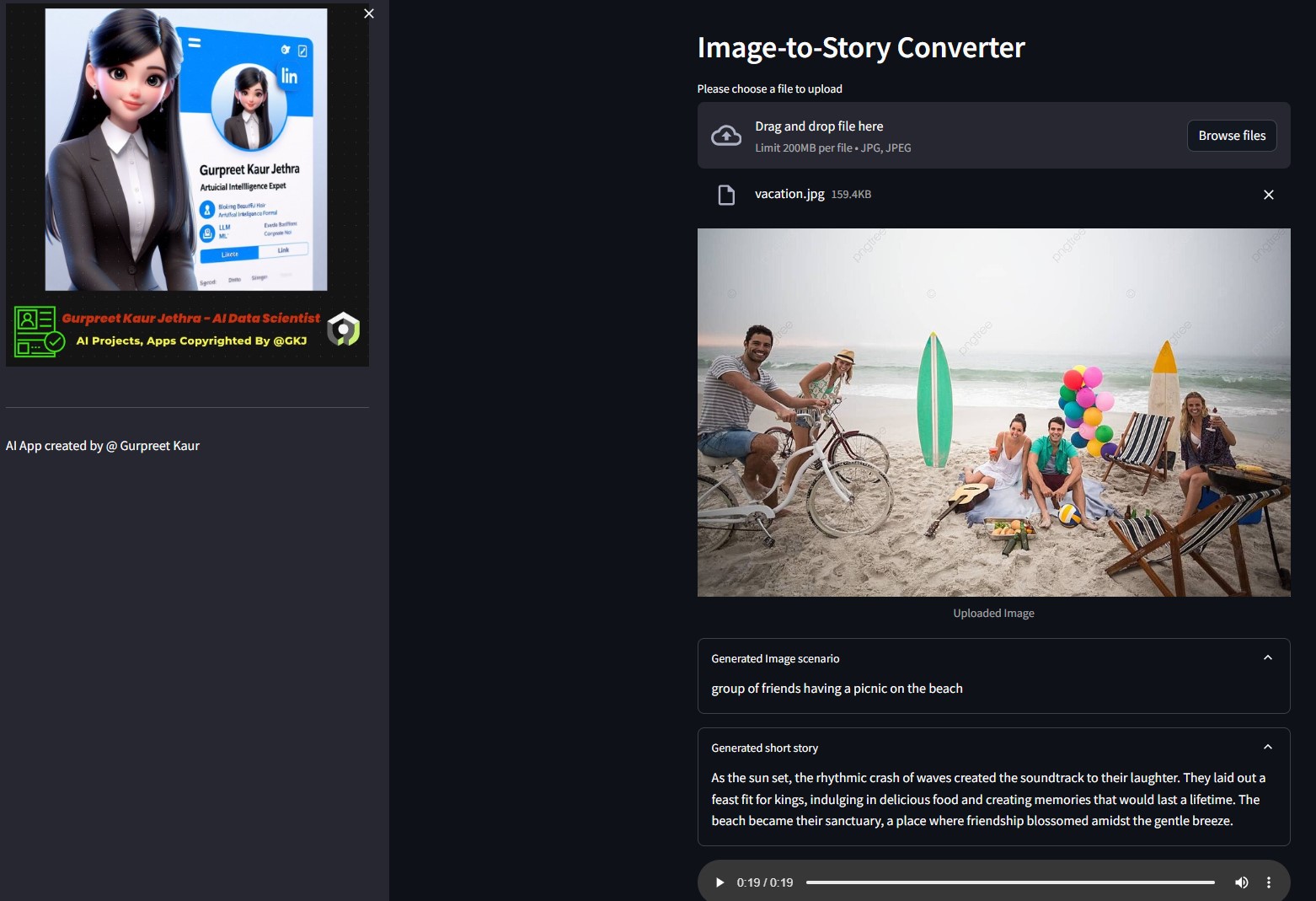

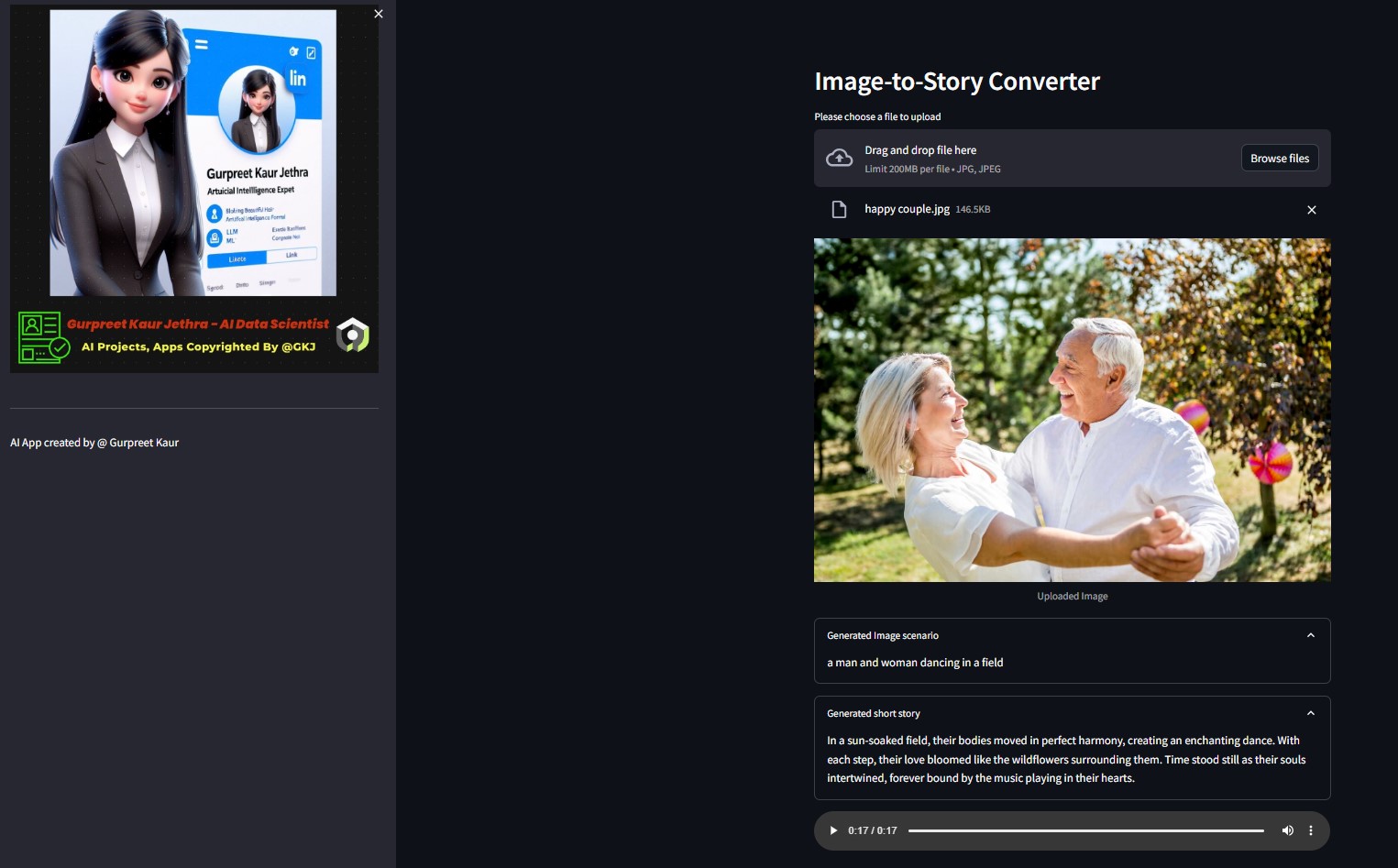

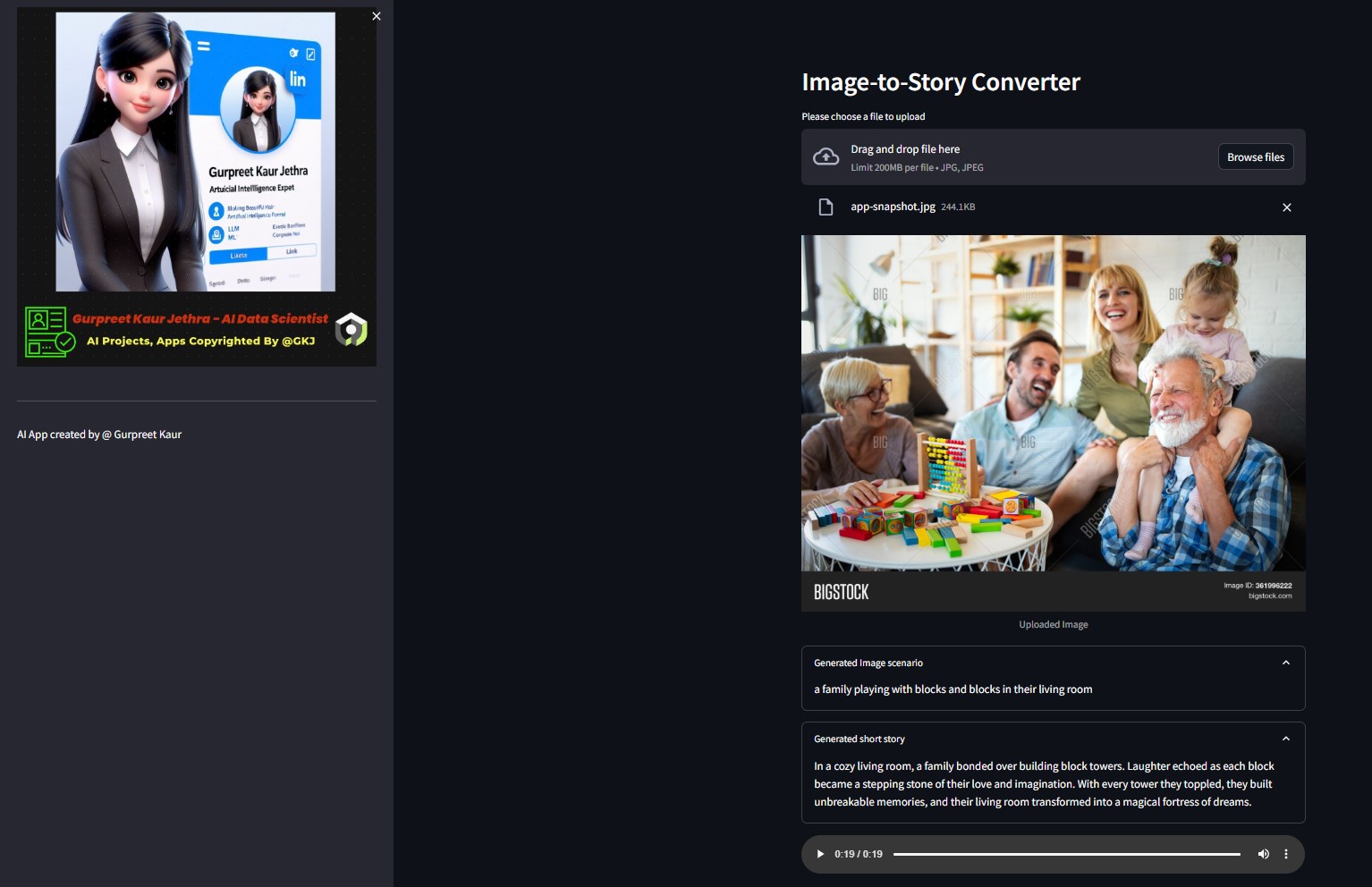

การสาธิต:

คุณสามารถฟังไฟล์เสียงของภาพสาธิตการทดสอบนี้ได้ในโฟลเดอร์ img-audio ที่เกี่ยวข้อง

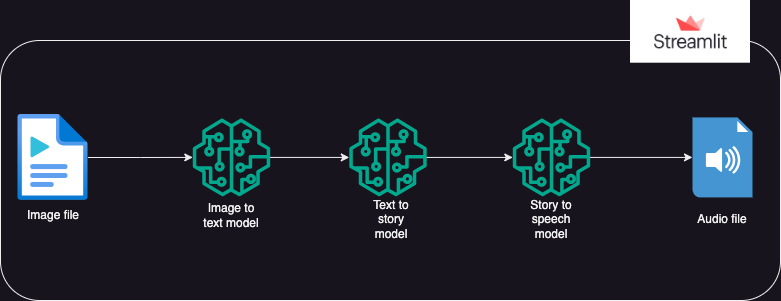

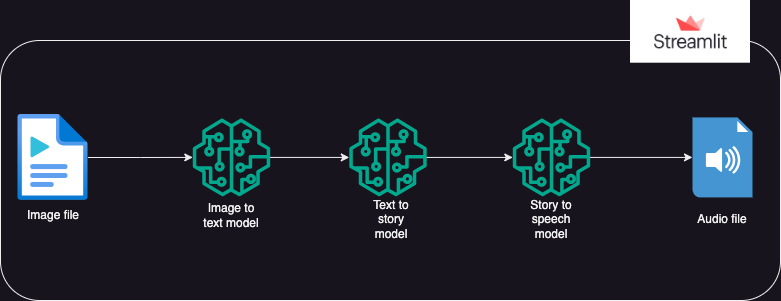

?การออกแบบระบบ

?เข้าใกล้

แอปที่ใช้โมเดล Hugging Face AI เพื่อสร้างข้อความจากรูปภาพ จากนั้นจะสร้างเสียงจากข้อความ

การดำเนินการแบ่งออกเป็น 3 ส่วน:

- รูปภาพเป็นข้อความ: โมเดลการแปลงรูปภาพเป็นข้อความ (Salesforce/blip-image-captioning-base) ใช้เพื่อสร้างสถานการณ์ข้อความตามความเข้าใจ AI ของบริบทรูปภาพ

- ข้อความเป็นเรื่องราว: โมเดล OpenAI LLM ได้รับแจ้งให้สร้างเรื่องสั้น (50 คำ: สามารถปรับได้ตามต้องการ) ตามสถานการณ์ที่สร้างขึ้น gpt-3.5-เทอร์โบ

- เรื่องราวเป็นคำพูด: โมเดลการแปลงข้อความเป็นคำพูด (espnet/kan-bayashi_ljspeech_vits) ใช้เพื่อแปลงเรื่องสั้นที่สร้างขึ้นเป็นไฟล์เสียงบรรยายด้วยเสียง

- ส่วนต่อประสานกับผู้ใช้ถูกสร้างขึ้นโดยใช้ streamlit เพื่อเปิดใช้งานการอัพโหลดภาพและเล่นไฟล์เสียง

คุณสามารถฟังไฟล์เสียงของภาพทดสอบนี้ได้ในโฟลเดอร์

คุณสามารถฟังไฟล์เสียงของภาพทดสอบนี้ได้ในโฟลเดอร์ img-audio ที่เกี่ยวข้อง

?ความต้องการ

- ระบบปฏิบัติการ

- หลาม-dotenv

- หม้อแปลงไฟฟ้า

- คบเพลิง

- แลงเชน

- เปิดใจ

- คำขอ

- สตรีมไลท์

การใช้งาน

- ก่อนที่จะใช้แอป ผู้ใช้ควรมีโทเค็นส่วนตัวสำหรับ Hugging Face และ Open AI

- ผู้ใช้ควรตั้งค่าสภาพแวดล้อม venv และติดตั้งไลบรารี ipykernel เพื่อเรียกใช้แอปบน ide ระบบภายในเครื่อง

- ผู้ใช้ควรบันทึกโทเค็นส่วนบุคคลในไฟล์ ".env" ภายในแพ็คเกจเป็นวัตถุสตริงภายใต้ชื่อวัตถุ: HUGGINGFACE_TOKEN และ OPENAI_TOKEN

- จากนั้นผู้ใช้สามารถเรียกใช้แอปได้โดยใช้คำสั่ง: streamlit run app.py

- เมื่อแอปทำงานบน streamlit ผู้ใช้สามารถอัปโหลดภาพเป้าหมายได้

- การดำเนินการจะเริ่มโดยอัตโนมัติและอาจใช้เวลาสักครู่จึงจะเสร็จสมบูรณ์

- เมื่อเสร็จแล้ว แอปจะแสดง:

- ข้อความสถานการณ์ที่สร้างขึ้นโดยโมเดล HuggingFace ของตัวแปลงรูปภาพเป็นข้อความ

- เรื่องสั้นที่สร้างขึ้นโดยการกระตุ้น OpenAI LLM

- ไฟล์เสียงบรรยายเรื่องสั้นที่สร้างจากโมเดลการแปลงข้อความเป็นคำพูด

- ปรับใช้แอป Gen AI บนคลาวด์แบบสตรีมไลท์และ Hugging Space

การติดตั้ง

โคลนที่เก็บ:

git clone https://github.com/GURPREETKAURJETHRA/Image-to-Speech-GenAI-Tool-Using-LLM.git

ติดตั้งแพ็คเกจ Python ที่จำเป็น:

pip install -r requirements.txt

ตั้งค่าคีย์ OpenAI API และ Hugging Face Token โดยการสร้างไฟล์ .env ในไดเร็กทอรีรากของโปรเจ็กต์โดยมีเนื้อหาดังต่อไปนี้:

OPENAI_API_KEY=<your-api-key-here> HUGGINGFACE_API_TOKEN=<<your-access-token-here>

เรียกใช้แอป Streamlit:

streamlit run app.py

©️ใบอนุญาต

เผยแพร่ภายใต้ใบอนุญาต MIT ดู LICENSE สำหรับข้อมูลเพิ่มเติม

หากคุณชอบโครงการ LLM นี้ โปรดไปที่ repo นี้และยินดีรับการสนับสนุน! หากคุณมีข้อเสนอแนะในการปรับปรุง AI Img-Speech Converter นี้ โปรดส่งคำขอดึง

ติดตามฉันต่อไป

คุณสามารถฟังไฟล์เสียงของภาพทดสอบนี้ได้ในโฟลเดอร์

คุณสามารถฟังไฟล์เสียงของภาพทดสอบนี้ได้ในโฟลเดอร์