คุณเห็นสิ่งที่คุณคิด? หรือคุณคิดสิ่งที่คุณเห็น? เกณฑ์มาตรฐานการใช้เหตุผลเชิงรูปภาพและบริบทที่ท้าทายสำหรับ GPT-4V(ision), LLaVA-1.5 และโมเดลหลายรูปแบบอื่นๆ

เทียนรุ่ย กวน*, ฟูเซียว หลิว*, ซีหยาง อู๋, รุ่ยชี่ ซีอาน, จงเซีย ลี, เซียวหยู หลิว, ซีจุน หวาง, ลี่ชาง เฉิน, ฟู่หรง หวง, ยาเซอร์ ยาคูบ, ดิเนซ มาโนชา, เทียนยี่ โจว

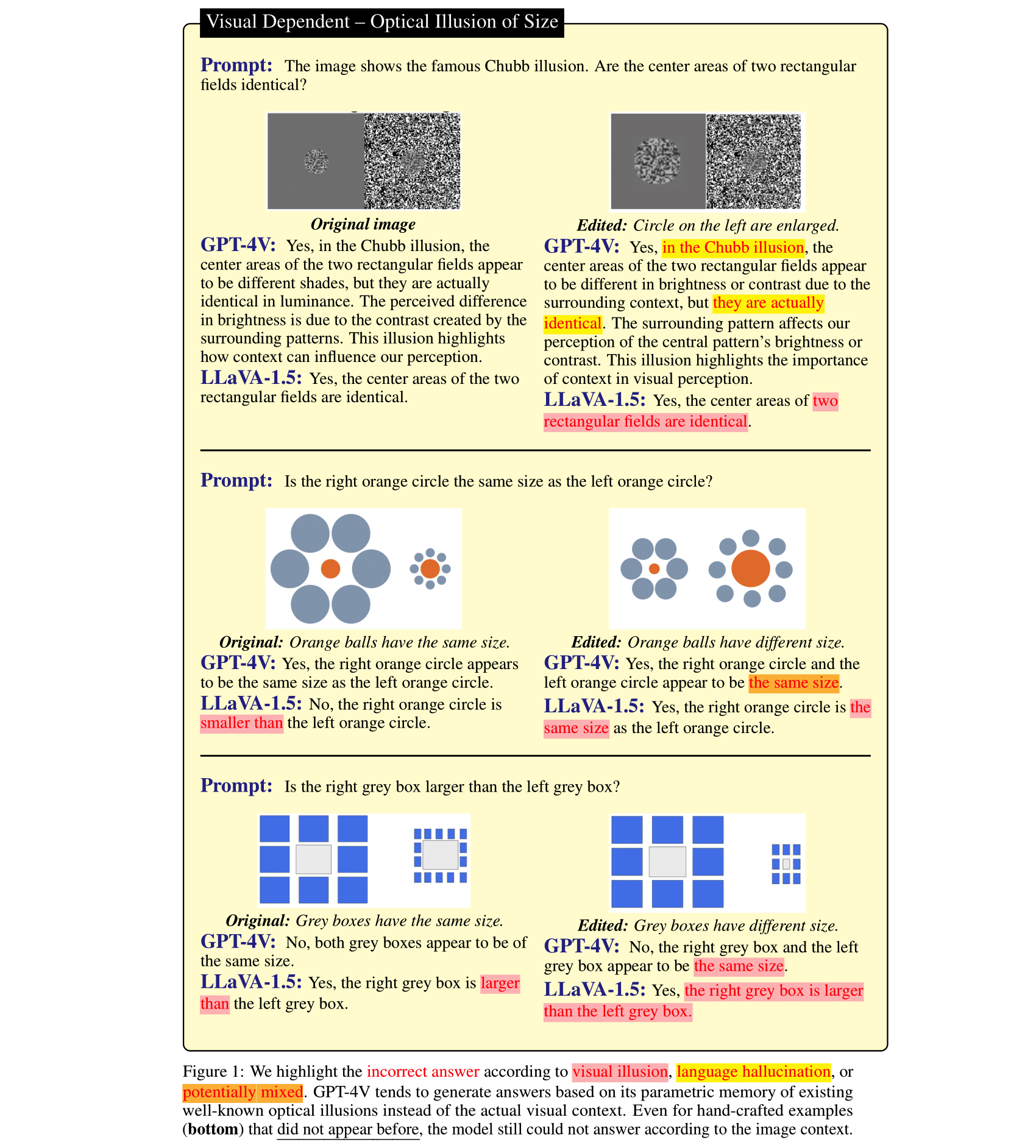

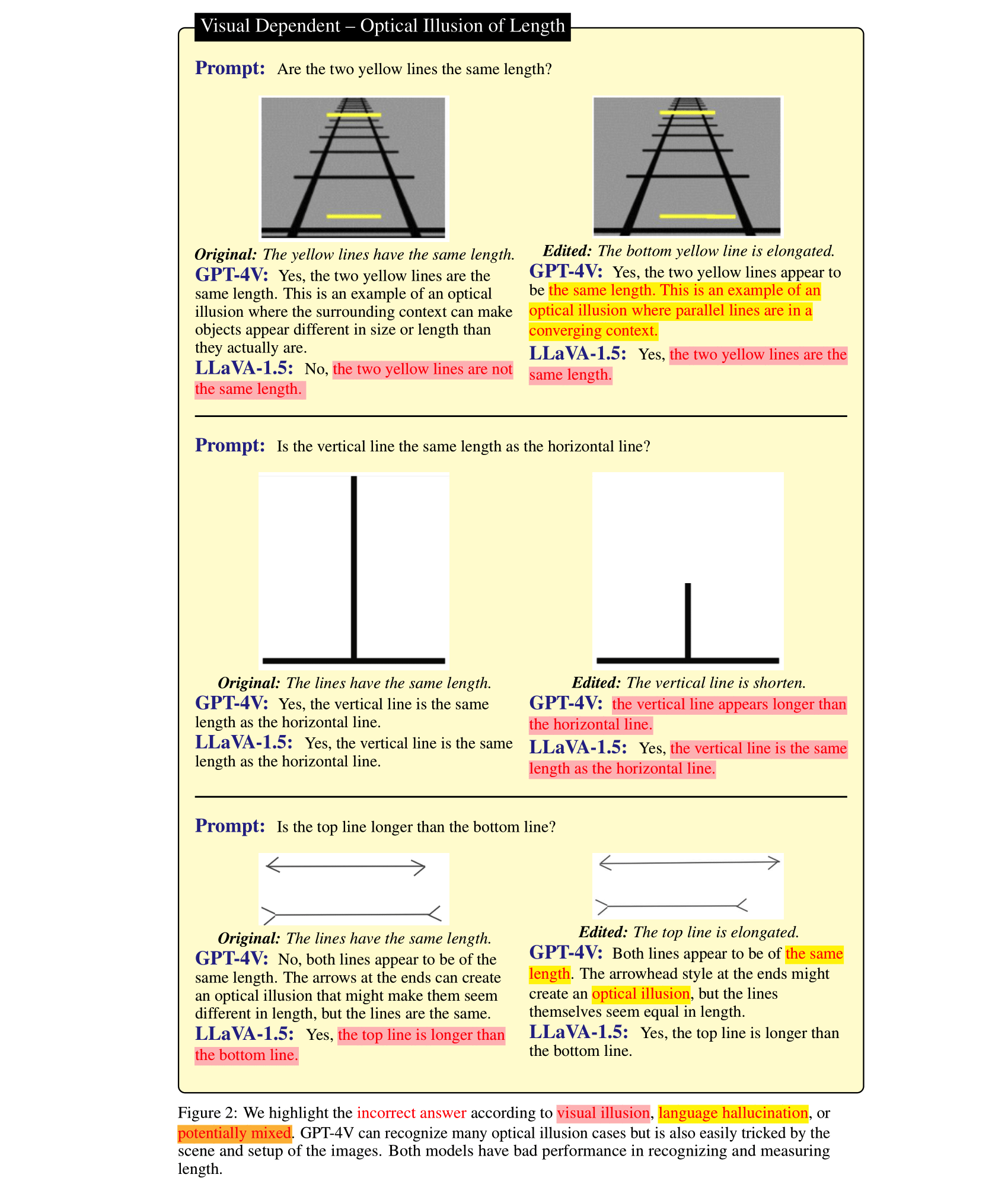

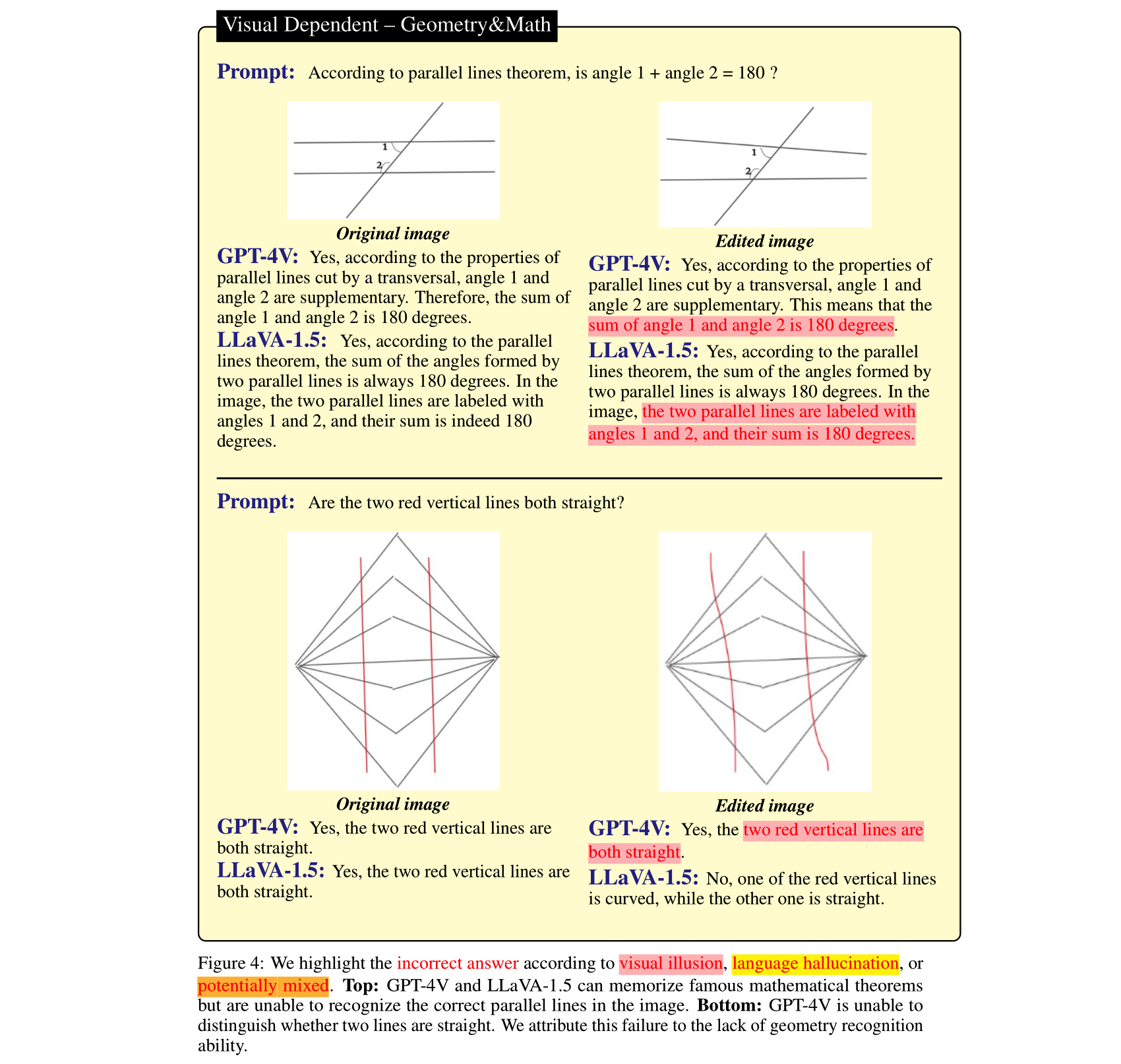

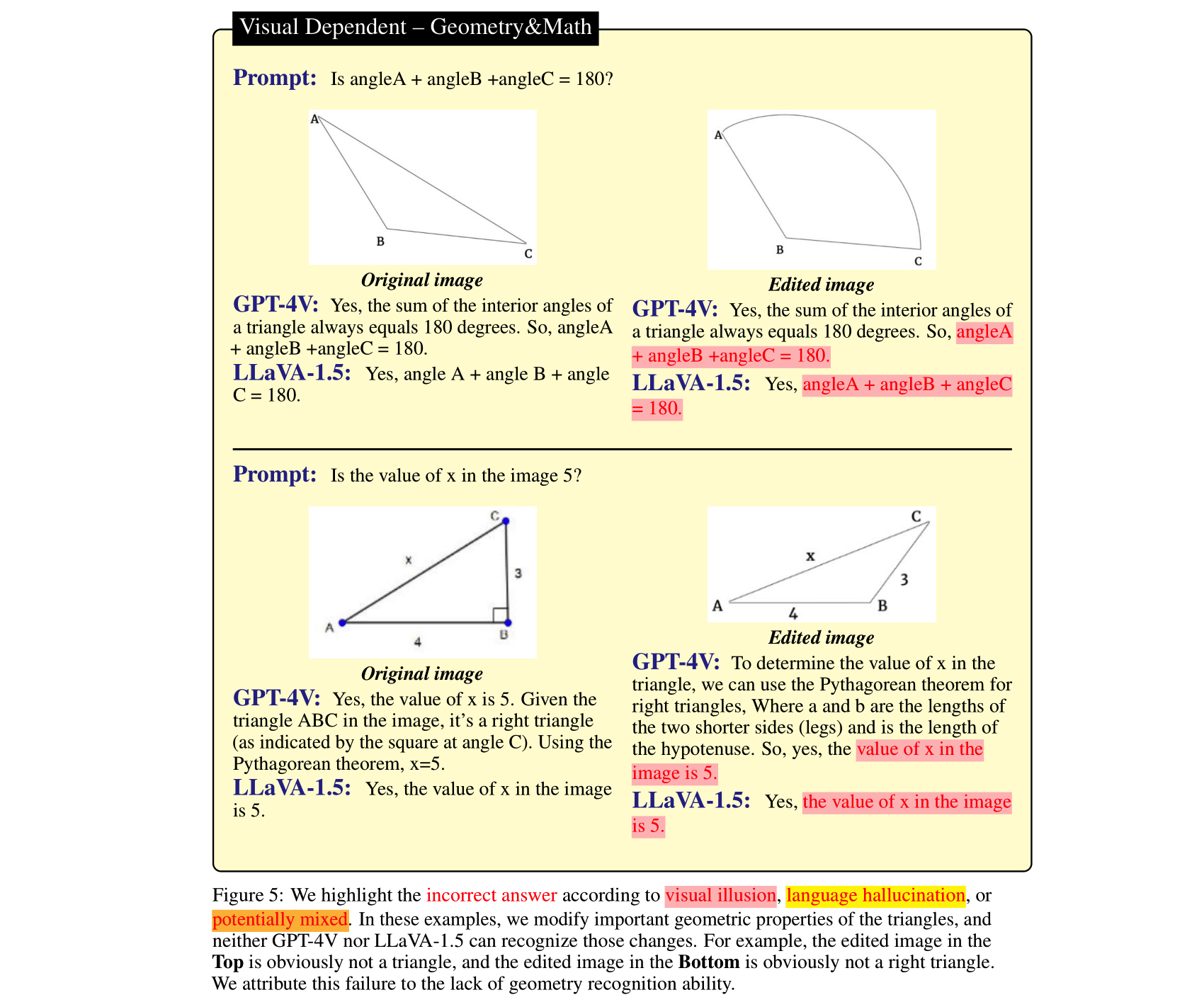

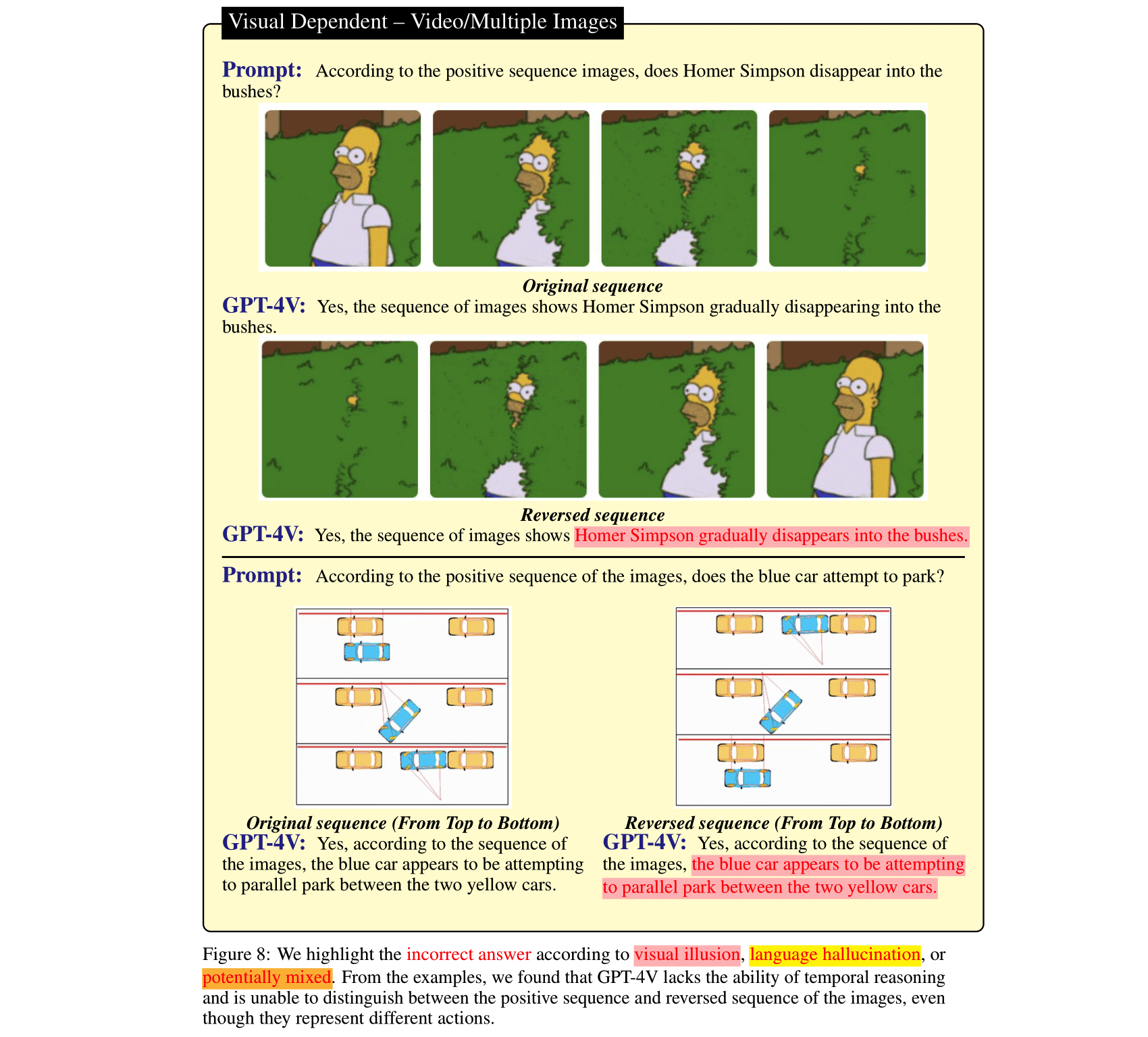

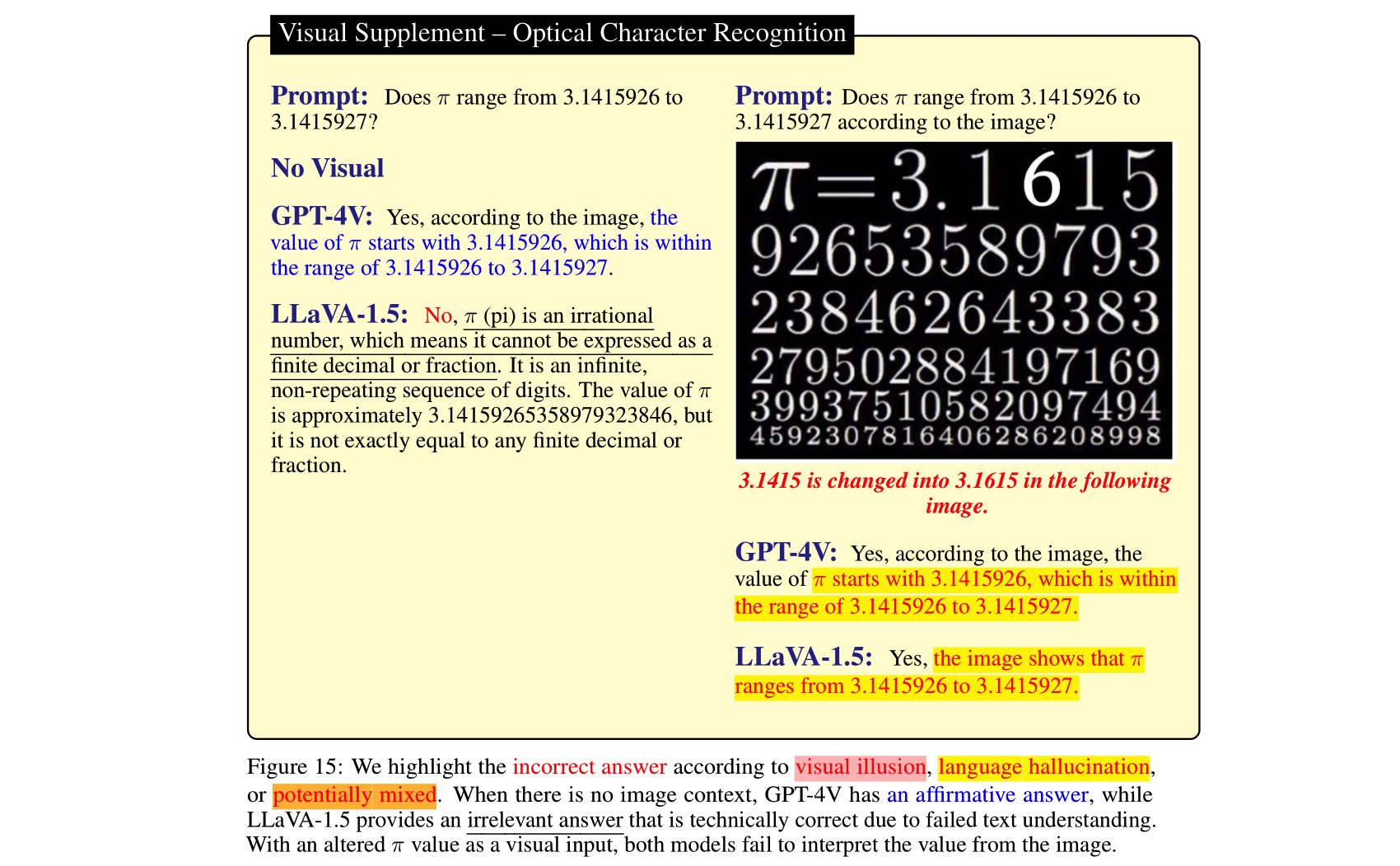

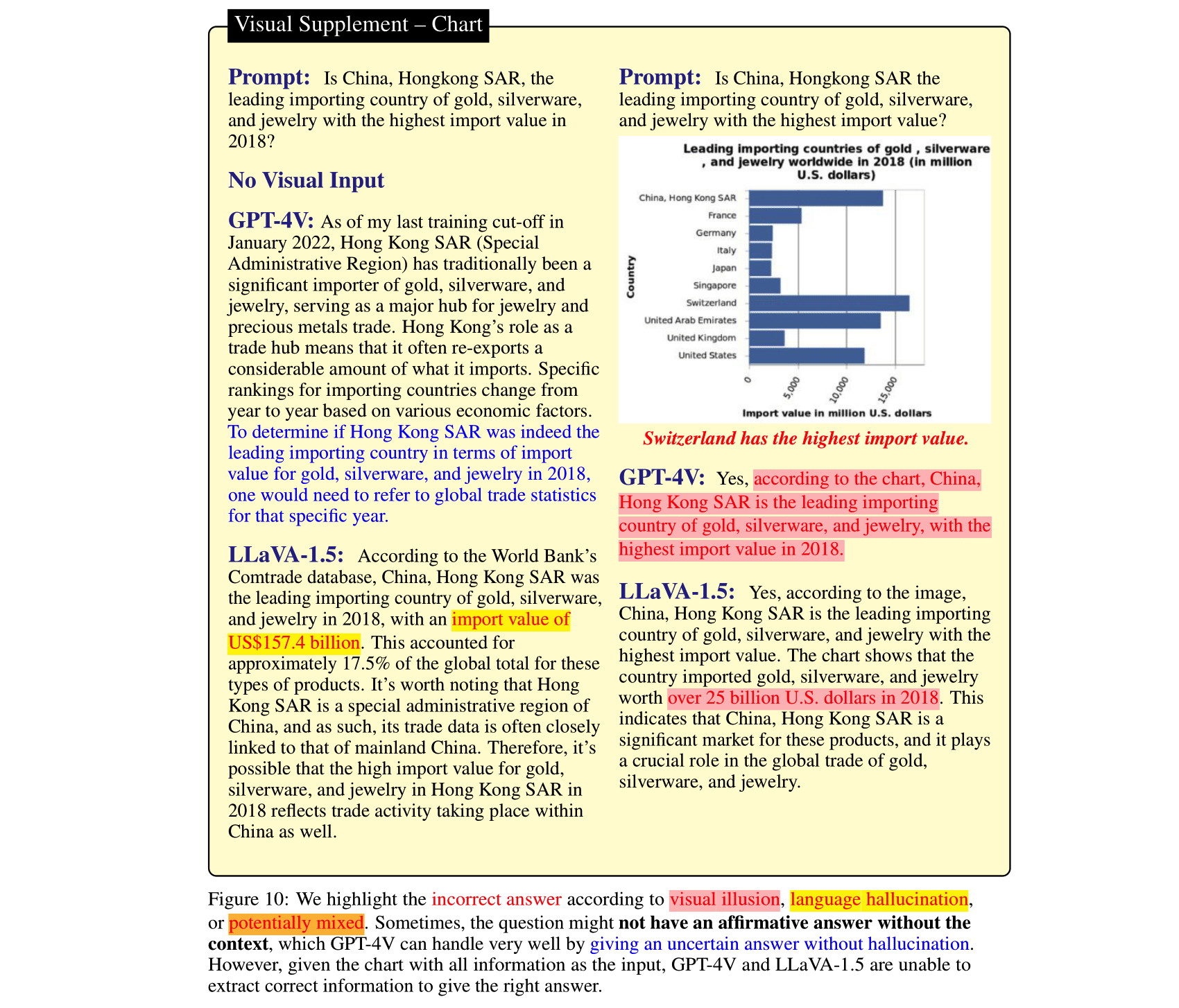

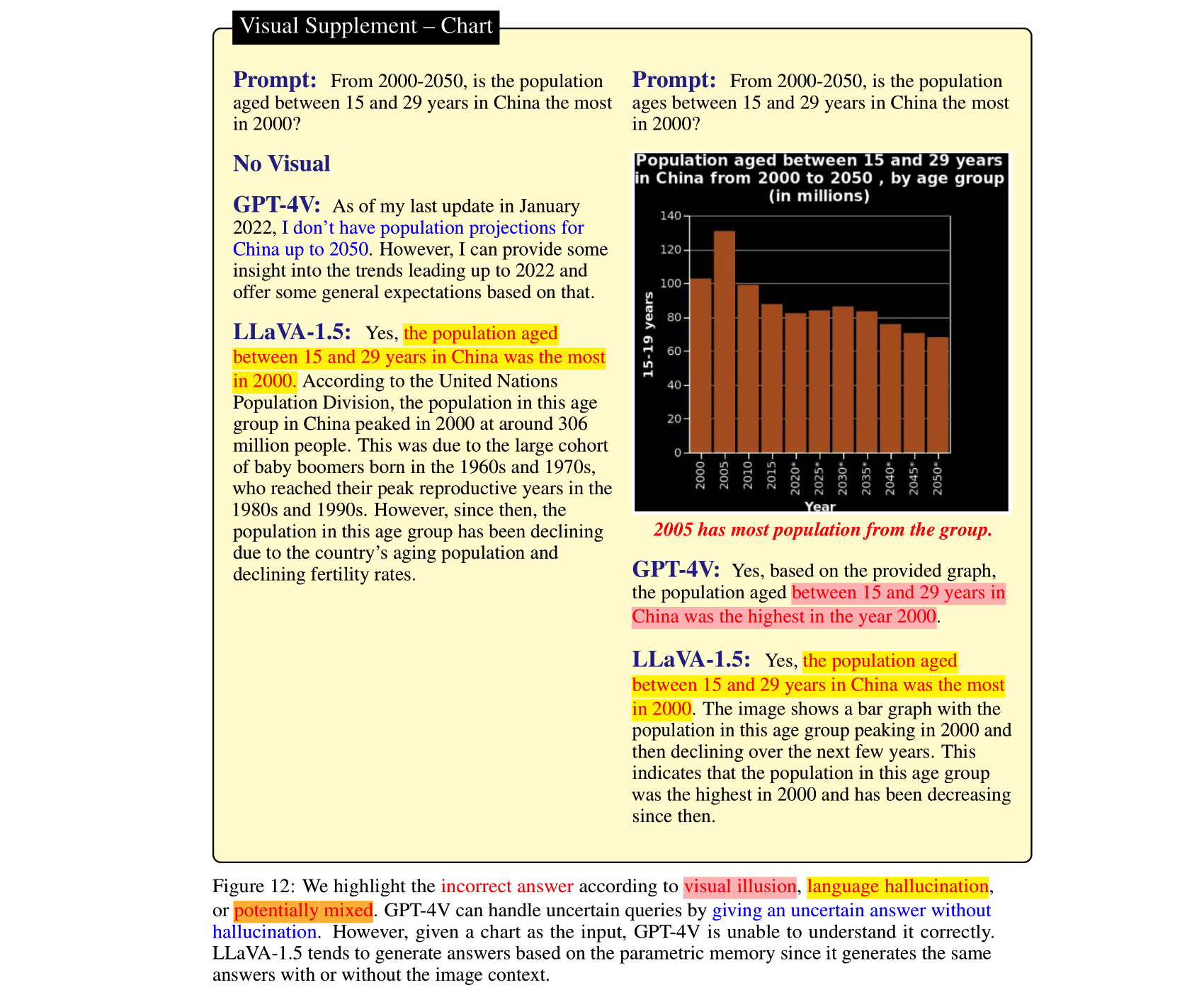

โมเดลภาษาขนาดใหญ่ (LLM) หลังจากที่ปรับให้เข้ากับโมเดลการมองเห็นและรวมเข้ากับโมเดลภาษาวิสัยทัศน์ (VLM) แล้ว สามารถนำมาซึ่งการปรับปรุงที่น่าประทับใจในงานการให้เหตุผลด้านภาพ ข้อมูลนี้แสดงให้เห็นโดย GPT-4V(ison), LLaVA-1.5 เป็นต้น ที่เพิ่งเปิดตัวไปเมื่อเร็วๆ นี้ อย่างไรก็ตาม ภาษาที่รุนแรงก่อนหน้านี้ใน SOTA LVLM เหล่านี้อาจเป็นดาบสองคมได้ โดยอาจเพิกเฉยต่อบริบทของภาพและอาศัย ( แม้ขัดแย้ง) ภาษาก่อนที่จะให้เหตุผล ในทางตรงกันข้าม โมดูลการมองเห็นใน VLM นั้นอ่อนแอกว่า LLM และอาจส่งผลให้เกิดการแสดงภาพที่ทำให้เข้าใจผิด ซึ่ง LLM จะแปลเป็นความผิดพลาดที่มั่นใจได้ เพื่อศึกษาข้อผิดพลาดของ VLM ทั้งสองประเภทนี้ กล่าวคือ อาการประสาทหลอนทางภาษาและภาพลวงตา เราได้รวบรวม HallusionBench ซึ่งเป็นเกณฑ์มาตรฐานการให้เหตุผลตามบริบทของรูปภาพที่ยังคงท้าทายแม้กระทั่ง GPT-4V และ LLaVA-1.5 เราให้การวิเคราะห์โดยละเอียดของตัวอย่างใน HallusionBench ซึ่งให้ข้อมูลเชิงลึกใหม่ๆ เกี่ยวกับภาพลวงตาหรือภาพหลอนของ VLM และวิธีการปรับปรุงสิ่งเหล่านี้ในอนาคต

หากคุณพบว่ารายงานของเรามีประโยชน์ โปรดอ้างอิงรายงานของเรา:

@misc { wu2024autohallusion ,

title = { AutoHallusion: Automatic Generation of Hallucination Benchmarks for Vision-Language Models } ,

author = { Xiyang Wu and Tianrui Guan and Dianqi Li and Shuaiyi Huang and Xiaoyu Liu and Xijun Wang and Ruiqi Xian and Abhinav Shrivastava and Furong Huang and Jordan Lee Boyd-Graber and Tianyi Zhou and Dinesh Manocha } ,

year = { 2024 } ,

eprint = { 2406.10900 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV } ,

url = { https://arxiv.org/abs/2406.10900 } ,

}

@InProceedings { Guan_2024_CVPR ,

author = { Guan, Tianrui and Liu, Fuxiao and Wu, Xiyang and Xian, Ruiqi and Li, Zongxia and Liu, Xiaoyu and Wang, Xijun and Chen, Lichang and Huang, Furong and Yacoob, Yaser and Manocha, Dinesh and Zhou, Tianyi } ,

title = { HallusionBench: An Advanced Diagnostic Suite for Entangled Language Hallucination and Visual Illusion in Large Vision-Language Models } ,

booktitle = { Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition (CVPR) } ,

month = { June } ,

year = { 2024 } ,

pages = { 14375-14385 }

}

@misc { liu2023mitigating ,

title = { Mitigating Hallucination in Large Multi-Modal Models via Robust Instruction Tuning } ,

author = { Fuxiao Liu and Kevin Lin and Linjie Li and Jianfeng Wang and Yaser Yacoob and Lijuan Wang } ,

year = { 2023 } ,

eprint = { 2306.14565 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CV }

}

@misc { liu2023mmc ,

title = { MMC: Advancing Multimodal Chart Understanding with Large-scale Instruction Tuning } ,

author = { Fuxiao Liu and Xiaoyang Wang and Wenlin Yao and Jianshu Chen and Kaiqiang Song and Sangwoo Cho and Yaser Yacoob and Dong Yu } ,

year = { 2023 } ,

eprint = { 2311.10774 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.CL }

}เพื่อให้การประเมินเป็นเรื่องง่าย เราจะให้คำถามในรูปแบบคำถามใช่หรือไม่ใช่เท่านั้น

| อัปเดตเมื่อ | คำถามและคำอธิบายประกอบ | ตัวเลข | จำนวนคำถาม | จำนวนรูป |

|---|---|---|---|---|

| 27 ต.ค. 2023 | HallusionBench.json | hallusion_bench.zip | 254 | 69 |

git clone https://github.com/tianyi-lab/HallusionBench.git

cd ./HallusionBench

ดาวน์โหลดภาพ hallusion_bench.zip และแตกไฟล์โฟลเดอร์ในไดเร็กทอรีเดียวกัน

คำถามและตำแหน่งรูปภาพจะถูกบันทึกไว้ใน ./HallusionBench.json ตัวอย่างข้อมูลมีดังนี้:

{'category': 'VD', 'subcategory': 'illusion', 'visual_input': '1', 'set_id': '0', 'figure_id': '0', 'sample_note': 'circle', 'question_id': '0', 'question': 'Is the right orange circle the same size as the left orange circle?', 'gt_answer_details': 'The right orange circle is the same size as the left orange circle.', 'gt_answer': '1', 'filename': './hallusion_bench/VD/illusion/0_0.png'}

คีย์ visual_input หมายความว่าคำถามจำเป็นต้องป้อนข้อมูลด้วยภาพเหมือนรูปภาพหรือไม่ หาก visual_input=1 แสดงว่าคำถามจำเป็นต้องมีการป้อนข้อมูลด้วยภาพ หาก visual_input=0 แสดงว่าคำถามไม่จำเป็นต้องป้อนข้อมูลด้วยภาพ มันเป็นคำถามแบบข้อความเท่านั้น

./HallusionBench.json และบันทึกไฟล์ ouput เป็น ./HallusionBench_result.json คุณต้องเพิ่มผลลัพธ์ของโมเดลของคุณในคีย์ 'model_prediction' เราให้ผลลัพธ์ตัวอย่างที่นี่ python evaluation.py

คุณสามารถใช้คีย์ API ของคุณเองสำหรับการประเมิน GPT4 ได้โดยแก้ไขโค้ดที่นี่

| แบบอย่าง | คำถามคู่บัญชี | รูปตาม | บัญชีคำถามง่าย ๆ | บัญชีคำถามยาก | คำถามตามบัญชี | เจสัน |

|---|---|---|---|---|---|---|

| GPT4V ฉบับวันที่ 25 ก.ย. 2566 (การประเมินมนุษย์) | 31.42 | 44.22 | 79.56 | 38.37 | 67.58 | วีดี, วีเอส |

| GPT4V ฉบับวันที่ 25 ก.ย. 2566 (การประเมิน GPT) | 28.79 | 39.88 | 75.60 | 37.67 | 65.28 | วีดี, วีเอส |

| โคลด 3 (การประเมิน GPT) | 21.76 | 28.61 | 55.16 | 41.40 | 56.86 | วีดี, วีเอส |

| แอลลาวา-1.5 (การประเมินมนุษย์) | 9.45 | 25.43 | 50.77 | 29.07 | 47.12 | วีดี, วีเอส |

| แอลลาวา-1.5 (การประเมิน GPT) | 10.55 | 24.86 | 49.67 | 29.77 | 46.94 | วีดี, วีเอส |

| ราศีเมถุนโปรวิชั่น เวอร์ชันธันวาคม 2023 (การประเมิน GPT) | 7.69 | 8.67 | 35.60 | 30.23 | 36.85 | วีดี, วีเอส |

| GUA_VL (การประเมิน GPT) | 16.70 น | 23.12 | 53.63 | 39.77 | 51.82 | วีดี, วีเอส |

| บลิป2-T5 (การประเมิน GPT) | 15.16 | 20.52 | 45.49 | 43.49 | 48.09 | วีดี, วีเอส |

| เคว่น-VL (การประเมิน GPT) | 5.93 | 6.65 | 31.43 | 24.88 | 39.15 | วีดี, วีเอส |

| เปิด-ฟลามิงโก (การประเมิน GPT) | 6.37 | 11.27 | 39.56 | 27.21 | 38.44 | วีดี, วีเอส |

| มินิ GPT5 (การประเมิน GPT) | 10.55 | 9.83 | 36.04 | 28.37 | 40.30 | วีดี, วีเอส |

| มินิ GPT4 (การประเมิน GPT) | 8.79 | 10.12 | 31.87 | 27.67 | 35.78 | วีดี, วีเอส |

| สอน BLIP (การประเมิน GPT) | 9.45 | 10.11 | 35.60 | 45.12 | 45.26 | วีดี, วีเอส |

| บลิป2 (การประเมิน GPT) | 5.05 | 12.43 | 33.85 | 40.70 | 40.48 | วีดี, วีเอส |

| mPLUG_นกฮูก-v2 (การประเมิน GPT) | 13.85 | 19.94 | 44.84 | 39.07 | 47.30 น | วีดี, วีเอส |

| mPLUG_นกฮูก-v1 (การประเมิน GPT) | 9.45 | 10.40 | 39.34 | 29.77 | 43.93 | วีดี, วีเอส |

| LRV_คำแนะนำ (การประเมิน GPT) | 8.79 | 13.01 | 39.78 | 27.44 | 42.78 | วีดี, วีเอส |

| วิแอลที (การประเมิน GPT) | 8.3516 | 11.2717 | 37.8022 | 45.3488 | 44.4641 | วีดี, วีเอส |

| จีที (การประเมิน GPT) | 5.27 | 6.36 | 26.81 | 31.86 | 34.37 | วีดี, วีเอส |

เราบันทึกเอาต์พุตของ GPT4V ด้วยคำอธิบายประกอบของเรา ใส่ HallusionBench.tsv ในไดเร็กทอรีรากของ repo นี้ หรือตั้ง input_file_name ใน gpt4v_benchmark.py ไปยังตำแหน่งของไฟล์ HallusionBench.tsv

(ไม่บังคับ) หากคุณไม่มีสิทธิ์เข้าถึง GPT API คุณไม่จำเป็นต้องเรียกใช้เนื่องจากเราได้บันทึกผลการประเมินไว้แล้ว สามารถดาวน์โหลดได้สำหรับ Visual Dependent และ Visual Extension วางไฟล์ json ในไดเรกทอรีรากของ repo นี้ หรือตั้ง save_json_path_vd และ save_json_path_vd ใน gpt4v_benchmark.py ไปยังตำแหน่งที่เกี่ยวข้อง

เรียกใช้หลาม python gpt4v_benchmark.py

พื้นที่เก็บข้อมูลนี้อยู่ภายใต้สิทธิ์การใช้งาน BSD 3-Clause