ยินดีต้อนรับสู่กลุ่มแลกเปลี่ยนเทคโนโลยีโมเดลขนาดใหญ่ของ Firefly ติดตามบัญชีอย่างเป็นทางการของเรา และคลิกปุ่มเข้าร่วมกลุ่ม

ยินดีต้อนรับติดตาม Zhihu ของเราเพื่อการสื่อสารและการสนทนา: ฝนแดงกำลังเท

Firefly เป็นโครงการฝึกอบรมโมเดลขนาดใหญ่แบบโอเพ่นซอร์สที่รองรับการฝึกอบรมล่วงหน้า การปรับแต่งคำสั่งอย่างละเอียด และ DPO สำหรับโมเดลขนาดใหญ่ทั่วไป รวมถึงแต่ไม่จำกัดเพียง Qwen2, Yi-1.5, Llama3, Gemma, Qwen1.5, MiniCPM, MiniCPM3, Lla ma, InternLM, Baichuan, ChatGLM, Yi, Deepseek, Qwen, Orion, Ziya, Xverse, Mistral, Mixtral-8x7B, Zephyr, Vicuna, Bloom ฯลฯ โปรเจ็กต์นี้สนับสนุน การฝึกอบรมพารามิเตอร์เต็มรูปแบบ, การฝึกอบรมที่มีประสิทธิภาพ LoRA, QLoRA และสนับสนุน การฝึกอบรมล่วงหน้า, SFT และ DPO หากทรัพยากรการฝึกอบรมของคุณมีจำกัด เราขอแนะนำอย่างยิ่งให้ใช้ QLoRA สำหรับการปรับแต่งคำสั่งอย่างละเอียด เนื่องจากเราได้ตรวจสอบประสิทธิภาพของวิธีนี้บนกระดานผู้นำ Open LLM และได้ผลลัพธ์ที่ดีมาก

?เนื้อหาหลักของโครงการนี้มีดังนี้:

เวอร์ชันปัจจุบันได้รับการปรับให้เข้ากับเทมเพลตของรูปแบบการแชทที่แตกต่างกัน และมีการอัปเดตที่สำคัญในโค้ด หากคุณต้องการเวอร์ชันก่อนหน้า คุณสามารถดาวน์โหลดโค้ด v0.0.1-alpha

ผลการประเมินมาจากลีดเดอร์บอร์ด Open LLM ของ Hugging Face โมเดลของเราได้รับการฝึกฝนโดยใช้สคริปต์ QLoRA และใช้ V100 เพียง 1 ถึง 2 ตัวเท่านั้นในการฝึก

| แบบอย่าง | เฉลี่ย | อาร์ค | HellaSwag | มจล | ความจริงQA |

|---|---|---|---|---|---|

| หิ่งห้อย-mixtral-8x7b | 70.16 | 68.09 | 85.76 | 71.49 | 55.31 |

| Yi-34B-แชท | 69.97 | 65.44 | 84.16 | 74.9 | 55.37 |

| หิ่งห้อย-llama-30b | 64.83 | 64.25 | 83.64 | 58.23 | 53.2 |

| Falcon-40b-instruct | 63.47 | 61.6 | 84.31 | 55.45 | 52.52 |

| กวานาโก-33b | 62.98 | 62.46 | 84.48 | 53.78 | 51.22 |

| หิ่งห้อย-llama2-13b-v1.2 | 62.17 | 60.67 | 80.46 | 56.51 | 51.03 |

| หิ่งห้อย-llama2-13b | 62.04 | 59.13 | 81.99 | 55.49 | 51.57 |

| วิคูนา-13b-v1.5 | 61.63 | 56.57 | 81.24 | 56.67 | 51.51 |

| mpt-30b-แชท | 61.21 | 58.7 | 82.54 | 51.16 | 52.42 |

| ตัวช่วยสร้างlm-13b-v1.2 | 60.79 | 59.04 | 82.21 | 54.64 | 47.27 |

| วิคูน่า-13b-v1.3 | 60.01 | 54.61 | 80.41 | 52.88 | 52.14 |

| llama-2-13b-แชท | 59.93 | 59.04 | 81.94 | 54.64 | 44.12 |

| วิคูนา-13b-v1.1 | 59.21 | 52.73 | 80.14 | 51.9 | 52.08 |

| กวานาโก-13b | 59.18 | 57.85 | 83.84 | 48.28 | 46.73 |

การใช้รหัสการฝึกอบรมของโครงการนี้ และข้อมูลการฝึกอบรมข้างต้น เราฝึกอบรมและเปิดซอร์สน้ำหนักแบบจำลองต่อไปนี้

โมเดลจีน:

| แบบอย่าง | โมเดลพื้นฐาน | ความยาวการฝึกอบรม |

|---|---|---|

| หิ่งห้อย-baichuan2-13b | baichuan-inc/Baichuan2-13B-ฐาน | 1,024 |

| หิ่งห้อย-baichuan-13b | baichuan-inc/Baichuan-13B-ฐาน | 1,024 |

| หิ่งห้อย-qwen-7b | คิวเวน/คิวเวน-7B | 1,024 |

| หิ่งห้อย-chatglm2-6b | THUDM/chatglm2-6b | 1,024 |

| หิ่งห้อย-internlm-7b | ฝึกงาน/ฝึกงาน-7b | 1,024 |

| หิ่งห้อย-baichuan-7b | baichuan-inc/baichuan-7B | 1,024 |

| หิ่งห้อย-ziya-13b | YeungNLP/Ziya-LLaMA-13B-Pretrain-v1 | 1,024 |

| หิ่งห้อย-bloom-7b1 | วิทยาศาสตร์ขนาดใหญ่/bloom-7b1 | 1,024 |

| หิ่งห้อย-bloom-2b6-v2 | หยางNLP/bloom-2b6-zh | 512 |

| หิ่งห้อย-bloom-2b6 | หยางNLP/bloom-2b6-zh | 512 |

| หิ่งห้อย-bloom-1b4 | หยางNLP/bloom-1b4-zh | 512 |

โมเดลภาษาอังกฤษ:

| แบบอย่าง | โมเดลพื้นฐาน | ความยาวการฝึกอบรม |

|---|---|---|

| หิ่งห้อย-mixtral-8x7b | มิสทราไล/Mixtral-8x7B-v0.1 | 1,024 |

| หิ่งห้อย-llama-30b | ฮักกิลลามะ/ลามะ-30b | 1,024 |

| หิ่งห้อย-llama-13-v1.2 | นูสรีเสิร์ช/ลามะ-2-13b-hf | 1,024 |

| หิ่งห้อย-llama2-13b | นูสรีเสิร์ช/ลามะ-2-13b-hf | 1,024 |

| หิ่งห้อย-llama-13b-v1.2 | ฮักกิลลามะ/ลามะ-13b | 1,024 |

| หิ่งห้อย-llama-13b | ฮักกิลลามะ/ลามะ-13b | 1,024 |

ในปัจจุบัน โครงการนี้จัดชุดข้อมูลคำสั่งต่อไปนี้เป็นหลักและจัดระเบียบให้อยู่ในรูปแบบข้อมูลแบบครบวงจร:

| ชุดข้อมูล | แนะนำ |

|---|---|

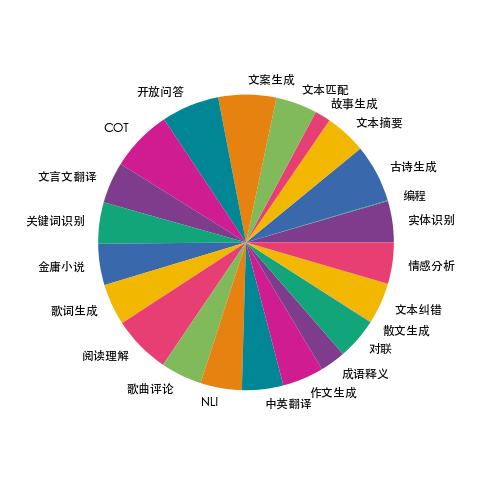

| หิ่งห้อย-รถไฟ-1.1M | เรารวบรวมข้อมูลเกี่ยวกับงาน NLP ภาษาจีนทั่วไป 23 รายการ และสร้างข้อมูลมากมายที่เกี่ยวข้องกับวัฒนธรรมจีน เช่น โคลงกลอน บทกวี การแปลภาษาจีนคลาสสิก ร้อยแก้ว นวนิยายจินหยง ฯลฯ สำหรับแต่ละงาน จะมีการเขียนเทมเพลตคำสั่งหลายแบบด้วยตนเองเพื่อให้แน่ใจว่าข้อมูลมีคุณภาพสูงและสมบูรณ์ จำนวนข้อมูลคือ 1.15 ล้าน |

| moss-003-sft-ข้อมูล | ข้อมูลบทสนทนาหลายรอบภาษาจีนและอังกฤษเปิดแหล่งที่มาโดยทีมงาน MOSS ของมหาวิทยาลัย Fudan ซึ่งมีข้อมูลมากกว่า 1 ล้านข้อมูล |

| อัลตร้าแชท | ข้อมูลการสนทนาแบบหลายเลี้ยวภาษาอังกฤษเปิดแหล่งที่มาโดยมหาวิทยาลัย Tsinghua ซึ่งมีข้อมูลมากกว่า 1.4 ล้านข้อมูล |

| ตัวช่วยสร้างLM_evol_instruct_V2_143k | ชุดข้อมูลการปรับแต่งคำสั่งภาษาอังกฤษแบบโอเพ่นซอร์สโดยโปรเจ็กต์ WizardLM ใช้เมธอด Evol-Instruct เพื่อพัฒนาคำสั่งและเพิ่มความซับซ้อนของคำสั่ง เพื่อปรับปรุงความสามารถของโมเดลในการทำตามคำแนะนำที่ซับซ้อน มีข้อมูล 143,000 ชิ้น |

| school_math_0.25M | ข้อมูลคำแนะนำการดำเนินการทางคณิตศาสตร์ที่มาจากทีมงานโครงการ BELLE มีข้อมูล 250,000 ชิ้น |

| แชร์AI/CodeChat | โดยส่วนใหญ่จะประกอบด้วยตัวอย่างคลังข้อมูลที่เกี่ยวข้องกับการใช้เหตุผลเชิงตรรกะ คำถามและคำตอบเกี่ยวกับโค้ด และการสร้างโค้ด |

| shareAI/ShareGPT-จีน-อังกฤษ-90k | ชุดข้อมูลคำถามและคำตอบมนุษย์-เครื่องจักรคุณภาพสูงสองภาษาคู่ขนานภาษาจีนและอังกฤษ ครอบคลุมคำถามของผู้ใช้ในสถานการณ์ที่ซับซ้อนจริง |

| ultrachat_200k | ข้อมูลการปรับแต่งคำสั่งภาษาอังกฤษแบบโอเพ่นซอร์สโดยโครงการ Zephyr ได้รับการทำความสะอาดตามข้อมูล ultrachat |

| ultrafeedback_binarized | ชุดข้อมูลการตั้งค่าภาษาอังกฤษ สามารถใช้สำหรับการฝึกอบรม DPO ได้ |

ข้อมูลข้างต้นสามารถเลือก สุ่มตัวอย่าง หรือรวมเข้าด้วยกันได้ตามต้องการ หากคุณกำลังฝึกโมเดลภาษาจีน ขอแนะนำให้ลองใช้ข้อมูลมอส ในภาษาอังกฤษ คุณสามารถลองใช้ข้อมูล ultrachat และ WizardLM

ข้อมูลการฝึกอบรมอยู่ในรูปแบบ jsonl รูปแบบข้อมูลของแต่ละแถวมีดังนี้ ฟิลด์การสนทนาเป็นสิ่งที่จำเป็น และสามารถเพิ่มหรือลบฟิลด์อื่นๆ ได้ตามความต้องการที่แท้จริง คุณสามารถอ้างอิงถึงไฟล์ data/dummy_data.jsonl ในโปรเจ็กต์ได้

{

"conversation_id" : 44 ,

"category" : " Brainstorming " ,

"conversation" :[

{

"human" : "怎么能够有效地提升个人能力? " ,

"assistant" : "提升个人能力可以通过以下几个方面实现: nn 1. 学习新知识和技能:阅读相关书籍、参加课程和工作坊、观看教育视频等学习方式,可以帮助你掌握新的知识和技能,从而提升个人能力。 nn 2. 持续练习和实践:不断地练习和实践所学的知识和技能,可以帮助你更好地掌握和应用这些技能,提高你的表现和效率。 nn 3. 寻求反馈和改进:寻求他人的反馈和建议可以帮助你发现自己的不足之处,进一步完善和改进自己的能力。 nn 4. 建立良好的工作和生活习惯:建立良好的工作和生活习惯,如合理安排时间、注意健康、保持积极态度等,可以提高你的工作效率和生活品质,从而提升个人能力。 nn 5. 社交和交流:与他人交流和合作,可以帮助你更好地了解他人的观点和经验,从而提升自己的能力和见识。 "

},

{

"human" : "对于初学者来说,如何快速掌握编程技能? " ,

"assistant":"以下是几个建议,可以帮助初学者快速掌握编程技能:nn1. 学习基础知识:建议先学习编程语言的基础知识和语法,例如变量、数据类型、控制结构、函数等。可以通过在线课程、编程书籍、视频教程等方式学习。nn2. 实践编程:进行实际的编程练习是非常重要的,可以通过参加编程挑战、编写小项目等方式来进行实践。nn3. 寻求反馈:可以寻求他人的反馈和建议,例如在线编程社区、编程导师等,他们可以帮助你发现问题并及时纠正。nn4. 阅读优秀代码:阅读和分析优秀的代码可以帮助你学习其他程序员的编程思路和技巧,从而提高自己的编程能力。nn5. 不断学习和更新:编程技术和工具在不断更新和发展,因此需要不断学习新的知识和技能,例如学习新的编程语言、框架、工具等,以跟上技术的发展和变化。nn总之,学习编程需要耐心和坚持,并且需要不断地实践和学习。通过以上建议,可以帮助初学者快速掌握编程技能。"

},

{

"human" : "除了参加编程挑战和阅读代码,还有哪些方式可以提升自己的编程能力呢? " ,

"assistant":"除了参加编程挑战和阅读代码,还有以下几种方式可以提升自己的编程能力:nn1. 参与开源项目:加入一个开源项目,可以让你了解到实际的软件开发流程和团队合作方式,并且可以与其他开发人员合作,学习和分享编程技巧和经验。nn2. 进行代码重构:对已经编写的代码进行重构,可以帮助你了解更好的编程实践和设计模式,从而提高代码的可读性和可维护性。nn3. 练习算法和数据结构:算法和数据结构是编程中的重要基础,练习算法和数据结构可以帮助你了解不同的数据结构和算法,从而更好地解决实际问题。nn4. 学习软件工程和架构:学习软件工程和架构的知识,可以帮助你了解如何设计和构建可靠、可扩展和可维护的软件系统。nn5. 参加编程社区和论坛:参加编程社区和论坛可以让你与其他开发人员分享和讨论编程经验和技巧,了解最新的技术趋势和解决方案。nn总之,提升编程能力需要不断地学习和实践,并与其他开发人员和编程专家进行交流和合作,以获取更多的经验和知识。"

},

{

"human" : "你有没有推荐的编程挑战网站? " ,

"assistant":"当然,以下是一些值得推荐的编程挑战网站:nn1. HackerRank:HackerRank 是一个全球领先的技术招聘平台,提供数百种编程挑战和比赛,包括算法、数据结构、数学、SQL、AI 等多个技术领域。nn2. LeetCode:LeetCode 是一个在线编程学习和实践平台,提供数千道编程题目,主要涵盖算法和数据结构。nn3. Codeforces:Codeforces 是一个全球知名的编程竞赛网站,提供数百个比赛和练习题目,主要涵盖算法和数据结构。nn4. Codewars:Codewars 是一个在线编程学习和实践平台,提供数千道编程题目,主要涵盖算法、数据结构、面向对象编程等多个技术领域。nn5. Project Euler:Project Euler 是一个非营利性的在线编程挑战平台,提供一系列数学和计算机科学问题,需要用编程语言进行解答。nn以上这些编程挑战网站可以帮助你提高编程能力,并且可以与其他编程爱好者进行交流和竞争。"

},

{

"human" : "在学习编程的过程中,如何避免陷入困境和放弃呢? " ,

"assistant":"学习编程是一个需要长期坚持和不断学习的过程,以下是一些避免陷入困境和放弃的方法:nn1. 制定合理的学习计划:制定合理的学习计划,包括学习时间、学习内容、目标等,可以帮助你更好地管理时间和精力,避免学习过程中的松懈和分心。nn2. 寻找合适的学习资源:选择适合自己的学习资源,例如在线课程、编程书籍、视频教程等,可以让你更好地了解和掌握编程知识和技能。nn3. 寻求帮助和支持:在学习过程中,遇到问题和困难是很正常的,可以寻求他人的帮助和支持,例如参加编程社区、找到编程导师等。nn4. 进行实践和项目:实践和项目是学习编程的重要组成部分,可以帮助你更好地了解和掌握编程技能,同时也可以提高学习的兴趣和动力。nn5. 坚持并保持兴趣:坚持学习和保持兴趣是学习编程的关键。可以通过参加编程社区、参加编程竞赛、与其他编程爱好者交流等方式来保持兴趣和动力。nn总之,学习编程需要耐心和坚持,并需要不断学习和实践。通过以上方法可以帮助你避免陷入困境和放弃。"

}

],

}การกระจายข้อมูลของหิ่งห้อย-รถไฟ-1.1M แสดงในรูปด้านล่าง:

สำหรับรูปแบบข้อมูล โปรดดูไฟล์ data/pretrain/dummy_pretrain.jsonl ในโปรเจ็กต์

สำหรับรูปแบบข้อมูล โปรดดูไฟล์ data/dummy_dpo.jsonl ในโปรเจ็กต์

หากมีการรายงานข้อผิดพลาดระหว่างการฝึก คุณสามารถตรวจสอบคำถามที่พบบ่อยก่อนได้

เราแยกส่วนประกอบต่างๆ ที่ใช้ในการฝึกอบรมเพื่อการขยายและการเพิ่มประสิทธิภาพในภายหลัง สำหรับรายละเอียด โปรดดูการใช้งานในไดเรกทอรีส่วนประกอบ การกำหนดค่าพารามิเตอร์ระหว่างการฝึกจะถูกจัดเก็บไว้ในไดเร็กทอรี train_args เพื่ออำนวยความสะดวกในการจัดการและการเปลี่ยนแปลงแบบรวมศูนย์ คุณสามารถดูการกำหนดค่าการฝึกของรุ่นต่างๆ ได้ในไดเร็กทอรี train_args และแก้ไขหรือเพิ่มได้ตามต้องการ

เวอร์ชันของแพ็คเกจ Python หลักหลายเวอร์ชันได้รับการแก้ไขภายใต้ Requirements.txt เพียงรันสคริปต์ต่อไปนี้ สังเกต:

pip install requirements.txtหากคุณต้องการเปิดใช้งาน Unsloth ขอแนะนำให้ติดตั้งหรืออัปเดตแพ็คเกจ Python ต่อไปนี้:

pip install git+https://github.com/unslothai/unsloth.git

pip install bitsandbytes==0.43.1

pip install peft==0.10.0

pip install torch==2.2.2

pip install xformers==0.0.25.post1หากคุณต้องการใช้ Unsloth เพื่อฝึก Qwen1.5 ให้ติดตั้งแพ็คเกจต่อไปนี้:

pip install git+https://github.com/yangjianxin1/unsloth.gitในระหว่างการฝึกล่วงหน้า เราใช้การสูญเสียอัตโนมัติแบบคลาสสิก นั่นคือโทเค็นในแต่ละตำแหน่งจะมีส่วนร่วมในการคำนวณการสูญเสีย

เมื่อปรับแต่งคำสั่งอย่างละเอียด เราจะคำนวณเฉพาะการสูญเสียส่วนการฟื้นตัวของผู้ช่วยเหลือเท่านั้น

ไดเร็กทอรี train_args จัดเก็บไฟล์การกำหนดค่าสำหรับโมเดลที่แตกต่างกันโดยใช้วิธีการฝึกอบรมที่แตกต่างกัน พารามิเตอร์หลักมีคำอธิบายดังนี้:

จำเป็นต้องตั้งค่าพารามิเตอร์ต่อไปนี้เมื่อใช้การฝึกอบรม QLoRA:

เกี่ยวกับการกำหนดค่าพารามิเตอร์ของ deepspeed คุณสามารถแก้ไขได้ตามต้องการ

การฝึกอบรมล่วงหน้าพารามิเตอร์แบบเต็ม แทนที่ {num_gpus} ด้วยจำนวนกราฟิกการ์ด:

deepspeed --num_gpus={num_gpus} train.py --train_args_file train_args/pretrain/full/bloom-1b1-pretrain-full.jsonการปรับแต่งคำสั่งพารามิเตอร์ทั้งหมดอย่างละเอียด โดยแทนที่ {num_gpus} ด้วยจำนวนกราฟิกการ์ด:

deepspeed --num_gpus={num_gpus} train.py --train_args_file train_args/sft/full/bloom-1b1-sft-full.jsonบัตรเดี่ยว QLoRA การฝึกอบรมล่วงหน้า:

python train.py --train_args_file train_args/pretrain/qlora/yi-6b-pretrain-qlora.jsonการปรับแต่งคำสั่ง QLoRA ของการ์ดเดี่ยว:

python train.py --train_args_file train_args/sft/qlora/yi-6b-sft-qlora.jsonการฝึกอบรมล่วงหน้า Doka QLoRA:

torchrun --nproc_per_node={num_gpus} train.py --train_args_file train_args/pretrain/qlora/yi-6b-pretrain-qlora.jsonการปรับแต่งคำสั่ง Doka QLoRA อย่างละเอียด:

torchrun --nproc_per_node={num_gpus} train.py --train_args_file train_args/sft/qlora/yi-6b-sft-qlora.jsonบัตรใบเดียว QLoRA สำหรับการฝึกอบรม DPO:

python train.py --train_args_file train_args/sft/qlora/minicpm-2b-dpo-qlora.jsonหากคุณใช้ LoRA หรือ QLoRA สำหรับการฝึก โปรเจ็กต์นี้จะบันทึกเฉพาะน้ำหนักและไฟล์การกำหนดค่าของอะแดปเตอร์ และคุณจะต้องรวมน้ำหนักของอะแดปเตอร์เข้ากับโมเดลพื้นฐาน สำหรับสคริปต์ โปรดดูที่ script/merge_lora.py

เราจัดทำสคริปต์เชิงโต้ตอบสำหรับการสนทนาหลายรอบ โปรดดูรายละเอียดในไดเรกทอรีสคริปต์/แชท template_name ที่ตั้งค่าไว้ในสคริปต์จะต้องสอดคล้องกับ template_name ในระหว่างการฝึกโมเดล

cd script/chat

python chat.pytop_p, อุณหภูมิ, repetition_penalty, do_sample และพารามิเตอร์อื่นๆ ในสคริปต์การสร้างมีผลกระทบอย่างมากต่อเอฟเฟกต์การสร้างของโมเดล และสามารถแก้ไขและแก้ไขได้ตามสถานการณ์การใช้งานของคุณเอง

สคริปต์การอนุมานรองรับการใช้โมเดลพื้นฐานและอะแดปเตอร์สำหรับการอนุมาน ข้อเสียคือทุกครั้งที่สคริปต์เริ่มต้น จะต้องรวมน้ำหนักเข้าด้วยกัน ซึ่งใช้เวลานาน

รองรับการใช้ 4 บิตสำหรับการอนุมาน ความต้องการหน่วยความจำเหลือน้อย และเอฟเฟกต์จะลดลงเล็กน้อย

หาก OOM เกิดขึ้น คุณสามารถลดพารามิเตอร์ เช่น per_device_train_batch_size และ max_seq_length เพื่อบรรเทาได้ คุณยังสามารถตั้งค่า gradient_checkpointing=true ได้ด้วย ซึ่งสามารถลดการใช้หน่วยความจำได้อย่างมาก แต่ความเร็วในการฝึกจะช้าลง

แต่ละแพ็คเกจของ Python มีเวอร์ชันต่างๆ ใน Requirements.txt

pip install -r requirements.txtคุณสามารถระบุการใช้การ์ดหมายเลข 0 และหมายเลข 1 ในการฝึกอบรมได้ดังนี้:

CUDA_VISIBLE_DEVICES=0,1 torchrun --nproc_per_node={num_gpus} train_qlora.py --train_args_file train_args/qlora/baichuan-7b-sft-qlora.jsonการฝึกอบรม Baichuan2 จำเป็นต้องติดตั้ง torch==2.0 และถอนการติดตั้ง xformers และ apex มิฉะนั้นข้อผิดพลาดจะถูกรายงาน

RuntimeError: No such operator xformers::efficient_attention_forward_generic - did you forget to build xformers with `python setup.py develop`?

Qwen จำเป็นต้องถอนการติดตั้ง flash-attn สำหรับการฝึกอบรม QLoRA ไม่เช่นนั้นระบบจะรายงานข้อผิดพลาด:

assert all((i.dtype in [torch.float16, torch.bfloat16] for i in (q, k, v)))

หลังจากการสอบถาม ปัญหานี้มีอยู่อย่างกว้างขวางในปัญหาในฐานรหัสอย่างเป็นทางการของ Qwen หากคุณฝึก Qwen-Base และ Yi-Base ขอแนะนำให้ตั้งค่า template_name="default" เพื่อหลีกเลี่ยงปัญหานี้ หากคุณดำเนินการ SFT ในรุ่น Qwen-Chat และ Yi-Chat ปัญหานี้จะไม่เกิดขึ้น คุณสามารถตั้งค่า template_name เป็น "qwen" และ "yi" ตามลำดับ

หมายเหตุ: ปัญหานี้ไม่มีอยู่ใน Qwen1.5

เนื่องจากปัจจัยต่างๆ เช่น ข้อจำกัดของพารามิเตอร์โมเดลและระดับการทำความสะอาดข้อมูลการฝึกอบรม โมเดลโอเพ่นซอร์สของโปรเจ็กต์นี้อาจมีข้อจำกัดดังต่อไปนี้:

ตามข้อจำกัดของโมเดลข้างต้น เรากำหนดให้โค้ด ข้อมูล และโมเดลของโปรเจ็กต์นี้จะต้องไม่ถูกนำไปใช้เพื่อวัตถุประสงค์ที่ก่อให้เกิดอันตรายต่อสังคม และต้องปฏิบัติตามใบอนุญาตเชิงพาณิชย์ของโมเดลพื้นฐาน

หากคุณใช้ข้อมูล รหัส หรือแบบจำลองจากโครงการนี้ โปรดอ้างอิงโครงการนี้

@misc{Firefly,

author = {Jianxin Yang},

title = {Firefly(流萤): 中文对话式大语言模型},

year = {2023},

publisher = {GitHub},

journal = {GitHub repository},

howpublished = {url{https://github.com/yangjianxin1/Firefly}},

}