คู่มือนี้จะช่วยคุณรวบรวมและทดสอบผลิตภัณฑ์ RHEL AI เวอร์ชันตัวอย่างสำหรับนักพัฒนา

ยินดีต้อนรับสู่ ตัวอย่างนักพัฒนา Red Hat Enterprise Linux AI! คู่มือนี้มีไว้เพื่อแนะนำให้คุณรู้จักกับความสามารถการแสดงตัวอย่างของนักพัฒนา RHEL AI เช่นเดียวกับตัวอย่างสำหรับนักพัฒนาอื่นๆ คาดว่าจะมีการเปลี่ยนแปลงในเวิร์กโฟลว์เหล่านี้ ระบบอัตโนมัติเพิ่มเติมและลดความซับซ้อน ตลอดจนการขยายความสามารถ เวอร์ชันที่รองรับฮาร์ดแวร์และซอฟต์แวร์ การปรับปรุงประสิทธิภาพ (และการเพิ่มประสิทธิภาพอื่นๆ) ก่อน GA

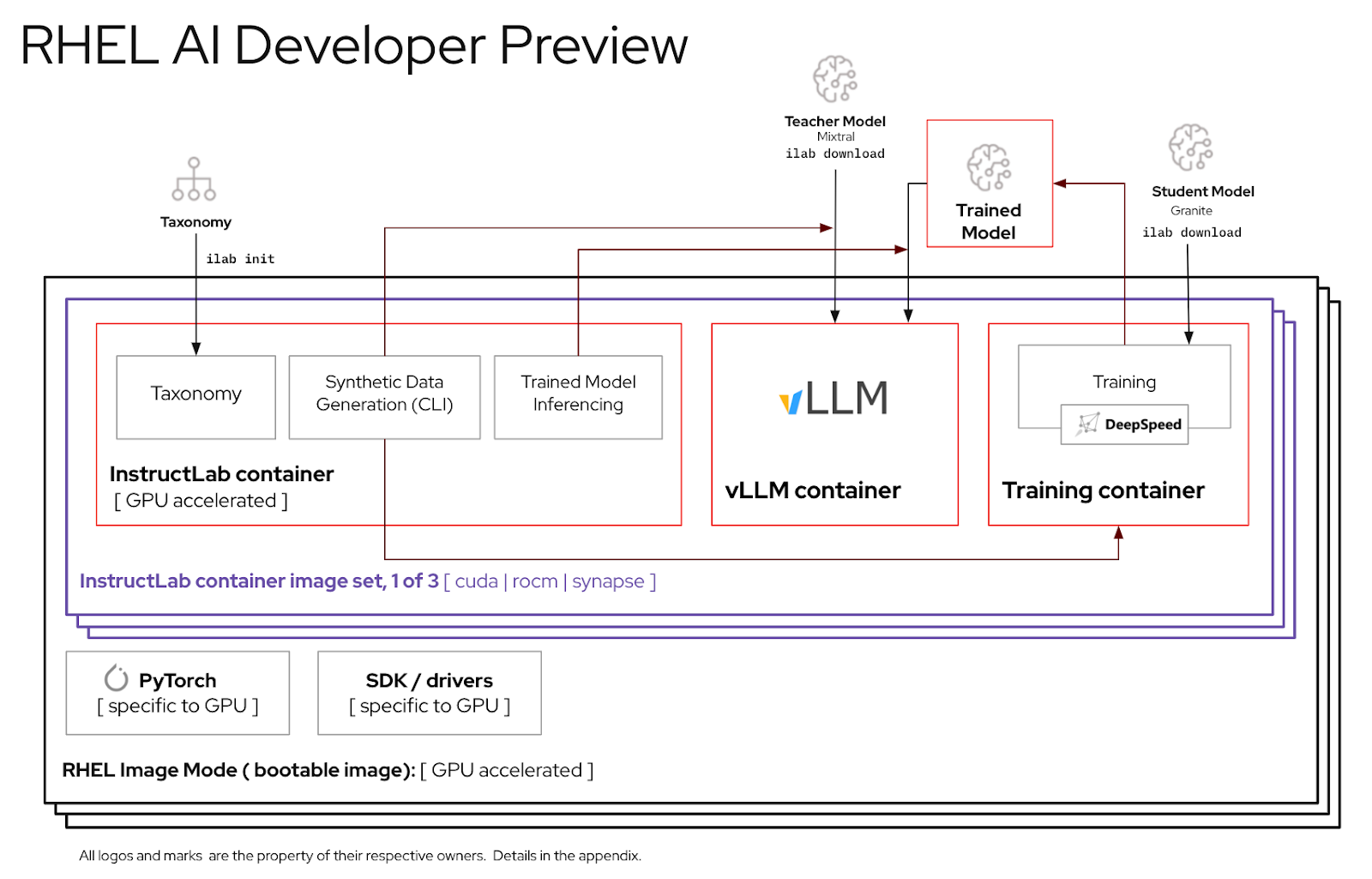

RHEL AI เป็นผลิตภัณฑ์โอเพ่นซอร์สที่ประกอบด้วย:

บันทึก

RHEL AI กำหนดเป้าหมายไปที่แพลตฟอร์มเซิร์ฟเวอร์และเวิร์กสเตชันที่มี GPU แยก สำหรับแล็ปท็อป โปรดใช้ InstructLab ขั้นต้น

นี่คือรายการเซิร์ฟเวอร์ที่วิศวกร Red Hat ตรวจสอบเพื่อทำงานร่วมกับ RHEL AI Developer Preview เราคาดว่าระบบล่าสุดที่ได้รับการรับรองให้รัน RHEL 9 พร้อมด้วย GPU สำหรับศูนย์ข้อมูลล่าสุด เช่น รายการด้านล่างนี้ จะทำงานร่วมกับหน้าตัวอย่างสำหรับนักพัฒนานี้ได้

| ผู้จำหน่าย GPU / ข้อมูลจำเพาะ | ดูตัวอย่าง RHEL AI Dev |

|---|---|

| เดลล์ (4) NVIDIA H100 | ใช่ |

อินสแตนซ์ IBM GX3 | ใช่ |

| เลอโนโว (8) AMD MI300x | ใช่ |

| อินสแตนซ์ AWS p4 และ p5 (NVIDIA) | กำลังดำเนินการอยู่ |

| อินเทล | กำลังดำเนินการอยู่ |

เพื่อประสบการณ์ที่ดีที่สุดในการใช้ช่วงแสดงตัวอย่างนักพัฒนา RHEL AI เราได้รวมแผนผังอนุกรมวิธานที่ถูกตัดออกไว้ในคอนเทนเนอร์ InstructLab ซึ่งจะช่วยให้สามารถตรวจสอบการฝึกอบรมให้เสร็จสิ้นภายในกรอบเวลาที่เหมาะสมบนเซิร์ฟเวอร์เดียว

สูตร: GPU ตัวเดียวสามารถฝึกตัวอย่างได้ประมาณ 250 ตัวอย่างต่อนาที หากคุณมี GPU 8 ตัวและตัวอย่าง 10,000 รายการ คาดว่าจะต้องใช้

เมื่อสิ้นสุดแบบฝึกหัดนี้ คุณจะมี:

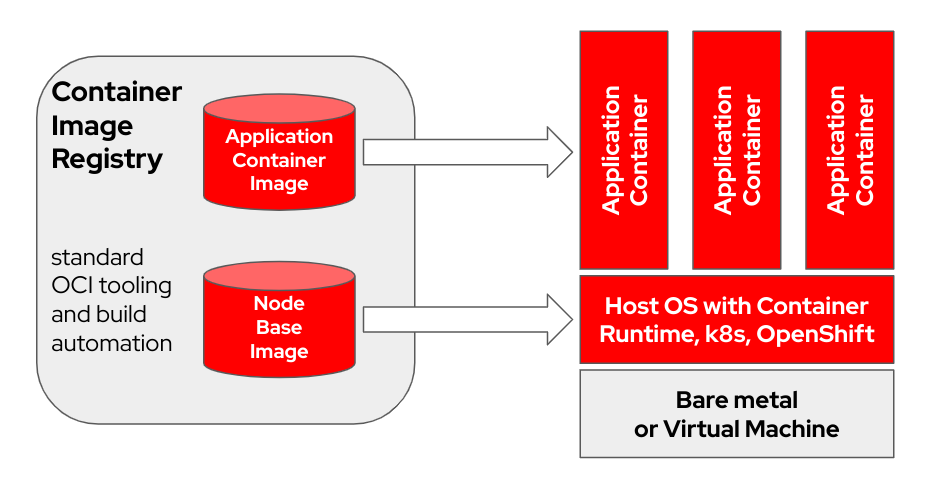

bootc คือระบบปฏิบัติการแบบแทนที่ซึ่งจัดเตรียมและอัปเดตโดยใช้อิมเมจคอนเทนเนอร์ OCI/Docker bootc เป็นองค์ประกอบสำคัญในภารกิจที่กว้างขึ้นของคอนเทนเนอร์ที่สามารถบูตได้

โมเดลคอนเทนเนอร์ Docker ดั้งเดิมที่ใช้ "เลเยอร์" เพื่อสร้างโมเดลแอปพลิเคชันประสบความสำเร็จอย่างมาก โครงการนี้มีจุดมุ่งหมายเพื่อใช้เทคนิคเดียวกันสำหรับระบบโฮสต์ที่สามารถบูตได้ โดยใช้คอนเทนเนอร์ OCI/Docker มาตรฐานเป็นรูปแบบการขนส่งและการจัดส่งสำหรับการอัพเดตระบบปฏิบัติการพื้นฐาน

อิมเมจคอนเทนเนอร์ประกอบด้วยเคอร์เนล Linux (เช่น /usr/lib/modules ) ซึ่งใช้ในการบูต ณ รันไทม์บนระบบเป้าหมาย พื้นที่ผู้ใช้พื้นฐานไม่ได้ทำงานในคอนเทนเนอร์ตามค่าเริ่มต้น ตัวอย่างเช่น สมมติว่า systemd ใช้งานอยู่ systemd จะทำหน้าที่เป็น pid1 ตามปกติ - ไม่มีกระบวนการ "ภายนอก"

ในตัวอย่างต่อไปนี้ คอนเทนเนอร์ bootc มีป้ายกำกับว่า Node Base Image :

ขึ้นอยู่กับฮาร์ดแวร์โฮสต์บิลด์และความเร็วการเชื่อมต่ออินเทอร์เน็ตของคุณ การสร้างและการอัพโหลดอิมเมจคอนเทนเนอร์อาจใช้เวลานานถึง 2 ชั่วโมง

m5.xlarge โดยใช้ที่เก็บข้อมูล GP3)quay.io หรือรีจีสทรีอิมเมจอื่น ลงทะเบียนโฮสต์ (จะลงทะเบียนและสมัครสมาชิกระบบ RHEL กับพอร์ทัลลูกค้า Red Hat โดยใช้ Red Hat Subscription-Manager ได้อย่างไร)

sudo subscription-manager register --username < username > --password < password >ติดตั้งแพ็คเกจที่จำเป็น

sudo dnf install git make podman buildah lorax -yโคลน repo คอมไพล์ตัวอย่าง RHEL AI Developer

git clone https://github.com/RedHatOfficial/rhelai-dev-preview ตรวจสอบสิทธิ์รีจิสทรี Red Hat (การตรวจสอบสิทธิ์รีจิสทรี Red Hat Container) โดยใช้บัญชี redhat.com ของคุณ

podman login registry.redhat.io --username < username > --password < password >

podman login --get-login registry.redhat.io

Your_login_here ตรวจสอบให้แน่ใจว่าคุณมีคีย์ SSH บนโฮสต์บิลด์ ซึ่งใช้ในระหว่างการสร้างอิมเมจชุดเครื่องมือไดรเวอร์ (การใช้ ssh-keygen และการแชร์สำหรับการตรวจสอบสิทธิ์แบบใช้คีย์ใน Linux | เปิดใช้งาน Sysadmin)

RHEL AI มีชุด Makefiles เพื่ออำนวยความสะดวกในการสร้างอิมเมจคอนเทนเนอร์ อาจใช้เวลานานถึงหนึ่งชั่วโมง ขึ้นอยู่กับฮาร์ดแวร์โฮสต์บิลด์และความเร็วการเชื่อมต่ออินเทอร์เน็ตของคุณ

สร้างอิมเมจคอนเทนเนอร์ InstructLab NVIDIA

make instruct-nvidia สร้างอิมเมจคอนเทนเนอร์ vllm

make vllm สร้างอิมเมจคอนเทนเนอร์ deepspeed

make deepspeed สุดท้าย สร้าง bootc RHEL AI NVIDIA นี่คือคอนเทนเนอร์ "บูตได้" ในโหมดรูปภาพ RHEL เราฝัง 3 รูปภาพด้านบนลงในคอนเทนเนอร์นี้

make nvidia FROM=registry.redhat.io/rhel9/rhel-bootc:9.4 REGISTRY= < your-registry > REGISTRY_ORG= < your-org-name > รูปภาพที่ได้จะถูกแท็ก ${REGISTRY}/${REGISTRY_ORG}/nvidia-bootc:latest สำหรับตัวแปรและตัวอย่างเพิ่มเติม โปรดดูที่การฝึกอบรม/README

พุชอิมเมจผลลัพธ์ไปที่รีจิสตรีของคุณ คุณจะอ้างอิงถึง URL นี้ภายในไฟล์ Kickstart ในขั้นตอนต่อๆ ไป

podman push ${REGISTRY} / ${REGISTRY_ORG} /nvidia-bootc:latest

e.g. podman push quay.io/ < your-user-name > /nvidia-bootc.latestณ จุดนี้ คุณมีอิมเมจคอนเทนเนอร์ที่สามารถบูตได้ของ RHEL AI ที่พร้อมสำหรับการติดตั้งบนโฮสต์จริงหรือโฮสต์เสมือน

Anaconda เป็นตัวติดตั้ง Red Hat Enterprise Linux และฝังอยู่ในอิมเมจ ISO ที่สามารถดาวน์โหลดได้ของ RHEL ทั้งหมด วิธีการหลักในการติดตั้ง RHEL อัตโนมัติคือผ่านสคริปต์ที่เรียกว่า Kickstart หากต้องการข้อมูลเพิ่มเติมเกี่ยวกับ Anaconda และ Kickstart โปรดอ่านเอกสารเหล่านี้

คำสั่ง Kickstart ล่าสุดที่เรียกว่า ostreecontainer ได้รับการแนะนำพร้อมกับ RHEL 9.4 เราใช้ ostreecontainer เพื่อจัดเตรียมคอนเทนเนอร์ nvidia-bootc ที่สามารถบูตได้ซึ่งคุณเพิ่งส่งไปยังรีจิสทรีของคุณผ่านเครือข่าย

นี่คือตัวอย่างของไฟล์คิกสตาร์ท คัดลอกไปยังไฟล์ชื่อ rhelai-dev-preview-bootc.ks และปรับแต่งให้เหมาะกับสภาพแวดล้อมของคุณ:

# text

## customize this for your target system

# network --bootproto=dhcp --device=link --activate

## Basic partitioning

## customize this for your target system

# clearpart --all --initlabel --disklabel=gpt

# reqpart --add-boot

# part / --grow --fstype xfs

# ostreecontainer --url quay.io/<your-user-name>/nvidia-bootc:latest

# firewall --disabled

# services --enabled=sshd

## optionally add a user

# user --name=cloud-user --groups=wheel --plaintext --password

# sshkey --username cloud-user "ssh-ed25519 AAAAC3Nza....."

## if desired, inject an SSH key for root

# rootpw --iscrypted locked

# sshkey --username root "ssh-ed25519 AAAAC3Nza..."

# reboot

ดาวน์โหลด RHEL 9.4 “Boot ISO” และใช้คำสั่ง mkksiso เพื่อฝังคิกสตาร์ทลงใน RHEL boot ISO

mkksiso rhelai-dev-preview-bootc.ks rhel-9.4-x86_64-boot.iso rhelai-dev-preview-bootc-ks.isoณ จุดนี้คุณควรมี:

nvidia-bootc:latest : อิมเมจคอนเทนเนอร์ที่สามารถบู๊ตได้พร้อมรองรับ NVIDIA GPUrhelai-dev-preview-bootc.ks : ไฟล์คิกสตาร์ทที่ปรับแต่งเพื่อจัดเตรียม RHEL จากรีจิสตรีคอนเทนเนอร์ของคุณไปยังระบบเป้าหมายของคุณrhelai-dev-preview-bootc-ks.iso : RHEL 9.4 ISO ที่สามารถบู๊ตได้พร้อมคิกสตาร์ทฝังอยู่ บูตระบบเป้าหมายของคุณโดยใช้ไฟล์ rhelai-dev-preview-bootc-ks.iso อนาคอนดาจะดึง nvidia-bootc: รูปภาพล่าสุดจากรีจิสตรีของคุณและจัดเตรียม RHEL ตามไฟล์คิกสตาร์ทของคุณ

ทางเลือก : ไฟล์ Kickstart สามารถให้บริการผ่าน HTTP ในการติดตั้งผ่านบรรทัดคำสั่งเคอร์เนลและเซิร์ฟเวอร์ HTTP ภายนอก – เพิ่ม inst.ks=http(s)://kickstart/url/rhelai-dev-preview-bootc.ks

ก่อนที่จะใช้สภาพแวดล้อม RHEL AI คุณต้องดาวน์โหลดสองโมเดล โดยแต่ละโมเดลได้รับการปรับแต่งให้เหมาะกับฟังก์ชันหลักในกระบวนการปรับแต่งที่มีความเที่ยงตรงสูง หินแกรนิตถูกใช้เป็นแบบอย่างของนักเรียน และมีหน้าที่รับผิดชอบในการอำนวยความสะดวกในการฝึกอบรมโหมดที่ได้รับการปรับแต่งใหม่ Mixtral ถูกใช้เป็นแบบอย่างสำหรับครูและมีหน้าที่รับผิดชอบในการช่วยเหลือขั้นตอนการสร้างกระบวนการ LAB ซึ่งใช้ทักษะและความรู้ร่วมกันเพื่อสร้างชุดข้อมูลการฝึกอบรมที่หลากหลาย

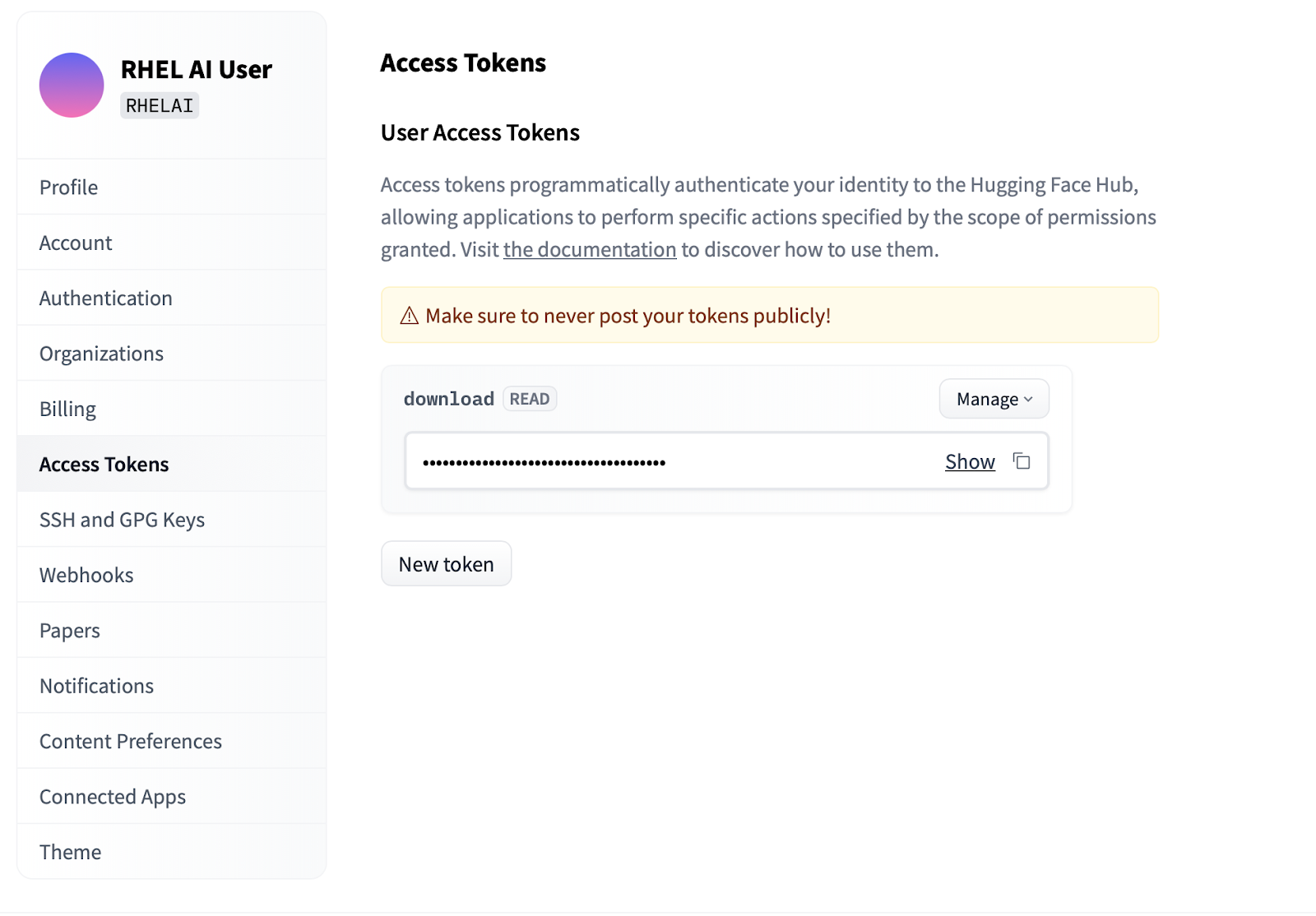

SettingsAccess Tokens คลิกปุ่ม New token แล้วระบุชื่อ โทเค็นใหม่ต้องใช้สิทธิ์ใน Read เท่านั้น เนื่องจากใช้เพื่อดึงโมเดลเท่านั้น บนหน้าจอนี้ คุณจะสามารถสร้างเนื้อหาโทเค็นและบันทึกและคัดลอกข้อความเพื่อตรวจสอบสิทธิ์ได้

อินเทอร์เฟซบรรทัดคำสั่ง ilab ซึ่งเป็นส่วนหนึ่งของโปรเจ็กต์ InstructLab มุ่งเน้นไปที่การใช้งานโมเดลเชิงปริมาณแบบน้ำหนักเบาบนอุปกรณ์คอมพิวเตอร์ส่วนบุคคล เช่น แล็ปท็อป ในทางตรงกันข้าม RHEL AI ช่วยให้สามารถใช้การฝึกอบรมที่มีความเที่ยงตรงสูงโดยใช้แบบจำลองที่มีความแม่นยำเต็มรูปแบบ เพื่อความคุ้นเคย คำสั่งและพารามิเตอร์จะเหมือนกับคำสั่ง ilab ของ InstructLab อย่างไรก็ตาม การดำเนินการสนับสนุนจะแตกต่างกันมาก

ใน RHEL AI คำสั่ง

ilabคือ wrapper ที่ทำหน้าที่เป็นส่วนหน้าของสถาปัตยกรรมคอนเทนเนอร์ที่รวมกลุ่มไว้ล่วงหน้าบนระบบ RHEL AI

ilabขั้นตอนแรกคือการสร้างไดเร็กทอรีการทำงานใหม่สำหรับโครงการของคุณ ทุกอย่างจะสัมพันธ์กับไดเร็กทอรีการทำงานนี้ โดยจะมีโมเดล บันทึก และข้อมูลการฝึกของคุณ

mkdir my-project

cd my-project คำสั่ง ilab แรกสุดที่คุณจะเรียกใช้จะตั้งค่าสภาพแวดล้อมพื้นฐาน รวมถึงการดาวน์โหลด repo แบบอนุกรมวิธานหากคุณเลือก ขั้นตอนนี้จำเป็นสำหรับขั้นตอนต่อไป ดังนั้นจึงแนะนำให้ดำเนินการดังกล่าว

ilab initกำหนดตัวแปรสภาพแวดล้อมโดยใช้โทเค็น HF ที่คุณสร้างในส่วนด้านบนภายใต้โทเค็นการเข้าถึง

export HF_TOKEN= < paste token value here > จากนั้น ดาวน์โหลดโมเดลพื้นฐานของ IBM Granite สำคัญ: อย่าดาวน์โหลดโมเดลเวอร์ชัน "แล็บ" แบบ จำลองฐาน หินแกรนิตจะมีประสิทธิภาพมากที่สุดเมื่อทำการฝึกที่มีความเที่ยงตรงสูง

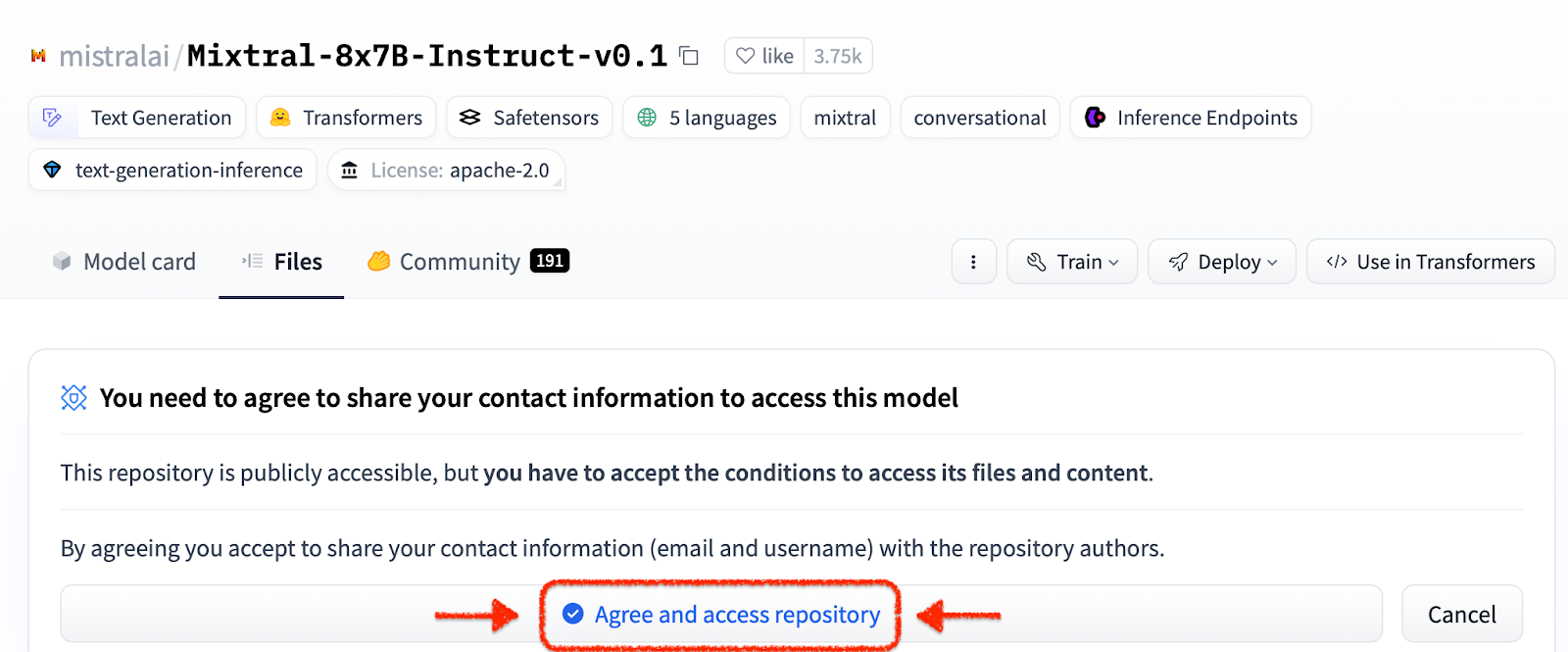

ilab download --repository ibm/granite-7b-baseทำตามขั้นตอนเดียวกันเพื่อดาวน์โหลดโมเดล Mixtral

ilab download --repository mistralai/Mixtral-8x7B-Instruct-v0.1ตอนนี้คุณได้เริ่มต้นโปรเจ็กต์และดาวน์โหลดโมเดลแรกของคุณแล้ว ให้สังเกตโครงสร้างไดเร็กทอรีของโปรเจ็กต์ของคุณ

my-project/

├─ models/

├─ generated/

├─ taxonomy/

├─ training/

├─ training_output/

├─ cache/

| โฟลเดอร์ | วัตถุประสงค์ |

|---|---|

| โมเดล | เก็บโมเดลภาษาทั้งหมด รวมถึงเอาต์พุตที่บันทึกไว้ของโมเดลภาษาที่คุณสร้างด้วย RHEL AI |

| สร้างขึ้น | เอาต์พุตข้อมูลที่สร้างขึ้นจากระยะการสร้าง สร้างขึ้นจากการแก้ไขที่เก็บอนุกรมวิธาน |

| อนุกรมวิธาน | ข้อมูลทักษะหรือความรู้ที่ใช้โดยวิธี LAB เพื่อสร้างข้อมูลสังเคราะห์สำหรับการฝึกอบรม |

| การฝึกอบรม | แปลงข้อมูลเริ่มต้นเพื่ออำนวยความสะดวกในกระบวนการฝึกอบรม |

| การฝึกอบรม_เอาท์พุท | ผลลัพธ์ชั่วคราวทั้งหมดของกระบวนการฝึกอบรม รวมถึงบันทึกและจุดตรวจสอบตัวอย่างบนเครื่องบิน |

| แคช | แคชภายในที่ใช้โดยข้อมูลโมเดล |

ขั้นตอนต่อไปคือการสนับสนุนความรู้หรือทักษะใหม่ๆ ในการซื้อคืนอนุกรมวิธาน ดูเอกสาร InstructLab สำหรับข้อมูลเพิ่มเติมและตัวอย่างวิธีดำเนินการนี้ เรายังมีชุดแบบฝึกหัดในห้องปฏิบัติการที่นี่ด้วย

ด้วยการเพิ่มข้อมูลอนุกรมวิธานเพิ่มเติม ขณะนี้คุณสามารถสร้างข้อมูลสังเคราะห์ใหม่เพื่อฝึกโมเดลใหม่ได้ในที่สุด แม้ว่าก่อนรุ่นจะสามารถเริ่มต้นได้ แต่โมเดลครูจะต้องเริ่มต้นก่อนเพื่อช่วยตัวสร้างในการสร้างข้อมูลใหม่ ในเซสชันเทอร์มินัลที่แยกต่างหาก ให้รันคำสั่ง "serve" และรอให้การเริ่มต้น VLLM เสร็จสิ้น โปรดทราบว่ากระบวนการนี้อาจใช้เวลาหลายนาทีจึงจะเสร็จสมบูรณ์

ilab serve

INFO: Application startup complete.

INFO: Uvicorn running on http://0.0.0.0:8080 (Press CTRL+C to quit) ขณะนี้ VLLM ให้บริการโหมดผู้สอนแล้ว กระบวนการสร้างสามารถเริ่มต้นได้โดยใช้คำสั่ง ilab create กระบวนการนี้จะใช้เวลาสักครู่จึงจะเสร็จสมบูรณ์ และจะส่งออกจำนวนคำสั่งทั้งหมดที่สร้างขึ้นเมื่อมีการอัปเดตอย่างต่อเนื่อง ค่าเริ่มต้นนี้อยู่ที่ 5,000 คำสั่ง แต่คุณสามารถปรับค่านี้ได้โดยใช้ตัวเลือก --num-instructions

ilab generate Q> How do cytokines influence the outcome of certain diseases involving tonsils?

A> The outcome of infectious, autoimmune, or malignant diseases affecting tonsils may be influenced by the overall balance of production profiles of pro-inflammatory and anti-inflammatory cytokines. Determining cytokine profiles in tonsil studies is essential for understanding the causes and underlying mechanisms of these disorders.

35%|████████████████████████████████████████▉

นอกเหนือจากข้อมูลปัจจุบันที่พิมพ์ลงหน้าจอระหว่างการสร้างแล้ว เอาต์พุตทั้งหมดจะถูกบันทึกลงในโฟลเดอร์ที่สร้างขึ้น ก่อนการฝึกอบรม ขอแนะนำให้ตรวจสอบผลลัพธ์นี้เพื่อยืนยันว่าตรงตามความคาดหวัง หากไม่เป็นที่พอใจ ให้ลองแก้ไขหรือสร้างตัวอย่างใหม่ในอนุกรมวิธานและรันใหม่

less generated/generated_Mixtral * .jsonเมื่อข้อมูลที่สร้างขึ้นเป็นที่น่าพอใจแล้ว กระบวนการฝึกอบรมก็สามารถเริ่มต้นได้ แม้ว่าจะปิดอินสแตนซ์ VLLM ในเซสชันเทอร์มินัลที่เริ่มต้นสำหรับการสร้างก็ตาม

CTRL+C

INFO: Application shutdown complete.

INFO: Finished server process [1]

คุณอาจได้รับข้อยกเว้น Python KeyboardInterrupt และการติดตามสแต็ก สิ่งนี้สามารถถูกเพิกเฉยได้อย่างปลอดภัย

เมื่อ VLLM หยุดทำงานและสร้างข้อมูลใหม่แล้ว กระบวนการฝึกอบรมสามารถเริ่มต้นได้โดยใช้คำสั่ง ilab train ตามค่าเริ่มต้น กระบวนการฝึกอบรมจะบันทึกจุดตรวจสอบแบบจำลองหลังจากทุกๆ 4999 ตัวอย่าง คุณสามารถปรับได้โดยใช้พารามิเตอร์ --num-samples นอกจากนี้ การฝึกจะมีค่าเริ่มต้นอยู่ที่ 10 epochs ซึ่งสามารถปรับได้ด้วยพารามิเตอร์ --num-epochs โดยทั่วไป ยุคที่มากขึ้นจะดีกว่า แต่หลังจากจุดหนึ่ง ยุคที่มากขึ้นจะส่งผลให้มียุคที่มากเกินไป โดยทั่วไปจะแนะนำให้อยู่ภายใน 10 ยุคหรือน้อยกว่า และดูจุดตัวอย่างต่างๆ เพื่อหาผลลัพธ์ที่ดีที่สุด

ilab train --num-epochs 9 RunningAvgSamplesPerSec=149.4829861942806, CurrSamplesPerSec=161.99957513920629, MemAllocated=22.45GB, MaxMemAllocated=29.08GB

throughput: 161.84935045724643 samples/s, lr: 1.3454545454545455e-05, loss: 0.840185821056366 cuda_mem_allocated: 22.45188570022583 GB cuda_malloc_retries: 0 num_loss_counted_tokens: 8061.0 batch_size: 96.0 total loss: 0.8581467866897583

Epoch 1: 100%|█████████████████████████████████████████████████████████| 84/84 [01:09<00:00, 1.20it/s]

total length: 2527 num samples 15 - rank: 6 max len: 187 min len: 149

เมื่อกระบวนการฝึกอบรมเสร็จสิ้น รายการโมเดลใหม่จะถูกจัดเก็บไว้ในไดเร็กทอรีโมเดลพร้อมตำแหน่งที่พิมพ์ไปยังเทอร์มินัล

Generated model in /root/workspace/models/tuned-0504-0051:

.

./samples_4992

./samples_9984

./samples_14976

./samples_19968

./samples_24960

./samples_29952

./samples_34944

./samples_39936

./samples_44928

./samples_49920

คำ ilab serve เดียวกันสามารถใช้เพื่อให้บริการโมเดลใหม่โดยส่งตัวเลือก –model พร้อมชื่อและตัวอย่าง

ilab serve --model tuned-0504-0051/samples_49920 หลังจากที่ VLLM เริ่มต้นด้วยโมเดลใหม่แล้ว เซสชันการแชทสามารถเปิดใช้งานได้โดยการสร้างเซสชันเทอร์มินัลใหม่ และส่งพารามิเตอร์ --model เดียวกันไปยังแชท (โปรดทราบว่าหากไม่ตรงกัน คุณจะได้รับข้อความแสดงข้อผิดพลาด 404) ถามคำถามที่เกี่ยวข้องกับการมีส่วนร่วมด้านอนุกรมวิธานของคุณ

ilab chat --model tuned-0504-0051/samples_49920╭─────────────────────────────── system ────────────────────────────────╮

│ Welcome to InstructLab Chat w/ │

│ /INSTRUCTLAB/MODELS/TUNED-0504-0051/SAMPLES_49920 (type /h for help) │

╰───────────────────────────────────────────────────────────────────────╯

>>> What are tonsils ?

╭────────── /instructlab/models/tuned-0504-0051/samples_49920 ──────────╮

│ │

│ Tonsils are a type of mucosal lymphatic tissue found in the │

│ aerodigestive tracts of various mammals, including humans. In the │

│ human body, the tonsils play a crucial role in protecting the body │

│ from infections, particularly those caused by bacteria and viruses. │

╰─────────────────────────────────────────────── elapsed 0.469 seconds ─╯หากต้องการออกจากเซสชัน ให้พิมพ์

exit

แค่นั้นแหละ! วัตถุประสงค์ของการแสดงตัวอย่างสำหรับนักพัฒนาซอฟต์แวร์คือการเผยแพร่บางสิ่งแก่ผู้ใช้ของเราเพื่อรับข้อเสนอแนะล่วงหน้า เราตระหนักดีว่าอาจมีข้อบกพร่อง และเราขอขอบคุณที่สละเวลาและความพยายามของคุณหากคุณมาไกลขนาดนี้ มีโอกาสที่คุณจะประสบปัญหาหรือจำเป็นต้องแก้ไขปัญหา เราขอแนะนำให้คุณยื่นรายงานข้อบกพร่อง คำขอคุณลักษณะ และถามคำถามกับเรา ดูข้อมูลการติดต่อด้านล่างสำหรับวิธีการดังกล่าว ขอบคุณ!

$ sudo subscription-manager config --rhsm.manage_repos=1nvidia-smi เพื่อให้แน่ใจว่าไดรเวอร์ทำงานและสามารถมองเห็น GPU ได้nvtop (มีใน EPEL) เพื่อดูว่ามีการใช้ GPU หรือไม่ (เส้นทางโค้ดบางส่วนมีทางเลือก CPU ซึ่งเราไม่ต้องการที่นี่)make prune จากไดเร็กทอรีย่อยการฝึกอบรม การดำเนินการนี้จะล้างสิ่งก่อสร้างเก่าๆ--no-cache ไปยังกระบวนการสร้าง make nvidia-bootc CONTAINER_TOOL_EXTRA_ARGS= " --no-cache "TMPDIR : make < platform > TMPDIR=/path/to/tmp