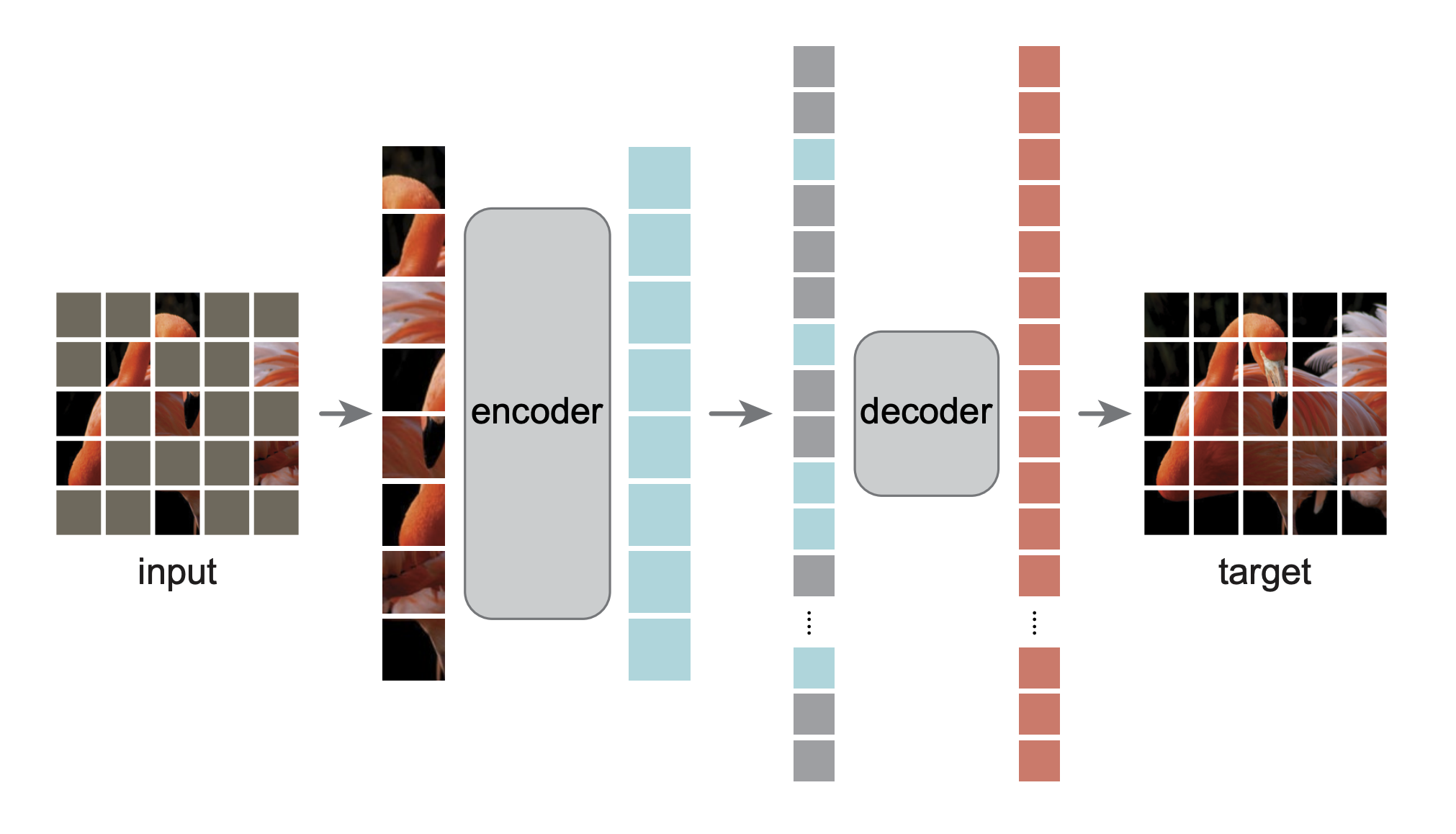

นี่คือการนำ PyTorch/GPU ไปใช้ใหม่ในกระดาษ Masked Autoencoders Are Scalable Vision Learners:

@Article{MaskedAutoencoders2021,

author = {Kaiming He and Xinlei Chen and Saining Xie and Yanghao Li and Piotr Doll{'a}r and Ross Girshick},

journal = {arXiv:2111.06377},

title = {Masked Autoencoders Are Scalable Vision Learners},

year = {2021},

}

การใช้งานดั้งเดิมอยู่ใน TensorFlow+TPU การปรับใช้ใหม่นี้อยู่ใน PyTorch+GPU

repo นี้เป็นการแก้ไขบน repo DeiT การติดตั้งและการเตรียมการเป็นไปตาม repo นั้น

repo นี้อิงจาก timm==0.3.2 ซึ่งจำเป็นต้องมีการแก้ไขเพื่อทำงานกับ PyTorch 1.8.1+

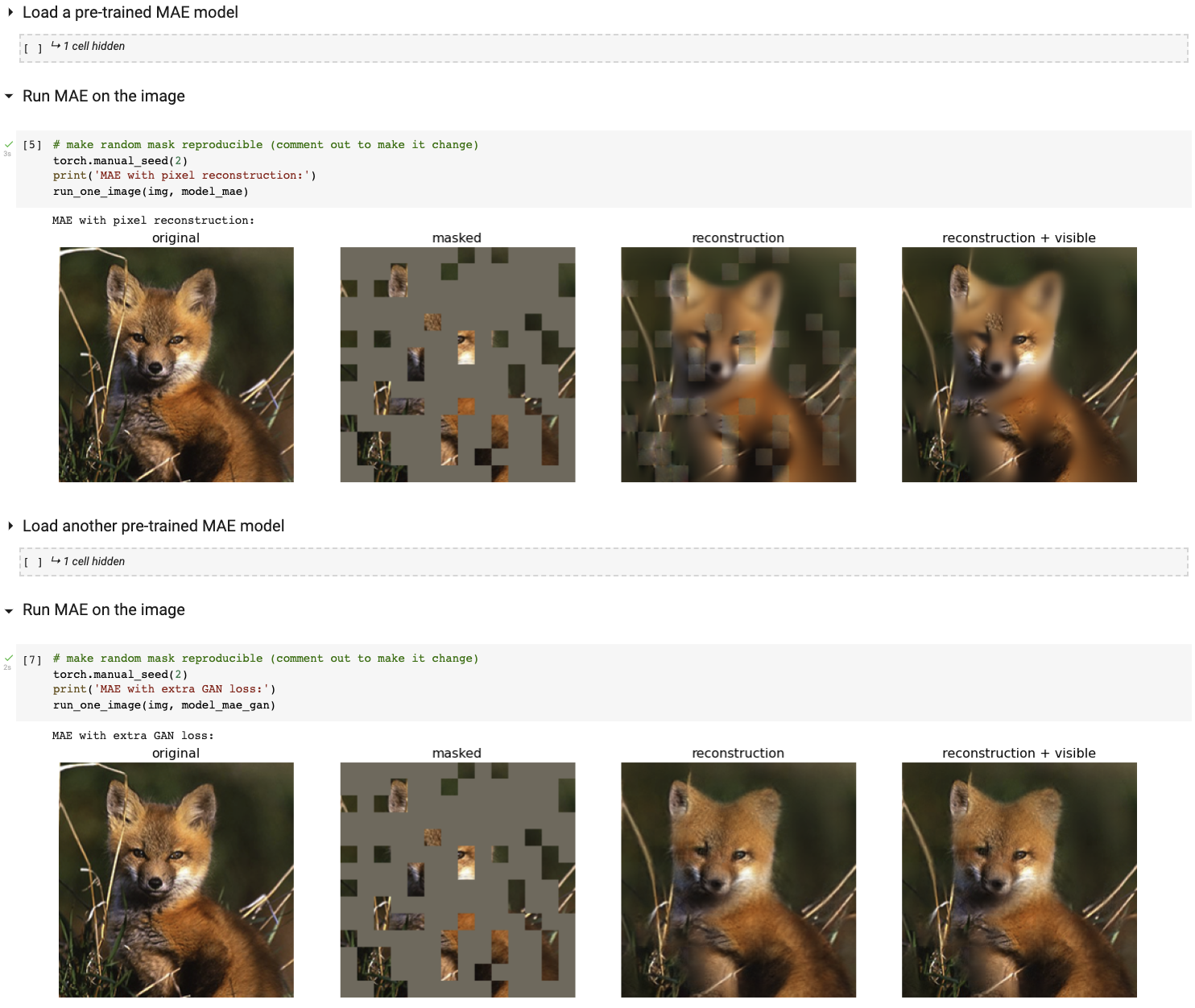

เรียกใช้การสาธิตการแสดงภาพเชิงโต้ตอบของเราโดยใช้สมุดบันทึก Colab (ไม่ต้องใช้ GPU):

ตารางต่อไปนี้แสดงจุดตรวจสอบที่ได้รับการฝึกอบรมล่วงหน้าซึ่งใช้ในรายงาน ซึ่งแปลงจาก TF/TPU เป็น PT/GPU:

| ViT-ฐาน | ViT-ขนาดใหญ่ | ViT-ใหญ่มาก | |

|---|---|---|---|

| จุดตรวจที่ได้รับการฝึกอบรมล่วงหน้า | ดาวน์โหลด | ดาวน์โหลด | ดาวน์โหลด |

| md5 | 8cad7c | b8b06e | 9bdbb0 |

คำแนะนำในการปรับแต่งอย่างละเอียดอยู่ใน FINETUNE.md

ด้วยการปรับแต่งโมเดลที่ได้รับการฝึกอบรมล่วงหน้าเหล่านี้ เราได้อันดับที่ 1 ในงานจำแนกประเภทเหล่านี้ (รายละเอียดในรายงาน):

| ไวที-บี | ไวที-แอล | ViT-H | ViT-H 448 | ก่อนหน้าดีที่สุด | |

|---|---|---|---|---|---|

| ImageNet-1K (ไม่มีข้อมูลภายนอก) | 83.6 | 85.9 | 86.9 | 87.8 | 87.1 |

| ต่อไปนี้เป็นการประเมินตุ้มน้ำหนักรุ่นเดียวกัน (ปรับแต่งอย่างละเอียดใน ImageNet-1K ดั้งเดิม): | |||||

| ImageNet-Corruption (อัตราข้อผิดพลาด) | 51.7 | 41.8 | 33.8 | 36.8 | 42.5 |

| ImageNet-ฝ่ายตรงข้าม | 35.9 | 57.1 | 68.2 | 76.7 | 35.8 |

| ImageNet-เรนเดอร์ | 48.3 | 59.9 | 64.4 | 66.5 | 48.7 |

| ImageNet-ร่าง | 34.5 | 45.3 | 49.6 | 50.9 | 36.0 |

| ต่อไปนี้คือการถ่ายโอนการเรียนรู้โดยการปรับแต่ง MAE ที่ได้รับการฝึกอบรมล่วงหน้าบนชุดข้อมูลเป้าหมาย: | |||||

| iNaturalists2017 | 70.5 | 75.7 | 79.3 | 83.4 | 75.4 |

| iNaturalists2018 | 75.4 | 80.1 | 83.0 | 86.8 | 81.2 |

| iNaturalists2019 | 80.5 | 83.4 | 85.7 | 88.3 | 84.1 |

| สถานที่205 | 63.9 | 65.8 | 65.9 | 66.8 | 66.0 |

| สถานที่365 | 57.9 | 59.4 | 59.8 | 60.3 | 58.0 |

คำแนะนำก่อนการฝึกอบรมอยู่ใน PRETRAIN.md

โครงการนี้อยู่ภายใต้ใบอนุญาต CC-BY-NC 4.0 ดูใบอนุญาตสำหรับรายละเอียด