Python 3.8 และ conda รับ Conda CUDA หากต้องการใช้ GPU Environment

conda create -n $YOUR_PY38_ENV_NAME python=3.8

conda activate $YOUR_PY38_ENV_NAME

pip install -r requirements.txt

สำหรับโปรเจ็กต์ของเรา อินพุตจะอยู่ในรูปแบบของอาร์เรย์ที่มีรูปร่าง (B, T, C, H, W) โดยแต่ละเฟรมในอาร์เรย์มีขนาดคงที่ 128x128 จำนวนเฟรมในแต่ละวิดีโอคือ 30 ส่งผลให้มีรูปร่างเป็น (B, 30, 3,128, 128) ก่อนที่จะใช้โปรเจ็กต์นี้ คุณอาจต้องประมวลผลข้อมูลวิดีโอของคุณล่วงหน้าตามนั้น ในโค้ด เรามีตัวอย่างอาร์เรย์ "city_bonn.npy" ที่มีรูปร่างเป็น (46, 30, 3, 128, 128) อาร์เรย์นี้ประกอบด้วยวิดีโอ 46 รายการจากเมืองบอนน์ในชุดข้อมูล Cityscape ด้านล่างนี้เป็นตัวอย่างคำสั่ง

คุณสามารถควบคุมวิดีโอที่จะประมวลผลได้โดยเลือกค่าสำหรับ start_idx และ end_idx ตรวจสอบให้แน่ใจว่าช่วงที่เลือกไม่เกินค่า B (จำนวนวิดีโอในชุดข้อมูลของคุณ)

python city_sender.py --data_npy "data_npy/city_bonn.npy" --output_path "your path" --start_idx 0 --end_idx 1

ในส่วนเกณฑ์มาตรฐาน เรามีโค้ดสำหรับการคำนวณหน่วยวัดการบีบอัดสำหรับ H.264 และ H.265 อินพุตสำหรับโค้ดนี้ควรเป็น 30 เฟรมของเฟรมรูปภาพ 128x128 โดยควรตั้งชื่อในรูปแบบ "frame%d"

โครงสร้างโฟลเดอร์ของชุดข้อมูลจะเป็นเช่นไร

/your path/

- frame0.png

- frame1.png

- ...

- frame29.png

สำหรับ project_str นี่เป็นเพียงสตริงที่ใช้แยกแยะข้อมูลของคุณ ในที่นี้เราใช้ "uvg"

python bench.py --dataset "your path" --output_path "your path" --project_str uvg

ส่วนจุดตรวจเราใช้สองชุด หนึ่งชุดประกอบด้วย "checkpoint_900000.pt" ซึ่งใช้สำหรับส่วนการสร้างวิดีโอ อีกชุดประกอบด้วยจุดตรวจสอบหกกลุ่ม และจุดตรวจสอบเหล่านี้จะใช้สำหรับส่วนการบีบอัดภาพ ซึ่งสอดคล้องกับคุณสมบัติการบีบอัดที่แตกต่างกันหกประการ

ต้องย้ายตุ้มน้ำหนักทั้งหกรายการไปยังโฟลเดอร์ "จุดตรวจ/โครงข่ายประสาทเทียม"

| แลมบ์ดา | คุณภาพ |

|---|---|

| 0.45 | ไตรมาสที่ 5 |

| 0.15 | ไตรมาสที่ 4 |

| 0.032 | ไตรมาสที่ 3 |

| 0.015 | ไตรมาสที่ 2 |

| 0.008 | ไตรมาสที่ 1 |

| 0.004 | q0 |

น้ำหนักส่วนบุคคลนี้จะต้องถูกย้ายไปยังโฟลเดอร์ "จุดตรวจสอบ/ผู้ส่ง"

| จุดตรวจแบบจำลองการแพร่กระจาย |

|---|

| จุดตรวจแบบจำลองการแพร่กระจาย |

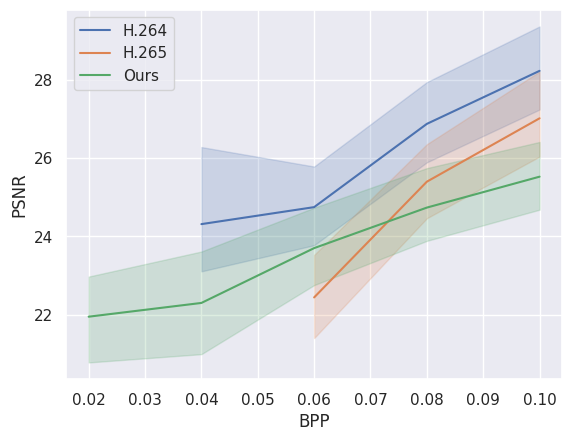

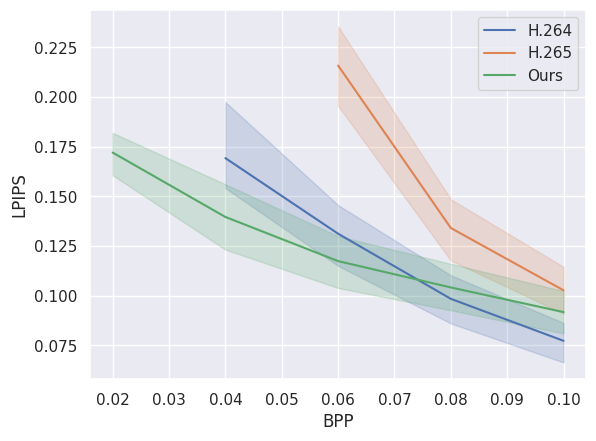

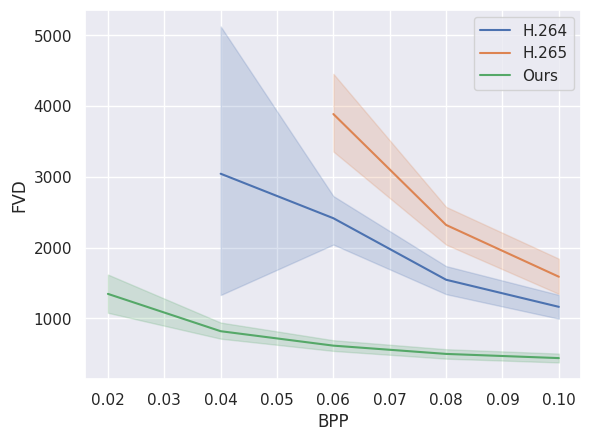

รูปภาพต่อไปนี้เปรียบเทียบประสิทธิภาพการบีบอัดของรุ่นของเรากับมาตรฐานการบีบอัดวิดีโอแบบดั้งเดิม H.264 และ H.265 สังเกตได้ว่าโมเดลของเรามีประสิทธิภาพเหนือกว่าโมเดลด้วยบิตเรตต่ำ (bpp) ข้อมูลเหล่านี้คำนวณจากวิดีโอ 24 รายการแรกจาก city_bonn.npy