สร้างโดย Wayne Wu, Yunxuan Zhang และ Ren Li

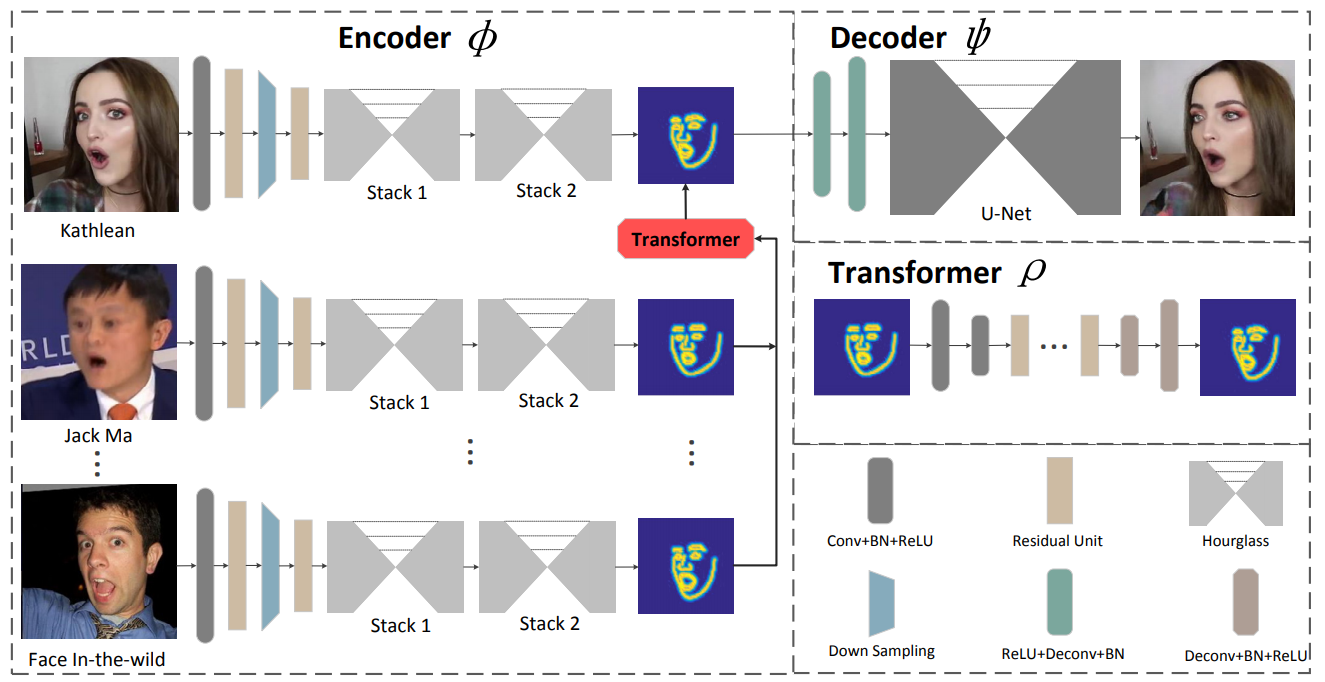

เรานำเสนอกรอบการทำงานบนพื้นฐานการเรียนรู้ใหม่สำหรับการจำลองใบหน้า วิธีการที่นำเสนอนี้เรียกว่า ReenactGAN สามารถถ่ายโอนการเคลื่อนไหวและการแสดงออกทางสีหน้าจากอินพุตวิดีโอตาเดียวของบุคคลที่กำหนดเองไปยังวิดีโอของบุคคลเป้าหมายได้ แทนที่จะดำเนินการถ่ายโอนโดยตรงในพื้นที่พิกเซล ซึ่งอาจส่งผลให้เกิดสิ่งประดิษฐ์ทางโครงสร้าง ก่อนอื่นเราจะแมปใบหน้าของแหล่งที่มาไปยังพื้นที่แฝงของขอบเขต ต่อมาหม้อแปลงไฟฟ้าจะถูกนำมาใช้เพื่อปรับขอบเขตของแหล่งกำเนิดให้เข้ากับขอบเขตของเป้าหมาย ในที่สุด ตัวถอดรหัสเฉพาะเป้าหมายจะถูกใช้เพื่อสร้างใบหน้าเป้าหมายที่จำลองขึ้นมาใหม่ ด้วยการถ่ายโอนตามขอบเขตที่มีประสิทธิภาพและเชื่อถือได้ วิธีการของเราจึงสามารถจำลองใบหน้าที่สมจริงด้วยภาพถ่ายได้ นอกจากนี้ ReenactGAN ยังน่าสนใจตรงที่กระบวนการจำลองเหตุการณ์ทั้งหมดเป็นแบบฟีดไปข้างหน้าเท่านั้น และด้วยเหตุนี้ กระบวนการจำลองเหตุการณ์จึงสามารถทำงานได้แบบเรียลไทม์

โคลน repo นี้:

git clone ...

cd ReenactGANตัวเข้ารหัสขอบเขตได้รับการฝึกฝนบนชุดข้อมูล WFLW และ Helen และหม้อแปลงขอบเขตและตัวถอดรหัสทั้งสองได้รับการฝึกฝนบนชุดข้อมูล CelebV การฝึกอบรมตัวเข้ารหัสต้องใช้เวลามาก ดังนั้นคุณจึงสามารถรับตัวเข้ารหัสที่ได้รับการฝึกล่วงหน้าได้ที่ . /pretrained_models/v8_net_boundary_detection.pth

หากต้องการฝึกหม้อแปลงขอบเขตให้รัน

sh script/train_Transformer.shคุณต้องดูแลข้อโต้แย้ง --root_dir และ --who_target --root_dir อ้างถึงไดเร็กทอรีของชุดข้อมูล และ -- ซึ่ง_target อ้างถึงบุคคลที่จะเป็นเป้าหมาย

0: Emmanuel_Macron

1: Kathleen

2: Jack_Ma

3: Theresa_May

4: Donald_Trumpหากต้องการฝึกตัวถอดรหัส ให้รัน

sh script/train_Decoder.shนอกจากนี้ คุณต้องดูแลค่าของ --root_dir ซึ่งอ้างอิงถึงไดเร็กทอรีของบุคคลเป้าหมาย

หากต้องการทดสอบโมเดล ให้รัน

sh script/move_models.sh ./checkpoints/Transformer_2019-xx-xx_xx-xx-xx/G_BA_xx.pth ./checkpoints/Decoder_2019-xx-xx_xx-xx-xx/xx_net_G.pth trump

sh script/test.shรูปภาพที่ใช้สำหรับการทดสอบอยู่ที่ ./test_imgs/samples/image และไฟล์ข้อความ ./test_imgs/samples/images_list.txt มีรายการรูปภาพเหล่านี้ หลังการทดสอบ คุณจะได้รับโฟลเดอร์ชื่อ results ซึ่งประกอบด้วยรูปภาพของใบหน้าจริงและใบหน้าจำลอง ขอบเขต และขอบเขตที่เปลี่ยนแปลงของใบหน้าจริง นี่คือผลลัพธ์บางส่วน

คุณสามารถรับโมเดลที่ผ่านการฝึกอบรมของเราได้จาก Decoder และ Transformer

หากคุณพบว่า ReenactGAN มีประโยชน์สำหรับการวิจัยของคุณ โปรดอ้างอิง:

inproceedings{wayne2018reenactgan,

author = {Wu, Wayne and Zhang, Yunxuan and Li, Cheng and Qian, Chen and Loy, Chen Change},

title = {ReenactGAN: Learning to Reenact Faces via Boundary Transfer},

booktitle = {ECCV},

month = September,

year = {2018}

} กรุณาติดต่อ [email protected]