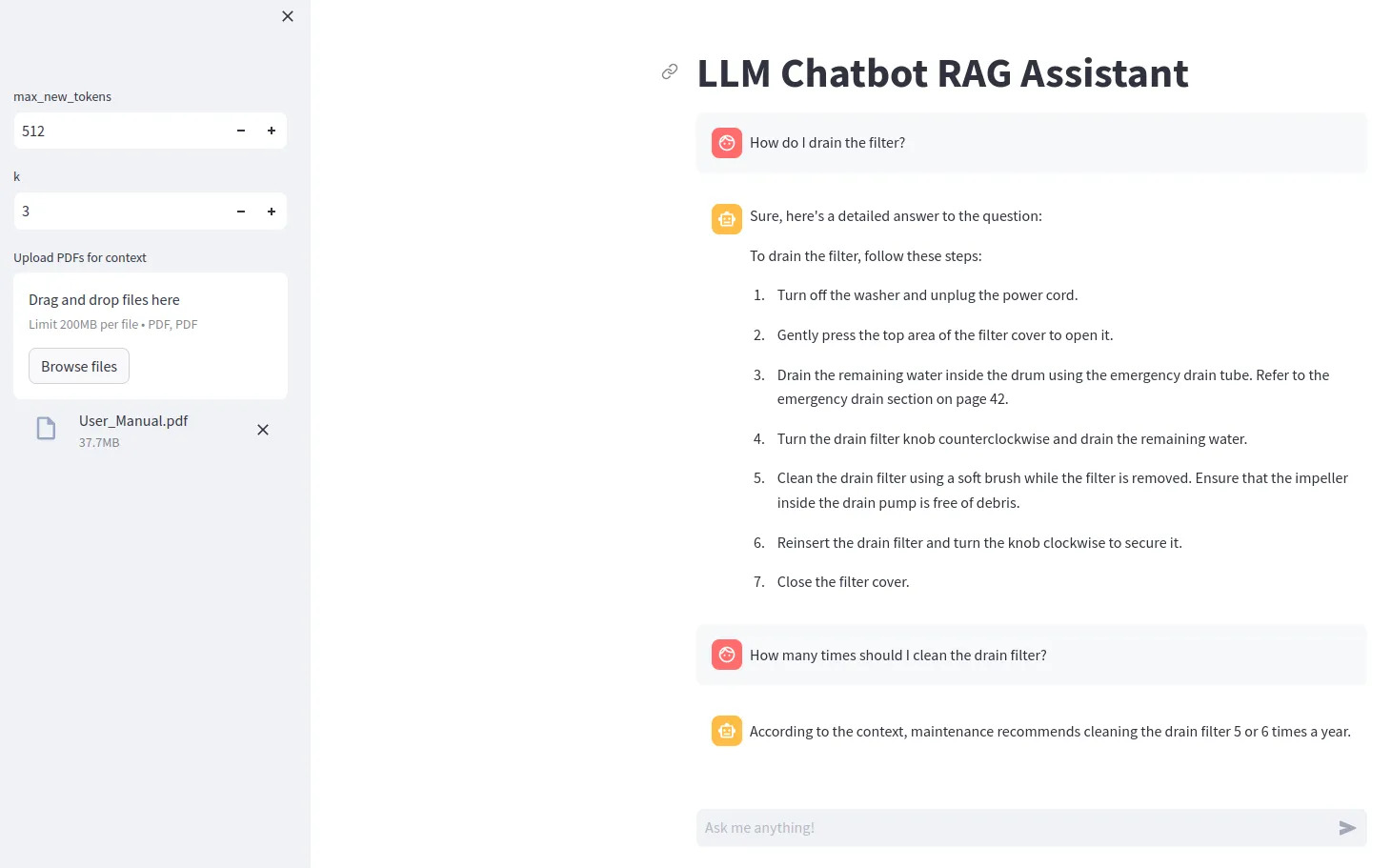

llm chatbot rag

1.0.0

หากต้องการใช้ LLM รุ่นบางรุ่น (เช่น Gemma) คุณต้องสร้างไฟล์ .env ที่มีบรรทัด ACCESS_TOKEN=<your hugging face token>

ติดตั้งการพึ่งพาด้วย pip install -r requirements.txt

รันด้วย streamlit run src/app.py

หากต้องการใช้การหาปริมาณบิตแซนด์ไบต์ จำเป็นต้องมี Nvidia GPU ตรวจสอบให้แน่ใจว่าได้ติดตั้ง NVIDIA Toolkit ก่อนแล้วจึงตามด้วย PyTorch

คุณสามารถตรวจสอบว่า GPU ของคุณมีอยู่ใน Python หรือไม่

import torch

print(torch.cuda.is_available())

หากคุณไม่มี GPU ที่ใช้งานร่วมกันได้ ให้ลองตั้งค่า device="cpu" สำหรับโมเดลและลบการกำหนดค่าการกำหนดปริมาณออก