เคเซิร์ฟ

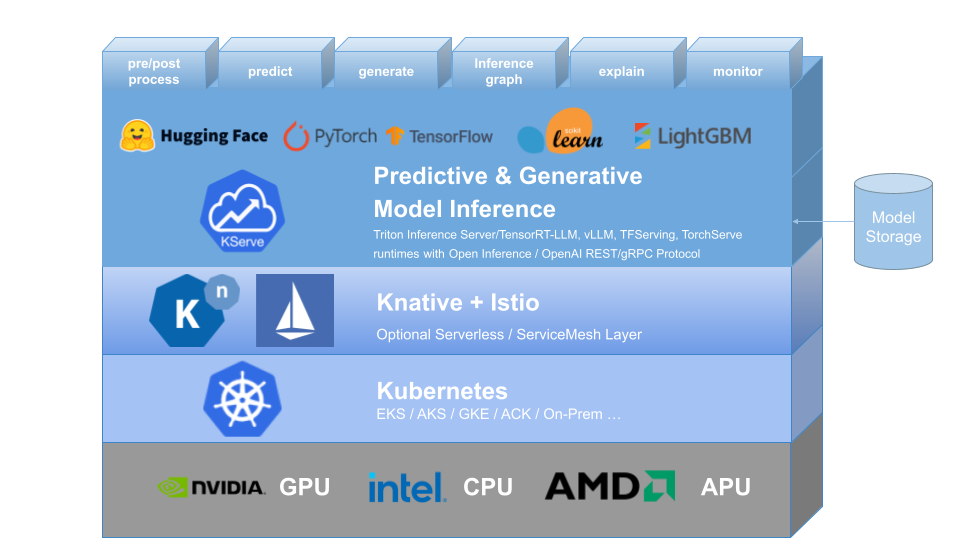

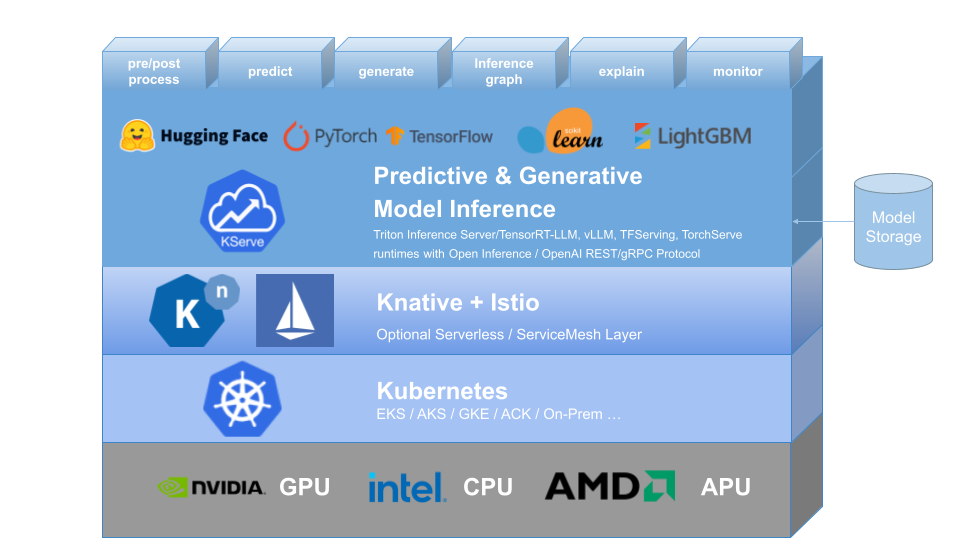

KServe จัดเตรียมคำจำกัดความทรัพยากรที่กำหนดเองของ Kubernetes สำหรับการให้บริการโมเดลการเรียนรู้ของเครื่องเชิงคาดการณ์และเชิงสร้างสรรค์ (ML) โดยมีจุดมุ่งหมายเพื่อแก้ปัญหาโมเดลการผลิตที่ให้บริการกรณีการใช้งานโดยจัดเตรียมอินเทอร์เฟซที่เป็นนามธรรมสูงสำหรับโมเดล Tensorflow, XGBoost, ScikitLearn, PyTorch, Huggingface Transformer/LLM โดยใช้โปรโตคอลระนาบข้อมูลมาตรฐาน

โดยสรุปความซับซ้อนของการปรับขนาดอัตโนมัติ เครือข่าย การตรวจสอบสภาพ และการกำหนดค่าเซิร์ฟเวอร์ เพื่อนำฟีเจอร์การให้บริการที่ล้ำหน้า เช่น GPU Autoscaling, Scale to Zero และ Canary Rollouts มาสู่การปรับใช้ ML ของคุณ ช่วยให้เรื่องราวที่เรียบง่าย เสียบได้ และสมบูรณ์สำหรับการให้บริการ ML การผลิต รวมถึงการคาดการณ์ การประมวลผลล่วงหน้า หลังการประมวลผล และความสามารถในการอธิบาย KServe ถูกนำไปใช้ในองค์กรต่างๆ

ดูรายละเอียดเพิ่มเติมที่เว็บไซต์ KServe

KFServing ได้รับการเปลี่ยนชื่อเป็น KServe ตั้งแต่เวอร์ชัน 0.7

ทำไมต้องเคเซิร์ฟ?

- KServe เป็น แพลตฟอร์มการอนุมานโมเดล ที่ไม่เชื่อเรื่องพระเจ้าบนคลาวด์มาตรฐานสำหรับการให้บริการโมเดล AI แบบคาดการณ์และแบบสร้างบน Kubernetes ซึ่งสร้างขึ้นสำหรับกรณีการใช้งานที่ปรับขนาดได้สูง

- มอบ โปรโตคอลการอนุมานที่เป็นมาตรฐาน และมีประสิทธิภาพทั่วทั้งเฟรมเวิร์ก ML รวมถึงข้อกำหนด OpenAI สำหรับโมเดลเชิงกำเนิด

- รองรับ ปริมาณงานการอนุมานแบบไร้เซิร์ฟเวอร์ สมัยใหม่ด้วย การปรับขนาดอัตโนมัติตามคำขอ รวมถึงการปรับขนาดเป็นศูนย์ บน CPU และ GPU

- มอบ ความสามารถในการปรับขนาดสูง การบรรจุความหนาแน่น และการกำหนดเส้นทางอัจฉริยะ โดยใช้ ModelMesh

- การให้บริการการผลิตที่เรียบง่ายและเสียบปลั๊กได้ สำหรับ การอนุมาน การประมวลผลก่อน/หลัง การตรวจสอบ และ ความสามารถในการอธิบาย

- การปรับใช้ขั้นสูงสำหรับ การเปิดตัว canary ไปป์ไลน์ และ วงดนตรี ด้วย InferenceGraph

เรียนรู้เพิ่มเติม

หากต้องการเรียนรู้เพิ่มเติมเกี่ยวกับ KServe วิธีใช้คุณสมบัติต่างๆ ที่รองรับ และวิธีการเข้าร่วมในชุมชน KServe โปรดปฏิบัติตามเอกสารประกอบของเว็บไซต์ KServe นอกจากนี้เรายังได้รวบรวมรายการการนำเสนอและการสาธิตเพื่อเจาะลึกรายละเอียดต่างๆ

การติดตั้ง

การติดตั้งแบบสแตนด์อโลน

- การติดตั้งแบบไร้เซิร์ฟเวอร์ : KServe โดยค่าเริ่มต้นจะติดตั้ง Knative สำหรับ การปรับใช้แบบไร้เซิร์ฟเวอร์ สำหรับ InferenceService

- การติดตั้ง Raw Deployment : เมื่อเปรียบเทียบกับการติดตั้งแบบไร้เซิร์ฟเวอร์ นี่เป็นการติดตั้ง ที่เบา กว่า อย่างไรก็ตาม ตัวเลือกนี้ไม่รองรับการใช้งาน Canary และการปรับขนาดอัตโนมัติตามคำขอที่มีขนาดเป็นศูนย์

- การติดตั้ง ModelMesh : คุณสามารถเลือกติดตั้ง ModelMesh เพื่อเปิดใช้งานกรณีการใช้งานโมเดลที่ให้บริการโมเดล ขนาดใหญ่ ความหนาแน่นสูง และ เปลี่ยนแปลงบ่อยได้

- การติดตั้งอย่างรวดเร็ว : ติดตั้ง KServe บนเครื่องของคุณ

การติดตั้ง Kubeflow

KServe เป็นองค์ประกอบเสริมที่สำคัญของ Kubeflow โปรดเรียนรู้เพิ่มเติมจากเอกสารประกอบของ Kubeflow KServe ดูคำแนะนำต่อไปนี้สำหรับการรันบน AWS หรือบน OpenShift Container Platform

- สร้าง InferenceService แรกของคุณ

แผนการทำงาน

การอ้างอิง API ของ InferenceService

- คู่มือนักพัฒนา

✍️คู่มือผู้ร่วมให้ข้อมูล

- ผู้รับบุตรบุญธรรม